熱画像、LiDAR、赤外線画像などの視覚データタイプが、いかに多様なコンピュータビジョンアプリケーションを様々な産業で実現するかをご紹介します。

熱画像、LiDAR、赤外線画像などの視覚データタイプが、いかに多様なコンピュータビジョンアプリケーションを様々な産業で実現するかをご紹介します。

ドローンのような技術は、かつては研究者や専門家だけが利用できるものでしたが、今日では、最先端のハードウェアがより多くの人々にとって利用しやすくなっています。この変化は、私たちが視覚データを収集する方法を変えています。よりアクセスしやすい技術により、従来のカメラだけでなく、さまざまなソースから画像やビデオをキャプチャできるようになりました。

それと並行して、人工知能(AI)の一分野であるコンピューター・ビジョンによって実現される画像解析は急速に進化しており、機械が視覚データをより効果的に解釈・処理できるようになっている。この進歩は、自動化、物体検出、リアルタイム分析に新たな可能性をもたらしている。機械は現在、パターンを認識し、動きをtrack し、複雑な視覚入力を理解することができる。

視覚データの主な種類には、物体認識によく使用されるRGB(赤、緑、青)画像、低照度下での熱シグネチャのdetect 役立つ赤外線画像、機械が3D環境を理解するための深度データなどがある。これらのデータはそれぞれ、監視から医療用画像処理まで、ビジョンAIのさまざまなアプリケーションで重要な役割を果たしている。

この記事では、Vision AIで使用される主要な視覚データの種類を探り、それぞれがさまざまな業界で精度、効率、およびパフォーマンスの向上にどのように貢献するかを検討します。それでは始めましょう!

通常、スマートフォンで写真を撮ったり、CCTV映像を見たりするときは、RGB画像を扱っています。RGBは、赤、緑、青の略で、デジタル画像で視覚情報を表す3つのカラーチャネルです。

RGB画像とビデオは、コンピュータビジョンで使用される密接に関連する視覚データタイプであり、どちらも標準的なカメラを使用してキャプチャされます。主な違いは、画像が単一の瞬間をキャプチャするのに対し、ビデオは時間の経過とともに物事がどのように変化するかを示す一連のフレームであることです。

RGB画像は一般的に、物体検出、インスタンス分割、姿勢推定などのコンピュータビジョンタスクに使用されます。 Ultralytics YOLO11.これらのアプリケーションは、1フレーム内のパターン、形状、または特定の特徴を識別することに依存しています。

一方、動画は、ジェスチャー認識、監視、行動の追跡など、動きや時間が重要な要素となる場合に不可欠です。動画は一連の画像とみなすことができるため、YOLO11 ようなコンピュータビジョンモデルは、フレームごとに処理し、時間経過に伴う動きや行動を理解する。

例えば、YOLO11 RGB画像やビデオを解析し、農地の雑草をdetect したり、植物を数えたりすることができる。これにより、作物のモニタリングが強化され、生育サイクルの変化をtrack 、より効率的な農場管理が可能になる。

深度データは、オブジェクトがカメラまたはセンサーからどれだけ離れているかを示すことにより、視覚情報に3次元を追加します。色とテクスチャのみをキャプチャするRGB画像とは異なり、深度データは空間コンテキストを提供します。オブジェクトとカメラの間の距離を示し、シーンの3Dレイアウトを解釈することを可能にします。

このタイプのデータは、LiDAR、ステレオビジョン(人間の奥行き認識を模倣するために2台のカメラを使用)、およびTime-of-Flight(光がオブジェクトに移動して戻るのにかかる時間を測定)カメラなどのテクノロジーを使用してキャプチャされます。

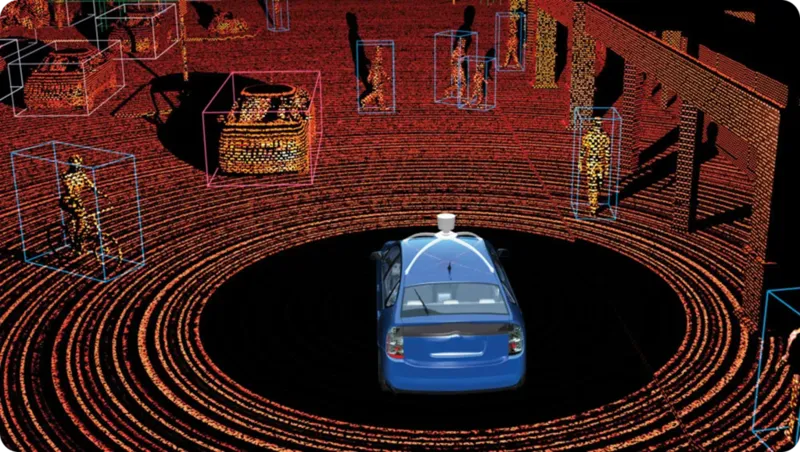

これらの中で、LiDAR(Light Detection and Ranging)は、深度測定に最も信頼できることがよくあります。これは、高速レーザーパルスを送信し、それらが跳ね返るのにかかる時間を測定することによって機能します。その結果、ポイントクラウドとして知られる非常に正確な3Dマップが得られ、オブジェクトの形状、位置、および距離をリアルタイムで強調表示します。

LiDARテクノロジーは、特定のアプリケーションと環境向けに設計された2つの主要なタイプに分割できます。両方のタイプを詳しく見てみましょう。

LiDARデータのインパクトのある応用例は、自動運転車です。ここでは、車線検出、衝突回避、および近隣の物体の識別などのタスクで重要な役割を果たします。LiDARは、環境の詳細なリアルタイム3Dマップを生成し、車両が物体を認識し、その距離を計算し、安全にナビゲートできるようにします。

RGB画像は、可視光スペクトルで私たちが見るものを捉えますが、熱画像や赤外線画像などの他の画像技術は、これをさらに超えています。赤外線画像は、物体から放射または反射される赤外光を捉え、低照度条件下で役立ちます。

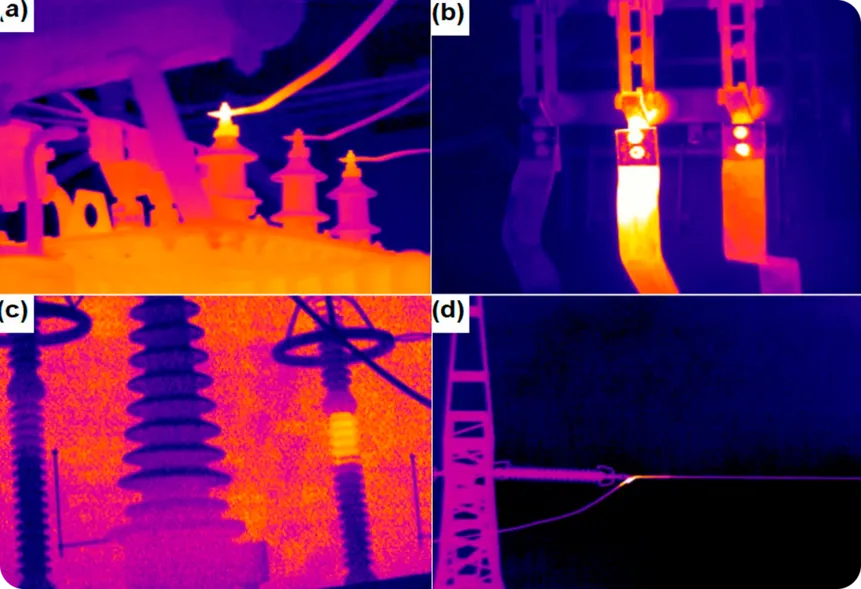

対照的に、熱画像は物体から放射される熱を検出し、温度差を表示するため、完全な暗闇や煙、霧、その他の障害物の中でも機能します。このタイプのデータは、特に温度変化が潜在的な問題を示す可能性がある業界において、監視や問題の検出に特に役立ちます。

興味深い例として、電気部品の過熱の兆候を監視するために熱画像が使用されていることが挙げられます。温度差を検出することにより、熱カメラは、機器の故障、火災、またはコストのかかる損傷につながる前に問題を特定できます。

同様に、赤外線画像は、ガスや液体の漏れを示す温度差を識別することで、パイプラインや断熱材の漏れをdetect のに役立ちます。

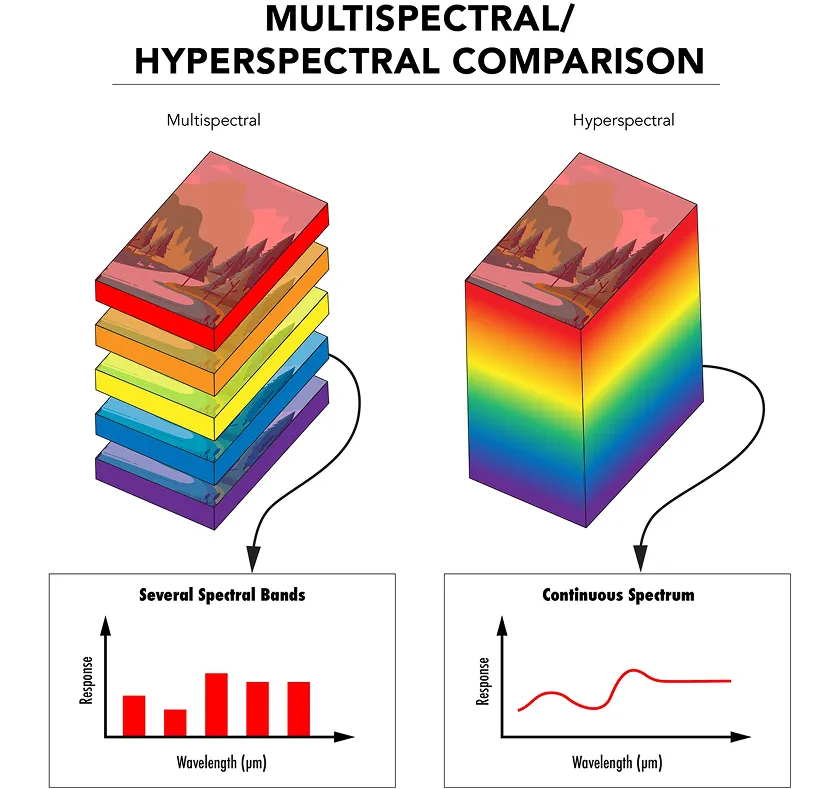

赤外線および熱画像が電磁スペクトルの特定の側面を捉える一方で、マルチスペクトルイメージングは、健全な植生の検出や表面材料の識別など、特定の目的のために選択されたいくつかの波長範囲からの光を収集します。

ハイパースペクトルイメージングは、数百もの非常に狭く連続した波長範囲にわたって光を捉えることにより、これをさらに一歩進めます。これにより、画像内の各ピクセルに対して詳細な光の署名が提供され、観察されているあらゆる材料をより深く理解できます。

マルチスペクトルイメージングとハイパースペクトルイメージングはどちらも、特殊なセンサーとフィルターを使用して、異なる波長で光を捉えます。データはその後、スペクトルキューブと呼ばれる3D構造に編成され、各レイヤーは異なる波長を表します。

AIモデルはこのデータを分析して、通常のカメラや人間の目では見えない特徴をdetect ことができる。例えば、植物の表現型分類では、ハイパースペクトル画像を使って、栄養不足やストレスなど、葉や茎の微妙な変化を検出することで、植物の健康状態や成長をモニターすることができる。これにより、研究者は侵襲的な方法を用いることなく、植物の健康状態を評価し、農法を最適化することができる。

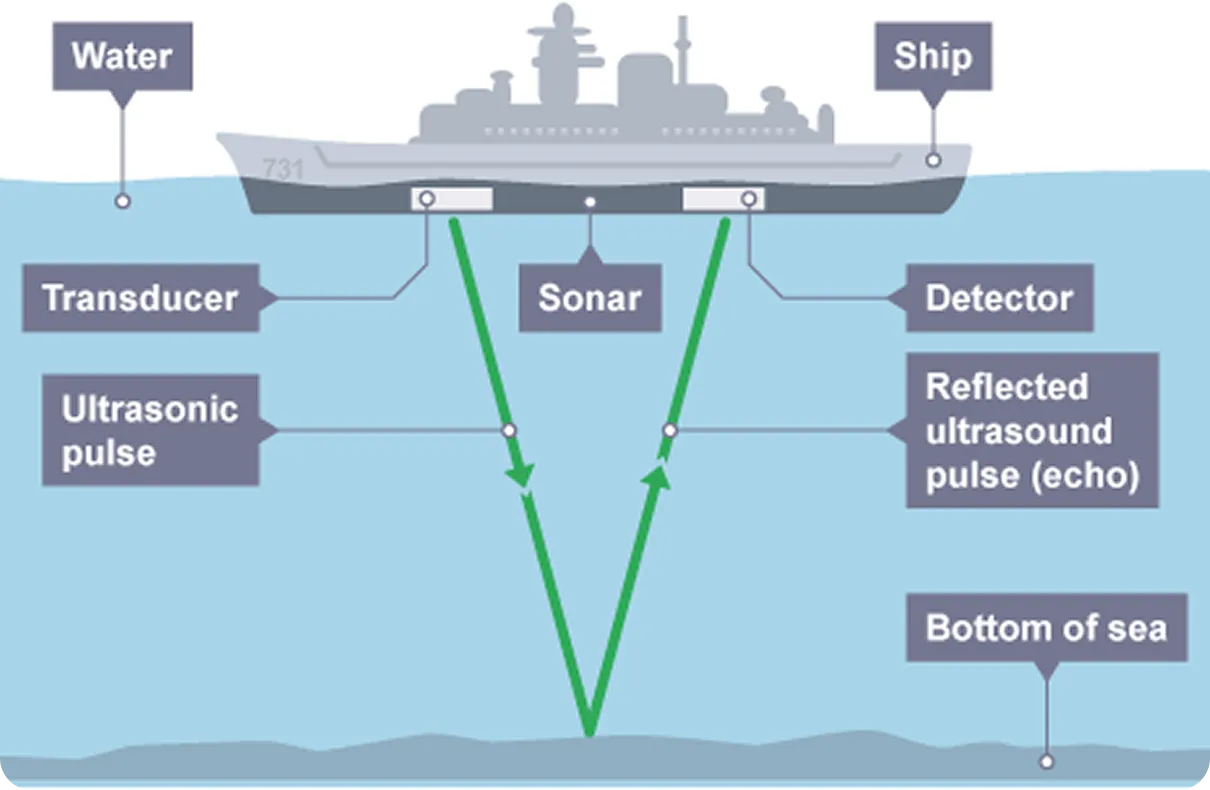

レーダーとソナーイメージングは、LiDARと同様に、信号を発信し、その反射を分析することによって物体をdetect し、マッピングする技術である。視覚情報を取得するために光波に依存するRGBイメージングとは異なり、レーダーは電磁波、通常は電波を使用し、ソナーは音波を使用する。レーダーとソナーの両システムはパルスを放射し、信号が物体から跳ね返ってくるまでの時間を測定することで、物体の距離、大きさ、速度に関する情報を提供する。

レーダー画像は、霧や雨、夜間など視界が悪いときに特に役立つ。光に依存しないため、完全な暗闇でも航空機、車両、地形をdetect できる。このため、レーダーは航空、気象監視、自律航法において信頼できる選択肢となる。

比較すると、ソナーイメージングは、光が届かない水中環境で一般的に使用されます。水中を伝わり、水中の物体から跳ね返る音波を使用して、潜水艦の検出、海底のマッピング、および水中救助ミッションの実行を可能にします。コンピュータビジョンの進歩により、ソナーデータとインテリジェントな分析を組み合わせることで水中検出がさらに強化され、検出と意思決定が改善されています。

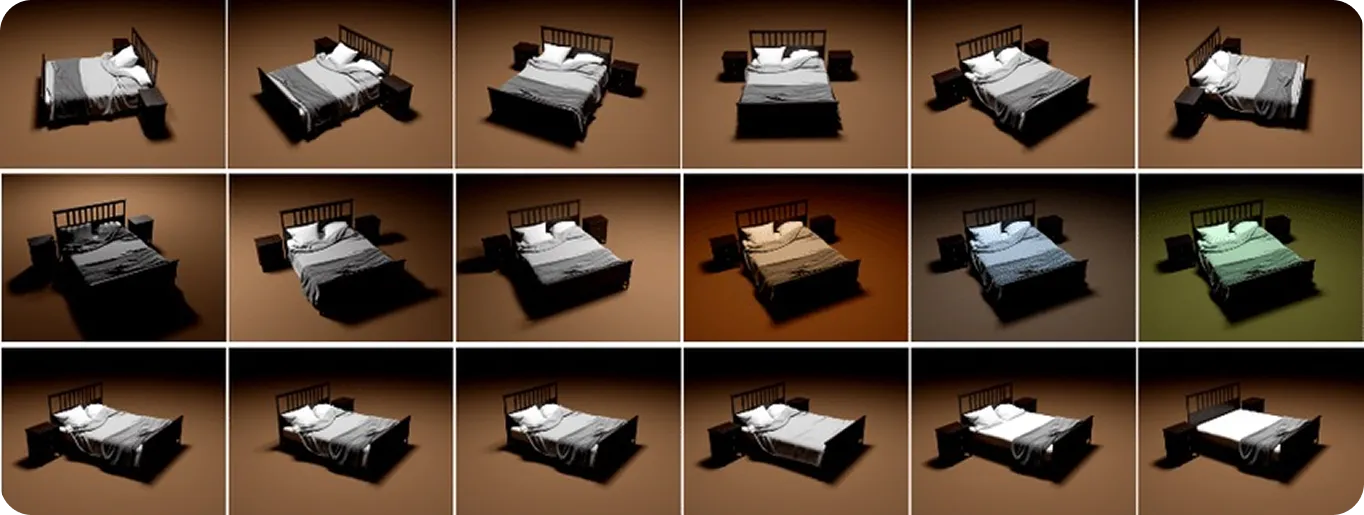

これまで議論してきたさまざまな種類のデータは、現実世界から収集できるものでした。ただし、合成およびシミュレーションビジュアルデータはどちらも人工コンテンツの一種です。合成データは、3DモデリングまたはジェネレーティブAIを使用してゼロから生成され、リアルな画像またはビデオを生成します。

シミュレーションデータも同様ですが、光の反射、影の形成、物体の動きなど、物理世界がどのように動作するかを複製する仮想環境を作成することが含まれます。すべてのシミュレーションビジュアルデータは合成データですが、すべての合成データがシミュレーションされるわけではありません。重要な違いは、シミュレーションデータは外観だけでなく、現実的な動作を複製することです。

これらのデータタイプは、特に現実世界のデータの収集が困難な場合、または特定のまれな状況をシミュレートする必要がある場合に、コンピュータビジョンモデルのトレーニングに役立ちます。開発者は、シーン全体を作成し、オブジェクトの種類、位置、照明を選択し、トレーニング用のバウンディングボックスなどのラベルを自動的に追加できます。これにより、実際の写真や手動によるラベル付けを必要とせずに、大規模で多様なデータセットを迅速に構築できます。これは、コストがかかり、時間がかかる可能性があります。

例えば、ヘルスケアでは、合成データは、実際の画像の大規模なデータセットを収集し、ラベル付けすることが困難な乳がん細胞をsegment するモデルを訓練するために使用することができます。合成データとシミュレートされたデータは、柔軟性と制御性を提供し、実世界のビジュアルが制限されるギャップを埋める。

さまざまな種類のビジュアルデータの仕組みと、それらが何ができるかを見てきたので、特定のタスクに最適なデータタイプを詳しく見ていきましょう。

現実の状況では、単一のデータタイプだけでは十分な精度やコンテキストを提供できない場合があります。そこで、マルチモーダルセンサーフュージョンが重要になります。RGBを熱、深度、LiDARなどの他のデータタイプと組み合わせることで、システムは個々の制限を克服し、信頼性と適応性を向上させることができます。

たとえば、倉庫の自動化では、物体認識にRGBを使用し、距離測定に深度を使用し、過熱した機器の検出に熱を使用することで、運用がより効率的かつ安全になります。最終的には、アプリケーションの特定のニーズに基づいてデータタイプを選択または組み合わせることで、最良の結果が得られます。

Vision AIモデルを構築する場合、適切な種類のビジュアルデータを選択することが重要です。物体検出、セグメンテーション、モーショントラッキングなどのタスクは、アルゴリズムだけでなく、入力データの品質にも依存します。クリーンで多様で正確なデータセットは、ノイズを減らし、パフォーマンスを向上させるのに役立ちます。

RGB、深度、熱、LiDARなどのデータタイプを組み合わせることで、AIシステムは環境をより完全に把握できるようになり、さまざまな条件でより信頼性が高まります。テクノロジーが向上し続けるにつれて、Vision AIがより高速で、より適応性があり、業界全体でより大きな影響力を持つようになる道が開かれる可能性があります。

当社のコミュニティに参加し、当社のGitHubリポジトリを調べて、コンピュータビジョンについて詳しく学んでください。ソリューションページで、医療におけるAIおよび小売におけるコンピュータビジョンに関連するさまざまなアプリケーションをご覧ください。Vision AIの使用を開始するには、当社のライセンスオプションをご確認ください。