Esplorazione di vari tipi di dati per applicazioni Vision AI

Scopri come i tipi di dati visivi come l'imaging termico, il LiDAR e le immagini a infrarossi consentono diverse applicazioni di computer vision in tutti i settori.

Scopri come i tipi di dati visivi come l'imaging termico, il LiDAR e le immagini a infrarossi consentono diverse applicazioni di computer vision in tutti i settori.

Tecnologie come i droni erano limitate e accessibili solo a ricercatori e specialisti, ma oggi l'hardware all'avanguardia sta diventando più accessibile a un pubblico più ampio. Questo cambiamento sta modificando il modo in cui raccogliamo i dati visivi. Con una tecnologia più accessibile, ora possiamo acquisire immagini e video da una varietà di fonti, oltre alle tradizionali fotocamere.

Parallelamente, l'analisi delle immagini, abilitata dalla computer vision, una branca dell'intelligenza artificiale (AI), si sta evolvendo rapidamente, consentendo alle macchine di interpretare ed elaborare i dati visivi in modo più efficace. Questo progresso ha aperto nuove possibilità di automazione, rilevamento di oggetti e analisi in tempo reale. Le macchine possono ora riconoscere schemi, track movimenti e dare un senso a input visivi complessi.

Alcuni tipi chiave di dati visivi sono le immagini RGB (Red, Green, Blue), comunemente utilizzate per il riconoscimento degli oggetti, le immagini termiche, che aiutano a detect le tracce di calore in condizioni di scarsa illuminazione, e i dati di profondità, che consentono alle macchine di comprendere gli ambienti 3D. Ognuno di questi tipi di dati svolge un ruolo fondamentale nell'alimentazione di varie applicazioni di Vision AI, dalla sorveglianza all'imaging medico.

In questo articolo, esploreremo i tipi chiave di dati visivi utilizzati nella Vision AI ed esamineremo come ciascuno contribuisce a migliorare l'accuratezza, l'efficienza e le prestazioni in vari settori. Iniziamo!

In genere, quando si utilizza uno smartphone per scattare una foto o visualizzare filmati CCTV, si lavora con immagini RGB. RGB sta per rosso, verde e blu e sono i tre canali di colore che rappresentano le informazioni visive nelle immagini digitali.

Le immagini e i video RGB sono tipi di dati visivi strettamente correlati utilizzati nella computer vision, entrambi acquisiti tramite fotocamere standard. La differenza principale è che le immagini catturano un singolo istante, mentre i video sono una sequenza di fotogrammi che mostrano come cambiano le cose nel tempo.

Le immagini RGB sono generalmente utilizzate per compiti di computer vision come il rilevamento di oggetti, la segmentazione di istanze e la stima della posa, con il supporto di modelli quali Ultralytics YOLO11. Queste applicazioni si basano sull'identificazione di modelli, forme o caratteristiche specifiche in un singolo fotogramma.

I video, invece, sono essenziali quando il movimento o il tempo sono un fattore determinante, ad esempio per il riconoscimento dei gesti, la sorveglianza o il tracciamento delle azioni. Poiché i video possono essere considerati una serie di immagini, i modelli di computer vision come YOLO11 li elaborano fotogramma per fotogramma per comprendere il movimento e il comportamento nel tempo.

Ad esempio, YOLO11 può essere utilizzato per analizzare immagini o video RGB per detect erbacce e contare le piante nei campi agricoli. Questo migliora il monitoraggio delle colture e aiuta a track cambiamenti durante i cicli di crescita per una gestione più efficiente dell'azienda agricola.

I dati di profondità aggiungono una terza dimensione alle informazioni visive, indicando quanto sono distanti gli oggetti dalla fotocamera o dal sensore. A differenza delle immagini RGB che catturano solo il colore e la texture, i dati di profondità forniscono un contesto spaziale. Mostrano la distanza tra gli oggetti e la fotocamera, rendendo possibile l'interpretazione del layout 3D di una scena.

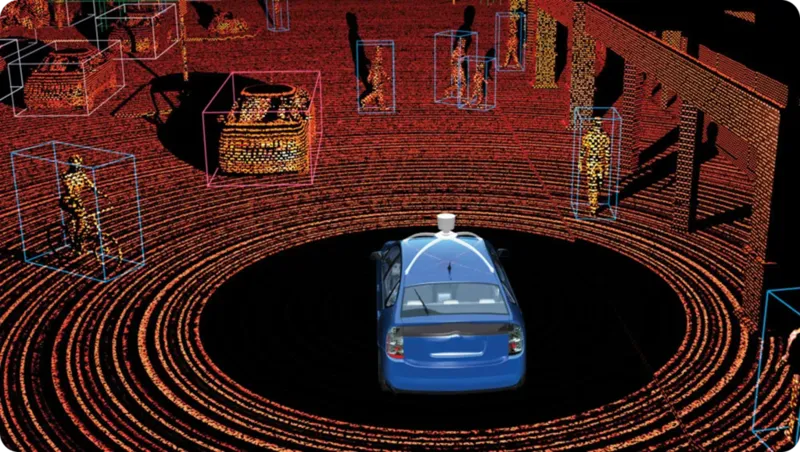

Questo tipo di dati viene acquisito utilizzando tecnologie come LiDAR, visione stereo (che utilizza due fotocamere per imitare la percezione umana della profondità) e fotocamere Time-of-Flight (che misurano il tempo impiegato dalla luce per raggiungere un oggetto e tornare indietro).

Tra queste, la tecnologia LiDAR (Light Detection and Ranging) è spesso la più affidabile per la misurazione della profondità. Funziona inviando rapidi impulsi laser e misurando il tempo impiegato per rimbalzare indietro. Il risultato è una mappa 3D molto precisa, nota come nuvola di punti, che evidenzia la forma, la posizione e la distanza degli oggetti in tempo reale.

La tecnologia LiDAR può essere suddivisa in due tipi principali, ciascuno progettato per applicazioni e ambienti specifici. Ecco uno sguardo più da vicino a entrambi i tipi:

Un'applicazione di grande impatto dei dati LiDAR è nei veicoli autonomi, dove svolge un ruolo chiave in attività come il rilevamento della corsia, l'evitamento delle collisioni e l'identificazione degli oggetti vicini. Il LiDAR genera mappe 3D dettagliate e in tempo reale dell'ambiente, consentendo al veicolo di vedere gli oggetti, calcolarne la distanza e navigare in sicurezza.

Le immagini RGB catturano ciò che vediamo nello spettro della luce visibile; tuttavia, altre tecnologie di imaging, come l'imaging termico e a infrarossi, vanno oltre. L'imaging a infrarossi cattura la luce infrarossa emessa o riflessa dagli oggetti, rendendolo utile in condizioni di scarsa illuminazione.

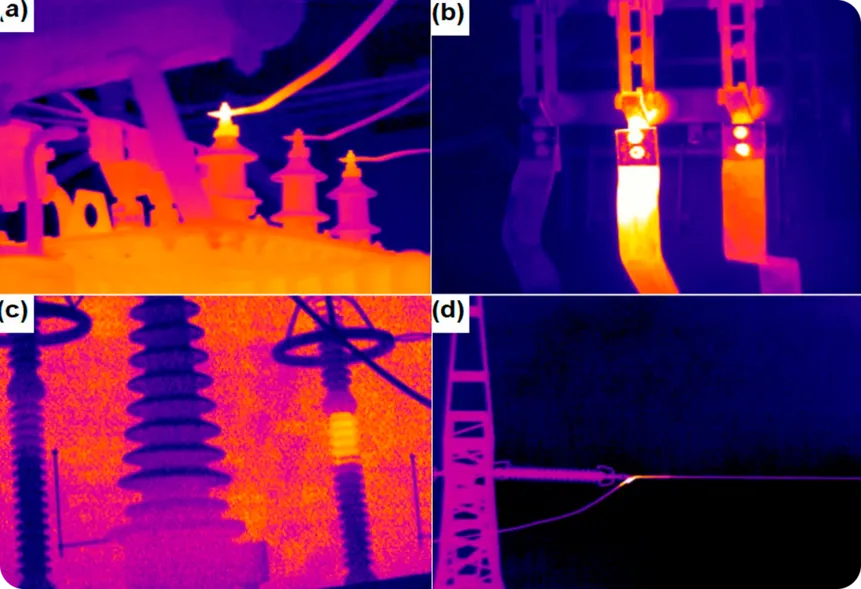

L'imaging termico, al contrario, rileva il calore emesso dagli oggetti e mostra le differenze di temperatura, consentendogli di funzionare in completa oscurità o attraverso fumo, nebbia e altre ostruzioni. Questo tipo di dati è particolarmente utile per il monitoraggio e il rilevamento di problemi, soprattutto nei settori in cui le variazioni di temperatura possono segnalare potenziali problemi.

Un esempio interessante è l'imaging termico utilizzato per monitorare i componenti elettrici per individuare segni di surriscaldamento. Rilevando le differenze di temperatura, le termocamere possono identificare i problemi prima che provochino guasti alle apparecchiature, incendi o danni costosi.

Allo stesso modo, le immagini a infrarossi possono aiutare a detect perdite nelle condutture o nell'isolamento, identificando le differenze di temperatura che indicano la fuoriuscita di gas o fluidi, il che è fondamentale per prevenire situazioni pericolose e migliorare l'efficienza energetica.

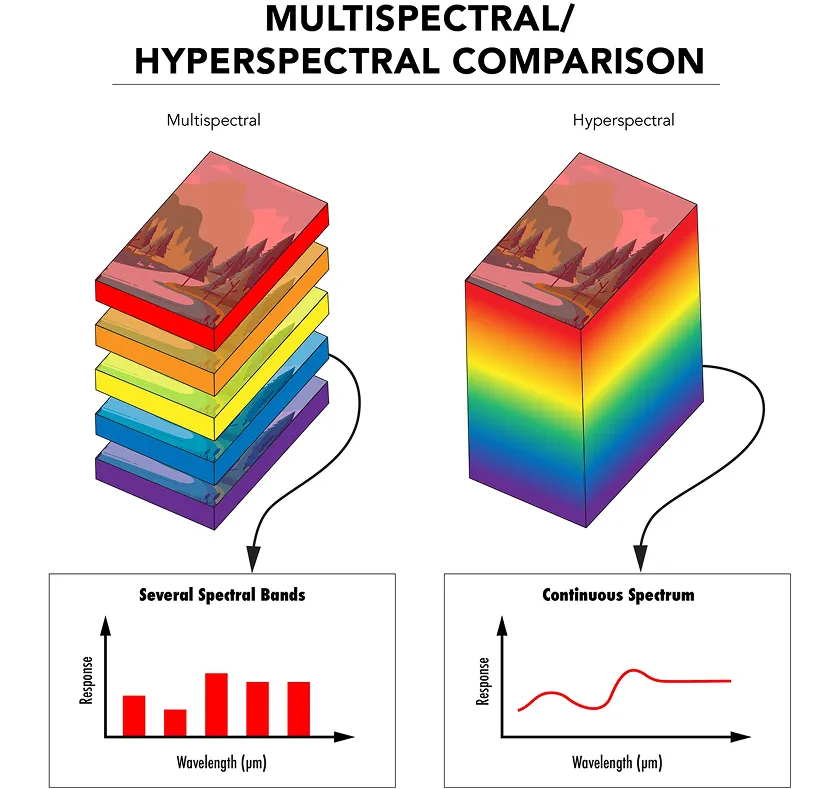

Mentre l'imaging a infrarossi e termico cattura aspetti specifici dello spettro elettromagnetico, l'imaging multispettrale raccoglie la luce da alcune gamme di lunghezze d'onda selezionate, ciascuna scelta per uno scopo specifico, come il rilevamento di vegetazione sana o l'identificazione di materiali superficiali.

L'imaging iperspettrale fa un ulteriore passo avanti catturando la luce attraverso centinaia di gamme di lunghezze d'onda molto strette e continue. Ciò fornisce una firma luminosa dettagliata per ogni pixel nell'immagine, offrendo una comprensione molto più profonda di qualsiasi materiale osservato.

Sia l'imaging multispettrale che quello iperspettrale utilizzano sensori e filtri speciali per acquisire la luce a diverse lunghezze d'onda. I dati vengono poi organizzati in una struttura 3D chiamata cubo spettrale, in cui ogni strato rappresenta una lunghezza d'onda diversa.

I modelli di intelligenza artificiale possono analizzare questi dati per detect caratteristiche che le normali telecamere o l'occhio umano non possono vedere. Ad esempio, nella fenotipizzazione delle piante, l'imaging iperspettrale può essere utilizzato per monitorare la salute e la crescita delle piante, rilevando sottili cambiamenti nelle foglie o negli steli, come carenze di nutrienti o stress. Ciò aiuta i ricercatori a valutare la salute delle piante e a ottimizzare le pratiche agricole senza dover ricorrere a metodi invasivi.

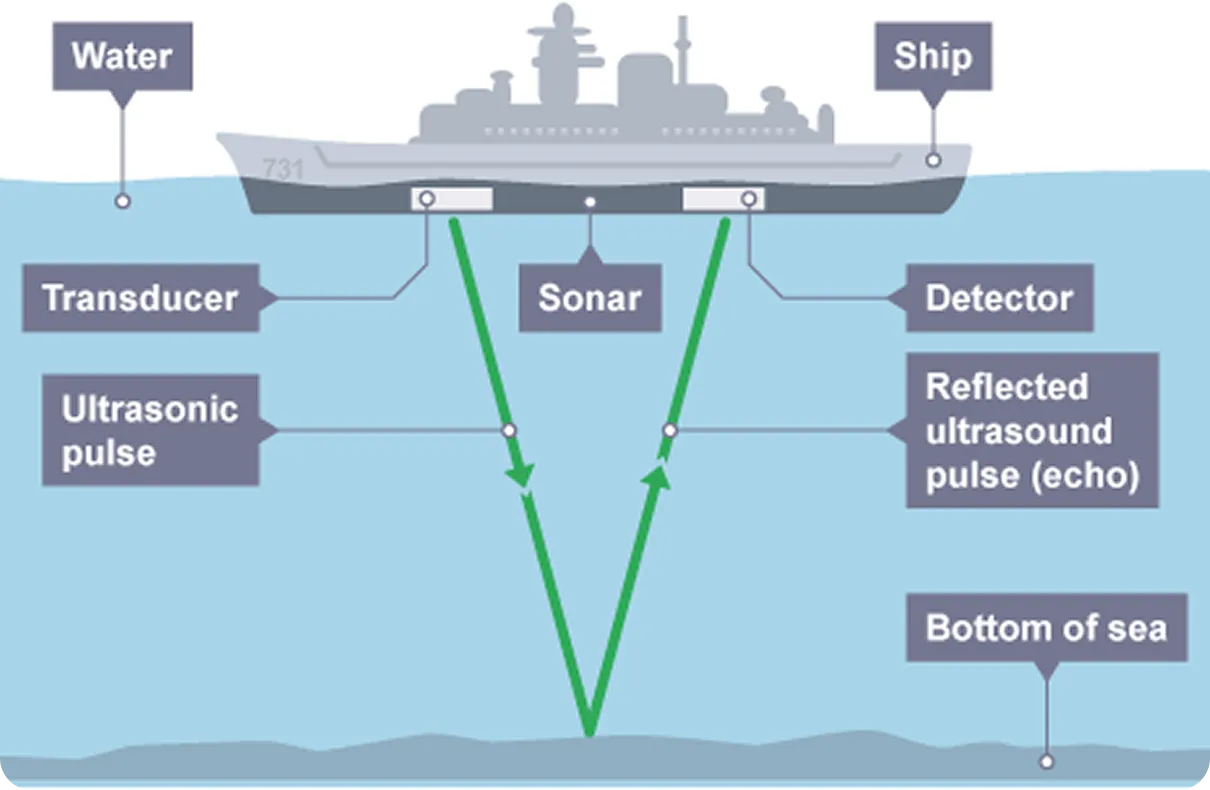

Le immagini radar e sonar sono tecnologie che detect e mappano gli oggetti inviando segnali e analizzandone i riflessi, in modo simile al LiDAR. A differenza dell'imaging RGB, che si basa sulle onde luminose per catturare informazioni visive, il radar utilizza onde elettromagnetiche, tipicamente onde radio, mentre il sonar utilizza onde sonore. Sia il radar che il sonar emettono impulsi e misurano il tempo che il segnale impiega a rimbalzare da un oggetto, fornendo informazioni sulla sua distanza, dimensione e velocità.

Le immagini radar sono particolarmente utili quando la visibilità è scarsa, ad esempio durante la nebbia, la pioggia o la notte. Poiché non si basa sulla luce, è in grado di detect velivoli, veicoli o terreni in condizioni di completa oscurità. Ciò rende il radar una scelta affidabile per l'aviazione, il monitoraggio meteorologico e la navigazione autonoma.

In confronto, l'imaging sonar è comunemente utilizzato in ambienti sottomarini dove la luce non può arrivare. Utilizza onde sonore che viaggiano attraverso l'acqua e rimbalzano su oggetti sommersi, consentendo il rilevamento di sottomarini, la mappatura dei fondali oceanici e l'esecuzione di missioni di soccorso subacquee. I progressi nella computer vision stanno ora consentendo un ulteriore miglioramento del rilevamento subacqueo combinando i dati sonar con l'analisi intelligente per un rilevamento e un processo decisionale migliorati.

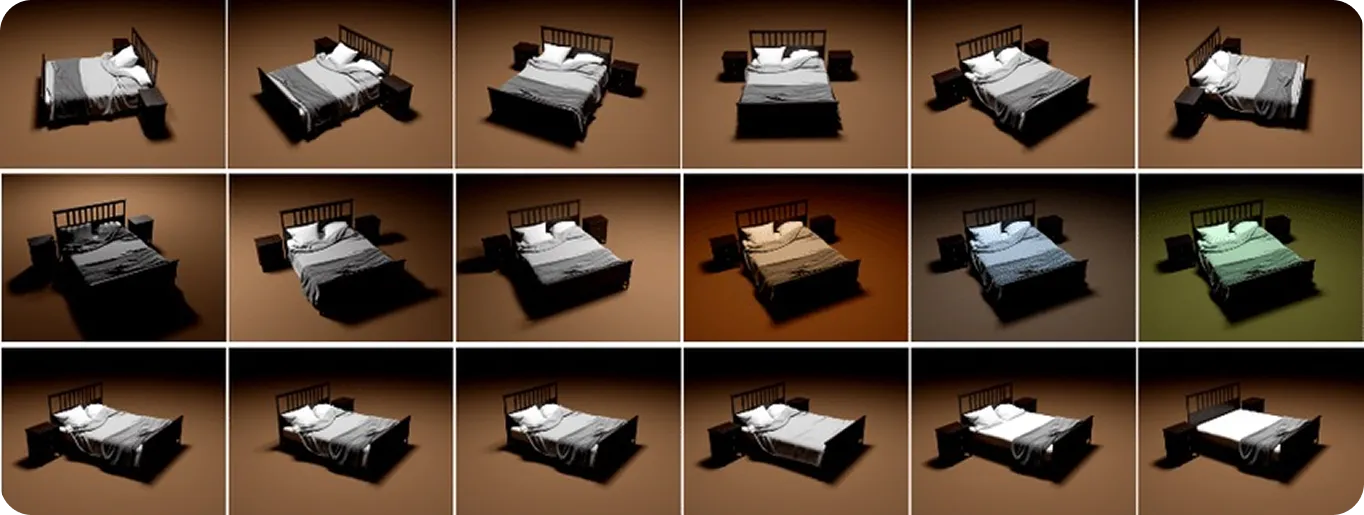

Finora, i diversi tipi di dati di cui abbiamo discusso sono quelli che possono essere raccolti dal mondo reale. Tuttavia, i dati visivi sintetici e simulati sono entrambi tipi di contenuto artificiale. I dati sintetici vengono generati da zero utilizzando la modellazione 3D o l'IA generativa per produrre immagini o video dall'aspetto realistico.

I dati simulati sono simili, ma implicano la creazione di ambienti virtuali che replicano il comportamento del mondo fisico, inclusi il riflesso della luce, la formazione delle ombre e il movimento degli oggetti. Sebbene tutti i dati visivi simulati siano sintetici, non tutti i dati sintetici sono simulati. La differenza fondamentale è che i dati simulati replicano il comportamento realistico, non solo l'aspetto.

Questi tipi di dati sono utili per l'addestramento di modelli di computer vision, in particolare quando i dati del mondo reale sono difficili da raccogliere o quando è necessario simulare situazioni specifiche e rare. Gli sviluppatori possono creare intere scene, scegliere tipi di oggetti, posizioni e illuminazione e aggiungere automaticamente etichette come bounding box per l'addestramento. Questo aiuta a costruire set di dati ampi e diversificati rapidamente, senza la necessità di foto reali o etichettatura manuale, che può essere costosa e richiedere molto tempo.

Ad esempio, nel settore sanitario, i dati sintetici possono essere utilizzati per addestrare i modelli a segment cellule del cancro al seno, dove è difficile raccogliere ed etichettare grandi serie di immagini reali. I dati sintetici e simulati offrono flessibilità e controllo, colmando le lacune in cui le immagini del mondo reale sono limitate.

Ora che abbiamo esaminato come funzionano i diversi tipi di dati visivi e cosa possono fare, diamo un'occhiata più da vicino a quali tipi di dati sono i migliori per attività specifiche:

A volte, un singolo tipo di dati potrebbe non fornire sufficiente accuratezza o contesto in situazioni del mondo reale. È qui che la fusione di sensori multimodale diventa fondamentale. Combinando RGB con altri tipi di dati come termico, profondità o LiDAR, i sistemi possono superare i limiti individuali, migliorando l'affidabilità e l'adattabilità.

Ad esempio, nell'automazione del magazzino, l'utilizzo di RGB per il riconoscimento degli oggetti, la profondità per la misurazione della distanza e il termico per il rilevamento di apparecchiature surriscaldate rende le operazioni più efficienti e sicure. In definitiva, i migliori risultati derivano dalla selezione o dalla combinazione di tipi di dati in base alle esigenze specifiche della tua applicazione.

Quando si creano modelli di Vision AI, la scelta del tipo giusto di dati visivi è fondamentale. Attività come il rilevamento di oggetti, la segmentazione e il tracciamento del movimento si basano non solo sugli algoritmi, ma anche sulla qualità dei dati di input. Set di dati puliti, diversificati e accurati aiutano a ridurre il rumore e a migliorare le prestazioni.

Combinando tipi di dati come RGB, profondità, termico e LiDAR, i sistemi di IA ottengono una visione più completa dell'ambiente, rendendoli più affidabili in varie condizioni. Man mano che la tecnologia continua a migliorare, probabilmente aprirà la strada alla Vision AI per diventare più veloce, più adattabile e di maggiore impatto in tutti i settori.

Unisciti alla nostra community ed esplora il nostro repository GitHub per saperne di più sulla computer vision. Scopri le varie applicazioni relative all'IA nel settore sanitario e alla computer vision nel retail nelle nostre pagine dedicate alle soluzioni. Consulta le nostre opzioni di licenza per iniziare con la Vision AI.