Explorando vários tipos de dados para aplicações de Visão de IA

Descubra como os tipos de dados visuais, como imagens térmicas, LiDAR e imagens infravermelhas, permitem diversas aplicações de visão computacional em todos os setores.

Descubra como os tipos de dados visuais, como imagens térmicas, LiDAR e imagens infravermelhas, permitem diversas aplicações de visão computacional em todos os setores.

Tecnologias como drones costumavam ser limitadas e acessíveis apenas a pesquisadores e especialistas, mas hoje em dia, hardware de ponta está se tornando mais acessível a um público mais amplo. Essa mudança está alterando a forma como coletamos dados visuais. Com tecnologia mais acessível, agora podemos capturar imagens e vídeos de diversas fontes, além de apenas câmeras tradicionais.

Paralelamente, a análise de imagens, possibilitada pela visão computacional, um ramo da inteligência artificial (IA), está a evoluir rapidamente, permitindo às máquinas interpretar e processar dados visuais de forma mais eficaz. Este avanço abriu novas possibilidades de automatização, deteção de objectos e análise em tempo real. As máquinas podem agora reconhecer padrões, track movimentos e dar sentido a dados visuais complexos.

Alguns dos principais tipos de dados visuais incluem imagens RGB (vermelho, verde, azul), que são normalmente utilizadas para reconhecimento de objectos, imagens térmicas, que ajudam a detect assinaturas de calor em condições de pouca luz, e dados de profundidade, que permitem às máquinas compreender ambientes 3D. Cada um destes tipos de dados desempenha um papel vital na alimentação de várias aplicações de IA de visão, desde a vigilância à imagiologia médica.

Neste artigo, exploraremos os principais tipos de dados visuais usados em Visão de IA e como cada um contribui para melhorar a precisão, a eficiência e o desempenho em vários setores. Vamos começar!

Normalmente, quando você usa um smartphone para tirar uma foto ou visualizar imagens de CFTV, você está trabalhando com imagens RGB. RGB significa vermelho, verde e azul, e são os três canais de cores que representam informações visuais em imagens digitais.

Imagens e vídeos RGB são tipos de dados visuais intimamente relacionados usados em visão computacional, ambos capturados usando câmeras padrão. A principal diferença é que as imagens capturam um único momento, enquanto os vídeos são uma sequência de frames que mostram como as coisas mudam ao longo do tempo.

As imagens RGB são geralmente utilizadas para tarefas de visão computacional como a deteção de objectos, a segmentação de instâncias e a estimativa de pose, apoiadas por modelos como Ultralytics YOLO11. Estas aplicações dependem da identificação de padrões, formas ou caraterísticas específicas numa única imagem.

Os vídeos, por outro lado, são essenciais quando o movimento ou o tempo são um fator, como no reconhecimento de gestos, na vigilância ou no seguimento de acções. Uma vez que os vídeos podem ser considerados uma série de imagens, os modelos de visão por computador, como o YOLO11 , processam-nos fotograma a fotograma para compreender o movimento e o comportamento ao longo do tempo.

Por exemplo, YOLO11 pode ser utilizado para analisar imagens ou vídeos RGB para detect ervas daninhas e contar plantas em campos agrícolas. Isto melhora a monitorização das culturas e ajuda a track as alterações ao longo dos ciclos de crescimento para uma gestão agrícola mais eficiente.

Os dados de profundidade adicionam uma terceira dimensão à informação visual, indicando a distância dos objetos à câmara ou sensor. Ao contrário das imagens RGB que apenas capturam cor e textura, os dados de profundidade fornecem contexto espacial. Mostram a distância entre os objetos e a câmara, tornando possível interpretar o layout 3D de uma cena.

Este tipo de dado é capturado usando tecnologias como LiDAR, visão estéreo (usando duas câmeras para imitar a percepção de profundidade humana) e câmeras Time-of-Flight (medindo o tempo que a luz leva para viajar até um objeto e voltar).

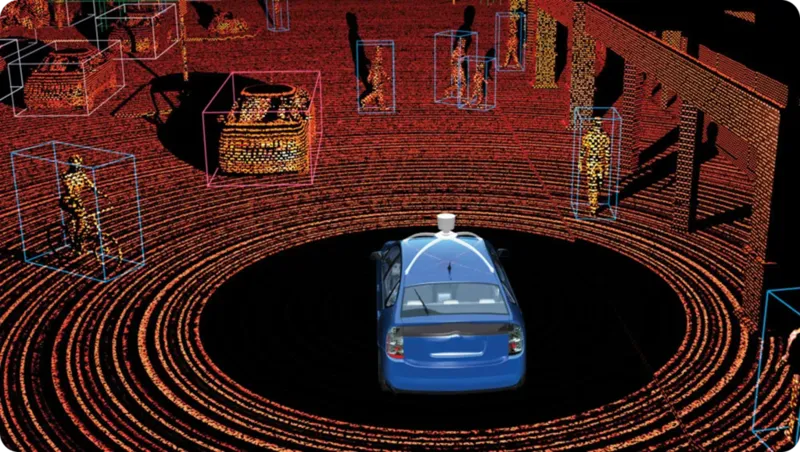

Entre estes, o LiDAR (Light Detection and Ranging) é frequentemente o mais confiável para medição de profundidade. Ele funciona emitindo pulsos de laser rápidos e medindo quanto tempo eles levam para retornar. O resultado é um mapa 3D altamente preciso, conhecido como nuvem de pontos, que destaca a forma, a posição e a distância dos objetos em tempo real.

A tecnologia LiDAR pode ser dividida em dois tipos principais, cada um projetado para aplicações e ambientes específicos. Aqui está uma análise mais detalhada de ambos os tipos:

Uma aplicação impactante dos dados LiDAR é em veículos autônomos, onde desempenha um papel fundamental em tarefas como detecção de faixa, prevenção de colisões e identificação de objetos próximos. O LiDAR gera mapas 3D detalhados e em tempo real do ambiente, permitindo que o veículo veja objetos, calcule sua distância e navegue com segurança.

As imagens RGB capturam o que vemos no espectro de luz visível; no entanto, outras tecnologias de imagem, como a imagem térmica e infravermelha, vão além disso. A imagem infravermelha captura a luz infravermelha que é emitida ou refletida por objetos, tornando-a útil em condições de pouca luz.

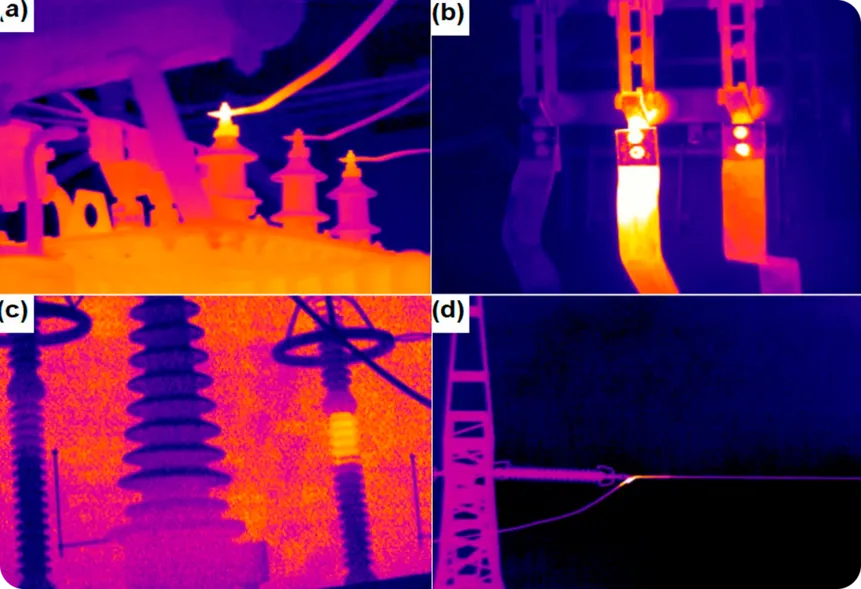

A imagem térmica, em contraste, detecta o calor emitido pelos objetos e mostra as diferenças de temperatura, permitindo que funcione na escuridão completa ou através de fumaça, neblina e outras obstruções. Este tipo de dado é particularmente útil para monitorar e detectar problemas, especialmente em indústrias onde as mudanças de temperatura podem sinalizar problemas potenciais.

Um exemplo interessante é o uso de imagens térmicas para monitorar componentes elétricos em busca de sinais de superaquecimento. Ao detectar diferenças de temperatura, as câmeras térmicas podem identificar problemas antes que resultem em falhas de equipamentos, incêndios ou danos dispendiosos.

Do mesmo modo, as imagens de infravermelhos podem ajudar a detect fugas em condutas ou isolamentos, identificando diferenças de temperatura que indicam a fuga de gases ou fluidos, o que é crucial para evitar situações perigosas e melhorar a eficiência energética.

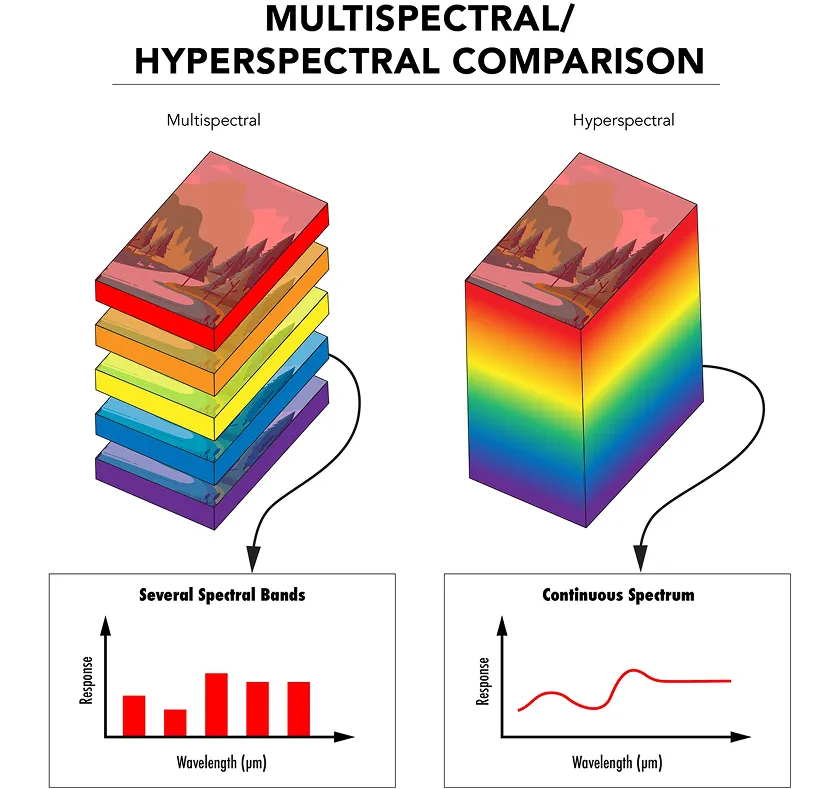

Enquanto a imagem infravermelha e térmica capturam aspectos específicos do espectro eletromagnético, a imagem multiespectral coleta luz de algumas faixas de comprimento de onda selecionadas, cada uma escolhida para um propósito específico, como detectar vegetação saudável ou identificar materiais de superfície.

A imagem hiperespectral leva isso um passo adiante, capturando a luz em centenas de faixas de comprimento de onda muito estreitas e contínuas. Isso fornece uma assinatura de luz detalhada para cada pixel na imagem, oferecendo uma compreensão muito mais profunda de qualquer material que esteja sendo observado.

Tanto a imagem multiespectral quanto a hiperespectral usam sensores e filtros especiais para capturar luz em diferentes comprimentos de onda. Os dados são então organizados em uma estrutura 3D chamada cubo espectral, com cada camada representando um comprimento de onda diferente.

Os modelos de IA podem analisar estes dados para detect caraterísticas que as câmaras normais ou o olho humano não conseguem ver. Por exemplo, na fenotipagem de plantas, a imagem hiperespectral pode ser utilizada para monitorizar a saúde e o crescimento das plantas, detectando alterações subtis nas suas folhas ou caules, tais como deficiências de nutrientes ou stress. Isto ajuda os investigadores a avaliar a saúde das plantas e a otimizar as práticas agrícolas sem necessidade de recorrer a métodos invasivos.

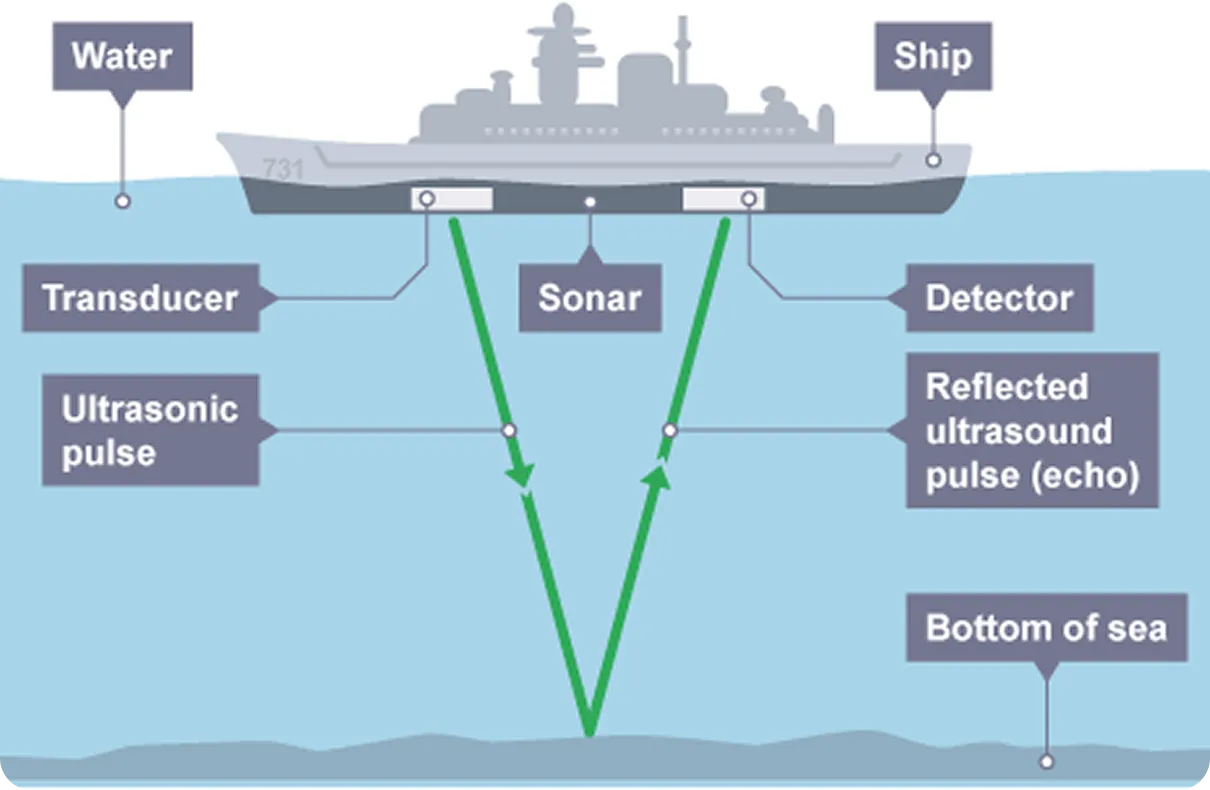

As imagens de radar e de sonar são tecnologias que detect e cartografam objectos através do envio de sinais e da análise dos seus reflexos, à semelhança do LiDAR. Ao contrário das imagens RGB, que se baseiam em ondas de luz para captar informações visuais, o radar utiliza ondas electromagnéticas, normalmente ondas de rádio, enquanto o sonar utiliza ondas sonoras. Tanto os sistemas de radar como os de sonar emitem impulsos e medem o tempo que o sinal demora a ser refletido por um objeto, fornecendo informações sobre a sua distância, tamanho e velocidade.

As imagens de radar são especialmente úteis quando a visibilidade é reduzida, como durante o nevoeiro, a chuva ou a noite. Como não depende da luz, pode detect aeronaves, veículos ou terreno na escuridão total. Isto faz do radar uma escolha fiável na aviação, monitorização meteorológica e navegação autónoma.

Em comparação, a imagem de sonar é comumente usada em ambientes subaquáticos onde a luz não consegue chegar. Ela usa ondas sonoras que viajam pela água e ricocheteiam em objetos submersos, permitindo a detecção de submarinos, o mapeamento de fundos oceânicos e a execução de missões de resgate subaquáticas. Os avanços na visão computacional agora estão permitindo um aprimoramento adicional da detecção subaquática, combinando dados de sonar com análise inteligente para detecção e tomada de decisões aprimoradas.

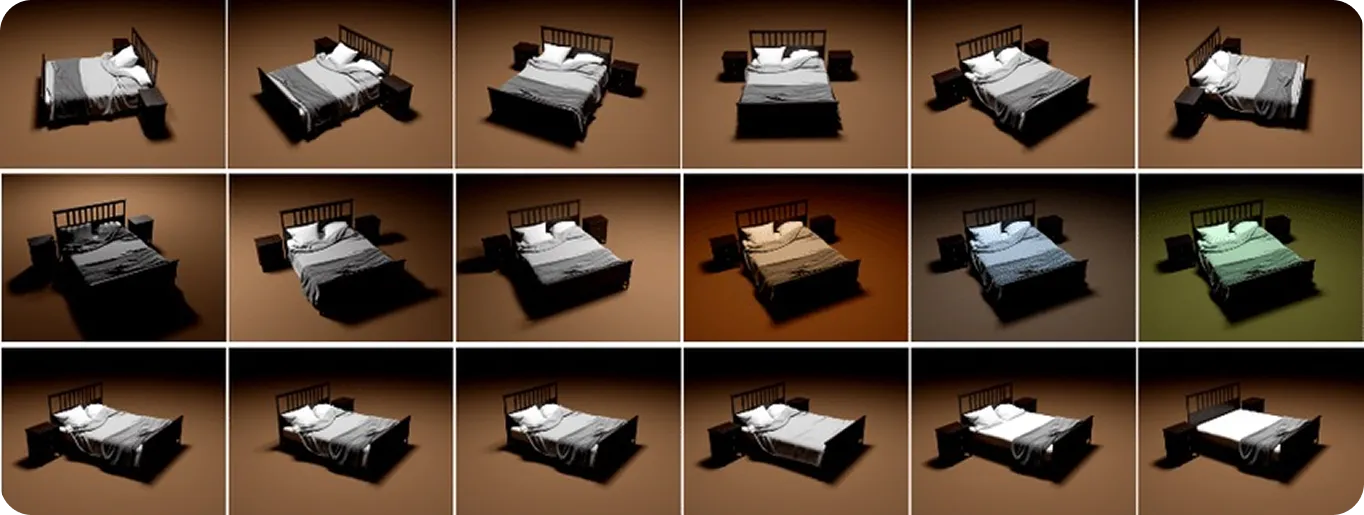

Até agora, os diferentes tipos de dados que discutimos foram aqueles que podem ser coletados do mundo real. No entanto, os dados visuais sintéticos e simulados são ambos tipos de conteúdo artificial. Os dados sintéticos são gerados do zero usando modelagem 3D ou IA generativa para produzir imagens ou vídeos com aparência realista.

Dados simulados são semelhantes, mas envolvem a criação de ambientes virtuais que replicam como o mundo físico se comporta, incluindo reflexão de luz, formação de sombras e movimento de objetos. Embora todos os dados visuais simulados sejam sintéticos, nem todos os dados sintéticos são simulados. A principal diferença é que os dados simulados replicam o comportamento realista, não apenas a aparência.

Esses tipos de dados são úteis para treinar modelos de visão computacional, principalmente quando os dados do mundo real são difíceis de coletar ou quando situações específicas e raras precisam ser simuladas. Os desenvolvedores podem criar cenas inteiras, escolher tipos de objetos, posições e iluminação e adicionar automaticamente rótulos como caixas delimitadoras para treinamento. Isso ajuda a construir conjuntos de dados grandes e diversos rapidamente, sem a necessidade de fotos reais ou rotulagem manual, o que pode ser caro e demorado.

Por exemplo, no sector dos cuidados de saúde, os dados sintéticos podem ser utilizados para treinar modelos de segment células de cancro da mama, onde é difícil recolher e rotular grandes conjuntos de dados de imagens reais. Os dados sintéticos e simulados proporcionam flexibilidade e controlo, preenchendo lacunas onde as imagens do mundo real são limitadas.

Agora que analisamos como diferentes tipos de dados visuais funcionam e o que eles podem fazer, vamos dar uma olhada mais de perto em quais tipos de dados são melhores para tarefas específicas:

Às vezes, um único tipo de dado pode não fornecer precisão ou contexto suficientes em situações do mundo real. É aqui que a fusão de sensores multimodais se torna fundamental. Ao combinar RGB com outros tipos de dados, como térmico, profundidade ou LiDAR, os sistemas podem superar as limitações individuais, melhorando a confiabilidade e a adaptabilidade.

Por exemplo, na automação de armazéns, usar RGB para reconhecimento de objetos, profundidade para medição de distância e termal para detectar equipamentos superaquecidos torna as operações mais eficientes e seguras. Em última análise, os melhores resultados vêm da seleção ou combinação de tipos de dados com base nas necessidades específicas de sua aplicação.

Ao construir modelos de Visão de IA, escolher o tipo certo de dados visuais é crucial. Tarefas como detecção de objetos, segmentação e rastreamento de movimento dependem não apenas de algoritmos, mas também da qualidade dos dados de entrada. Conjuntos de dados limpos, diversos e precisos ajudam a reduzir o ruído e melhorar o desempenho.

Ao combinar tipos de dados como RGB, profundidade, térmico e LiDAR, os sistemas de IA obtêm uma visão mais completa do ambiente, tornando-os mais confiáveis em várias condições. À medida que a tecnologia continua a melhorar, provavelmente abrirá caminho para que a Visão de IA se torne mais rápida, mais adaptável e mais impactante em todos os setores.

Junte-se à nossa comunidade e explore nosso repositório GitHub para saber mais sobre visão computacional. Descubra diversas aplicações relacionadas à IA na área da saúde e à visão computacional no varejo em nossas páginas de soluções. Confira nossas opções de licenciamento para começar a usar a Vision AI.