Explore cómo la IA neurosimbólica pretende combinar el aprendizaje y la lógica para construir sistemas que comprendan el contexto y ofrezcan decisiones más transparentes y explicables.

Explore cómo la IA neurosimbólica pretende combinar el aprendizaje y la lógica para construir sistemas que comprendan el contexto y ofrezcan decisiones más transparentes y explicables.

Hoy en día, gracias al rápido crecimiento de la inteligencia artificial (IA) y a la creciente disponibilidad de potencia de cálculo, los modelos avanzados de IA se lanzan más rápido que nunca. De hecho, la IA está impulsando innovaciones significativas en muchos sectores.

Por ejemplo, en la sanidad, los sistemas de IA se están utilizando para ayudar en tareas como el análisis de imágenes médicas para un diagnóstico precoz. Sin embargo, como cualquier tecnología, la IA tiene sus limitaciones.

Uno de los principales problemas es la transparencia. Por ejemplo, un modelo de detección de objetos puede localizar con precisión un tumor en una resonancia magnética cerebral, pero puede ser difícil entender cómo ha llegado el modelo a esa conclusión. Esta falta de explicación dificulta que médicos e investigadores confíen plenamente en los resultados de la IA o los validen.

Precisamente por eso crece el interés por el campo emergente de la IA neurosimbólica. La IA neurosimbólica combina la capacidad de reconocimiento de patrones del aprendizaje profundo con el razonamiento estructurado y basado en reglas de la IA simbólica. El objetivo es crear sistemas que hagan predicciones precisas, pero que también puedan explicar su razonamiento de forma comprensible para los humanos.

En este artículo analizaremos cómo funciona la inteligencia artificial neurosimbólica y cómo combina el aprendizaje y el razonamiento para crear sistemas más transparentes y conscientes del contexto. Empecemos.

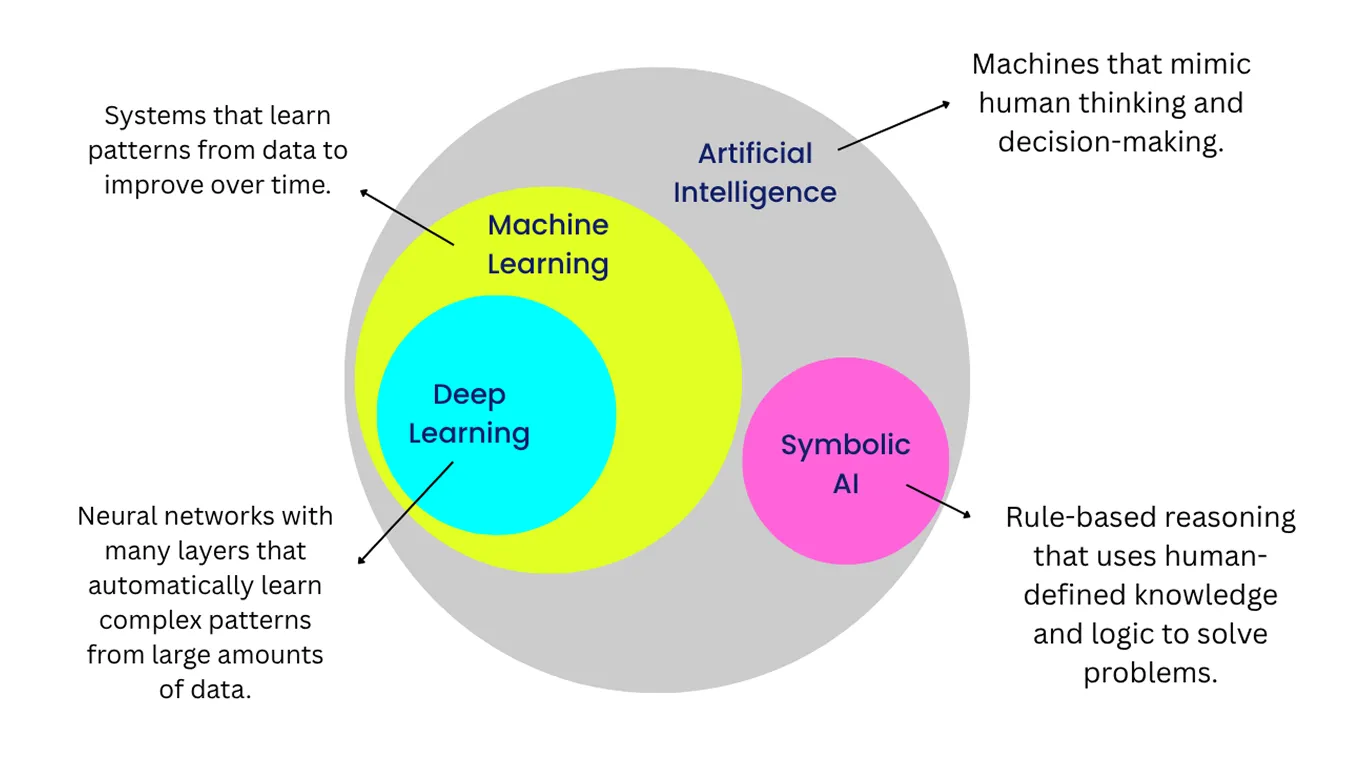

Antes de sumergirnos en la IA neurosimbólica, echemos un vistazo más de cerca a los dos subcampos que reúne: el aprendizaje profundo y la IA simbólica.

El aprendizaje profundo se centra en reconocer patrones en los datos, mientras que la IA simbólica utiliza reglas, lógica o sentido común para razonar los problemas. Cada una tiene sus puntos fuertes, pero también sus limitaciones. Combinándolas, la IA neurosimbólica crea sistemas que pueden aprender de los datos y explicar sus decisiones con mayor claridad.

El aprendizaje profundo es una rama del aprendizaje automático que utiliza redes neuronales artificiales, inspiradas libremente en la forma en que el cerebro procesa la información. Estas redes aprenden analizando grandes cantidades de datos y ajustando sus conexiones internas para mejorar su rendimiento.

Esto les permite reconocer patrones en imágenes, sonidos y texto sin necesidad de reglas elaboradas a mano para cada situación. Por ello, el aprendizaje profundo es muy eficaz para tareas centradas en la percepción, como el reconocimiento de imágenes, el procesamiento del habla y la traducción de idiomas.

Un buen ejemplo es un modelo de visión por ordenador entrenado para segment objetos en imágenes. Con suficientes ejemplos etiquetados, puede aprender a separar carreteras, vehículos y peatones en imágenes de tráfico en tiempo real.

Sin embargo, a pesar de su precisión, los modelos de aprendizaje profundo a menudo tienen dificultades para explicar claramente cómo han llegado a un resultado concreto. Este reto, comúnmente conocido como el problema de la caja negra, hace que sea más difícil para los usuarios interpretar o verificar las decisiones del modelo, especialmente en áreas sensibles como la salud o las finanzas. Es importante porque la IA responsable requiere transparencia, confianza y la capacidad de entender por qué un modelo ha hecho una predicción determinada.

La IA simbólica adopta un enfoque más estructurado de la inteligencia y la toma de decisiones. Representa el conocimiento mediante símbolos y aplica reglas lógicas para trabajar con ese conocimiento, de forma similar a como utilizamos el razonamiento y el lenguaje para resolver problemas. Cada paso del proceso de razonamiento está definido, lo que hace que las decisiones de la IA simbólica sean transparentes y más fáciles de explicar.

El conocimiento simbólico funciona especialmente bien en tareas que siguen reglas claras y bien definidas, como la planificación, la programación o la gestión del conocimiento estructurado. Sin embargo, la IA simbólica tiene dificultades con los datos no estructurados o las situaciones que no encajan perfectamente en categorías predefinidas.

Un ejemplo común de enfoques simbólicos en acción son los primeros programas de ajedrez. En lugar de aprender de partidas anteriores o adaptarse a diferentes oponentes, seguían reglas y estrategias fijas. Como resultado, su juego tendía a ser rígido y predecible.

En la década de 2010, a medida que se generalizaba el aprendizaje profundo, los investigadores empezaron a buscar formas de ir más allá del simple reconocimiento de patrones y pasar a comprender las relaciones y el contexto. Este cambio hizo posible que los modelos de IA no solo detect objetos en una escena, como un gato y una alfombrilla, sino que también interpretaran cómo se relacionan esos objetos, por ejemplo, reconociendo que el gato está sentado en la alfombrilla.

Sin embargo, estos avances también han puesto de manifiesto una limitación fundamental. Los modelos de aprendizaje profundo pueden reconocer patrones extremadamente bien, pero a menudo tienen dificultades para explicar su razonamiento o manejar situaciones desconocidas. Esta renovada atención al razonamiento llevó a los investigadores de vuelta a un campo que ha existido desde la década de 1980: la IA neuro-simbólica.

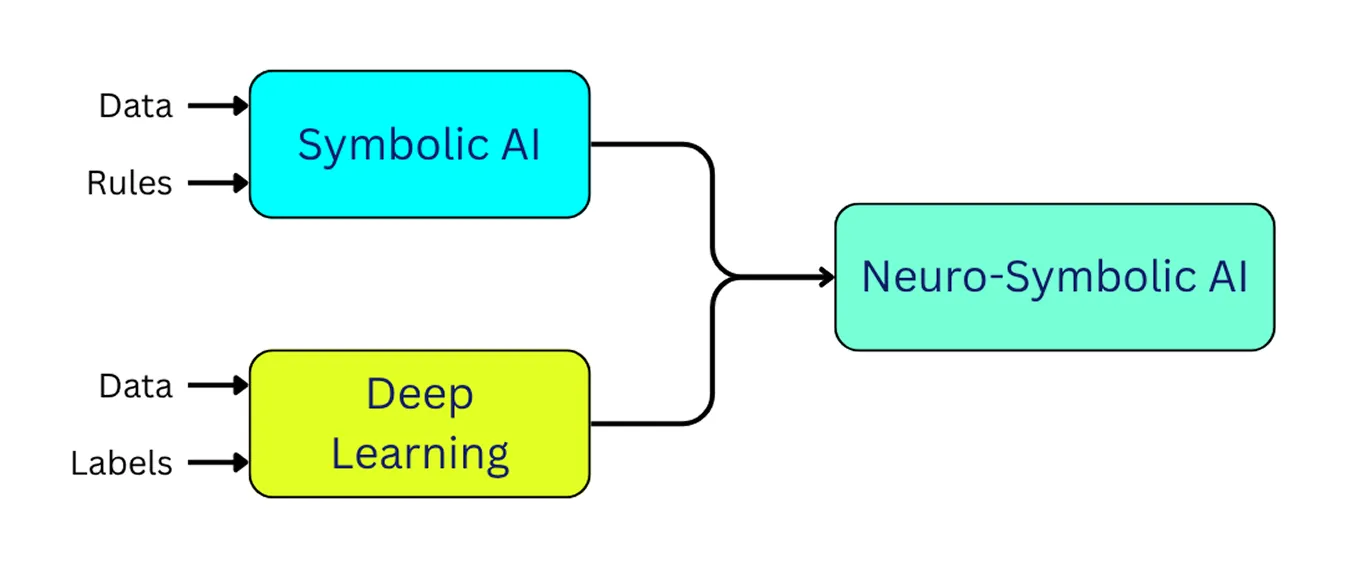

La IA neurosimbólica integra el aprendizaje profundo y la IA simbólica. Permite a los modelos aprender a partir de ejemplos de la misma forma que lo hace el aprendizaje profundo, al tiempo que aplican la lógica y el razonamiento como lo hace la IA simbólica.

En pocas palabras, la IA neurosimbólica puede reconocer información, entender el contexto y ofrecer explicaciones más claras de sus decisiones. Este enfoque nos acerca al desarrollo de sistemas de IA que se comporten de forma más fiable y parecida a la humana.

Las arquitecturas neuro-simbólicas aúnan aprendizaje y razonamiento en un único marco. Suele incluir tres partes principales: una capa de percepción neuronal que interpreta los datos brutos, una capa de razonamiento simbólico que aplica la lógica y una capa de integración que conecta ambas. A continuación, examinaremos más detenidamente cada capa.

El componente de percepción neuronal procesa datos no estructurados, como imágenes, vídeo, texto o audio, y los convierte en representaciones internas con las que el sistema puede trabajar. Normalmente utiliza modelos de aprendizaje profundo para detect patrones e identificar objetos o características en la entrada. En esta fase, el sistema reconoce lo que hay en los datos, pero aún no razona sobre el significado, las relaciones o el contexto.

Estos son algunos tipos comunes de modelos de aprendizaje profundo utilizados en esta capa:

En última instancia, estos modelos neuronales extraen y representan características significativas de los datos brutos. Este resultado se convierte en la entrada de la capa de razonamiento simbólico, que interpreta y razona sobre lo que el sistema ha detectado.

La capa de razonamiento simbólico toma la información producida por la capa de percepción neural y le da sentido utilizando la lógica. En lugar de trabajar sólo a partir de patrones, se basa en reglas, grafos de conocimiento, bases de conocimiento y ontologías (descripciones organizadas de conceptos y de cómo se relacionan entre sí). Todo ello ayuda al sistema a entender cómo encajan los distintos elementos y qué acciones tienen sentido en una situación determinada.

Por ejemplo, en un coche autoconducido, la capa de percepción neuronal puede reconocer un semáforo en rojo en la imagen de la cámara. La capa de razonamiento simbólico puede entonces aplicar una regla como: "Si el semáforo está en rojo, el vehículo debe detenerse". Como el razonamiento se basa en reglas claras, las decisiones del sistema son más fáciles de explicar y verificar, lo que es especialmente importante en situaciones en las que la seguridad y la responsabilidad son importantes.

La capa de integración conecta la capa de percepción neural y la capa de razonamiento simbólico, garantizando que el aprendizaje y el razonamiento funcionen conjuntamente. En una dirección, convierte las salidas de los modelos neuronales (como la detección de un peatón) en representaciones simbólicas que describen el objeto y sus atributos.

En la otra dirección, toma reglas simbólicas (por ejemplo, "un vehículo debe detenerse si hay un peatón en un paso de peatones") y las traduce en señales que guían los modelos neuronales. Esto puede implicar resaltar las zonas relevantes de una imagen, influir en la atención o dar forma a las vías de decisión del modelo.

Este intercambio bidireccional forma un bucle de retroalimentación. La parte neuronal obtiene estructura e interpretabilidad de las reglas simbólicas, mientras que la parte simbólica puede adaptarse más eficazmente a los datos del mundo real. Técnicas como las redes neuronales lógicas (RNL) facilitan esta interacción al integrar restricciones lógicas directamente en las arquitecturas neuronales.

Al vincular de este modo la percepción y el razonamiento, la IA neurosimbólica puede producir decisiones precisas y fáciles de interpretar. Muchos investigadores ven en este enfoque un paso prometedor hacia una IA más fiable y adaptada al ser humano, y potencialmente una base para futuros avances hacia la inteligencia general artificial (AGI).

Ahora que entendemos mejor qué es y cómo funciona una IA neurosimbólica, echemos un vistazo a algunos de sus casos de uso en el mundo real.

Los vehículos autónomos necesitan comprender su entorno para funcionar con seguridad. Utilizan tecnologías como la visión por ordenador para detect peatones, vehículos, marcas viales y señales de tráfico.

Aunque los modelos de aprendizaje profundo pueden identificar estos objetos con precisión, no siempre entienden qué significan esos objetos en su contexto o cómo se relacionan entre sí en una situación del mundo real. Por ejemplo, un modelo neuronal puede reconocer a un peatón en un paso de peatones, pero no puede decir si está a punto de cruzar o simplemente está parado y esperando.

La IA neurosimbólica intenta colmar esta laguna permitiendo a los vehículos autoconducidos combinar el reconocimiento visual con el razonamiento lógico, de modo que puedan interpretar situaciones en lugar de limitarse a identificar objetos. Investigaciones recientes sobre IA han demostrado que los sistemas que combinan la percepción neuronal con reglas simbólicas pueden mejorar la predicción del comportamiento de los peatones.

En estos sistemas, el componente neuronal analiza señales visuales como la postura, el movimiento y la posición de un peatón. A continuación, el componente simbólico aplica reglas lógicas, teniendo en cuenta factores como si la persona está cerca de un paso de peatones o qué indica la señal de tráfico actual.

Combinando estas dos perspectivas, el sistema neuro-simbólico puede hacer algo más que detect un peatón. Puede hacer una predicción razonable sobre la probabilidad de que el peatón cruce y explicar por qué ha tomado esa decisión. Esto conduce a un comportamiento más seguro y transparente en los vehículos autónomos.

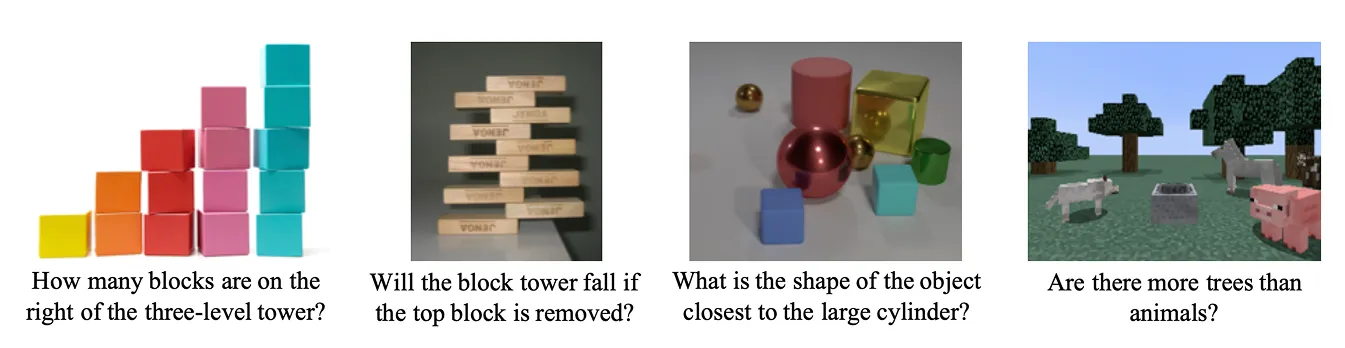

Otra aplicación importante de la IA neurosimbólica es la respuesta a preguntas visuales (VQA). Los sistemas VQA están diseñados para responder a preguntas sobre imágenes.

Reúne grandes modelos lingüísticos (LLM) y modelos visuales para realizar razonamientos multimodales, combinando lo que el sistema ve con lo que entiende. Por ejemplo, si a un sistema VQA se le muestra una imagen y se le pregunta: "¿Está la taza encima de la mesa?", tiene que reconocer los objetos pero también entender la relación entre ellos. Tiene que determinar si la taza se encuentra realmente encima de la mesa en la escena.

Un estudio reciente ha demostrado cómo la IA neurosimbólica puede mejorar el VQA integrando la percepción neuronal con el razonamiento simbólico. En el sistema propuesto, la red neuronal analiza primero la imagen para reconocer objetos y sus atributos, como el color, la forma o el tamaño.

A continuación, el componente de razonamiento simbólico aplica reglas lógicas para interpretar cómo se relacionan estos objetos entre sí y responder a la pregunta. Si se le pregunta "¿Cuántos cilindros grises hay en la escena?", la parte neuronal identifica todos los cilindros y sus colores, y la parte simbólica los filtra en función de los criterios y cuenta los correctos.

Este tipo de investigación muestra cómo el VQA neurosimbólico puede ir más allá de la mera provisión de respuestas. Como el modelo puede mostrar los pasos que ha seguido para llegar a una conclusión, apoya la IA explicable, en la que los sistemas hacen predicciones y justifican su razonamiento de forma comprensible.

Estas son algunas de las principales ventajas de utilizar la IA neurosimbólica:

A pesar de su potencial, la IA neurosimbólica sigue evolucionando y presenta ciertos retos prácticos. He aquí algunas de sus principales limitaciones:

La IA neurosimbólica representa un paso importante hacia la construcción de sistemas de IA que no sólo puedan percibir el mundo, sino también razonar sobre él y explicar sus decisiones. A diferencia de los sistemas tradicionales de aprendizaje profundo, que se basan principalmente en patrones aprendidos a partir de datos, la IA neurosimbólica combina el aprendizaje estadístico con la lógica estructurada y el conocimiento. No sustituye al aprendizaje profundo, sino que lo complementa y nos acerca un poco más al desarrollo de una IA capaz de comprender y razonar de forma más parecida a la humana.

Únase a nuestra comunidad y explore nuestro repositorio de GitHub. Consulte nuestras páginas de soluciones para descubrir diversas aplicaciones de la IA en la agricultura y la visión por ordenador en la atención sanitaria. Descubra nuestras opciones de licencia y comience a construir su proyecto de Vision AI.