Acompáñenos mientras nos sumergimos en el Segment Anything Model 2SAM 2) de Meta AI y comprendemos para qué aplicaciones en tiempo real puede utilizarse en diversos sectores.

Acompáñenos mientras nos sumergimos en el Segment Anything Model 2SAM 2) de Meta AI y comprendemos para qué aplicaciones en tiempo real puede utilizarse en diversos sectores.

El 29 de julio de 2024, Meta AI lanzó la segunda versión de su Segment Anything Model, SAM 2. El nuevo modelo puede determinar con precisión qué píxeles pertenecen a un objeto tanto en imágenes como en vídeos. Lo mejor es que el modelo es capaz de seguir un objeto de forma consistente a lo largo de todos los fotogramas de un vídeo en tiempo real. SAM 2 abre interesantes posibilidades para la edición de vídeo, las experiencias de realidad mixta y la anotación más rápida de datos visuales para el entrenamiento de sistemas de visión por ordenador.

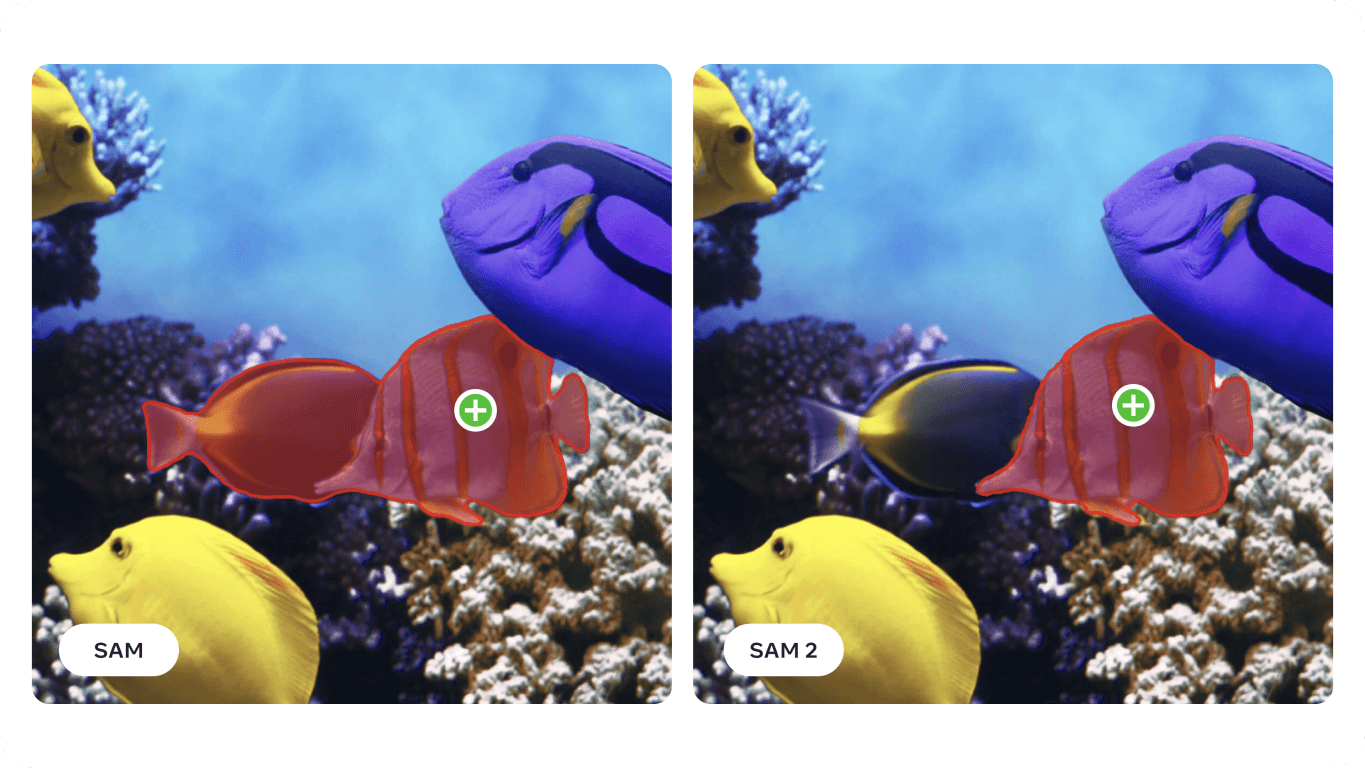

Basándose en el éxito del SAM original, que se ha utilizado en ámbitos como las ciencias marinas, las imágenes por satélite y la medicina, SAM 2 afronta retos como los objetos que se mueven rápidamente y los cambios de aspecto. Su mayor precisión y eficacia la convierten en una herramienta versátil para una amplia gama de aplicaciones. En este artículo, nos centraremos en dónde puede aplicarseSAM 2 y por qué es importante para la comunidad de la IA.

El Segment Anything Model 2 es un modelo de base avanzado que admite la segmentación visual provocable o PVS tanto en imágenes como en vídeos. PVS es una técnica en la que un modelo puede segment o identificar diferentes partes de una imagen o vídeo basándose en indicaciones o entradas específicas dadas por el usuario. Estas indicaciones pueden adoptar la forma de clics, recuadros o máscaras que resaltan el área de interés. El modelo genera entonces una máscara de segmentación que delimita el área especificada.

La arquitectura SAM 2 se basa en la SAM original y amplía la segmentación de imágenes para incluir también la segmentación de vídeo. Incorpora un descodificador de máscaras ligero que utiliza datos de imagen e indicaciones para crear máscaras de segmentación. Para los vídeos, SAM 2 introduce un sistema de memoria que le ayuda a recordar información de fotogramas anteriores, garantizando un seguimiento preciso a lo largo del tiempo. El sistema de memoria incluye componentes que almacenan y recuerdan detalles sobre los objetos segmentados. SAM 2 también puede gestionar oclusiones, track objetos en varios fotogramas y gestionar indicaciones ambiguas generando varias máscaras posibles. La avanzada arquitectura de SAM 2 le confiere una gran capacidad tanto en entornos visuales estáticos como dinámicos.

En concreto, con respecto a la segmentación de vídeo, SAM 2 consigue una mayor precisión con tres veces menos interacciones del usuario en comparación con los métodos anteriores. En cuanto a la segmentación de imágenes, SAM 2 supera al Segment Anything Model (SAM) original, siendo seis veces más rápido y preciso. Esta mejora se demostró en el artículo de investigación de SAM 2 en 37 conjuntos de datos diferentes, incluidos 23 en los que se había probado SAM anteriormente.

Curiosamente, SAM 2 de Meta AI se desarrolló creando el mayor conjunto de datos de segmentación de vídeo hasta la fecha, el conjunto de datos SA-V. Este amplio conjunto de datos, que incluye más de 50.000 vídeos y 35,5 millones de máscaras de segmentación, se recopiló mediante contribuciones interactivas de los usuarios. Los anotadores proporcionaron indicaciones y correcciones para ayudar al modelo a aprender de una amplia variedad de escenarios y tipos de objetos.

Gracias a sus avanzadas funciones de segmentación de imágenes y vídeos, SAM 2 puede utilizarse en diversos sectores. Exploremos algunas de estas aplicaciones.

El nuevo modelo de segmentación de Meta AI puede utilizarse en aplicaciones de Realidad Aumentada (RA) y Realidad Virtual (RV). Por ejemplo, SAM 2 puede identificar y segment con precisión objetos del mundo real y hacer que la interacción con objetos virtuales resulte más realista. Puede ser útil en diversos campos como los juegos, la educación y la formación, donde es esencial una interacción realista entre elementos virtuales y reales.

Con dispositivos como las gafas de realidad aumentada cada vez más avanzados, las capacidades de SAM 2 podrían integrarse pronto en ellos. Imagina que te pones las gafas y echas un vistazo a tu salón. Cuando tus gafas segment y se fijen en el cuenco de agua de tu perro, podrían recordarte que lo rellenes, como se muestra en la imagen inferior. O, si estás cocinando una nueva receta, las gafas podrían identificar los ingredientes en tu encimera y ofrecerte instrucciones y consejos paso a paso, mejorando tu experiencia culinaria y asegurándote de que tienes todos los elementos necesarios a mano.

Las investigaciones realizadas con el modelo SAM han demostrado que puede aplicarse en ámbitos especializados, como las imágenes de sonar. Las imágenes de sonar plantean retos únicos debido a su baja resolución, los altos niveles de ruido y las formas complejas de los objetos en las imágenes. Al ajustar SAM a las imágenes de sonar, los investigadores han demostrado su capacidad para segment con precisión diversos objetos submarinos, como basura marina, formaciones geológicas y otros elementos de interés. La obtención de imágenes submarinas precisas y fiables puede utilizarse en la investigación marina, la arqueología subacuática, la gestión pesquera y la vigilancia para tareas como la cartografía de hábitats, el descubrimiento de artefactos y la detección de amenazas.

%25252525201.png)

Dado que SAM 2 se basa en muchos de los retos a los que se enfrenta SAM y los mejora, tiene el potencial de mejorar aún más el análisis de las imágenes de sonar. Su capacidad de segmentación precisa puede ayudar en diversas aplicaciones marinas, como la investigación científica y la pesca. Por ejemplo, SAM 2 puede delinear eficazmente estructuras submarinas, detect residuos marinos e identificar objetos en imágenes de sonar orientadas hacia delante, contribuyendo así a una exploración y vigilancia submarinas más precisas y eficaces.

Éstas son las posibles ventajas de utilizar SAM 2 para analizar las imágenes del sonar:

Con la integración de SAM 2 en los procesos de obtención de imágenes por sonar, el sector marino puede lograr mayor eficacia, precisión y fiabilidad en la exploración y el análisis submarinos, lo que en última instancia redundará en mejores resultados en la investigación marina.

Otra aplicación de SAM 2 es en vehículos autónomos. SAM 2 puede identificar con precisión objetos como peatones, otros vehículos, señales de tráfico y obstáculos en tiempo real. SAM nivel de detalle que puede proporcionar SAM 2 es esencial para tomar decisiones seguras de navegación y evitación de colisiones. Al procesar los datos visuales con precisión, SAM 2 ayuda a crear un mapa detallado y fiable del entorno y permite tomar mejores decisiones.

La capacidad de SAM 2 para funcionar bien en distintas condiciones de iluminación, cambios meteorológicos y entornos dinámicos lo hace fiable para los vehículos autónomos. Tanto si se trata de una calle urbana con mucho tráfico como de una autopista con niebla, SAM 2 puede identificar y segment los objetos de forma sistemática y precisa para que el vehículo pueda responder correctamente a las distintas situaciones.

Sin embargo, hay que tener en cuenta algunas limitaciones. En el caso de objetos complejos que se mueven con rapidez, SAM 2 puede pasar por alto detalles finos y sus predicciones pueden volverse inestables a lo largo de los fotogramas. Además, SAM 2 puede confundir varios objetos de aspecto similar en escenas abarrotadas. Por eso, la integración de sensores y tecnologías adicionales es fundamental en las aplicaciones de conducción autónoma.

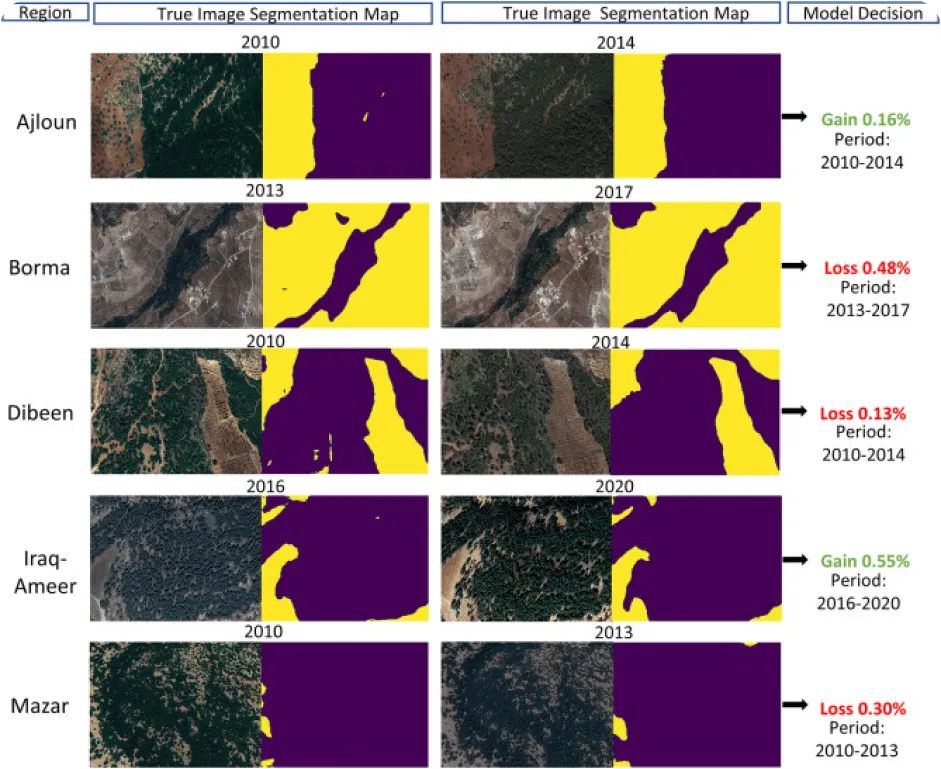

El seguimiento del medio ambiente mediante visión por ordenador puede ser complicado, sobre todo cuando se carece de datos anotados, pero eso es también lo que lo convierte en una aplicación interesante para SAM 2. SAM 2 puede utilizarse para track y analizar cambios en paisajes naturales segmentando e identificando con precisión diversas características medioambientales como bosques, masas de agua, zonas urbanas y terrenos agrícolas a partir de imágenes de satélite o drones. En concreto, la segmentación precisa ayuda a supervisar la deforestación, la urbanización y los cambios en el uso del suelo a lo largo del tiempo para proporcionar datos valiosos para la conservación y la planificación medioambientales.

Estas son algunas de las ventajas de utilizar un modelo como SAM 2 para analizar los cambios medioambientales a lo largo del tiempo:

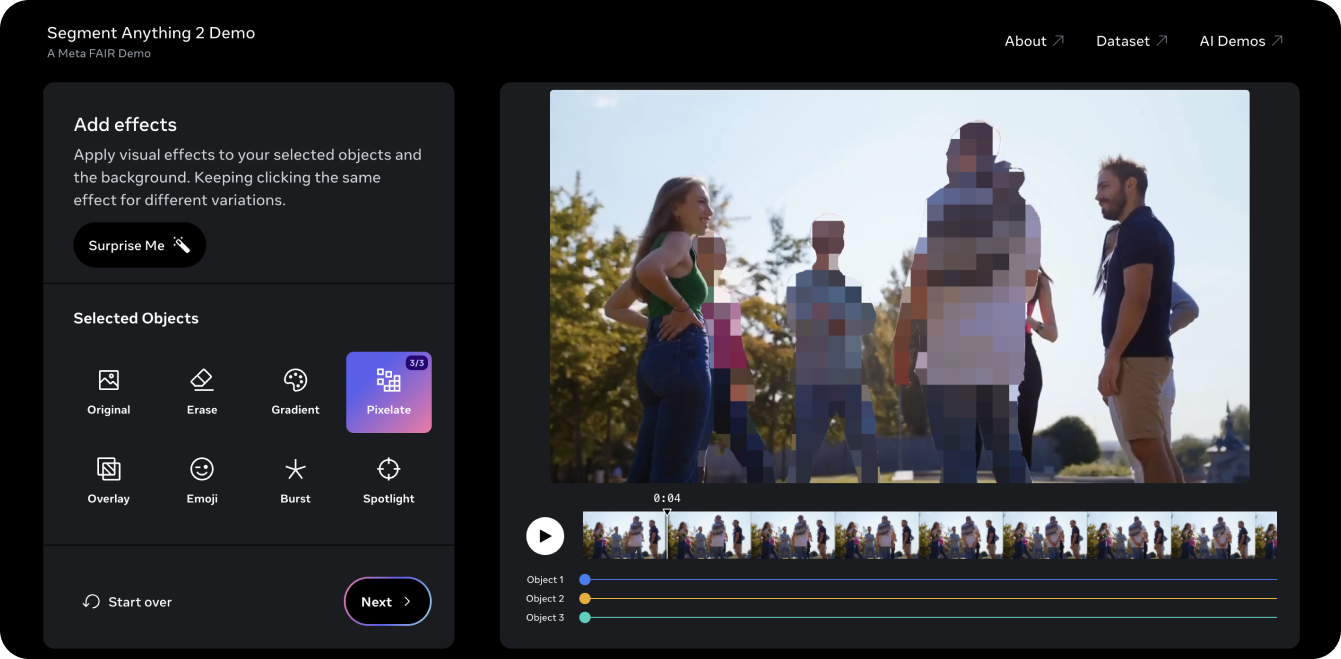

La demo de Segment Anything 2 es una buena forma de probar el modelo en un vídeo. Usando las capacidades PVS de SAM 2, tomamos un viejo vídeo de YouTubeUltralytics y fuimos capaces de segment tres objetos o personas en el vídeo y pixelarlos. Tradicionalmente, la edición de tres personas en un vídeo como ese llevaría mucho tiempo y sería tediosa y requeriría un enmascaramiento manual fotograma a fotograma. Sin embargo, SAM 2 simplifica este proceso. Con unos pocos clics en la demo, puede proteger la identidad de tres objetos de interés en cuestión de segundos.

La demostración también le permite probar algunos efectos visuales diferentes, como poner un foco en los objetos seleccionados para el seguimiento y borrar los objetos que se están siguiendo. Si le ha gustado la demostración y está listo para empezar a innovar con SAM 2, consulte la página de documentación del modeloSAM 2 deUltralytics para obtener instrucciones detalladas sobre cómo utilizar el modelo. Explore las funciones, los pasos de instalación y los ejemplos para aprovechar al máximo el potencial de SAM 2 en sus proyectos.

Segment Anything Model 2SAM 2) de Meta AI está transformando la segmentación de vídeo e imágenes. A medida que mejoran tareas como el seguimiento de objetos, descubrimos nuevas oportunidades en la edición de vídeo, la realidad mixta, la investigación científica y la imagen médica. Al facilitar tareas complejas y agilizar las anotaciones, SAM 2 está preparada para convertirse en una herramienta importante para la comunidad de la IA. Mientras sigamos explorando e innovando con modelos como SAM 2, podemos anticipar aún más aplicaciones y avances revolucionarios en diversos campos.

Obtenga más información sobre la IA explorando nuestro repositorio de GitHub y uniéndose a nuestra comunidad. Consulte nuestras páginas de soluciones para obtener información detallada sobre la IA en la fabricación y la atención sanitaria. 🚀