Explora los mejores modelos de detección de objetos en 2025, con un repaso a las arquitecturas más populares, las ventajas e inconvenientes en cuanto al rendimiento y los factores prácticos de implementación.

Explora los mejores modelos de detección de objetos en 2025, con un repaso a las arquitecturas más populares, las ventajas e inconvenientes en cuanto al rendimiento y los factores prácticos de implementación.

A principios de este año, Andrew Ng, pionero en inteligencia artificial y aprendizaje automático, introdujo el concepto de detección de objetos agenciales. Este enfoque utiliza un agente de razonamiento para detect basándose en una indicación textual sin necesidad de grandes cantidades de datos de entrenamiento.

Ser capaz de identificar objetos en imágenes y vídeos sin necesidad de grandes conjuntos de datos etiquetados es un paso hacia sistemas de visión artificial más inteligentes y flexibles. Sin embargo, la IA de visión agencial aún se encuentra en sus primeras etapas.

Aunque puede realizar tareas generales, como detectar personas o señales de tráfico en una imagen, las aplicaciones de visión artificial más precisas siguen basándose en modelos tradicionales de detección de objetos. Estos modelos se entrenan con grandes conjuntos de datos cuidadosamente etiquetados para aprender exactamente qué buscar y dónde se encuentran los objetos.

La detección tradicional de objetos es esencial porque proporciona tanto reconocimiento, identificando qué es el objeto, como localización, determinando exactamente dónde se encuentra en la imagen. Esta combinación permite a las máquinas realizar tareas complejas del mundo real de forma fiable, desde vehículos autónomos hasta automatización industrial y diagnósticos sanitarios.

Gracias a los avances tecnológicos, los modelos de detección de objetos siguen mejorando, volviéndose más rápidos, más precisos y más adecuados para entornos del mundo real. En este artículo, repasaremos algunos de los mejores modelos de detección de objetos disponibles en la actualidad. ¡Empecemos!

Las tareas de visión artificial, como la clasificación de imágenes, pueden utilizarse para determinar si una imagen contiene un coche, una persona u otro objeto. Sin embargo, no pueden determinar dónde se encuentra el objeto dentro de la imagen.

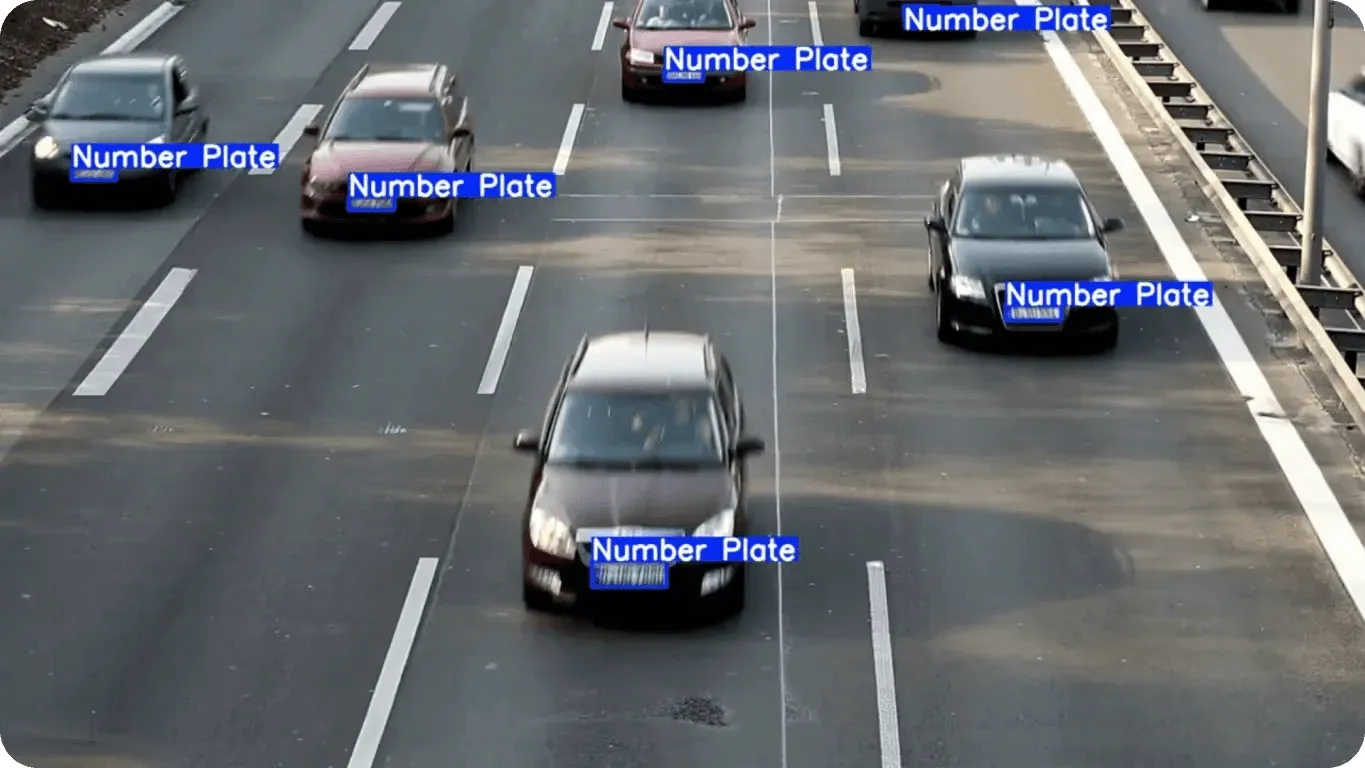

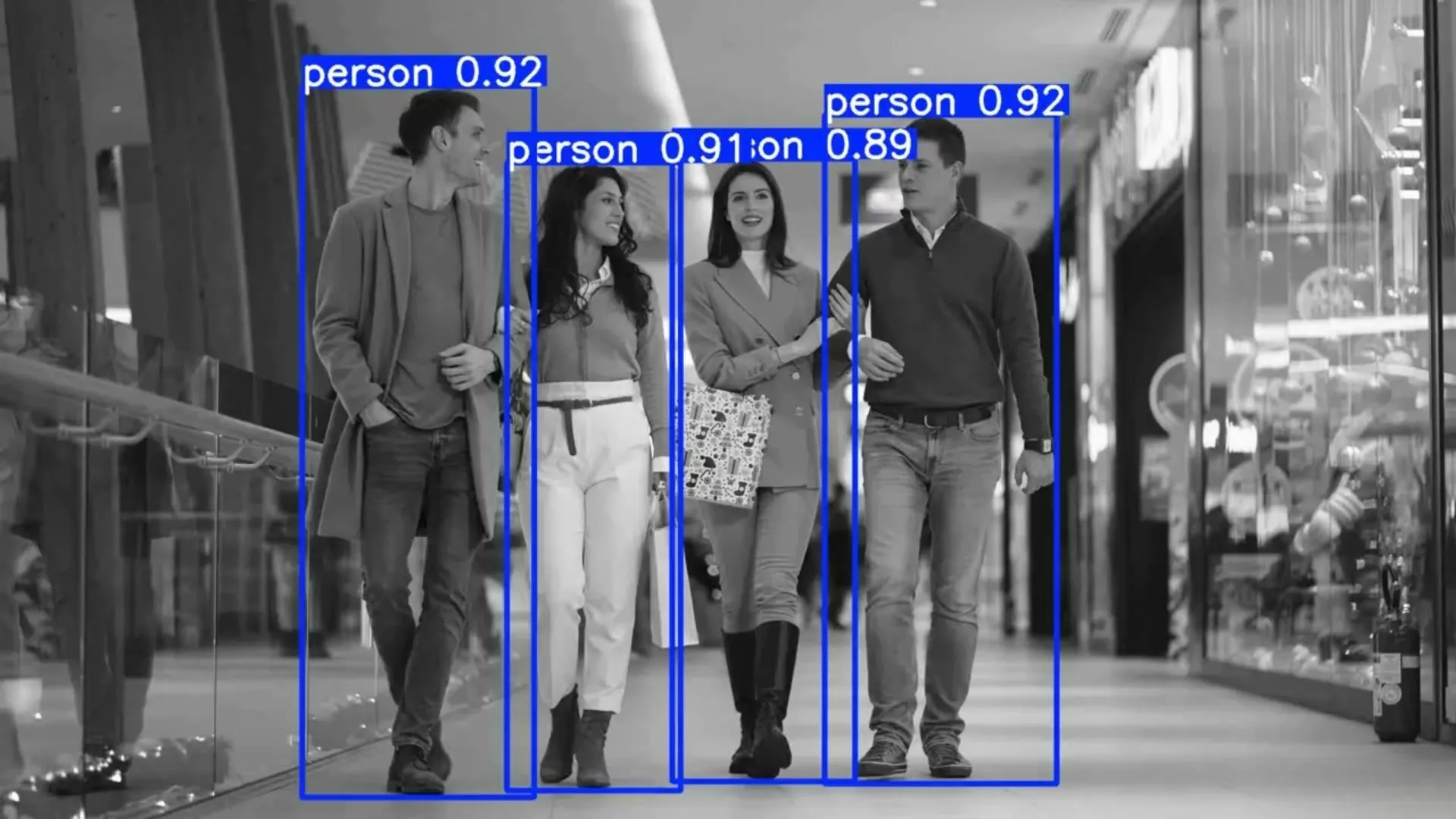

Aquí es donde la detección de objetos puede resultar muy útil. Los modelos de detección de objetos pueden identificar qué objetos están presentes y también señalar su ubicación exacta. Este proceso, conocido como localización, permite a las máquinas comprender las escenas con mayor precisión y responder de forma adecuada, ya sea deteniendo un coche autónomo, guiando el brazo de un robot o resaltando un área en una imagen médica.

El auge del aprendizaje profundo ha transformado la detección de objetos. En lugar de basarse en reglas codificadas manualmente, los modelos modernos aprenden patrones directamente a partir de anotaciones y datos visuales. Estos conjuntos de datos enseñan a los modelos cómo son los objetos, dónde suelen aparecer y cómo manejar retos como objetos pequeños, escenas abarrotadas o condiciones de iluminación variables.

De hecho, los sistemas de detección de objetos de última generación pueden detect con precisión detect objetos a la vez. Esto convierte a la detección de objetos en una tecnología fundamental en aplicaciones como la conducción autónoma, la robótica, la asistencia sanitaria y la automatización industrial.

La entrada a un modelo de detección de objetos es una imagen, que puede provenir de una cámara, un fotograma de vídeo o incluso una exploración médica. La imagen de entrada se procesa a través de una red neuronal, normalmente una red neuronal convolucional (CNN), que está entrenada para reconocer patrones en datos visuales.

Dentro de la red, la imagen se analiza por etapas. Basándose en las características que detecta, el modelo predice qué objetos están presentes y dónde aparecen.

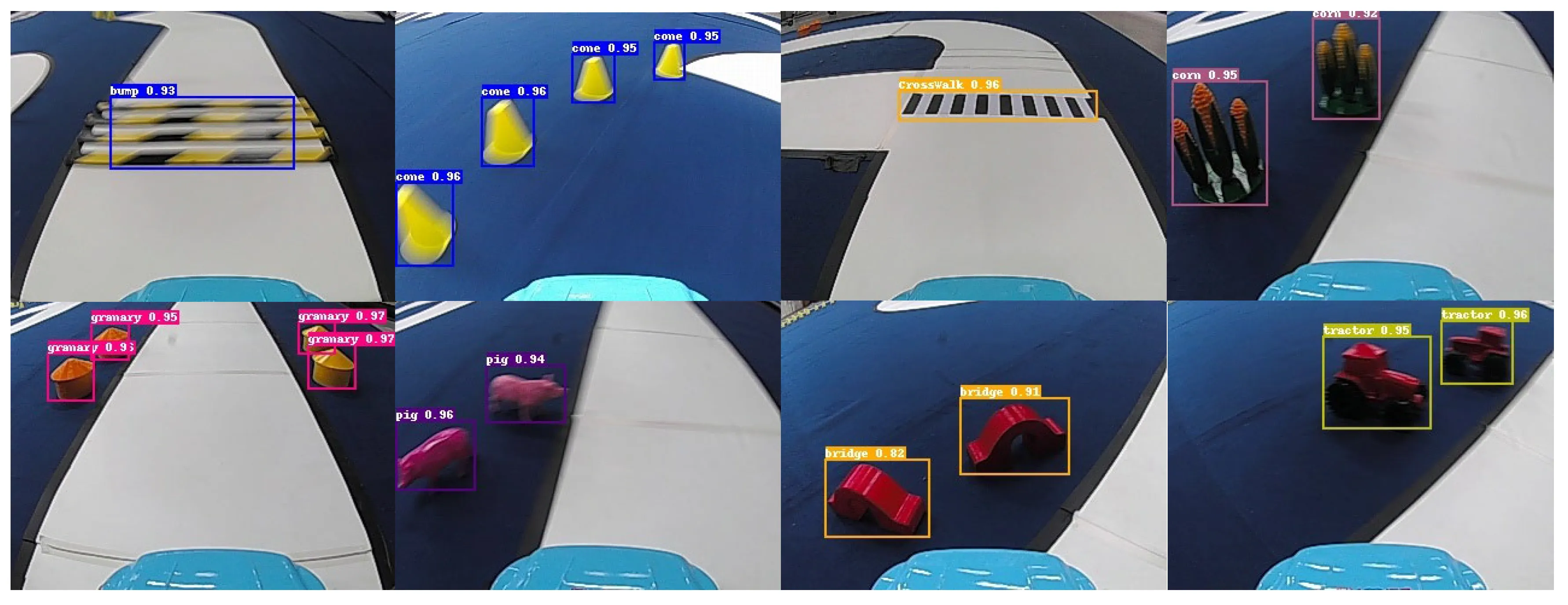

Estas predicciones se representan mediante cuadros delimitadores, que son rectángulos dibujados alrededor de cada objeto detectado. Para cada cuadro delimitador, el modelo asigna una etiqueta de clase (por ejemplo, coche, persona o perro) y una puntuación de confianza que indica el grado de certeza de la predicción (esto también puede considerarse como una probabilidad).

El proceso general se basa en gran medida en la extracción de características. El modelo aprende a identificar patrones visuales útiles, como bordes, formas, texturas y otras características distintivas. Estos patrones se codifican en mapas de características, que ayudan a la red a comprender la imagen en múltiples niveles de detalle.

Dependiendo de la arquitectura del modelo, los detectores de objetos utilizan diferentes estrategias para localizar objetos, equilibrando velocidad, precisión y complejidad.

Muchos modelos de detección de objetos, en particular los detectores de dos etapas como Faster R-CNN, se centran en partes específicas de la imagen denominadas regiones de interés (ROI). Al concentrarse en estas áreas, el modelo da prioridad a las regiones que tienen más probabilidades de contener objetos, en lugar de analizar todos los píxeles por igual.

Por otro lado, los modelos de una sola etapa, como YOLO primeros YOLO , no seleccionan regiones de interés específicas como lo hacen los modelos de dos etapas. En su lugar, dividen la imagen en una cuadrícula y utilizan cuadros predefinidos, llamados cuadros de anclaje, junto con mapas de características para predecir objetos en toda la imagen de una sola vez.

Hoy en día, los modelos de detección de objetos más avanzados están explorando enfoques sin anclajes. A diferencia de los modelos tradicionales de una sola etapa que se basan en cuadros de anclaje predefinidos, los modelos sin anclajes predicen la ubicación y el tamaño de los objetos directamente a partir de mapas de características. Esto puede simplificar la arquitectura, reducir la sobrecarga computacional y mejorar el rendimiento, especialmente para detectar objetos de diferentes formas y tamaños.

Hoy en día, existen muchos modelos de detección de objetos, cada uno diseñado con objetivos específicos en mente. Algunos están optimizados para el rendimiento en tiempo real, mientras que otros se centran en lograr la mayor precisión posible. La elección del modelo adecuado para una solución de visión artificial suele depender de su caso de uso particular y de los requisitos de rendimiento.

A continuación, exploraremos algunos de los mejores modelos de detección de objetos de 2025.

Una de las familias de modelos de detección de objetos más utilizadas en la actualidad es la familiaYOLO Ultralytics . YOLO, que significa «You Only Look Once» (solo hay que mirar una vez), es muy popular en todos los sectores porque ofrece un gran rendimiento de detección a la vez que es rápido, fiable y fácil de usar.

YOLO Ultralytics YOLO incluye Ultralytics YOLOv5, Ultralytics YOLOv8, Ultralytics YOLO11y el próximo Ultralytics , que ofrecen una amplia gama de opciones para diferentes requisitos de rendimiento y casos de uso. Gracias a su diseño ligero y a la optimización de la velocidad,YOLO Ultralytics YOLO son ideales para la detección en tiempo real y pueden implementarse en dispositivos periféricos con potencia de cálculo y memoria limitadas.

Más allá de la detección básica de objetos, estos modelos son muy versátiles. También admiten tareas como la segmentación de instancias, que perfila los objetos a nivel de píxeles, y la estimación de poses, que identifica puntos clave en personas u objetos. Esta flexibilidad convierte aYOLO Ultralytics en una opción ideal para una amplia gama de aplicaciones, desde la agricultura y la logística hasta el comercio minorista y la fabricación.

Otra razón clave para la popularidad deYOLO Ultralytics es el Python Ultralytics , que proporciona una interfaz sencilla y fácil de usar para entrenar, ajustar y desplegar modelos. Los desarrolladores pueden empezar con pesos preentrenados, personalizar los modelos para sus propios conjuntos de datos y desplegarlos con solo unas pocas líneas de código.

RT‑DETR (Real-Time Detection Transformer) y el más reciente RT‑DETRv2 son modelos de detección de objetos diseñados para su uso en tiempo real. A diferencia de muchos modelos tradicionales, pueden tomar una imagen y proporcionar las detecciones finales directamente sin utilizar la supresión no máxima (NMS).

NMS un paso que elimina las cajas superpuestas adicionales cuando un modelo predice el mismo objeto más de una vez. Saltarse NMS el proceso de detección NMS más sencillo y rápido.

Estos modelos combinan CNN con transformadores. La CNN encuentra detalles visuales como bordes y formas, mientras que el transformador es un tipo de red neuronal que puede ver la imagen completa de una sola vez y comprender cómo se relacionan entre sí las diferentes partes. Esta comprensión integral permite al modelo detect que están muy juntos o superpuestos.

RT‑DETRv2 mejora el modelo original con características como la detección multiescala, que ayuda a encontrar objetos pequeños y grandes, y un mejor manejo de escenas complejas. Estos cambios mantienen la rapidez del modelo al tiempo que mejoran su precisión.

RF‑DETR es un modelo basado en transformadores en tiempo real diseñado para combinar la precisión de las arquitecturas de transformadores con la velocidad necesaria para aplicaciones del mundo real. Al igual que RT‑DETR y RT‑DETRv2, utiliza un transformador para analizar toda la imagen y una CNN para extraer características visuales precisas, como bordes, formas y texturas.

El modelo predice objetos directamente a partir de la imagen de entrada, omitiendo los cuadros de anclaje y la supresión no máxima, lo que simplifica el proceso de detección y mantiene la rapidez de la inferencia. RF‑DETR también admite la segmentación de instancias, lo que le permite delinear objetos a nivel de píxeles, además de predecir cuadros delimitadores.

Lanzado a finales de 2019, EfficientDet es un modelo de detección de objetos diseñado para un escalado eficiente y un alto rendimiento. Lo que distingue a EfficientDet es el escalado compuesto, un método que escala simultáneamente la resolución de entrada, la profundidad de la red y la anchura de la red, en lugar de ajustar solo un factor. Este enfoque ayuda al modelo a mantener una precisión estable, tanto si se escala para tareas de alto rendimiento como si se reduce para implementaciones ligeras.

Otro componente clave de EfficientDet es su eficiente red piramidal de características (FPN), que permite al modelo analizar imágenes a múltiples escalas. Este análisis multiescala es crucial para detectar objetos de diferentes tamaños, lo que permite a EfficientDet identificar de forma fiable tanto objetos pequeños como grandes dentro de la misma imagen.

Lanzado en 2022, PP-YOLOE+ es un modelo de detección de objetos YOLO, lo que significa que detecta y clasifica objetos en una sola pasada sobre la imagen. Este enfoque lo hace rápido y adecuado para aplicaciones en tiempo real, al tiempo que mantiene una alta precisión.

Una de las mejoras clave de PP-YOLOE+ es el aprendizaje alineado con las tareas, que ayuda a que las puntuaciones de confianza del modelo reflejen la precisión con la que se localizan los objetos. Esto resulta especialmente útil para detectar objetos pequeños o superpuestos.

El modelo también utiliza una arquitectura de cabeza desacoplada, que separa las tareas de predicción de la ubicación de los objetos y las etiquetas de clase. Esto le permite dibujar cuadros delimitadores con mayor precisión, al tiempo que clasifica los objetos correctamente.

GroundingDINO es un modelo de detección de objetos basado en transformadores que combina visión y lenguaje. En lugar de basarse en un conjunto fijo de categorías, permite a los usuarios detect mediante indicaciones de texto en lenguaje natural.

Al alinear las características visuales de una imagen con descripciones de texto, el modelo puede localizar objetos incluso si esas etiquetas exactas no estaban en sus datos de entrenamiento. Esto significa que puedes indicarle al modelo descripciones como «una persona con casco» o «un coche rojo cerca de un edificio», y generará cuadros delimitadores precisos alrededor de los objetos coincidentes.

Además, al admitir la detección sin entrenamiento previo, GroundingDINO reduce la necesidad de volver a entrenar o ajustar el modelo para cada nuevo caso de uso, lo que lo hace muy flexible en una amplia gama de aplicaciones. Esta combinación de comprensión del lenguaje y reconocimiento visual abre nuevas posibilidades para los sistemas de IA interactivos y adaptativos.

Al comparar varios modelos de detección de objetos, es posible que se pregunte cómo saber cuál es el que realmente ofrece un mejor rendimiento. Es una buena pregunta, ya que, más allá de la arquitectura del modelo y la calidad de los datos, hay muchos factores que pueden afectar al rendimiento.

Los investigadores suelen basarse en puntos de referencia compartidos y métricas de rendimiento estándar para evaluar los modelos de forma coherente, comparar resultados y comprender las compensaciones entre velocidad y precisión. Los puntos de referencia estándar son especialmente importantes porque muchos modelos de detección de objetos se evalúan con los mismos conjuntos de datos, como el COCO .

A continuación, se analizan más detenidamente algunas métricas comunes utilizadas para evaluar los modelos de detección de objetos:

Estas son algunas de las principales ventajas de utilizar modelos de detección de objetos en aplicaciones del mundo real:

A pesar de estas ventajas, existen limitaciones prácticas que pueden afectar al rendimiento de los modelos de detección de objetos. A continuación se indican algunos factores importantes que hay que tener en cuenta:

El mejor modelo de detección de objetos para tu proyecto de visión artificial depende de tu caso de uso, la configuración de los datos, los requisitos de rendimiento y las limitaciones del hardware. Algunos modelos están optimizados para la velocidad, mientras que otros se centran en la precisión, y la mayoría de las aplicaciones del mundo real necesitan un equilibrio entre ambas. Gracias a los marcos de código abierto y a las comunidades activas en GitHub, estos modelos son cada vez más fáciles de evaluar, adaptar e implementar para su uso práctico.

Para obtener más información, explore nuestro repositorio GitHub. Únase a nuestra comunidad y consulte nuestras páginas de soluciones para leer sobre aplicaciones como la IA en el sector sanitario y la visión artificial en la industria automovilística. Descubra nuestras opciones de licencia para empezar a utilizar Vision AI hoy mismo.