Cómo utilizar Ultralytics YOLO11 para la detección de objetos

Descubra cómo puede utilizarse el nuevo modeloYOLO11 Ultralytics para la detección de objetos con el fin de lograr una mayor precisión en diversas aplicaciones de distintos sectores.

Descubra cómo puede utilizarse el nuevo modeloYOLO11 Ultralytics para la detección de objetos con el fin de lograr una mayor precisión en diversas aplicaciones de distintos sectores.

La visión artificial es un campo de la inteligencia artificial (IA) que ayuda a las máquinas a interpretar y comprender la información visual para permitir tareas esenciales como la detección de objetos. A diferencia de la clasificación de imágenes, la detección de objetos no solo identifica qué objetos hay en una imagen, sino que también localiza sus ubicaciones exactas. Esto la convierte en una herramienta fundamental para aplicaciones de IA visual como los coches autónomos, los sistemas de seguridad en tiempo real y la automatización de almacenes.

Con el tiempo, la tecnología de detección de objetos se ha vuelto más avanzada y fácil de usar. En el evento híbrido anual de Ultralytics , YOLO Vision 2024 (YV24), se anunció un importante paso adelante con el lanzamiento del modeloYOLO11 Ultralytics . YOLO11 mejora la precisión y el rendimiento al tiempo que admite las mismas tareas que YOLOv8facilitando a los usuarios de modelos anteriores la transición sin problemas.

En este artículo, explicaremos qué es la detección de objetos, en qué se diferencia de otras tareas de visión por ordenador y exploraremos sus aplicaciones en el mundo real. También le explicaremos cómo utilizar el modelo YOLO11 con el paquetePython Ultralytics y la plataformaUltralytics HUB. Pongámonos manos a la obra.

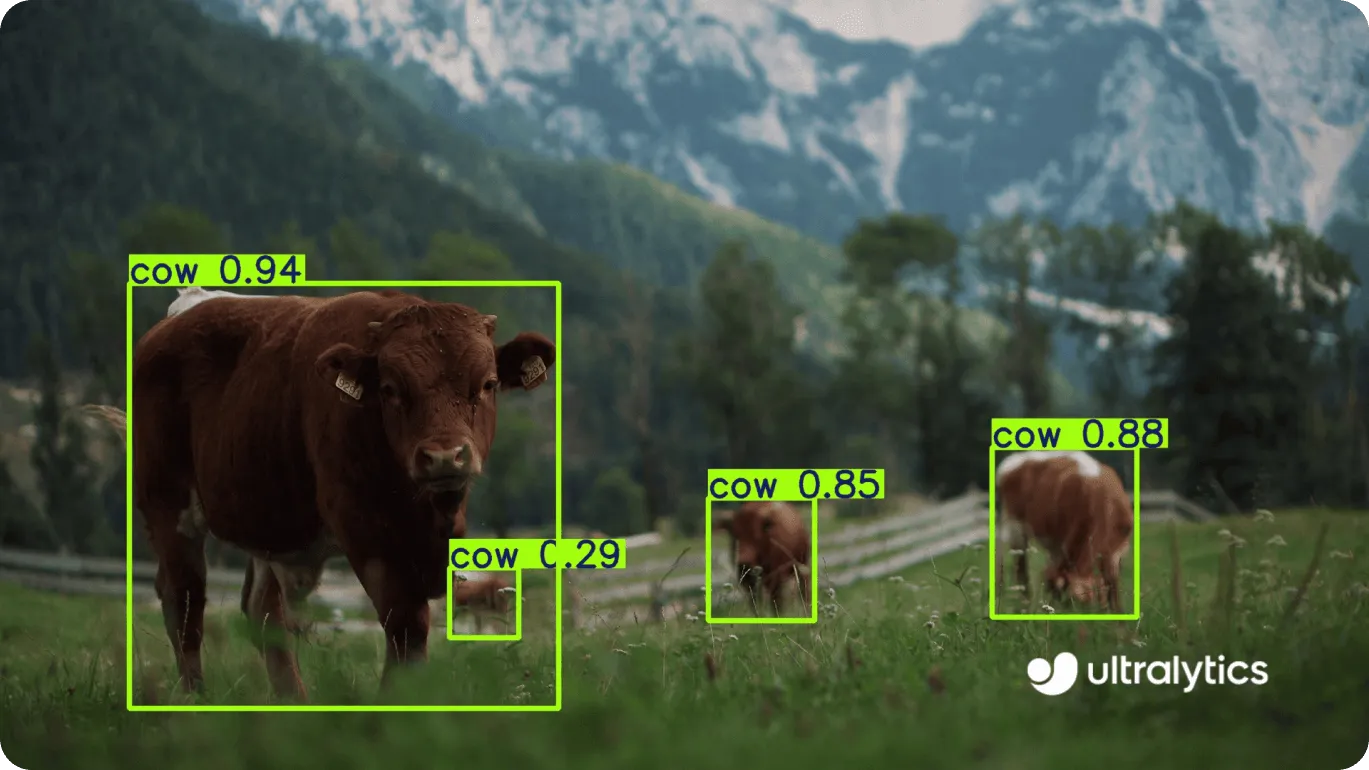

La detección de objetos es una tarea fundamental en la visión artificial que va más allá de la simple identificación de objetos en una imagen. A diferencia de la clasificación de imágenes, que solo determina si un objeto específico está presente, la detección de objetos reconoce múltiples objetos y localiza sus ubicaciones exactas mediante cuadros delimitadores.

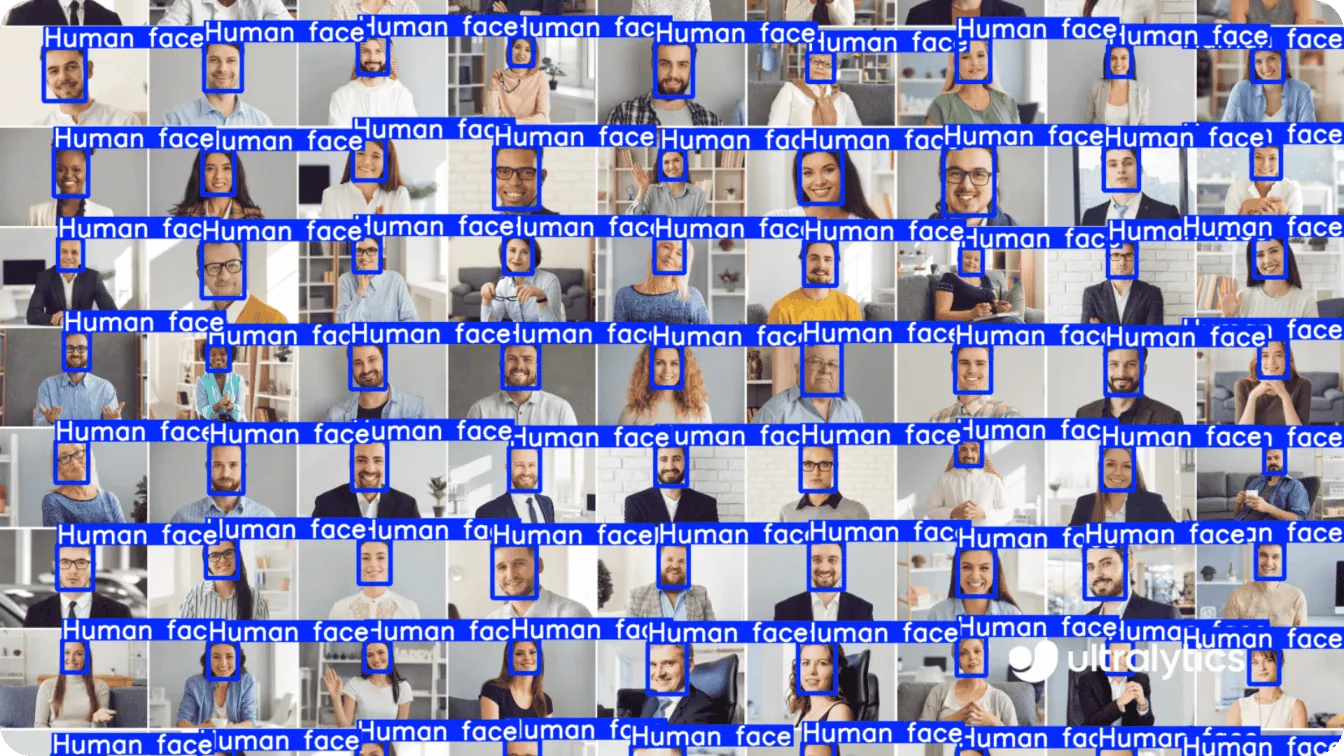

Por ejemplo, puede identificar y localizar rostros en una foto grupal, coches en una calle concurrida o productos en el estante de una tienda. La combinación del reconocimiento y la localización de objetos la hace especialmente útil para aplicaciones como la vigilancia, el monitoreo de multitudes y la gestión automatizada de inventarios.

Lo que distingue a la detección de objetos de otras tareas como la segmentación semántica o la segmentación de instancias es su enfoque y eficiencia.

La segmentación semántica etiqueta cada píxel de una imagen, pero no diferencia entre objetos individuales del mismo tipo (por ejemplo, todos los rostros en una foto se agruparían como "rostro"). La segmentación de instancias va un paso más allá al separar cada objeto y delinear su forma exacta, incluso para objetos de la misma clase.

Sin embargo, la detección de objetos proporciona un enfoque más ágil al identificar y clasificar objetos al tiempo que marca sus posiciones. Esto la hace ideal para tareas en tiempo real como la detección de rostros en imágenes de seguridad o la identificación de obstáculos para vehículos autónomos.

Las funciones avanzadas de detección de objetos de YOLO11 lo hacen útil en muchos sectores. Veamos algunos ejemplos.

YOLO11 y la detección de objetos están redefiniendo la analítica del comercio minorista al hacer más eficiente y precisa la gestión de inventarios y la supervisión de estanterías. La capacidad del modelo para detect objetos de forma rápida y fiable ayuda a los minoristas a track los niveles de existencias, organizar las estanterías y reducir los errores en los recuentos de inventario.

Por ejemplo, YOLO11 puede detect artículos concretos, como gafas de sol, en una estantería. Pero, ¿por qué querría un minorista controlar una estantería? Mantener las estanterías abastecidas y organizadas es vital para garantizar que los clientes encuentren lo que necesitan, lo que repercute directamente en las ventas. Al supervisar las estanterías en tiempo real, los minoristas pueden detectar rápidamente si los artículos se están agotando, están mal colocados o abarrotados, lo que les ayuda a mantener una exposición organizada y atractiva que mejora la experiencia de compra.

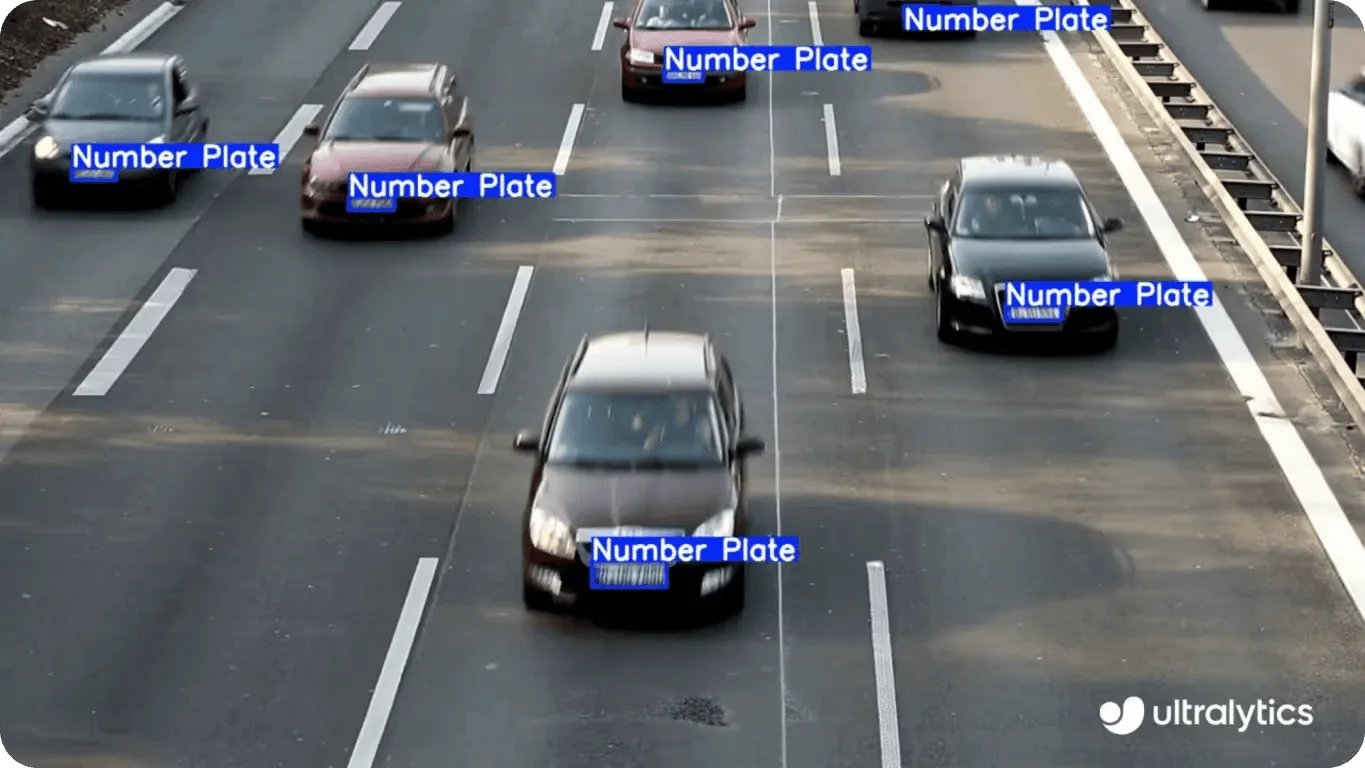

Una ciudad bulliciosa depende de un tráfico fluido y unas calles seguras para funcionar con eficacia, y YOLO11 puede ayudar a que esto sea posible. De hecho, muchas aplicaciones para ciudades inteligentes pueden integrarse con YOLO11.

Un caso interesante es el de la detección de objetos para identificar matrículas de vehículos en movimiento. De este modo, YOLO11 puede agilizar el cobro de peajes, mejorar la gestión del tráfico y agilizar el cumplimiento de las normas.

Los sistemas Vision AI que controlan las carreteras pueden alertar a las autoridades de infracciones de tráfico o atascos antes de que se conviertan en problemas mayores. YOLO11 también puede detect peatones y ciclistas, haciendo que las calles sean más seguras y eficientes para todos.

De hecho, la capacidad de YOLO11para procesar datos visuales lo convierte en una potente herramienta para mejorar las infraestructuras urbanas. Por ejemplo, puede ayudar a optimizar los tiempos de los semáforos analizando el movimiento de vehículos y peatones. También puede mejorar la seguridad en las zonas escolares detectando a los niños y alertando a los conductores para que reduzcan la velocidad. Con YOLO11, las ciudades pueden tomar medidas proactivas para afrontar los retos y crear un entorno más eficiente para todos.

La detección de objetos en tiempo real se refiere a la capacidad de un sistema para identificar y classify objetos en una secuencia de vídeo en directo a medida que aparecen. YOLO11 se ha diseñado para ofrecer un rendimiento superior en tiempo real y destaca por su capacidad para ello. Sus aplicaciones van más allá de la simple agilización de procesos: también puede ayudar a crear un mundo más inclusivo y accesible.

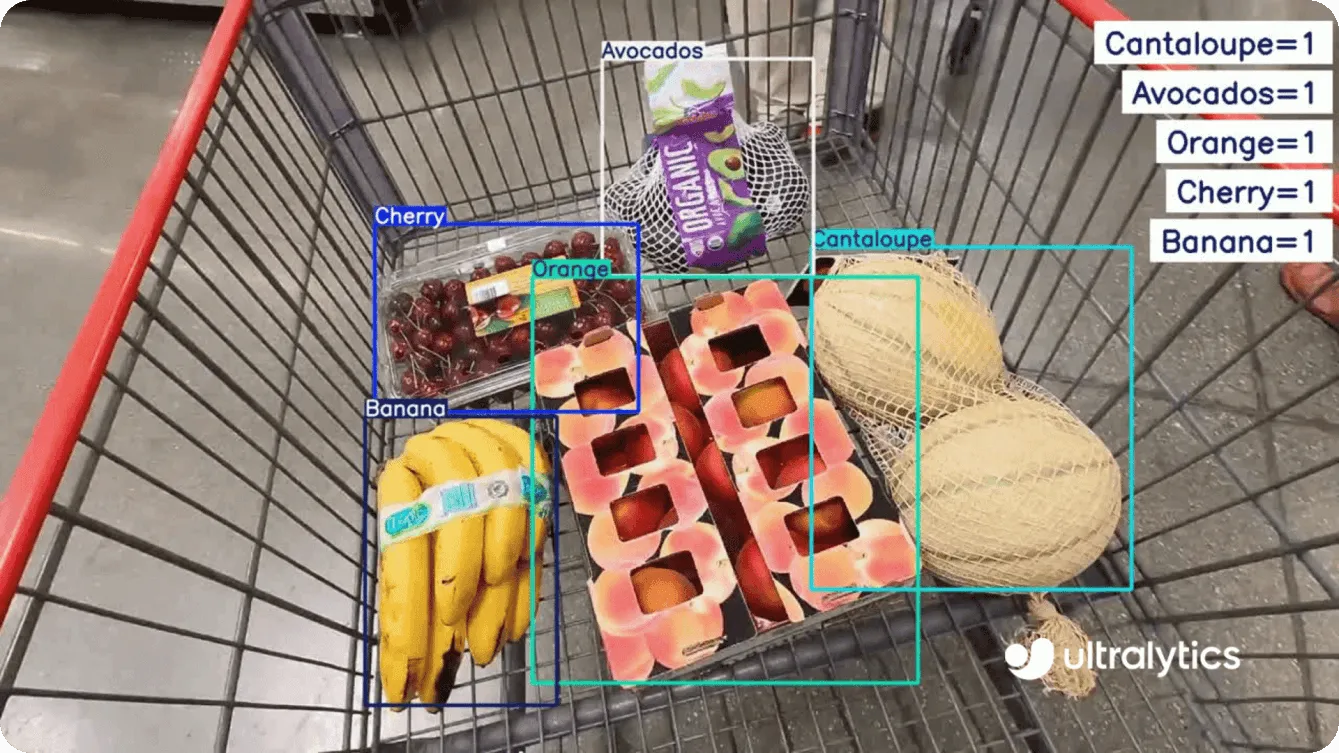

Por ejemplo, YOLO11 puede ayudar a las personas con discapacidad visual identificando objetos en tiempo real. A partir de las detecciones, se pueden proporcionar descripciones sonoras, lo que ayuda a los usuarios a navegar por su entorno con mayor independencia.

Imagínese a una persona con discapacidad visual haciendo la compra. Elegir los artículos adecuados puede ser un reto, pero YOLO11 puede ayudarle. Al colocar los artículos en el carrito, un sistema integrado con YOLO11 podría identificar cada artículo -como plátanos, aguacates o un cartón de leche- y ofrecer descripciones sonoras en tiempo real. Esto les permite confirmar sus elecciones y asegurarse de que tienen todo lo que necesitan. Al reconocer los artículos cotidianos, YOLO11 puede simplificar la compra.

Ahora que hemos cubierto los fundamentos de la detección de objetos y sus diversas aplicaciones, vamos a sumergirnos en cómo puede empezar a utilizar el modeloYOLO11 Ultralytics para tareas como la detección de objetos.

Hay dos formas sencillas de utilizar YOLO11: a través del paquetePython Ultralytics o del HUB de Ultralytics . Vamos a explorar ambos métodos, empezando por el paquete Python .

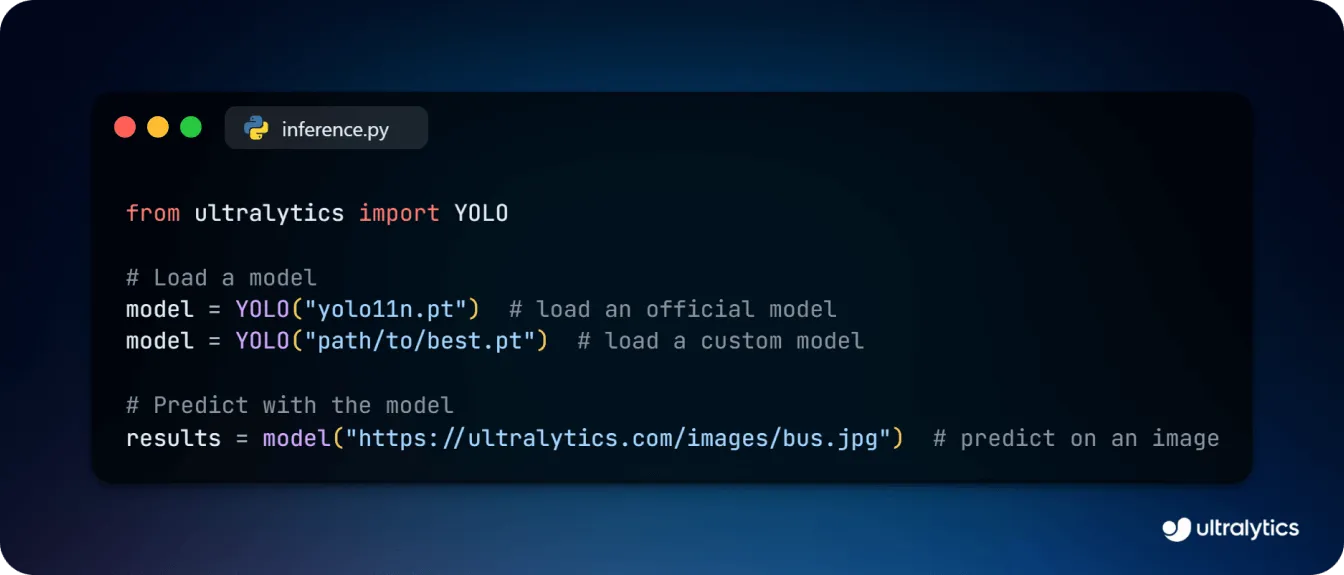

La inferencia se produce cuando un modelo de IA analiza datos nuevos y desconocidos para hacer predicciones, classify información o proporcionar información basada en lo que ha aprendido durante el entrenamiento. Con respecto a la detección de objetos, esto significa identificar y localizar objetos específicos dentro de una imagen o vídeo, dibujar cuadros delimitadores a su alrededor y etiquetarlos basándose en el entrenamiento del modelo.

Para inferir utilizando el modelo de detección de objetos YOLO11 , primero tendrá que instalar el paquete Ultralytics Python a través de pip, conda o Docker. Si se encuentra con algún problema de instalación, consulte la guía de solución de problemas para obtener consejos y trucos que le ayudarán a resolverlos. Una vez instalado, puede utilizar el siguiente código para cargar el modelo de detección de objetos YOLO11 y realizar predicciones sobre una imagen.

YOLO11 también admite la formación personalizada para adaptarse mejor a sus casos de uso específicos. Al ajustar el modelo, puede adaptarlo para detect objetos relevantes para su proyecto. Por ejemplo, cuando se utiliza la visión por ordenador en la sanidad, un modelo YOLO11 entrenado a medida podría utilizarse para detect anomalías específicas en imágenes médicas, como tumores en resonancias magnéticas o fracturas en radiografías, lo que ayudaría a los médicos a realizar diagnósticos más rápidos y precisos.

El siguiente fragmento de código muestra cómo cargar y entrenar un modelo YOLO11 para la detección de objetos. Puede partir de un archivo de configuración YAML o de un modelo preentrenado, transferir pesos y entrenar conjuntos de datos como COCO para obtener capacidades de detección de objetos más refinadas.

from ultralytics import YOLO

# Load a model

model = YOLO("yolo11n.yaml") # build a new model from YAML

model = YOLO("yolo11n.pt") # load a pretrained model (recommended for training)

model = YOLO("yolo11n.yaml").load("yolo11n.pt") # build from YAML and transfer weights

# Train the model

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)Después de entrenar un modelo, también puedes exportarlo en varios formatos para su implementación en diferentes entornos.

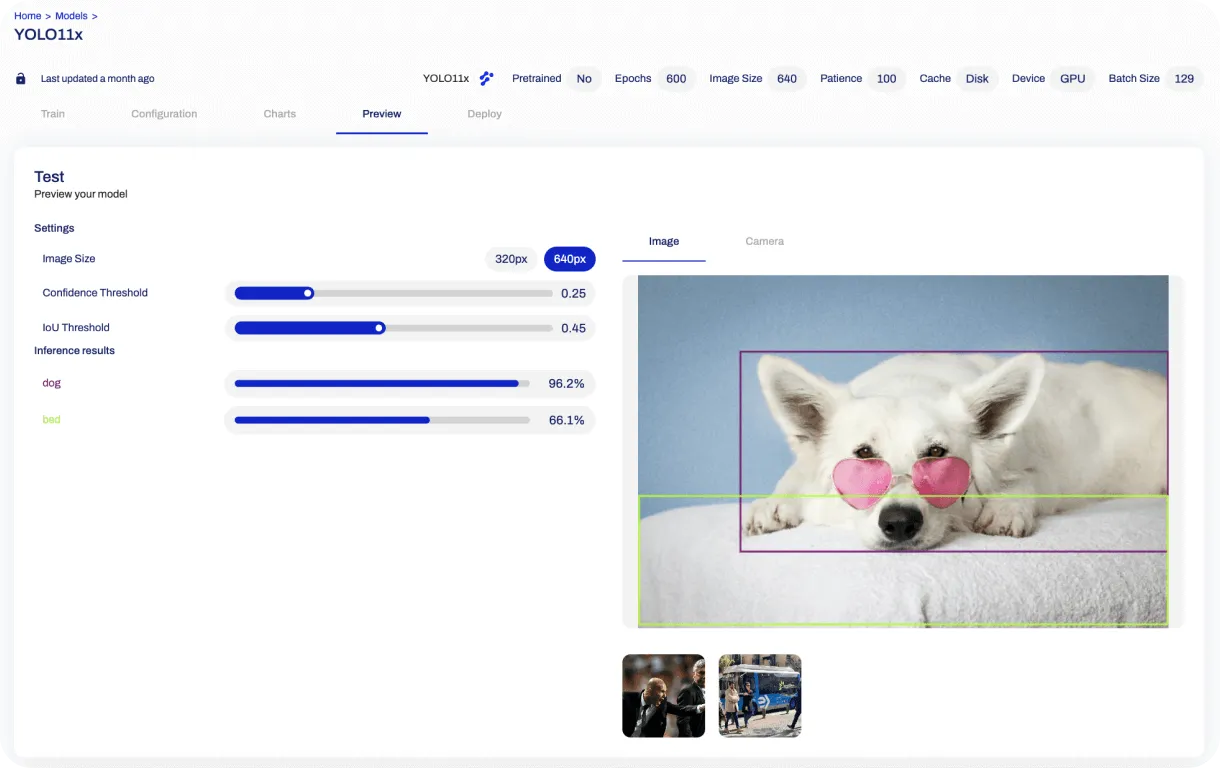

Para los que buscan una alternativa sin código, Ultralytics HUB ofrece una plataforma Vision AI fácil de usar para entrenar y desplegar modelos YOLO , incluido YOLO11.

Para ejecutar la detección de objetos en imágenes, basta con crear una cuenta, navegar hasta la sección "Modelos" y seleccionar la variante del modelo de detección de objetos YOLO11 . Sube tu imagen y la plataforma mostrará los objetos detectados en una sección de vista previa.

Al combinar la flexibilidad del paquete Python con la facilidad del HUB, YOLO11 facilita a desarrolladores y empresas por igual el aprovechamiento de la potencia de la tecnología avanzada de detección de objetos.

YOLO11 establece un nuevo estándar en la detección de objetos, combinando alta precisión con versatilidad para satisfacer las necesidades de diversas industrias. YOLO11 se ha diseñado para ofrecer un rendimiento fiable y en tiempo real en innumerables aplicaciones, desde la mejora de los análisis de comercios hasta la gestión de infraestructuras urbanas inteligentes.

Con opciones de formación personalizada y una interfaz fácil de usar a través de Ultralytics HUB, la integración de YOLO11 en sus flujos de trabajo nunca ha sido tan sencilla. Tanto si es un desarrollador que explora la visión por ordenador como una empresa que busca innovar con IA, YOLO11 le ofrece las herramientas que necesita para triunfar.

Para obtener más información, consulta nuestro repositorio de GitHub y participa en nuestra comunidad. Explora las aplicaciones de la IA en coches autónomos y la visión artificial para la agricultura en nuestras páginas de soluciones. 🚀