Ultralytics 新モデルYOLO11 、様々な産業分野の様々なアプリケーションにおいて、より高い精度を達成するための物体検出にどのように使用できるかをご覧ください。

Ultralytics 新モデルYOLO11 、様々な産業分野の様々なアプリケーションにおいて、より高い精度を達成するための物体検出にどのように使用できるかをご覧ください。

コンピュータビジョンは、機械が視覚情報を解釈および理解し、物体検出のような不可欠なタスクを可能にする人工知能(AI)の分野です。画像分類とは異なり、物体検出は画像内にどのような物体があるかを識別するだけでなく、それらの正確な位置を特定します。これにより、自動運転車、リアルタイムセキュリティシステム、倉庫の自動化などのビジョンAIアプリケーションにとって重要なツールとなります。

時が経つにつれ、物体検出技術はより進化し、より使いやすくなっている。Ultralytics年次ハイブリッドイベント、YOLO Vision 2024(YV24)で、大きな前進が発表され、Ultralytics YOLO11 モデルが発表された。YOLO11 、YOLO11 8と同じタスクをサポートしながら、精度とパフォーマンスを向上させています。 YOLOv8YOLO11は、YOLOv8と同じタスクをサポートしながら精度とパフォーマンスを向上させ、旧モデルのユーザーもシームレスに移行しやすくなっています。

この記事では、物体検出とは何か、他のコンピュータビジョンタスクとどう違うのかを説明し、実際のアプリケーションを探ります。また、YOLO11 モデルをUltralytics Python パッケージと Ultralytics HUBプラットフォームで使用する方法についても説明します。それでは始めましょう!

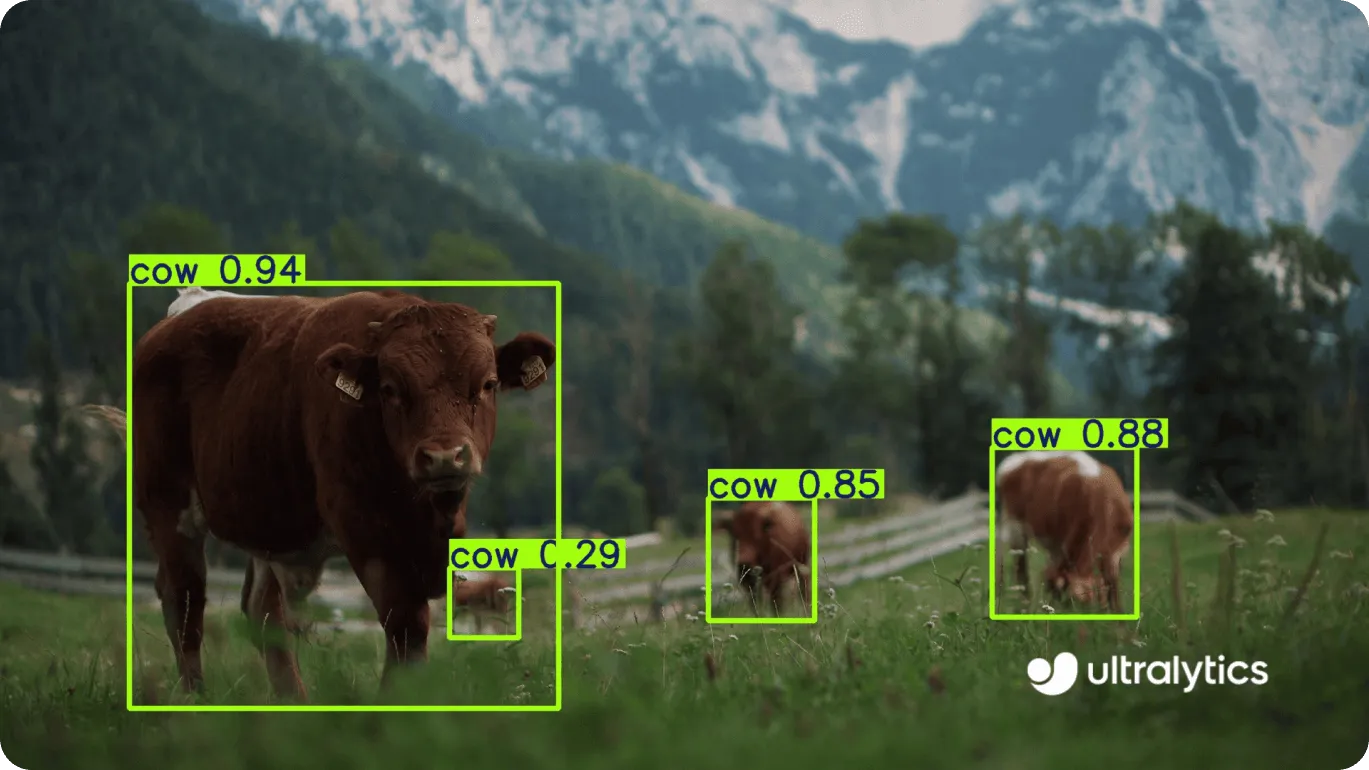

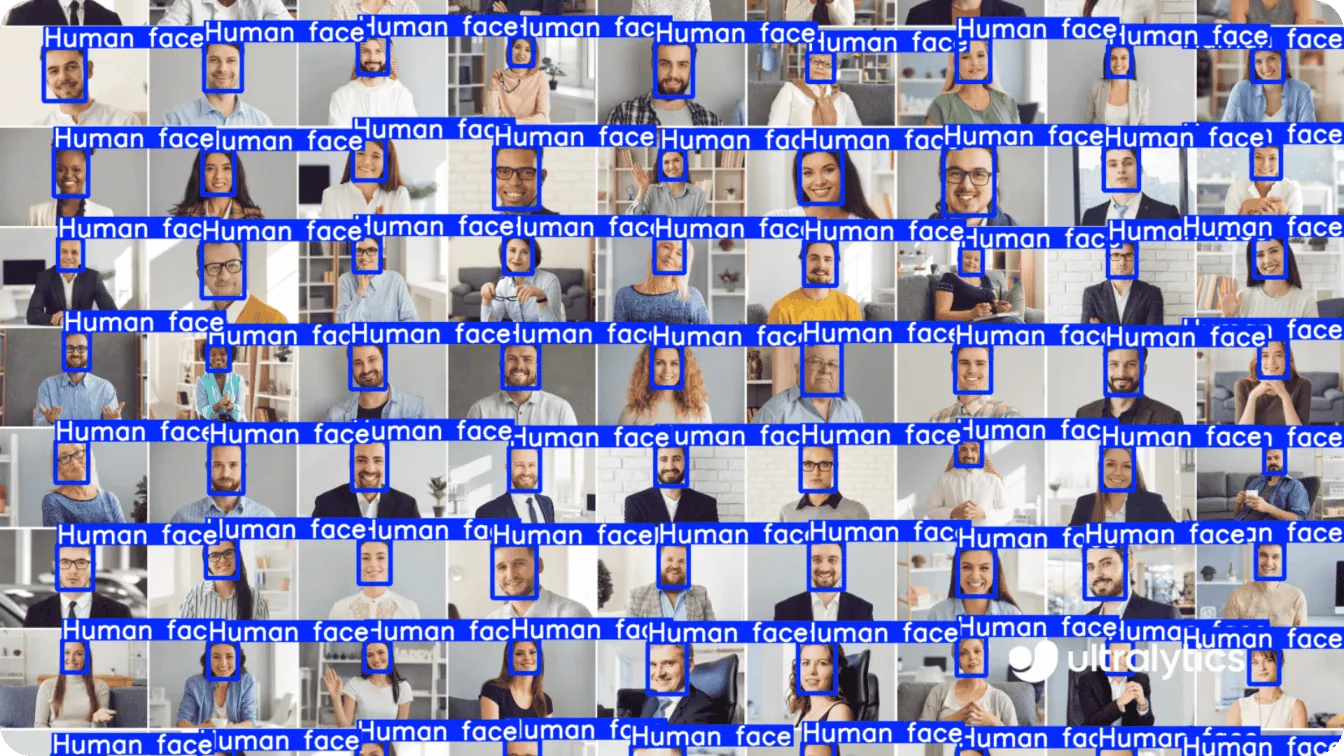

物体検出は、コンピュータビジョンの中核となるタスクであり、画像内の物体を識別する以上のことを行います。特定の物体が存在するかどうかのみを判断する画像分類とは異なり、物体検出は複数の物体を認識し、バウンディングボックスを使用してそれらの正確な位置を特定します。

たとえば、グループ写真内の顔、交通量の多い道路上の車、または店舗の棚にある製品を識別して特定できます。物体認識と位置特定の組み合わせにより、監視、群集監視、自動在庫管理などのアプリケーションに特に役立ちます。

物体検出をセマンティックセグメンテーションやインスタンスセグメンテーションのような他のタスクと区別するものは、その焦点と効率です。

セマンティックセグメンテーションは、画像内のすべてのピクセルにラベルを付けますが、同じタイプの個々の物体を区別しません(たとえば、写真内のすべての顔は「顔」としてグループ化されます)。インスタンスセグメンテーションは、各物体を分離し、同じクラスの物体であっても、その正確な形状を概説することで、さらにそれを進めます。

ただし、物体検出は、物体の位置をマークしながら、物体を識別および分類することにより、より合理化されたアプローチを提供します。これにより、セキュリティ映像内の顔の検出や、自動運転車の障害物の識別などのリアルタイムタスクに最適です。

YOLO11高度な物体検出機能は、様々な業界で役立ちます。いくつかの例を見てみよう。

YOLO11 物体検出は、在庫管理と棚の監視をより効率的かつ正確にすることで、小売分析を再定義しています。迅速かつ確実に物体をdetect するこのモデルの能力は、小売業者が在庫レベルをtrack し、棚を整理し、在庫カウントのミスを減らすのに役立ちます。

例えば YOLO11は店舗の棚にあるサングラスのような特定の商品をdetect することができる。しかし、なぜ小売業者は棚を監視したいのだろうか?顧客が必要なものを確実に見つけられるようにするためには、棚の在庫と整理整頓を保つことが不可欠であり、それは売上に直接影響する。リアルタイムで棚を監視することで、小売業者は商品が少なくなったり、置き場がなくなったり、過密状態になったりしたときにすぐに気づくことができ、買い物体験を向上させる整理された魅力的な陳列を維持するのに役立ちます。

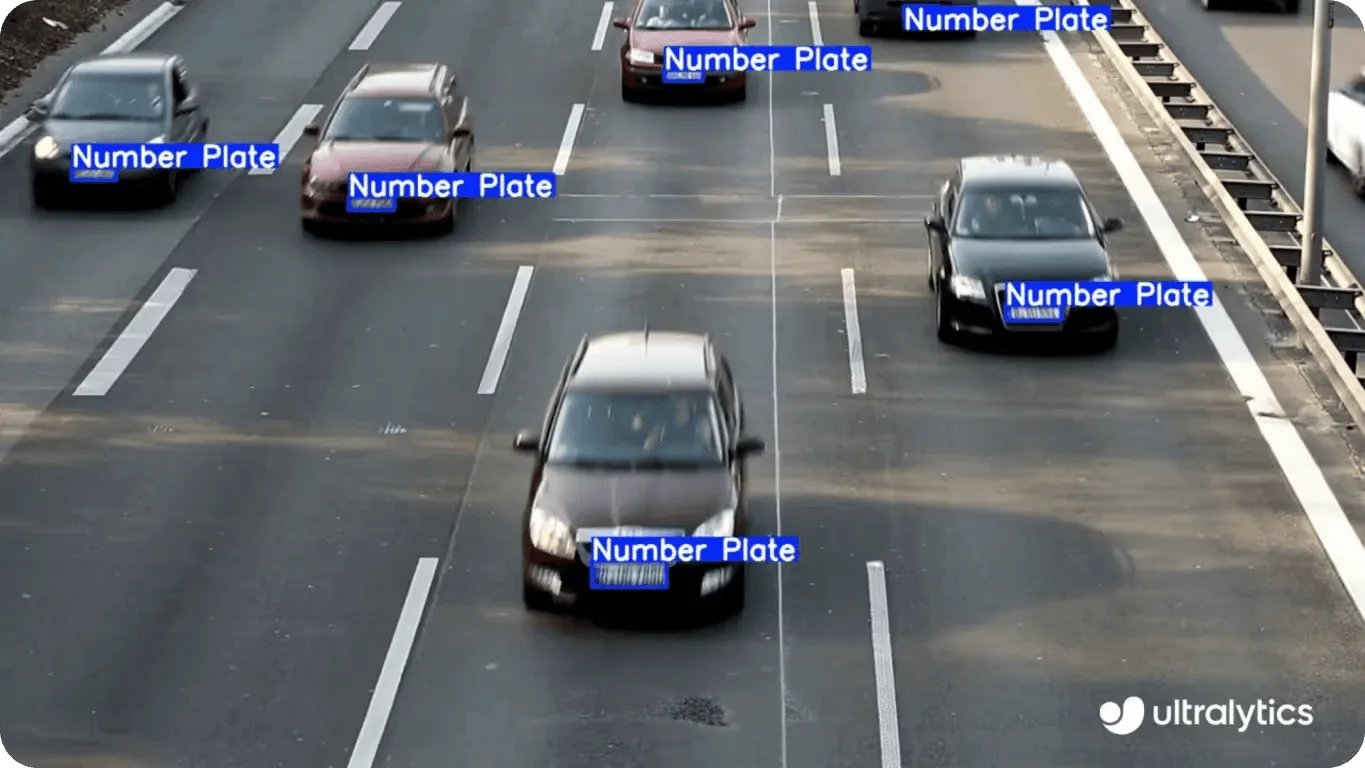

賑やかな都市が効率的に機能するためには、スムーズな交通の流れと安全な道路が不可欠YOLO11 。実際、多くのスマートシティ・アプリケーションがYOLO11統合できる。

興味深いケースのひとつは、物体検出を使用して、走行中の車両のナンバープレートを識別することだ。そうすることで、YOLO11 、より迅速な料金徴収、より良い交通管理、より迅速な規制執行をサポートすることができる。

道路を監視するビジョンAIシステムからの洞察は、交通違反や渋滞が大きな問題に発展する前に当局に警告することができる。 YOLO11は歩行者や自転車もdetect できるため、すべての人にとって道路がより安全で効率的になる。

実のところ、YOLO11ビジュアル・データ処理能力は、都市のインフラを改善するための強力なツールとなっている。例えば、車両や歩行者の動きを分析することで、信号のタイミングを最適化することができる。また、子どもを検知してドライバーに減速を促すことで、スクールゾーンの安全性を高めることもできる。YOLO11あれば、都市は課題に積極的に対処し、誰にとってもより効率的な環境を作り出すことができる。

リアルタイム物体検出とは、ライブ・ビデオ・フィード中の物体が現れたときに、それを識別・classify するシステムの能力のことです。YOLO11 、優れたリアルタイム性能のために設計されており、この機能のサポートに優れています。YOLO11のアプリケーションは、単にプロセスを合理化するだけではありません。

例えば YOLO11は、物体をリアルタイムで識別することで、視覚障害者を支援することができる。検出された物体に基づいて音声説明が提供されるため、ユーザーはより自立して周囲をナビゲートできる。

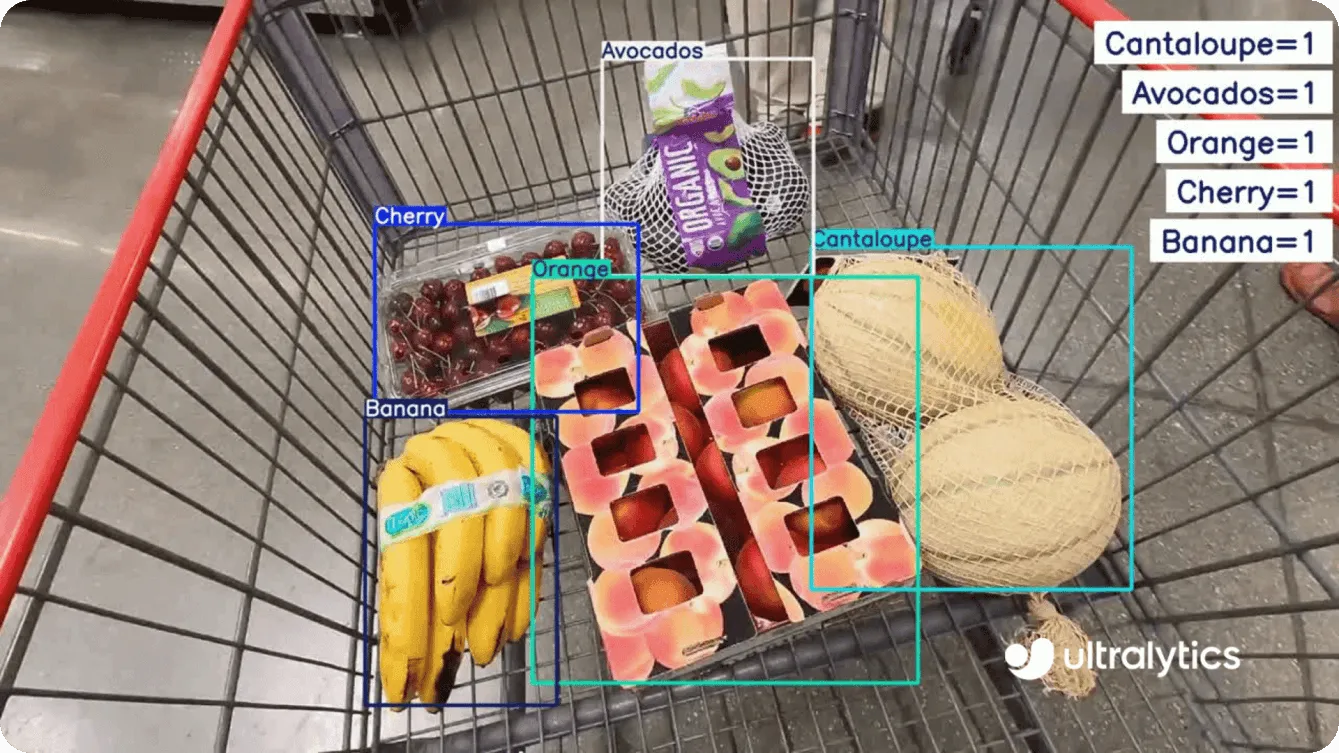

視覚障害者が食料品を買うことを考えてみよう。適切な商品を選ぶのは難しいかもしれないが、YOLO11 手助けしてくれる。商品をカートに入れる際、YOLO11 統合されたシステムを使えば、バナナ、アボカド、牛乳パックなどの各商品を識別し、リアルタイムの音声説明を提供することができる。これにより、買い物客は自分の選択を確認し、必要なものがすべて揃っていることを確認することができる。日用品を認識することで、YOLO11 11は買い物をより簡単にすることができる。

さて、物体検出の基礎とその多様なアプリケーションについて説明したところで、物体検出のようなタスクのためにUltralytics YOLO11 モデルをどのように使い始めることができるのかについて飛び込んでみよう。

YOLO11使うには、Ultralytics Python パッケージとUltralytics HUBの2つの方法がある。まずはPython パッケージから、両方の方法を試してみよう。

推論とは、AIモデルが新しい未見のデータを分析し、トレーニング中に学習した内容に基づいて予測、情報のclassify 、洞察などを行うことである。物体検出に関しては、画像やビデオ内の特定の物体を識別して位置を特定し、その周囲にバウンディングボックスを描画し、モデルのトレーニングに基づいてラベル付けすることを意味する。

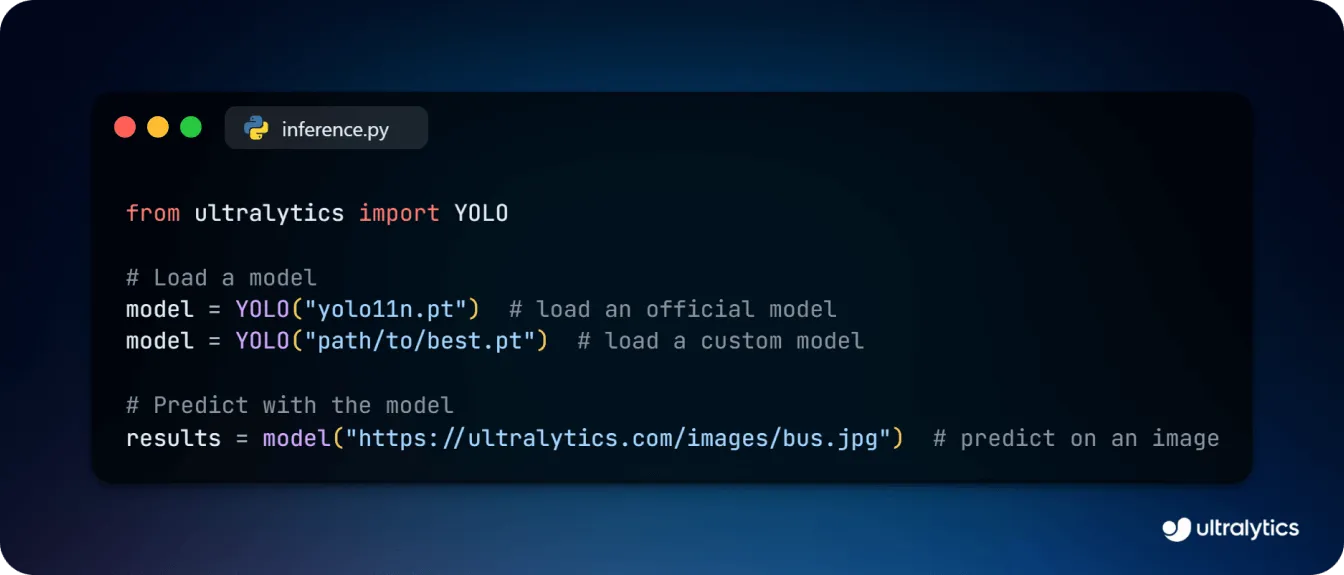

YOLO11 オブジェクト検出モデルを使用して推論するには、まず Ultralytics Python パッケージをpip、conda、またはDocker経由でインストールする必要があります。インストールで問題が発生した場合は、トラブルシューティングガイドで解決するためのヒントやコツを確認してください。インストールが完了したら、以下のコードを使用してYOLO11 オブジェクト検出モデルをロードし、画像上で予測を行うことができます。

YOLO11 また、特定のユースケースにより適合させるためのカスタムトレーニングもサポートしています。モデルを微調整することで、プロジェクトに関連するオブジェクトをdetect するように調整することができます。例えば、医療分野でコンピュータ・ビジョンを使用する場合、カスタム・トレーニングされたYOLO11 モデルを使用して、MRIスキャンの腫瘍やX線写真の骨折など、医療画像の特定の異常をdetect し、医師がより迅速で正確な診断を下せるようにすることができます。

以下のコード・スニペットは、物体検出のためのYOLO11 モデルをロードして訓練する方法を示している。YAML設定ファイルや事前に学習されたモデルから始め、重みを転送し、次のようなデータセットで学習することができます。 COCOのようなデータセットで学習することができます。

from ultralytics import YOLO

# Load a model

model = YOLO("yolo11n.yaml") # build a new model from YAML

model = YOLO("yolo11n.pt") # load a pretrained model (recommended for training)

model = YOLO("yolo11n.yaml").load("yolo11n.pt") # build from YAML and transfer weights

# Train the model

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)モデルをトレーニングした後、トレーニング済みモデルをさまざまな形式でエクスポートして、異なる環境にデプロイすることも可能です。

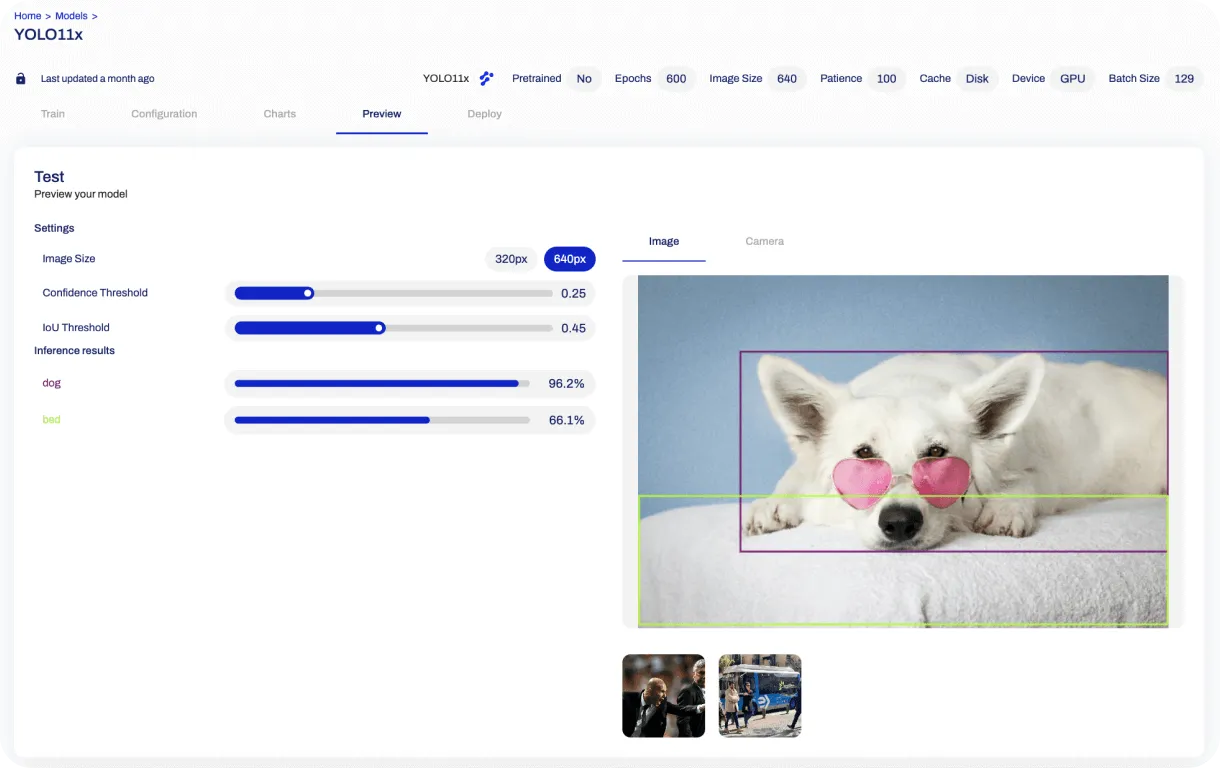

コードを使わない代替手段をお探しの方には、Ultralytics HUBが、YOLO11含むYOLO モデルのトレーニングとデプロイのための使いやすいVision AIプラットフォームを提供します。

画像上でオブジェクト検出を実行するには、アカウントを作成し、「モデル」セクションに移動し、YOLO11 オブジェクト検出モデルバリアントを選択するだけです。画像をアップロードすると、検出されたオブジェクトがプレビューセクションに表示されます。

Python パッケージの柔軟性とHUBの使いやすさを組み合わせることで、YOLO11 11は、開発者にも企業にも、高度な物体検出技術の力を活用することを簡単にします。

YOLO11 、高精度と多様性を兼ね備え、様々な業界のニーズに応える物体検出の新たな基準を打ち立てます。YOLO11 、リテール分析の強化からスマートシティのインフラ管理まで、数え切れないほどのアプリケーションにおいて、リアルタイムで信頼性の高いパフォーマンスを発揮するよう構築されています。

カスタムトレーニングのオプションや、Ultralytics HUBを通じた使いやすいインターフェイスにより、YOLO11 ワークフローに統合することがかつてないほどシンプルになりました。コンピュータビジョンを探求する開発者であれ、AIでイノベーションを起こそうとする企業であれ、YOLO11 11は成功に必要なツールを提供します。

詳細については、GitHubリポジトリをご覧になり、コミュニティにご参加ください。ソリューションページで、自動運転車や農業向けコンピュータビジョンにおけるAIアプリケーションをご覧ください。🚀

.webp)

.webp)