Comprenda la precisión mediamAP) en la detección de objetos. Aprenda su significado, cálculo y por qué mAP es clave para evaluar el rendimiento del modelo.

Comprenda la precisión mediamAP) en la detección de objetos. Aprenda su significado, cálculo y por qué mAP es clave para evaluar el rendimiento del modelo.

La adopción de la IA está creciendo rápidamente y se está integrando en diversas innovaciones, desde coches autónomos hasta sistemas minoristas que pueden identificar productos en un estante. Estas tecnologías se basan en la visión artificial, una rama de la inteligencia artificial (IA) que permite a las máquinas analizar datos visuales.

Una métrica de evaluación clave utilizada para medir la precisión de los sistemas y algoritmos de visión por ordenador es la precisión mediamAP). La métrica mAP indica hasta qué punto la predicción de un modelo de IA de visión se ajusta a los resultados del mundo real.

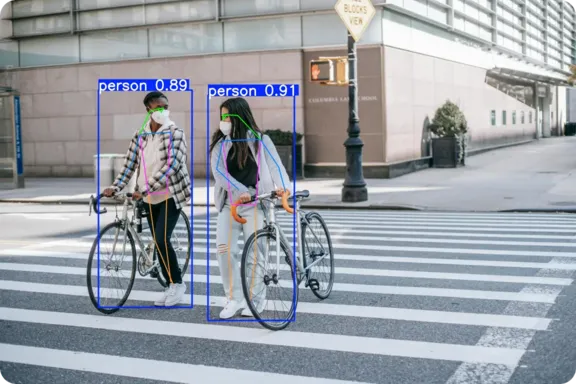

Una tarea común de visión por ordenador es la detección de objetos, en la que un modelo identifica múltiples objetos en una imagen y dibuja cuadros delimitadores a su alrededor. mAP es la métrica estándar utilizada para evaluar el rendimiento de los modelos de detección de objetos y se utiliza ampliamente para evaluar modelos de aprendizaje profundo como Ultralytics YOLO11.

En este artículo, veremos cómo se calcula la precisión media promedio (mAP) y por qué es esencial para cualquiera que entrene o evalúe modelos de detección de objetos. ¡Empecemos!

La precisión media promedio es una puntuación que muestra la exactitud de un modelo de aprendizaje profundo cuando se trata de tareas relacionadas con la recuperación de información visual, como la detección e identificación de diferentes objetos en una imagen. Por ejemplo, considere un modelo de detección de objetos que analiza una foto que contiene un perro, un gato y un coche. Un modelo fiable puede realizar la detección de objetos reconociendo cada objeto y dibujando cuadros delimitadores y etiquetas a su alrededor, destacando dónde está y qué es.

mAP indica lo bien que el modelo realiza esta tarea a través de muchas imágenes y diferentes tipos de objetos. Comprueba si el modelo identifica con precisión cada objeto y su ubicación en la imagen. La puntuación oscila entre 0 y 1, donde uno significa que el modelo encontró todo perfectamente y cero que no detect ningún objeto.

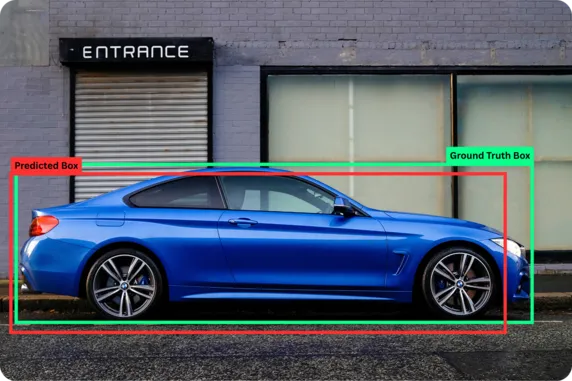

Antes de explorar los conceptos detrás de la precisión media promedio en el aprendizaje automático, comprendamos mejor dos términos básicos: ground truth y predicciones.

La verdad fundamental (ground truth) se refiere a los datos de referencia precisos, donde los objetos y sus ubicaciones en la imagen son etiquetados cuidadosamente por humanos a través de un proceso conocido como anotación. Mientras tanto, las predicciones son los resultados que los modelos de IA dan después de analizar una imagen. Al comparar las predicciones del modelo de IA con la verdad fundamental, podemos medir qué tan cerca estuvo el modelo de obtener los resultados correctos.

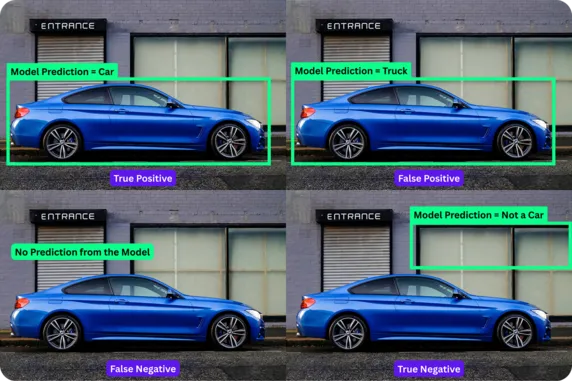

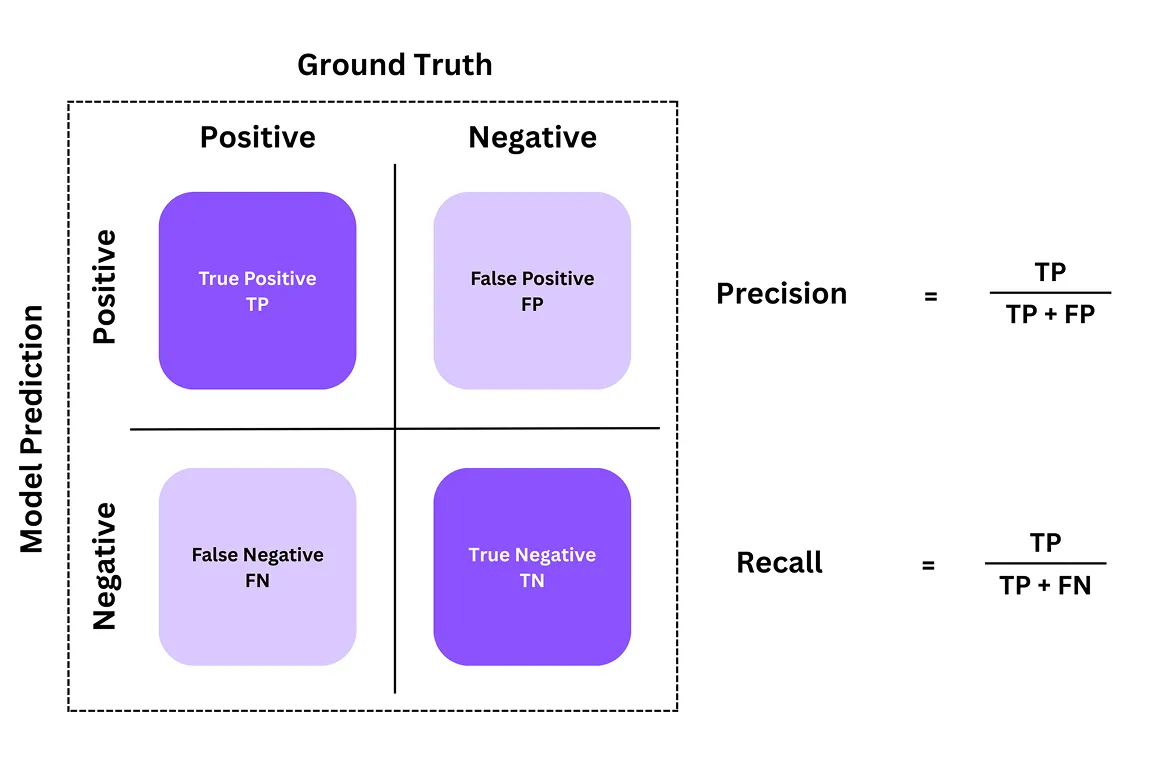

A menudo se utiliza una matriz de confusión para comprender la precisión de un modelo de detección de objetos. Es una tabla que muestra cómo las predicciones del modelo coinciden con las respuestas correctas reales (ground truth). A partir de esta tabla, podemos obtener un desglose de cuatro componentes o resultados clave: verdaderos positivos, falsos positivos, falsos negativos y verdaderos negativos.

Esto es lo que representan estos componentes en la matriz de confusión:

Los verdaderos negativos no se suelen utilizar en la detección de objetos, ya que normalmente ignoramos las muchas regiones vacías de una imagen. Sin embargo, es esencial en otras tareas de visión por ordenador, como la clasificación de imágenes, en las que el modelo asigna una etiqueta a la imagen. Por ejemplo, si la tarea consiste en detect si una imagen contiene un gato o no, y el modelo identifica correctamente "no hay gato" cuando la imagen no lo contiene, se trata de un verdadero negativo.

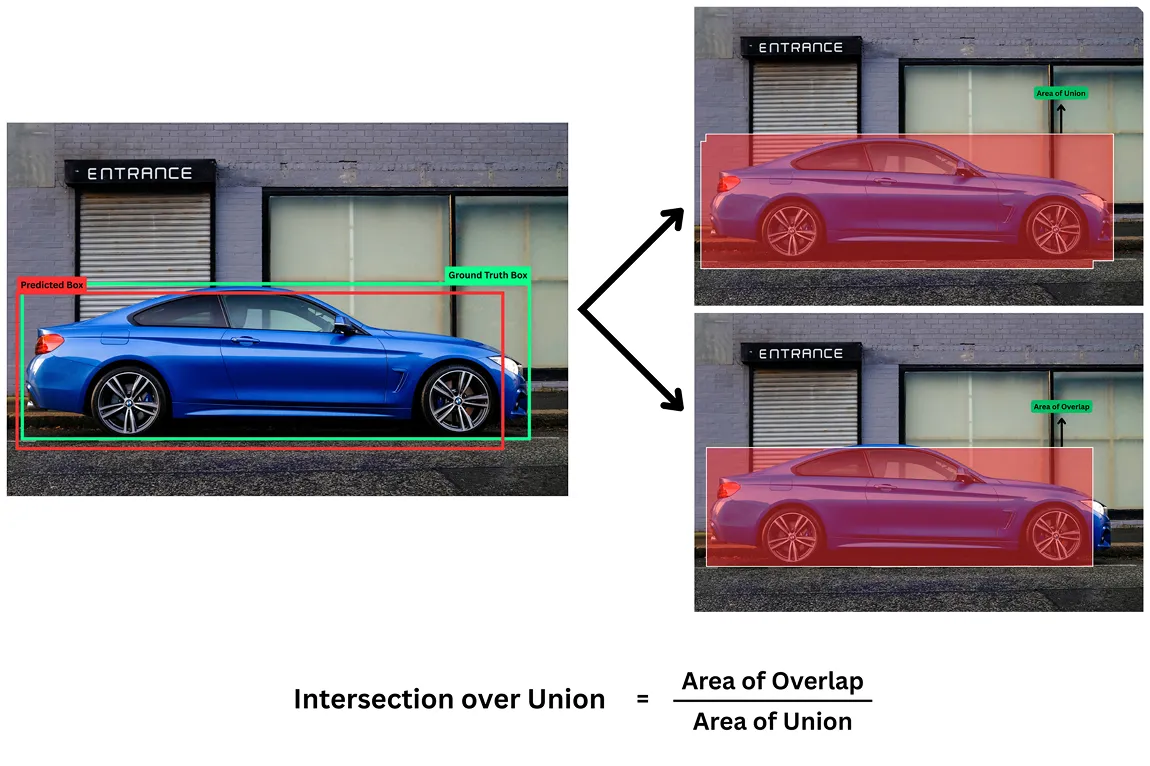

Otra métrica vital para evaluar los modelos de detección de objetos es la Intersección sobre UniónIoU). Para estos modelos de IA de visión, no basta con detectar la presencia de un objeto en una imagen; también es necesario localizar dónde se encuentra en una imagen para dibujar cuadros delimitadores.

La métrica IoU mide el grado de coincidencia entre la caja predicha por el modelo y la caja real correcta (verdad sobre el terreno). La puntuación oscila entre 0 y 1, donde 1 significa una coincidencia perfecta y 0 ninguna coincidencia.

Por ejemplo, un IoU más alto (como 0,80 o 0,85) significa que el recuadro predicho coincide con el recuadro real, lo que indica una localización precisa. Un IoU más bajo (como 0,30 o 0,25) significa que el modelo no ha localizado el objeto con precisión.

Para determinar si una detección es correcta, utilizamos distintos umbrales. Un umbral común IoU es 0,5, lo que significa que un recuadro predicho debe solaparse con el recuadro real en al menos un 50% para que se considere un verdadero positivo. Cualquier solapamiento por debajo de este umbral se considera un falso positivo.

Hasta ahora, hemos explorado algunas métricas de evaluación básicas para comprender el rendimiento de los modelos de detección de objetos. A partir de esto, dos de las métricas más importantes son la precisión y la exhaustividad. Nos dan una idea clara de la precisión de las detecciones del modelo. Echemos un vistazo a lo que son.

Los valores de precisión nos indican cuántas de las predicciones del modelo eran realmente correctas. Responde a la pregunta: de todos los objetos que el modelo pretendía detect, ¿cuántos estaban realmente ahí?

Por otro lado, los valores de recuperación miden lo bien que el modelo encuentra todos los objetos reales presentes en la imagen. Responde a la pregunta: de todos los objetos reales presentes, ¿cuántos detect correctamente el modelo?

En conjunto, la precisión y la exhaustividad nos ofrecen una visión más clara del rendimiento de un modelo. Por ejemplo, si un modelo predice 10 coches en una imagen y 9 de ellos son realmente coches, tiene una precisión del 90% (una predicción positiva).

Estas dos métricas de evaluación a menudo implican un compromiso: un modelo puede alcanzar un valor de precisión alto haciendo solo predicciones en las que confía plenamente, pero esto puede hacer que pierda muchos objetos, lo que reduce el nivel de recall. Mientras tanto, también puede alcanzar un recall muy alto prediciendo un bounding box en casi todas partes, pero esto reduciría la precisión.

Mientras que la precisión y la recuperación nos ayudan a comprender el rendimiento de un modelo en predicciones individuales, la precisión mediaAP) puede proporcionar una visión más amplia. Ilustra cómo cambia la precisión del modelo a medida que intenta detect más objetos y resume su rendimiento en una sola cifra.

Para calcular la puntuación de precisión media, primero podemos crear una métrica combinada similar a un gráfico llamada curva de precisión-recuperación (o curva PR) para cada tipo de objeto. Esta curva muestra lo que sucede a medida que el modelo realiza más predicciones.

Consideremos un escenario en el que el modelo empieza detectando sólo los objetos más fáciles o más obvios. En esta fase, la precisión es alta porque la mayoría de las predicciones son correctas, pero la recuperación es baja porque se siguen pasando por alto muchos objetos. A medida que el modelo intenta detect más objetos, incluidos los más difíciles o raros, suele introducir más errores. Esto hace que disminuya la precisión y aumente la recuperación.

La precisión media es el área bajo la curva (AUC de la curva PR). Un área mayor significa que el modelo es mejor a la hora de mantener la precisión de sus predicciones, incluso cuando detecta más objetos. AP se calcula por separado para cada etiqueta de clase.

Por ejemplo, en un modelo que puede detect coches, bicicletas y peatones, podemos calcular los valores AP individualmente para cada una de esas tres categorías. Esto nos ayuda a ver qué objetos detecta bien el modelo y en qué aspectos aún podría necesitar mejoras.

Tras calcular la precisión media de cada clase de objetos, necesitamos una única puntuación que refleje el rendimiento global del modelo en todas las clases. Para ello se utiliza la fórmula de precisión media . Esta fórmula calcula la media de las puntuaciones AP de cada categoría.

Por ejemplo, supongamos que un modelo de visión por ordenador como YOLO11 consigue un AP de 0,827 para los coches, 0,679 para las motos, 0,355 para los camiones, 0,863 para los autobuses y 0,982 para las bicicletas. Utilizando la fórmula mAP , podemos sumar estas cifras y dividirlas por el número total de clases de la siguiente manera:

mAP = (0,827 + 0,679 + 0,355 + 0,863 + 0,982) ÷ 5 = 0,7432 ≈ 0,743

La puntuación mAP de 0,743 ofrece una solución sencilla para juzgar el rendimiento del modelo en todas las clases de objetos. Un valor cercano a 1 significa que el modelo es preciso para la mayoría de las categorías, mientras que un valor inferior sugiere que tiene dificultades con algunas.

Ahora que comprendemos mejor cómo se calculan el AP y el mAP y cuáles son sus componentes, a continuación se ofrece una visión general de su importancia en la visión por ordenador:

A continuación, vamos a explorar cómo métricas clave como mAP pueden ayudar a la hora de construir casos de uso de visión por ordenador en el mundo real.

Cuando se trata de coches autónomos, la detección de objetos es crucial para identificar peatones, señales de tráfico, ciclistas y marcas viales. Por ejemplo, si de repente un niño cruza la calle corriendo, el coche tiene segundos para detect el objeto (el niño), localizar dónde está, track su movimiento y tomar las medidas necesarias (frenar).

Modelos como YOLO11 están diseñados para la detección de objetos en tiempo real en estos escenarios de alto riesgo. En estos casos, mAP se convierte en una medida crítica de seguridad.

Una puntuación mAP alta garantiza que el sistema detecta al niño rápidamente, lo localiza con precisión y activa el frenado con un retraso mínimo. Un mAP bajo puede significar que no se detecta o que se producen errores de clasificación peligrosos, como confundir al niño con otro objeto pequeño.

De forma similar, en el comercio minorista, los modelos de detección de objetos pueden utilizarse para automatizar tareas como la supervisión del stock y los procesos de pago. Cuando un cliente escanea un producto en un autopago, un error en la detección puede causar frustración.

Una puntuación mAP alta garantiza que el modelo distingue con precisión entre productos similares y dibuja recuadros delimitadores precisos, incluso cuando los artículos están muy empaquetados. Una puntuación mAP baja puede dar lugar a confusiones. Por ejemplo, si el modelo confunde una botella de zumo de naranja con una botella de zumo de manzana visualmente similar, podría dar lugar a una facturación incorrecta y a informes de inventario inexactos.

Los sistemas minoristas integrados con modelos como YOLO11 pueden detect productos en tiempo real, cotejarlos con el inventario y actualizar los sistemas backend al instante. En los comercios minoristas, donde el ritmo es frenético, mAP desempeña un papel crucial para que las operaciones sean precisas y fiables.

La mejora de la precisión diagnóstica en la atención sanitaria empieza por una detección precisa en las imágenes médicas. Modelos como YOLO11 pueden ayudar a los radiólogos a detectar tumores, fracturas u otras anomalías en esas exploraciones médicas. En este caso, la precisión media es una métrica esencial para evaluar la fiabilidad clínica de un modelo.

Un mAP alto indica que el modelo consigue tanto una alta recuperación (identificar los problemas más reales) como una alta precisión (evitar falsas alarmas), lo que es crucial en la toma de decisiones clínicas. Además, el umbral IoU en sanidad suele fijarse muy alto (0,85 o 0,90) para garantizar una detección extremadamente precisa.

Sin embargo, una puntuación mAP baja puede plantear problemas. Supongamos que un modelo no detecta un tumor; podría retrasar el diagnóstico o conducir a un tratamiento incorrecto.

Estas son las principales ventajas de utilizar la precisión media promedio para evaluar los modelos de detección de objetos:

Aunque el uso de la métrica mAP tiene varias ventajas, hay que tener en cuenta algunas limitaciones. He aquí algunos factores a tener en cuenta:

Hemos visto que la precisión media no es sólo una puntuación técnica, sino un reflejo del rendimiento potencial de un modelo en el mundo real. Ya sea en un sistema de vehículo autónomo o en una caja de un comercio, una puntuación mAP alta sirve como indicador fiable del rendimiento y la preparación práctica de un modelo.

Aunque la mAP es una métrica esencial y de gran impacto, debe considerarse parte de una estrategia de evaluación completa. Para aplicaciones críticas como la asistencia sanitaria y la conducción autónoma, no basta con basarse únicamente en la mAP.

También se deben considerar factores adicionales como la velocidad de inferencia (la rapidez con la que el modelo realiza predicciones), el tamaño del modelo (que afecta la implementación en dispositivos periféricos) y el análisis cualitativo de errores (la comprensión de los tipos de errores que comete el modelo) para garantizar que el sistema sea seguro, eficiente y realmente adecuado para el propósito previsto.

Únase a nuestra creciente comunidad y al repositorio de GitHub para obtener más información sobre la visión artificial. Explore nuestras páginas de soluciones para conocer las aplicaciones de la visión artificial en la agricultura y la IA en la logística. ¡Consulte nuestras opciones de licencia para comenzar hoy mismo con su propio modelo de visión artificial!