Descubra cómo se puede utilizar Mask R-CNN para segment con precisión objetos en imágenes y vídeos para diversas aplicaciones en distintos sectores.

Descubra cómo se puede utilizar Mask R-CNN para segment con precisión objetos en imágenes y vídeos para diversas aplicaciones en distintos sectores.

Innovaciones como robots en almacenes, coches autónomos que se mueven con seguridad por calles concurridas, drones que revisan los cultivos y sistemas de IA que inspeccionan productos en fábricas son cada vez más comunes a medida que aumenta la adopción de la IA. Una tecnología clave que impulsa estas innovaciones es la visión artificial, una rama de la IA que permite a las máquinas comprender e interpretar datos visuales.

Por ejemplo, la detección de objetos es una tarea de visión artificial que ayuda a identificar y localizar objetos en imágenes mediante el uso de cuadros delimitadores. Si bien los cuadros delimitadores ofrecen información útil, solo proporcionan una estimación aproximada de la posición de un objeto y no pueden capturar su forma o límites exactos. Esto los hace menos efectivos en aplicaciones que requieren una identificación precisa.

Para solucionar este problema, los investigadores desarrollaron modelos de segmentación que capturan los contornos exactos de los objetos, proporcionando detalles a nivel de píxel para una detección y un análisis más precisos.

Mask R-CNN es uno de estos modelos. Introducido en 2017 por Facebook AI Research (FAIR), se basa en modelos anteriores como R-CNN, Fast R-CNN y Faster R-CNN. Como hito importante en la historia de la visión por ordenador, Mask R-CNN ha allanado el camino para modelos más avanzados, como Ultralytics YOLO11.

En este artículo, exploraremos qué es Mask R-CNN, cómo funciona, sus aplicaciones y qué mejoras vinieron después, hasta llegar a YOLO11.

Mask R-CNN, que significa Mask Region-based Convolutional Neural Network (Red Neuronal Convolucional basada en Regiones con Máscara), es un modelo de aprendizaje profundo diseñado para tareas de visión artificial como la detección de objetos y la segmentación de instancias.

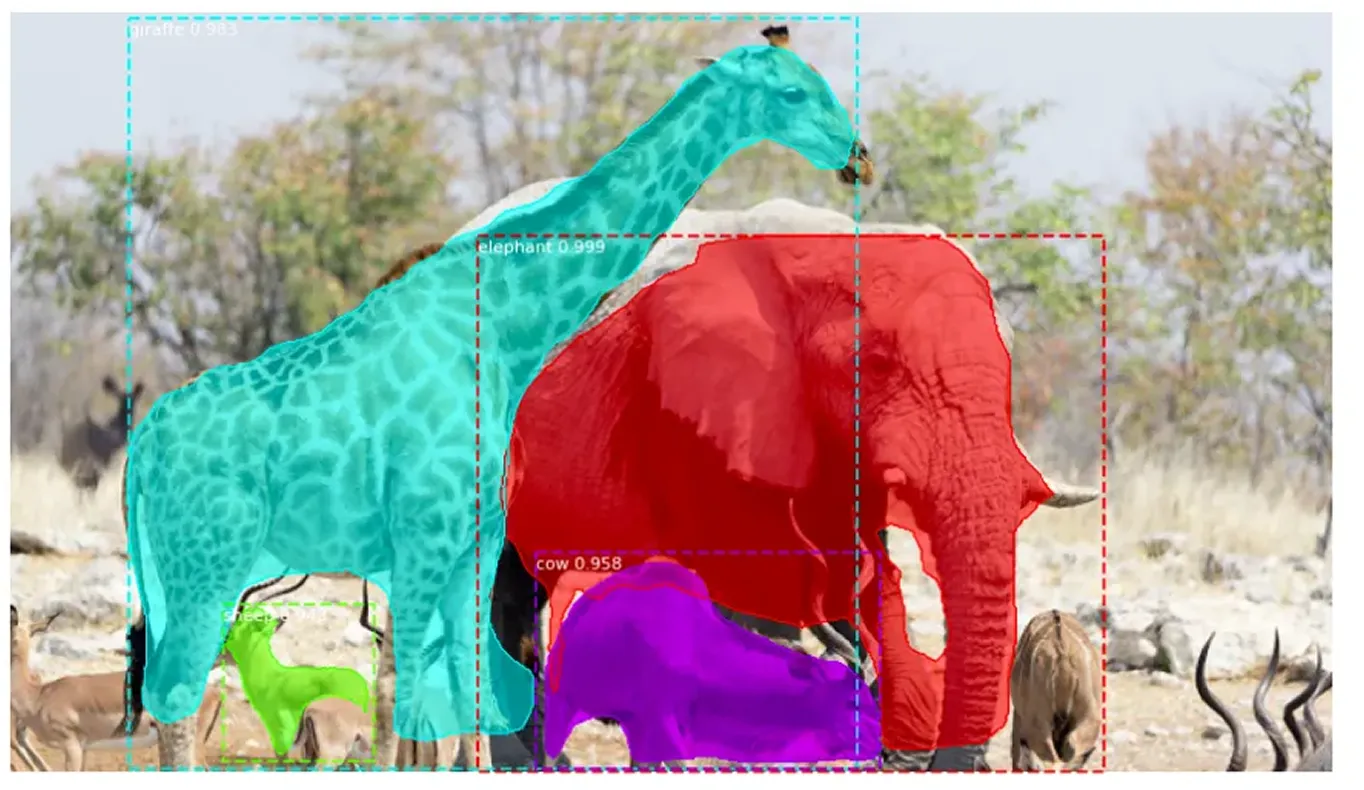

La segmentación de instancias va más allá de la detección de objetos tradicional, ya que no solo identifica objetos en una imagen, sino que también delinea con precisión cada uno de ellos. Asigna una etiqueta única a cada objeto detectado y captura su forma exacta a nivel de píxel. Este enfoque detallado permite distinguir claramente entre objetos superpuestos y manejar con precisión formas complejas.

Mask R-CNN se basa en Faster R-CNN, que detecta y etiqueta objetos, pero no define sus formas exactas. Mask R-CNN mejora esto identificando los píxeles exactos que componen cada objeto, lo que permite un análisis de imagen mucho más detallado y preciso.

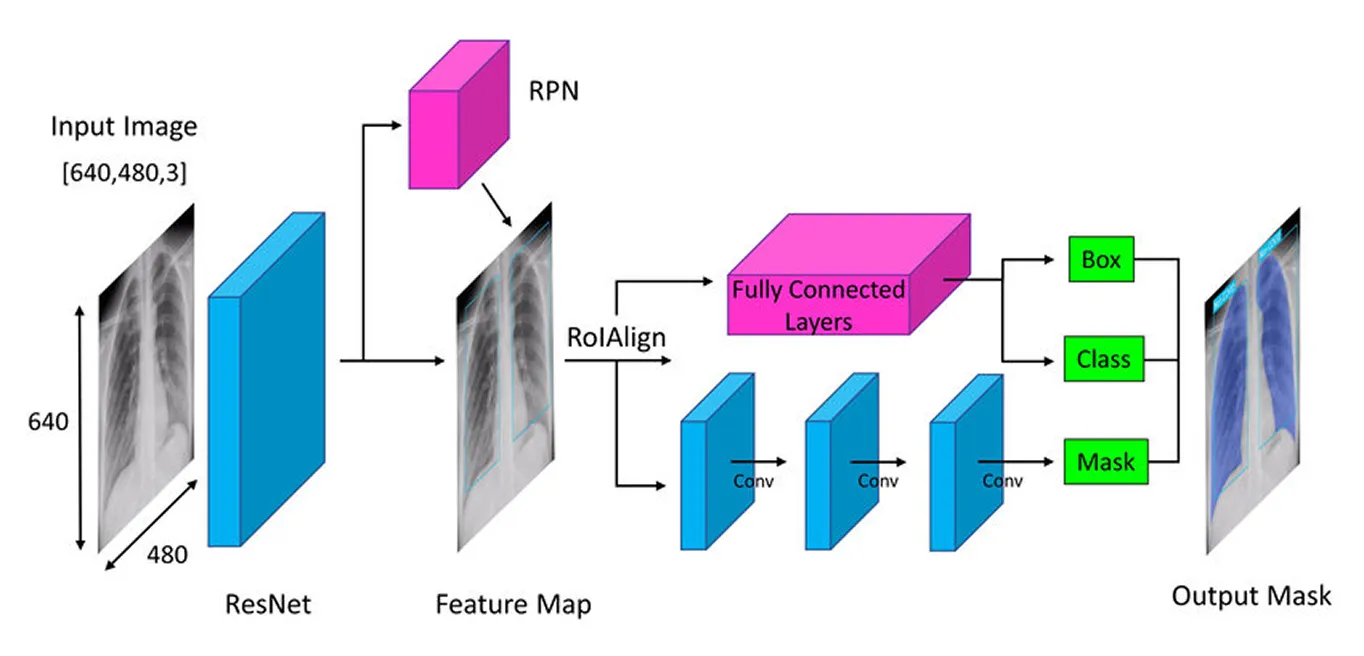

Mask R-CNN adopta un enfoque paso a paso para detect y segment objetos con precisión. Comienza extrayendo características clave mediante una red neuronal profunda (un modelo multicapa que aprende de los datos), luego identifica posibles áreas de objetos con una red de propuesta de regiones (un componente que sugiere posibles regiones de objetos) y, por último, refina estas áreas creando máscaras de segmentación detalladas (contornos precisos de los objetos) que capturan la forma exacta de cada objeto.

A continuación, repasaremos cada paso para tener una mejor idea de cómo funciona Mask R-CNN.

El primer paso en la arquitectura de Mask R-CNN es descomponer la imagen en sus partes clave para que el modelo pueda entender lo que hay en ella. Piense en ello como cuando mira una foto y naturalmente nota detalles como formas, colores y bordes. El modelo hace algo similar utilizando una red neuronal profunda llamada "backbone" (a menudo ResNet-50 o ResNet-101), que actúa como sus ojos para escanear la imagen y captar los detalles clave.

Dado que los objetos en las imágenes pueden ser muy pequeños o muy grandes, Mask R-CNN utiliza una Red de Pirámide de Características (Feature Pyramid Network). Esto es como tener diferentes lupas que permiten al modelo ver tanto los detalles finos como la imagen más grande, asegurando que los objetos de todos los tamaños sean detectados.

Una vez que se han extraído estas características importantes, el modelo pasa a localizar los objetos potenciales en la imagen, preparando el terreno para un análisis más profundo.

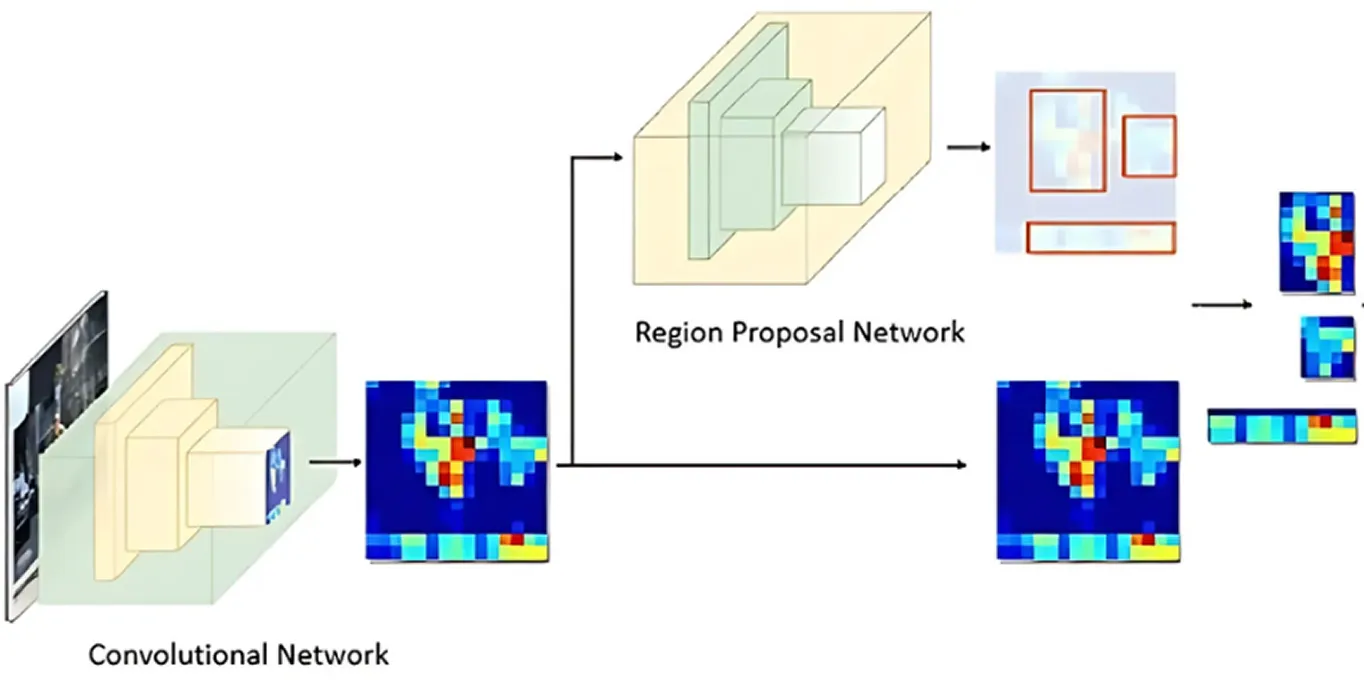

Una vez que la imagen ha sido procesada para obtener las características clave, la Red de Propuesta de Regiones (Region Proposal Network) toma el relevo. Esta parte del modelo examina la imagen y sugiere áreas que probablemente contengan objetos.

Lo hace generando múltiples ubicaciones de objetos posibles llamadas anclas. A continuación, la red evalúa estas anclas y selecciona las más prometedoras para su posterior análisis. De esta forma, el modelo se centra únicamente en las áreas con mayor probabilidad de ser interesantes, en lugar de comprobar cada punto de la imagen.

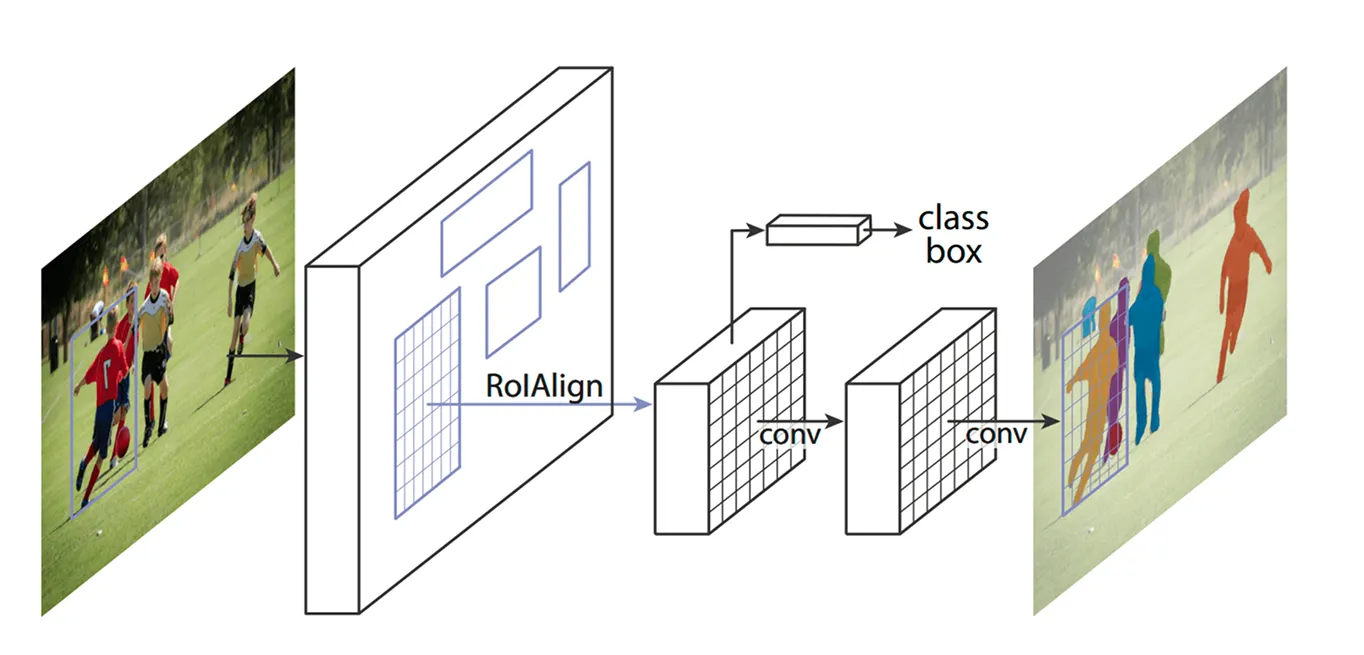

Una vez identificadas las áreas clave, el siguiente paso es refinar los detalles extraídos de estas regiones. Los modelos anteriores utilizaban un método llamado ROI Pooling (Region of Interest Pooling) para capturar características de cada área, pero esta técnica a veces provocaba ligeras desalineaciones al cambiar el tamaño de las regiones, lo que la hacía menos eficaz, especialmente para objetos más pequeños o superpuestos.

Mask R-CNN mejora esto utilizando una técnica conocida como ROI Align (Alineación de Región de Interés). En lugar de redondear las coordenadas como lo hace ROI Pooling, ROI Align utiliza la interpolación bilineal para estimar los valores de los píxeles con mayor precisión. La interpolación bilineal es un método que calcula un nuevo valor de píxel promediando los valores de sus cuatro vecinos más cercanos, lo que crea transiciones más suaves. Esto mantiene las características correctamente alineadas con la imagen original, lo que resulta en una detección y segmentación de objetos más precisas.

Por ejemplo, en un partido de fútbol, dos jugadores que están muy juntos pueden confundirse entre sí porque sus "bounding boxes" se superponen. ROI Align ayuda a separarlos manteniendo sus formas distintas.

Una vez que ROI Align procesa la imagen, el siguiente paso consiste en classify los objetos y afinar su ubicación. El modelo examina cada región extraída y decide qué objeto contiene. Asigna una puntuación de probabilidad a las distintas categorías y elige la mejor coincidencia.

Al mismo tiempo, ajusta los cuadros delimitadores para que se adapten mejor a los objetos. Es posible que los cuadros iniciales no estén colocados de manera ideal, por lo que esto ayuda a mejorar la precisión al asegurar que cada cuadro rodee estrechamente el objeto detectado.

Finalmente, Mask R-CNN da un paso más: genera una máscara de segmentación detallada para cada objeto en paralelo.

Cuando apareció este modelo, la comunidad de la inteligencia artificial lo acogió con gran entusiasmo y pronto se utilizó en diversas aplicaciones. Su capacidad para detect y segment objetos en tiempo real hizo que cambiara las reglas del juego en distintos sectores.

Por ejemplo, rastrear animales en peligro de extinción en su hábitat natural es una tarea difícil. Muchas especies se desplazan por bosques densos, lo que dificulta su track por parte de los conservacionistas. Los métodos tradicionales utilizan cámaras trampa, drones e imágenes por satélite, pero clasificar a mano todos estos datos lleva mucho tiempo. Las identificaciones erróneas y los avistamientos perdidos pueden ralentizar los esfuerzos de conservación.

Al reconocer rasgos únicos como las rayas de un tigre, las manchas de una jirafa o la forma de las orejas de un elefante, Mask R-CNN puede detect y segment animales en imágenes y vídeos con mayor precisión. Incluso cuando los animales están parcialmente ocultos por los árboles o muy juntos, el modelo puede separarlos e identificarlos individualmente, lo que agiliza y hace más fiable la vigilancia de la fauna salvaje.

A pesar de su importancia histórica en la detección y segmentación de objetos, Mask R-CNN también presenta algunos inconvenientes clave. Estos son algunos de los desafíos relacionados con Mask R-CNN:

La R-CNN de máscara era estupenda para tareas de segmentación, pero muchas industrias buscaban adoptar la visión por ordenador priorizando la velocidad y el rendimiento en tiempo real. Este requisito llevó a los investigadores a desarrollar modelos de una sola etapa que detect objetos en una sola pasada, lo que mejora enormemente la eficiencia.

A diferencia del proceso de múltiples pasos de Mask R-CNN, los modelos de visión por ordenador de una sola etapa como YOLO (You Only Look Once) se centran en tareas de visión por ordenador en tiempo real. En lugar de gestionar la detección y la segmentación por separado, los modelos YOLO pueden analizar una imagen de una sola vez. Por eso resultan ideales para aplicaciones como la conducción autónoma, la asistencia sanitaria, la fabricación y la robótica, en las que la rapidez en la toma de decisiones es crucial.

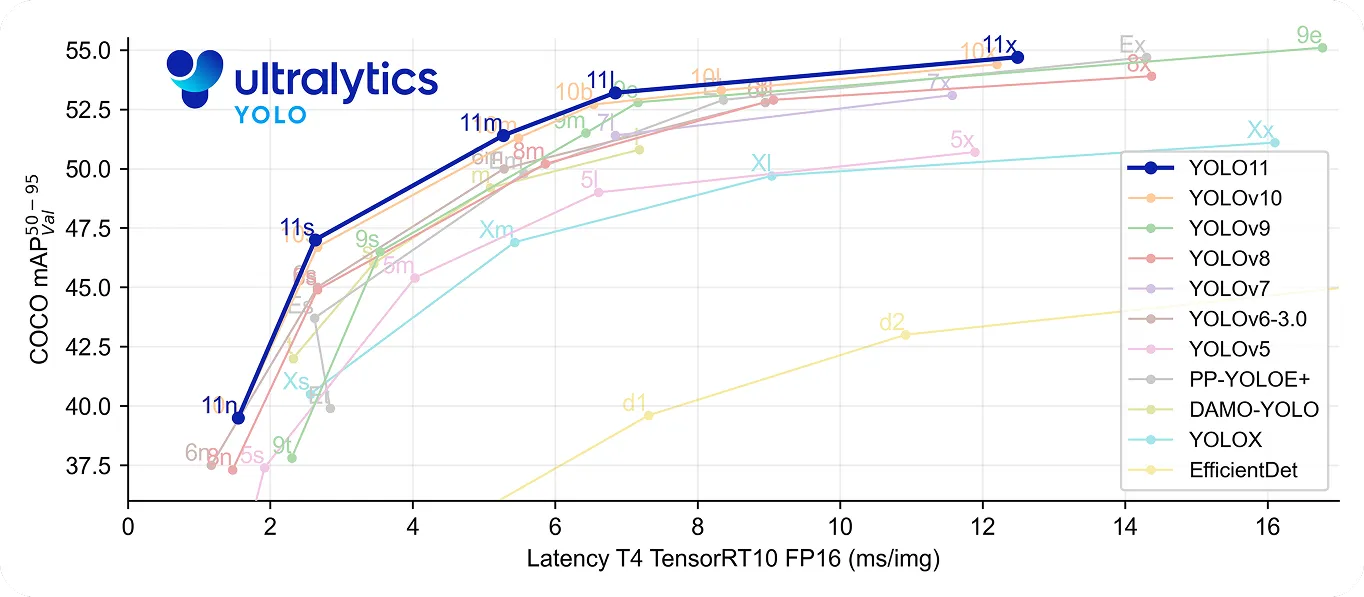

En concreto, YOLO11 va un paso más allá al ser rápido y preciso. Utiliza un 22% menos de parámetros que YOLOv8m , pero aún así alcanza una precisión mediamAP) superior en el conjunto de datos COCO , lo que significa que detecta los objetos con mayor precisión. Su mayor velocidad de procesamiento lo convierte en una buena opción para aplicaciones en tiempo real en las que cada milisegundo es importante.

Echando la vista atrás a la historia de la visión artificial, Mask R-CNN es reconocido como un gran avance en la detección y segmentación de objetos. Ofrece resultados muy precisos incluso en entornos complejos, gracias a su detallado proceso de varios pasos.

Sin embargo, este mismo proceso lo hace más lento en comparación con modelos en tiempo real como YOLO. A medida que crece la necesidad de velocidad y eficacia, muchas aplicaciones utilizan ahora modelos de una etapa como Ultralytics YOLO11, que ofrecen una detección de objetos rápida y precisa. Aunque Mask R-CNN es importante para comprender la evolución de la visión por ordenador, la tendencia hacia soluciones en tiempo real pone de manifiesto la creciente demanda de soluciones de visión por ordenador más rápidas y eficaces.

¡Únete a nuestra creciente comunidad! Explora nuestro repositorio de GitHub para obtener más información sobre la IA. ¿Listo para comenzar tus propios proyectos de visión artificial? Consulta nuestras opciones de licencia. ¡Descubre la IA en la agricultura y la IA de visión en la atención médica visitando nuestras páginas de soluciones!