監視やロボット工学などの実世界アプリケーションにおいて、Ultralytics YOLO11 高速かつ正確な小物体検出YOLO11 仕組みをご覧ください。

監視やロボット工学などの実世界アプリケーションにおいて、Ultralytics YOLO11 高速かつ正確な小物体検出YOLO11 仕組みをご覧ください。

ビジョンAIを搭載したドローンは地上数百メートル上空を飛行しながらも、映像フィード上でわずか数ピクセルに過ぎないdetect 求められる。実際、ロボット工学、監視システム、リモートセンシングなどの応用分野では、画像内の極めて微小な物体を識別する必要性から、これは一般的な課題となっている。

しかし、従来の物体検出モデルではこれが困難な場合があります。画像や動画内の小さな物体は、非常に限られた視覚情報しか提供しません。端的に言えば、モデルがそれらを観察しても、学習や認識に利用できる詳細情報がほとんどないのです。

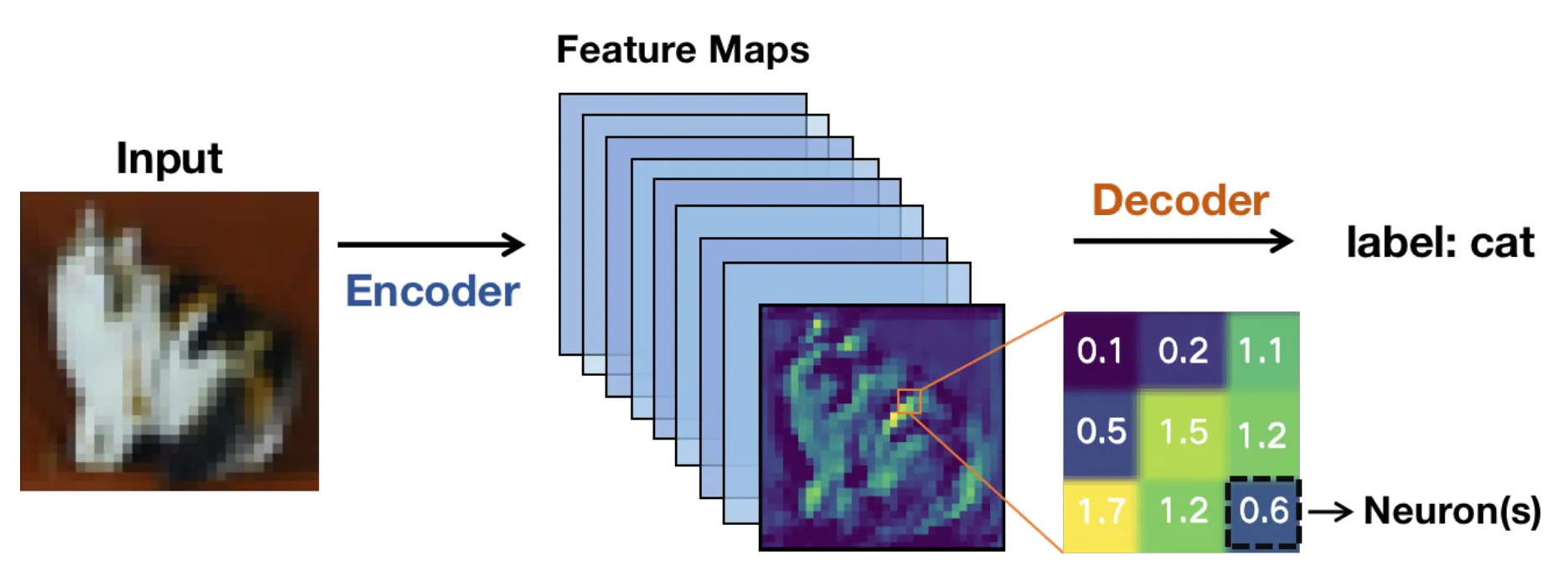

内部的には、これらのモデルは通常、畳み込みニューラルネットワーク(CNN)ベースのアーキテクチャに依存している。画像はネットワークの各層を通過し、特徴マップ、つまり生のピクセルではなく関連するパターンを強調した簡略化された表現へと変換される。

画像がネットワークの奥深くへ進むにつれて、これらの特徴マップは小さくなります。これにより計算は高速化されますが、細かいディテールが失われる可能性もあります。

微小な物体においては、こうした細部が極めて重要である。これらの細部が消失すると、コンピュータビジョンモデルは物体の検出に困難をきたす可能性があり、その結果、境界ボックスの精度が低下したり一貫性が失われたりする恐れがある。

リアルタイムのエンドツーエンドコンピュータビジョンシステムは、この問題をさらに複雑にする。高解像度画像は細部の保持に役立つが、推論速度を低下させ、よりGPU 必要とする。低解像度は高速に動作するが、小さな物体のdetectさらに困難になる。

速度、精度、ハードウェアの限界の間で絶え間ないバランス調整が必要となる。近年の技術進歩のおかげで、Ultralyticsのようなコンピュータビジョンモデルは Ultralytics YOLO11 や、まもなくUltralytics といったコンピュータビジョンモデルは、このトレードオフをより効果的に管理するよう設計されています。

本記事では、小さな物体の検出が困難な理由と、YOLO11 それをYOLO11 方法を探ります。さっそく始めましょう!

小物体検出は、AIの一分野であるコンピュータビジョンにおける課題であり、画像のごく一部を占める物体の識別と位置特定に焦点を当てている。これらの物体は、デジタル画像の最小単位であるピクセルの限られた数で画像内に表現されることが多い。このため、より大きく鮮明な対象物(多くの場合より多くのピクセルを含む)detect 困難となる。

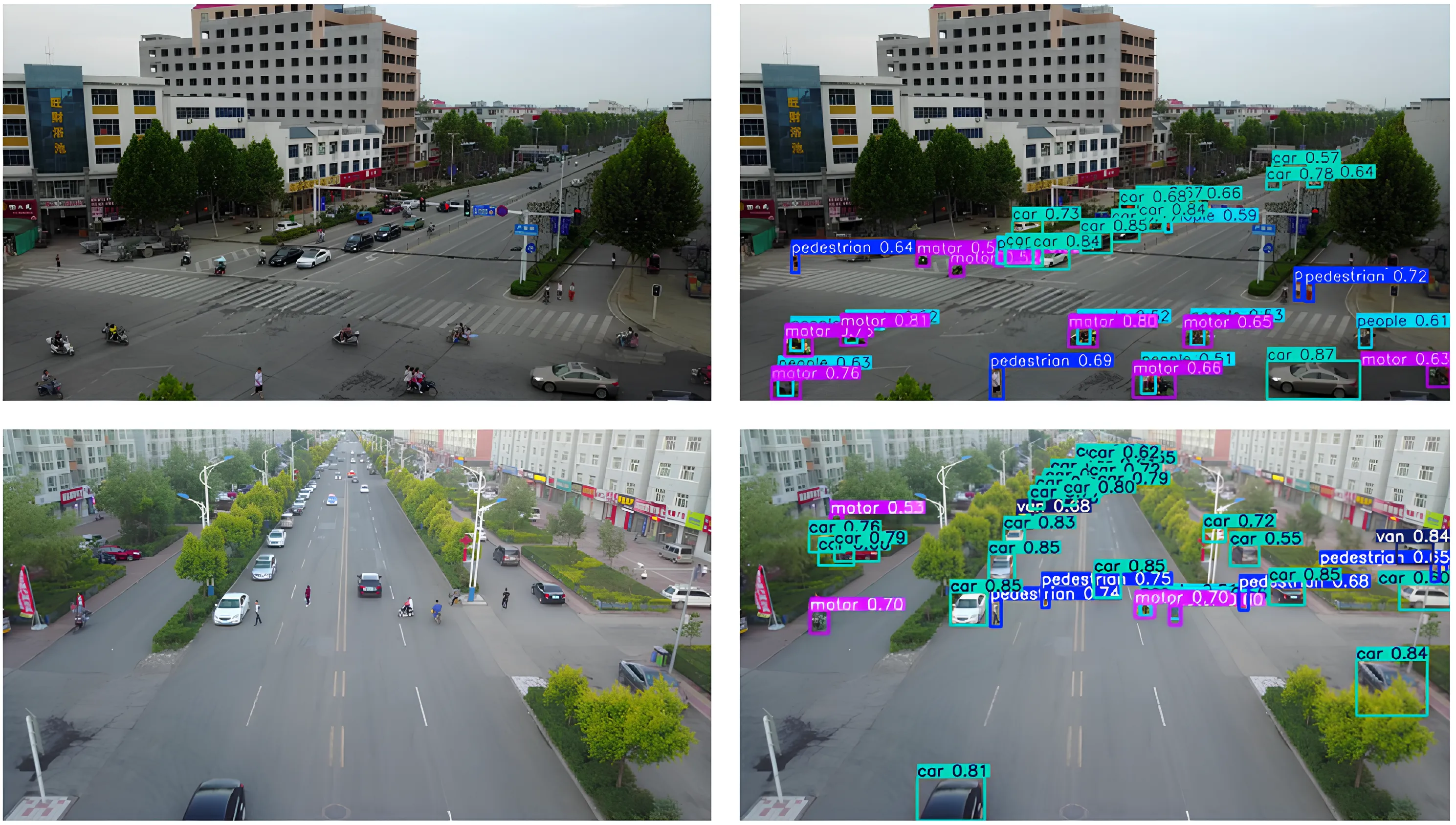

例えば、航空写真内の車両、工場フロアの工具、広角監視カメラに捉えられた人物などは、いずれも画像内で小さな物体として現れる。これらを検出することが重要なのは、それらが重要な情報を保持していることが多く、監視など多くの実世界アプリケーションが、これらの検出に依存して正しく機能するためである。

小さな物体を見逃すと、システムの性能や意思決定に影響を及ぼす可能性がある。無人航空機(UAV)監視はその好例であり、地上の小さな移動物体を見逃すと、航法や追跡精度に影響を与える恐れがある。

従来のシステムは手作業で作成された特徴量と従来のコンピュータビジョン手法を用いており、混雑した環境や多様なシーンでは困難を伴っていた。今日でも、深層学習モデルがはるかに優れた性能を発揮しているにもかかわらず、画像のごく一部を占める小さなターゲットの検出は依然として難しい。

次に、小さな物体を検出する際に、様々な実世界のシナリオで共通して見られる課題のいくつかを見ていきましょう。

小さな物体はピクセル数が非常に少ないため、特徴抽出などの段階でモデルが学習できる視覚的詳細が制限される。その結果、エッジや形状、テクスチャといったパターンがdetect、小さな物体が背景に溶け込みやすくなる。

画像がニューラルネットワークの畳み込み層を通過するにつれ、ピクセル内の視覚情報は次第に特徴マップへと圧縮される。これによりモデルの効率性は保たれるが、同時に細かいディテールが失われていく。

小さなターゲットの場合、重要な手がかりが検出ネットワークが動作する前に消失することがある。その場合、位置特定は信頼性が低下し、バウンディングボックスがずれたり、重なったり、ターゲットオブジェクトを完全に見逃したりする可能性がある。

遮蔽によってもサイズ関連の課題がしばしば生じる。遮蔽とは、特に小さい物体がシーン内の他の物体によって部分的に隠される現象である。

これによりターゲットの可視領域が縮小され、物体検出器が入手できる情報が制限される。わずかな遮蔽でも、特に低解像度の入力と組み合わさると、検出ネットワークを混乱させうる。この興味深い例は、VisDroneなどのUAVデータセットで見られる。そこでは歩行者、自転車、車両が建物、樹木、その他の移動物体によって部分的に遮蔽される場合がある。

同様に、スケールのばらつきは、距離やカメラ位置によって同じ物体が非常に小さく、あるいは比較的大きく見える場合に、さらなる難しさを加える。こうした課題にもかかわらず、検出アルゴリズムは精度を損なうことなく、異なるスケールにわたってこれらの小さな物体を認識しなければならない。

検出において文脈も重要な役割を果たす。例えば、大きな物体は通常、有用な視覚的手がかりを提供する明確な周囲環境と共に現れる。一方、小さな目標物はこの文脈情報が欠如していることが多く、パターン認識を困難にする。

交差率(IoU)などの一般的な評価指標は、予測された境界ボックスが真の境界ボックスとどれだけ重なるかを測定します。IoU 大きな物体では良好にIoU 、小さな物体ではその挙動が大きく異なります。

小さな物体はわずか数ピクセルしか占めないため、予測ボックスのわずかなずれでも比例的に大きな誤差が生じ、IoU 急激に低下する。これは、画像内に物体が確認できる場合でも、小さな物体が予測を正しいと判定するためのIoU を満たせないことが多いことを意味する。

その結果、位置特定エラーは偽陽性または偽陰性として分類される可能性が高くなる。こうした制限から、研究者らは物体検出システムが小さくdetect 評価・処理する方法を再考せざるを得なくなった。

研究者が小物体検出の精度向上に取り組む中で、複数のスケールにわたる視覚情報の保持と表現が不可欠であることが明らかになった。この知見は、最近のarXiv研究やIEEE国際会議、欧州コンピュータビジョン学会(ECCV)などの場で発表された論文にも反映されている。

画像がニューラルネットワークの深層へ進むにつれ、小さな物体は細部を失ったり完全に消失したりする可能性がある。YOLO11 現代のコンピュータビジョンモデルYOLO11 、より優れた特徴抽出に重点YOLO11 理由である。次に、特徴マップと特徴ピラミッドネットワークの核心概念を順を追って解説し、その理解を深めていこう。

リモートセンシング画像などの入力画像がニューラルネットワークに入力されると、次第に特徴マップへと変換される。これらは画像の簡略化された表現であり、エッジ、形状、テクスチャといった視覚的パターンを強調する。

ネットワークが深くなるにつれて、これらの特徴マップは空間的なサイズが小さくなります。この縮小により、モデルは効率的に動作し、高次元の情報を重視できるようになります。しかし、特徴マップの縮小と深層化は、空間的な詳細も減少させます。

大きな物体は正確な検出に必要な視覚情報を保持できる一方、小さなターゲットはわずか数層のネットワーク処理で重要な詳細を失う可能性がある。これが発生すると、モデルは小さな物体の存在自体を認識できなくなる。これが深層物体検出モデルで小さな物体が見落とされる主な理由の一つである。

特徴ピラミッドネットワーク(FPN)は、空間的詳細情報の損失に対処するために導入され、複数の層からの情報を統合する補助モジュールとして機能し、モデルがdetect 効果的にdetect します。このプロセスは特徴集約および特徴融合としても知られています。

浅い層は微細な空間的詳細を提供し、深い層は意味的文脈を追加することで、効果的なマルチスケール特徴学習を可能にする。単純に特徴マップを拡大する単純なアップサンプリングとは異なり、FPNは意味のある情報を保持し、小さな物体の検出を改善する。

現代的な手法はこの考え方を基盤とし、適応的な特徴融合と文脈認識設計を用いて小型目標の検出能力をさらに向上させている。つまりFPNは、モデルが全体像と細部を同時に認識することを可能にする。この最適化は対象物が小さい場合に不可欠である。

物体検出モデルが、非常に小さなものを含む様々なdetect より正確にdetect 、時間とともにどのように進化・進歩してきたかを以下に概観する:

小さな物体検出の仕組みについて理解が深まったところで、YOLO11 適用YOLO11 実際の応用例をいくつか見ていきましょう。

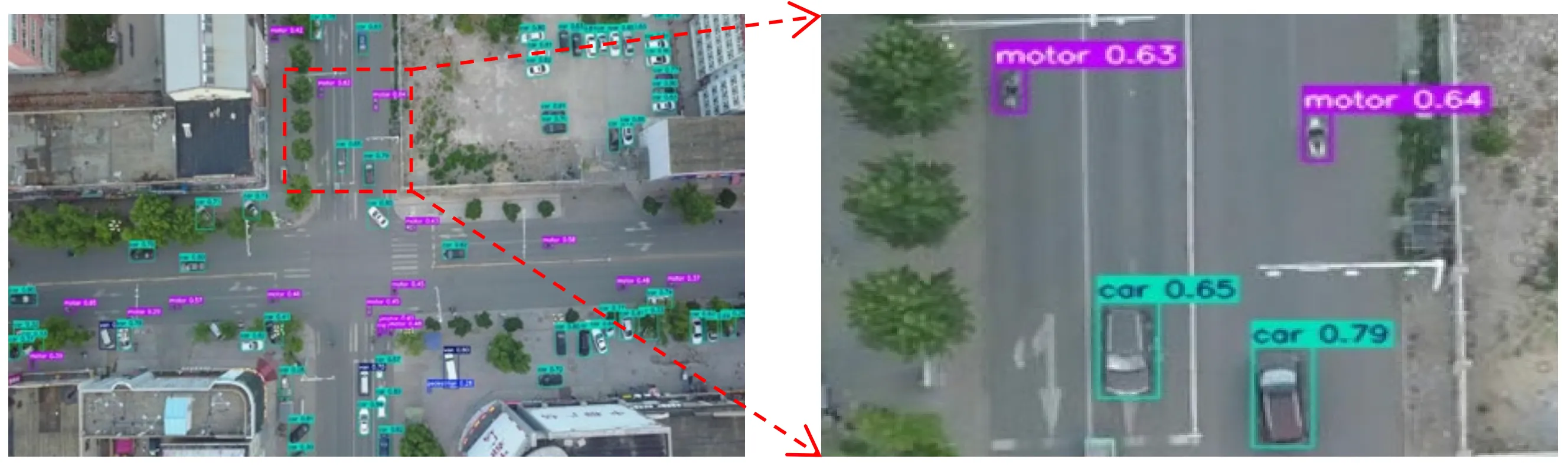

賑やかな街路の上空をドローンが飛んでいる様子を想像してみてください。その高さから見下ろすと、車や自転車、そして人々さえも、画面上のほんの数ピクセルに縮んでしまいます。

無人航空機(UAV)や航空撮影モジュールは、このようなシーンを頻繁に捉える。対象となる物体は小さく、雑然とした背景に囲まれているため、コンピュータビジョンモデルによるdetect困難となる。

このようなシナリオでは、YOLO11 理想的なモデル選択YOLO11 。例えば、YOLO11 モデルを搭載したドローンは、交通状況をリアルタイムで監視YOLO11 、車両、自転車、歩行者がシーン内を移動するのをYOLO11 。各オブジェクトが画像のごく一部しか占めていない場合でも同様である。これにより、交通管理、公共安全、都市計画などの応用分野において、より迅速な意思決定とより正確な洞察が可能となる。

ロボットは精度とタイミングが極めて重要な環境で頻繁に活用される。倉庫、工場、農場といった現場では、ロボットが組み立てライン上の部品、パッケージのラベル、畑の小さな植物の芽など、非常に小さな物体を認識し、迅速に対応する必要がある場合がある。

このサイズの物体を検出するのは複雑な場合があります。特に、カメラ映像上でわずか数ピクセルしか表示されない場合や、他の物体によって部分的に遮られている場合です。こうした細部を見逃すと、自動化の速度が低下したり、ロボットのタスク遂行能力に影響を及ぼす可能性があります。

YOLO11 こうした状況で効果YOLO11 。改良された特徴抽出と高速推論により、ロボットはdetect 物体をリアルタイムでdetect 、即座にアクションを起こすことが可能になります。

YOLO11 サポートYOLO11 、ロボットが物体の境界や把持点をより正確に把握するのに役立ちます。単なるバウンディングボックスの位置特定にとどまりません。例えば、YOLO11 統合したロボットアームは、コンベアベルト上の小さな部品をYOLO11 、segment 正確なsegment 、手がYOLO11 。これによりシステムの効率性と信頼性が維持されます。

今日では非常に多くのコンピュータビジョンモデルが利用可能ですが、Ultralytics YOLO11 理由について疑問に思っているかもしれません。

Ultralytics YOLO11 小さな物体の検出が必要なアプリケーションに最適なYOLO11 理由は以下の通りです:

YOLO11モデルを使用することに加え、アノテーションの準備方法、データセット全体、およびモデルトレーニング手順が、検出性能に大きな差をもたらす可能性があります。

以下に重点を置くべき事項の概要を示します:

小さな物体の検出は困難である。なぜなら、画像がコンピュータビジョンモデルを通過する過程で、小さなターゲットは細部を失うからだ。YOLO11 これらの細部の保持方法をYOLO11 、リアルタイム性能を犠牲にすることなく、小さな物体の検出をより信頼性の高いものにしている。このバランスにより、YOLO11 実世界のアプリケーションにおいて正確かつ効率的な検出YOLO11 。

成長を続けるコミュニティに参加しませんか?GitHubリポジトリでAIについてもっと学びましょう。ソリューションページでは、小売業におけるコンピュータビジョンや自動車産業におけるAIなどのイノベーションをご紹介しています。コンピュータビジョンを使った開発を始めるには、ライセンスオプションをご覧ください。

.webp)

.webp)