AppleはCVPR 2025でFastVLMを発表しました。このオープンソースのvision-languageモデルは、FastViTHDエンコーダーを搭載し、最初のトークンまでの時間を最大85 ×高速化します。

AppleはCVPR 2025でFastVLMを発表しました。このオープンソースのvision-languageモデルは、FastViTHDエンコーダーを搭載し、最初のトークンまでの時間を最大85 ×高速化します。

CVPR 2025カンファレンスで、AppleはFastVLMと呼ばれる新しいオープンソースAIモデルを発表しました。これは、画像と言語の両方を理解するように構築されており、iPhone、iPad、MacなどのAppleデバイスで実行されます。これは、データをクラウドに送信せずに、スマートな結果を迅速に提供できることを意味します。

FastVLMが特に興味深いのは、その速度と効率性です。AppleはFastViTHDと呼ばれる新しいビジョンエンコーダを開発しました。これは、より少ないメモリと電力で高品質の画像をモデルが解釈するのに役立ちます。すべての処理はデバイス上でローカルに行われるため、ユーザーのプライバシーを保護しながら、応答時間が短縮されます。

この記事では、FastVLMの仕組み、その特徴、そしてこのAppleのリリースが、デバイス上の日常的なAIアプリケーションにとってなぜ重要な一歩となるのかを解説します。

FastVLMを特別なものにしている理由について掘り下げる前に、その名前にある「VLM」が何を意味するのかを説明しましょう。これはVision-Language Modelの略で、視覚コンテンツと言語を理解し、結びつけるように設計されています。

VLM(Vision Language Model)は、視覚的な理解と言語を組み合わせることで、写真の説明、スクリーンショットに関する質問への回答、ドキュメントからのテキスト抽出などのタスクを実行できます。Vision Language Modelは通常、2つの部分で構成されています。1つは画像を処理してデータに変換し、もう1つはそのデータを解釈して、読み聞きできる応答を生成します。

気づかないうちに、すでにこの種のAIイノベーションを利用しているかもしれません。レシートをスキャンしたり、IDカードを読み取ったり、画像のキャプションを生成したり、視覚障碍者が画面を操作するのを支援したりするアプリは、バックグラウンドで静かに動作するVision-Languageモデルに依存していることがよくあります。

Appleは、他のvision-languageモデルと同じタスクを実行するためにFastVLMを構築しましたが、より高速で、より強力なプライバシー、および独自のデバイスでの最適化されたパフォーマンスを実現しています。画像のコンテンツを理解してテキストで応答できますが、クラウドサーバーに依存する多くのモデルとは異なり、FastVLMはiPhone、iPad、またはMacで完全に実行できます。

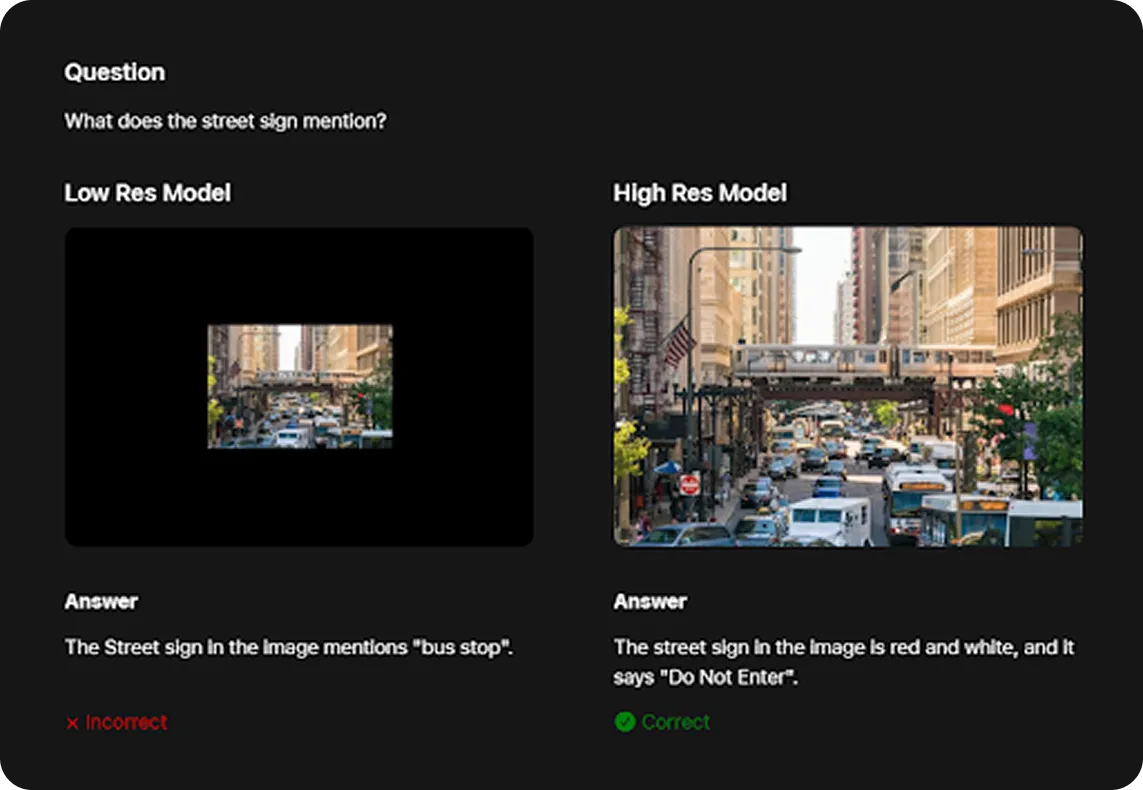

一般的に、VLMは高解像度の画像でより優れた性能を発揮します。例えば、以下に示すように、FastVLMは画像の高解像度版が与えられた場合にのみ、道路標識を「進入禁止」と正しく識別できました。ただし、高解像度の入力は通常、モデルの処理速度を低下させます。ここでFastViTHDが違いを生み出します。

Appleの新しいvisionエンコーダーであるFastViTHDは、FastVLMが高品質の画像をより効率的に処理するのに役立ち、メモリと電力を削減します。具体的には、FastViTHDは、小型デバイスでもスムーズに実行できるほど軽量です。

また、FastVLMはFastVLM GitHubリポジトリで公開されており、開発者はソースコードにアクセスし、変更を加え、Appleのライセンス条項に従って独自のアプリで使用できます。

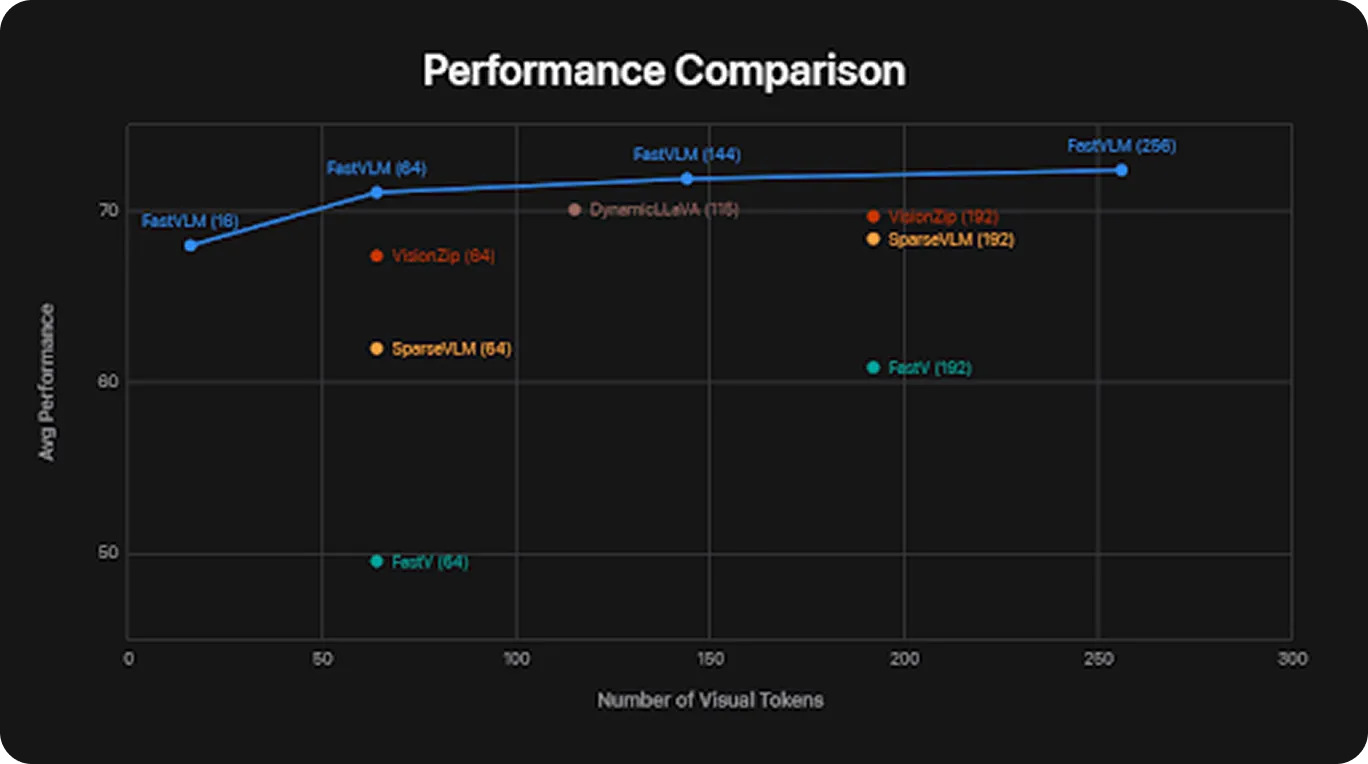

他のビジョン言語モデルと比較して、FastVLMはスマートフォンやラップトップなどの日常的なデバイスで実行するように最適化されています。パフォーマンステストでは、FastVLMはLLaVA-OneVision-0.5Bなどのモデルよりも最大85倍速く最初の単語または出力を生成しました。

FastVLMの評価に使用された標準的なベンチマークをいくつかご紹介します。

これらのベンチマーク全体で、FastVLMはより少ないリソースを使用しながら、競争力のある結果を達成しました。これにより、携帯電話、タブレット、ラップトップなどの日常的なデバイスに実用的なビジュアルAIがもたらされます。

次に、FastVLMの画像処理パフォーマンスにおいて重要な役割を果たすビジョンエンコーダであるFastViTHDを詳しく見ていきましょう。

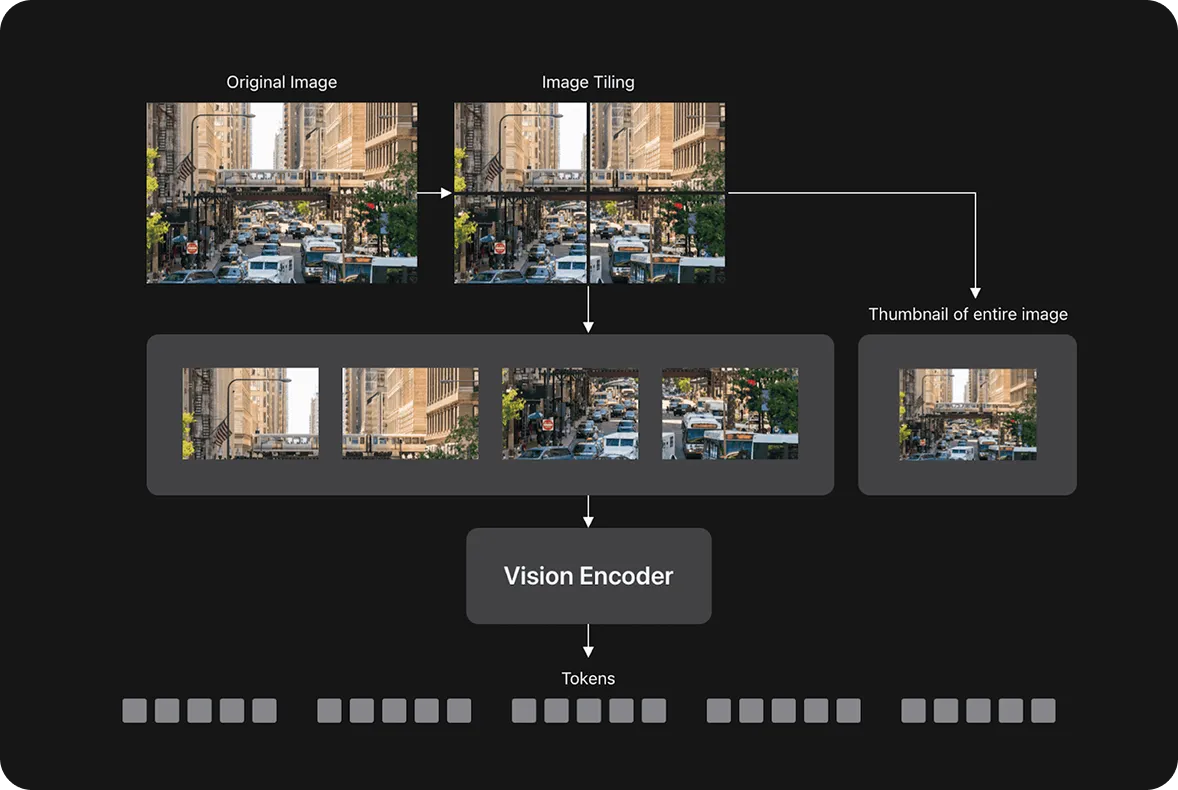

最新のビジョン言語モデルは、画像をトークンと呼ばれる数千の小さなパッチに分割します。トークンが多いほど、モデルが画像を理解するために必要な時間と電力が増えます。これにより、特に携帯電話やラップトップでは、処理が遅くなる可能性があります。

FastViTHDは、画像全体を理解しながら、トークン数を減らすことで、トークンが多すぎる場合に発生する速度低下を回避します。パターンと関係のモデリングに優れたTransformerと、視覚データの処理に効率的な畳み込み層の2つのアプローチを組み合わせています。その結果、より高速に動作し、使用するメモリが少ないシステムが実現します。

Appleによると、FastViTHDは、高い精度を維持しながらも、従来のビジョンエンコーダよりも最大3.4倍小型化されています。トークン削減(処理速度を上げるために重要度の低い画像パッチを削除する)のようなモデル最適化技術に頼る代わりに、よりシンプルで合理化されたアーキテクチャによって効率を実現しています。

Appleは、FastVLMを3つの異なるサイズでリリースしました:0.5B、1.5B、および7Bパラメータ(「B」は10億を表し、モデル内の学習可能な重みの数を指します)。各バージョンは、さまざまなタイプのデバイスに適合するように設計されています。小型モデルは携帯電話やタブレットで実行でき、大型の7Bモデルはデスクトップやより要求の厳しいタスクに適しています。

これにより、開発者は自分のアプリに最適なものを柔軟に選択できます。モバイル向けに高速で軽量なものを作成することも、より大規模なシステム向けに複雑なものを作成することもでき、すべて同じ基盤となるモデルアーキテクチャを使用できます。

Appleは、visionとlanguageモデルを調整するためのフレームワークであるLLaVA-1.5パイプラインを使用して、FastVLMモデルのバリアントをトレーニングしました。言語コンポーネントについては、自然で一貫性のあるテキストを生成することで知られる既存のオープンソースモデル(QwenやVicunaなど)を使用してFastVLMを評価しました。この設定により、FastVLMは単純な画像と複雑な画像の両方を処理し、読みやすく関連性の高い応答を生成できます。

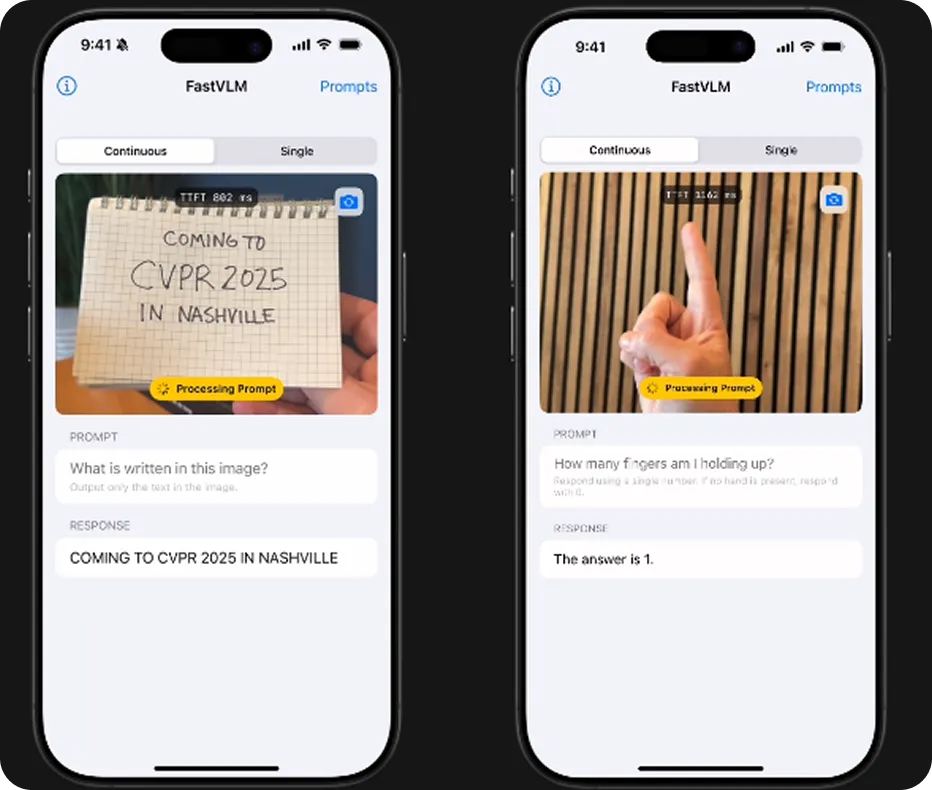

FastVLMの効率的な画像処理が重要なのはなぜだろうかと思われるかもしれません。それは、アプリがクラウドに依存せずに、どれだけリアルタイムでスムーズに動作できるかにかかっています。FastVLMは、最大1152 x 1152ピクセルの高解像度画像を処理でき、デバイス上で直接実行できるほど高速かつ軽量です。

つまり、アプリはカメラが見ているものを説明したり、領収書をスキャンして記録したり、画面上の変化に対応したりできます。しかも、すべてローカルで処理できます。これは、教育、アクセシビリティ、生産性、写真などの分野で特に役立ちます。

FastViTHDは、大きな画像の場合でも効率的であるため、デバイスの応答性と冷却性を維持するのに役立ちます。最小のiPhoneでも動作する最小のモデルを含む、すべてのモデルサイズで動作します。つまり、同じAI機能を携帯電話、タブレット、Macで利用できます。

FastVLMは、速度、効率、オンデバイスのプライバシーなどの主要な利点のおかげで、幅広いアプリケーションを強化できます。以下に、その使用方法をいくつか示します。

オンデバイスAIアシスタント: FastVLMは、画面上の情報を迅速に理解する必要があるAIアシスタントと相性が良いです。デバイス上で直接実行され、データのプライバシーが保護されるため、テキストの読み取り、ボタンやアイコンの識別、クラウドに情報を送信せずにリアルタイムでユーザーをガイドするなどのタスクを支援できます。

FastVLMは、オンデバイスのビジョン言語AIをAppleデバイスにもたらし、速度、プライバシー、効率を兼ね備えています。軽量設計とオープンソースリリースにより、モバイルおよびデスクトップアプリ全体でリアルタイムの画像理解が可能になります。

これにより、AIがより実用的になり、日常的に利用しやすくなります。また、開発者は、有用でプライバシーを重視したアプリケーションを構築するための強固な基盤を得ることができます。今後は、ビジョン・言語モデルが、私たちがテクノロジーと対話する方法において重要な役割を果たし、AIをより応答性が高く、状況を認識し、日常の状況で役立つものにする可能性があります。

AIについてさらに詳しく知りたい方は、GitHubリポジトリをご覧ください。活発なコミュニティに参加して、自動車産業におけるAIや製造業におけるVision AIなどの分野におけるイノベーションを発見してください。今日からコンピュータビジョンを始めるには、ライセンスオプションをご確認ください。