Ultralytics YOLO11 ようなコンピュータビジョンモデルが、どのようにロボットをより賢くし、ロボット工学の未来を形作るのか、詳しく見てみましょう。

Ultralytics YOLO11 ようなコンピュータビジョンモデルが、どのようにロボットをより賢くし、ロボット工学の未来を形作るのか、詳しく見てみましょう。

ロボットは、1950年代に発明された最初の産業用ロボットであるUnimate以来、長足の進歩を遂げてきました。事前にプログラムされたルールベースのマシンとして始まったものは、現在では複雑なタスクを実行し、現実世界とシームレスに相互作用できるインテリジェントシステムに進化しました。

今日、ロボットは製造業やヘルスケアから農業まで、さまざまな業界で多様なプロセスの自動化に利用されています。ロボット工学の進化における重要な要素は、AIとコンピュータビジョンです。これは、機械が視覚情報を理解し、解釈するのを助けるAIの一分野です。

例えば、次のようなコンピュータビジョンモデルがある。 Ultralytics YOLO11のようなコンピュータ・ビジョン・モデルは、ロボット・システムの知能を向上させている。これらのシステムに統合されたビジョンAIは、ロボットが物体を認識し、環境をナビゲートし、リアルタイムで意思決定を行うことを可能にします。

この記事では、YOLO11 どのように高度なコンピューター・ビジョン機能でロボットを強化できるかを見ていき、さまざまな産業分野での応用を探っていく。

ロボットの中核機能は、周囲の状況をどれだけ理解しているかにかかっています。この認識は、物理的なハードウェアをスマートな意思決定につなげます。それがなければ、ロボットは固定された指示に従うことしかできず、変化する環境に適応したり、複雑なタスクを処理したりすることができません。人間がナビゲートするために視覚に頼るのと同じように、ロボットはコンピュータビジョンを使用して環境を解釈し、状況を理解し、適切な行動を取ります。

実際、コンピューター・ビジョンはほとんどのロボット・タスクにとって基本的なものだ。ロボットが動き回りながら物体をdetect し、障害物を回避するのに役立つ。しかし、そのためには、世界を見るだけでは十分ではなく、ロボットは素早く反応できなければならない。実世界の状況では、わずかな遅れがコストのかかるエラーにつながる。Ultralytics YOLO11 ようなモデルは、ロボットがリアルタイムで洞察を収集し、複雑な状況や不慣れな状況でも即座に反応することを可能にします。

YOLO11 ロボットシステムにどのように組み込むことができるかを説明する前に、まずYOLO11主な特徴を探ってみよう。

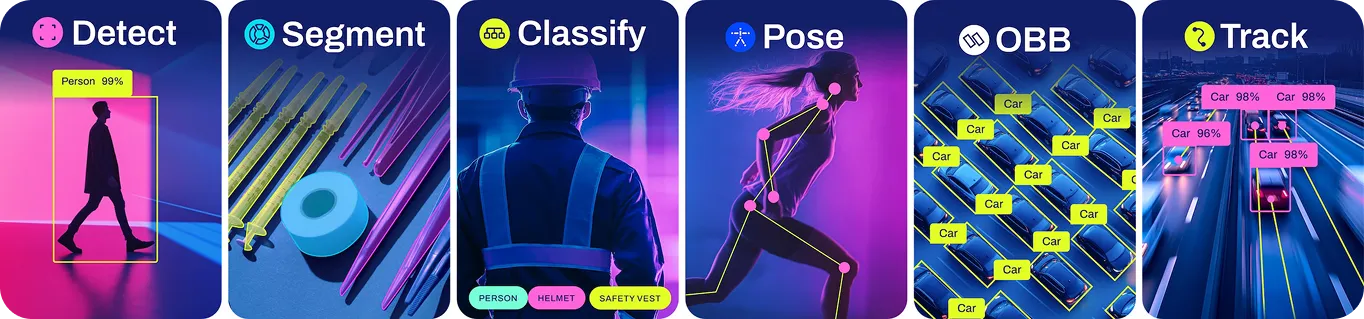

Ultralytics YOLO モデルは、高速でリアルタイムの洞察を提供するのに役立つ様々なコンピュータビジョンタスクをサポートします。特に、Ultralytics YOLO11 11は、より高速なパフォーマンス、より低い計算コスト、精度の向上を提供します。例えば、画像やビデオ内の物体を高精度でdetect することができ、ロボット工学、ヘルスケア、製造などの分野でのアプリケーションに最適です。

YOLO11 ロボット工学に最適な選択肢にしている、インパクトのある機能をいくつか紹介しよう:

ユーザーフレンドリー: YOLO11分かりやすいマニュアルとインターフェースは、学習曲線を短縮し、ロボットシステムへの統合を容易にします。

YOLO11 サポートするコンピュータビジョンタスクのいくつかを詳しく見てみよう:

インテリジェントな学習から産業オートメーションまで、YOLO11 ようなモデルはロボットができることを再定義するのに役立つ。YOLO11のロボット工学への統合は、コンピュータビジョンモデルがいかにオートメーションの進歩を促進しているかを示しています。YOLO11 大きな影響を与えることができる主要な領域をいくつか探ってみましょう。

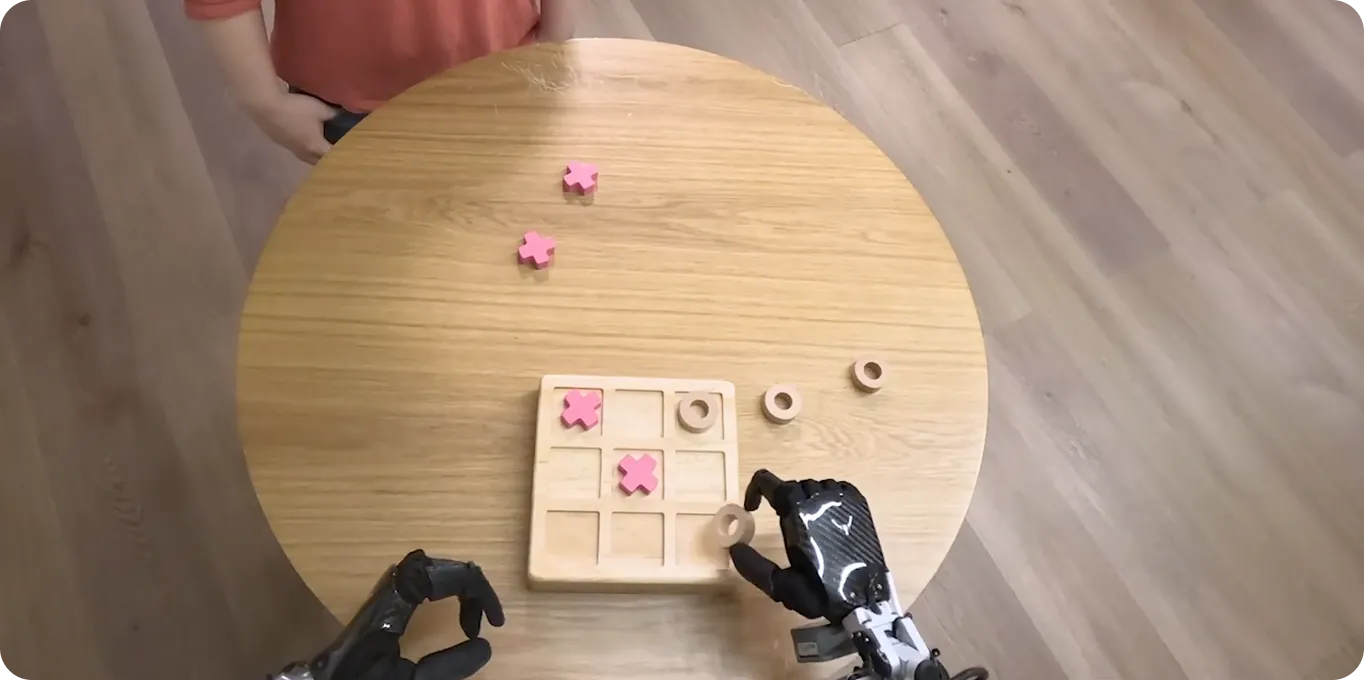

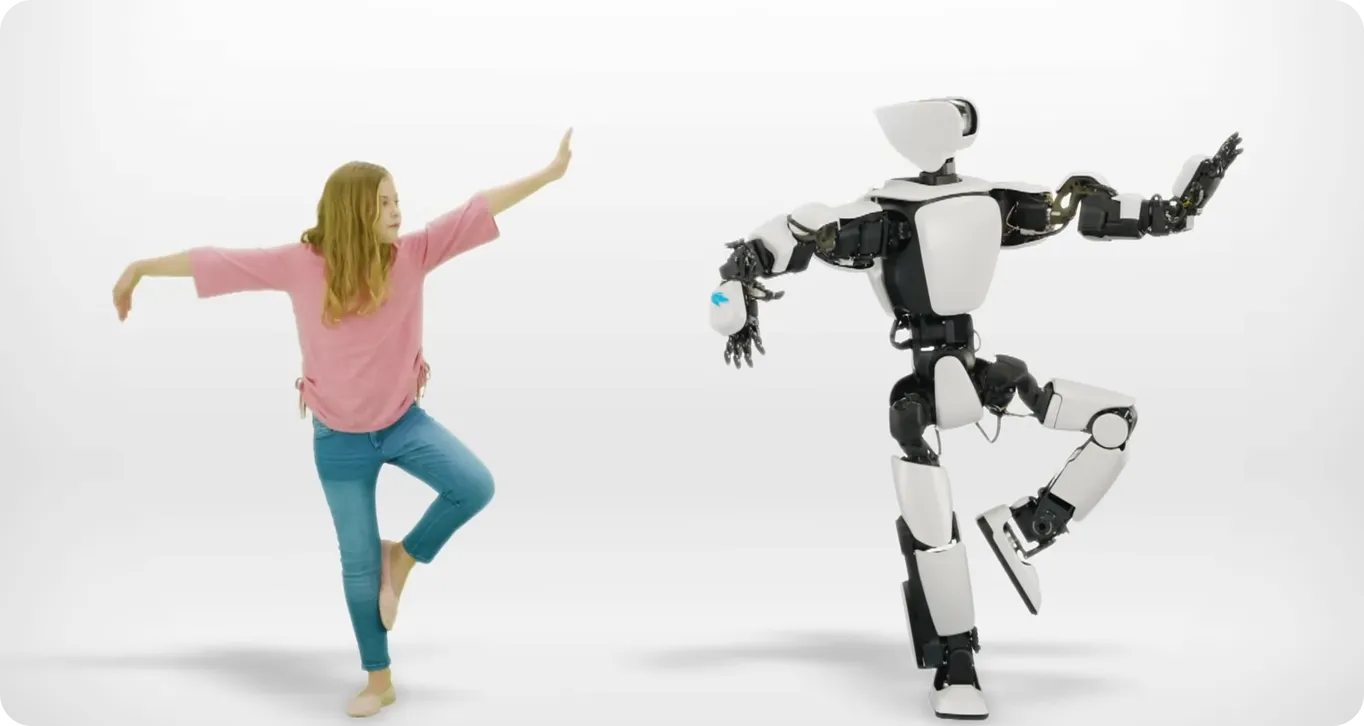

コンピュータビジョンはヒューマノイドロボットで広く使用されており、環境を観察することで学習することができます。YOLO11 ようなモデルは、高度な物体検出と姿勢推定を提供することで、このプロセスを強化し、ロボットが人間の行動や振る舞いを正確に解釈するのに役立ちます。

微妙な動きやインタラクションをリアルタイムで分析することで、ロボットは複雑な人間のタスクを再現するように訓練できます。これにより、ロボットはあらかじめプログラムされたルーチンを超えて、人がリモコンやドライバーを使用するのを見るだけで、タスクを学習できます。

この種の学習は、さまざまな産業で役立ちます。たとえば、農業では、ロボットが人間の作業者が植え付け、収穫、作物の管理などの作業を学習する様子を観察できます。人間がこれらのタスクを実行する方法を模倣することで、ロボットはあらゆる状況に合わせてプログラムする必要なく、さまざまな農業条件に適応できます。

同様に、ヘルスケアにおいても、コンピュータービジョンの重要性はますます高まっている。例えば、YOLO11 医療機器に使用され、外科医の複雑な手技を支援することができる。オブジェクト検出やインスタンス分割などの機能により、YOLO11 ロボットが体内構造を発見し、手術器具を管理し、正確な動きをするのを助けることができる。

SFの世界の話のように聞こえるかもしれないが、最近の研究では、外科手術におけるコンピューター・ビジョンの実用化が実証されている。胆嚢摘出術(胆嚢摘出)の自律的ロボット解剖に関する興味深い研究では、研究者たちはYOLO11 組織セグメンテーション (画像内の異なる組織の分類と分離)と手術器具キーポイント検出(器具上の特定のランドマークの識別)に統合した。

このシステムは、異なる組織タイプを正確に区別することができ、組織が手術中に変形(形状変化)しても、これらの変化に動的に対応しました。これにより、ロボット手術器具は正確な解剖(外科的切断)経路をたどることができました。

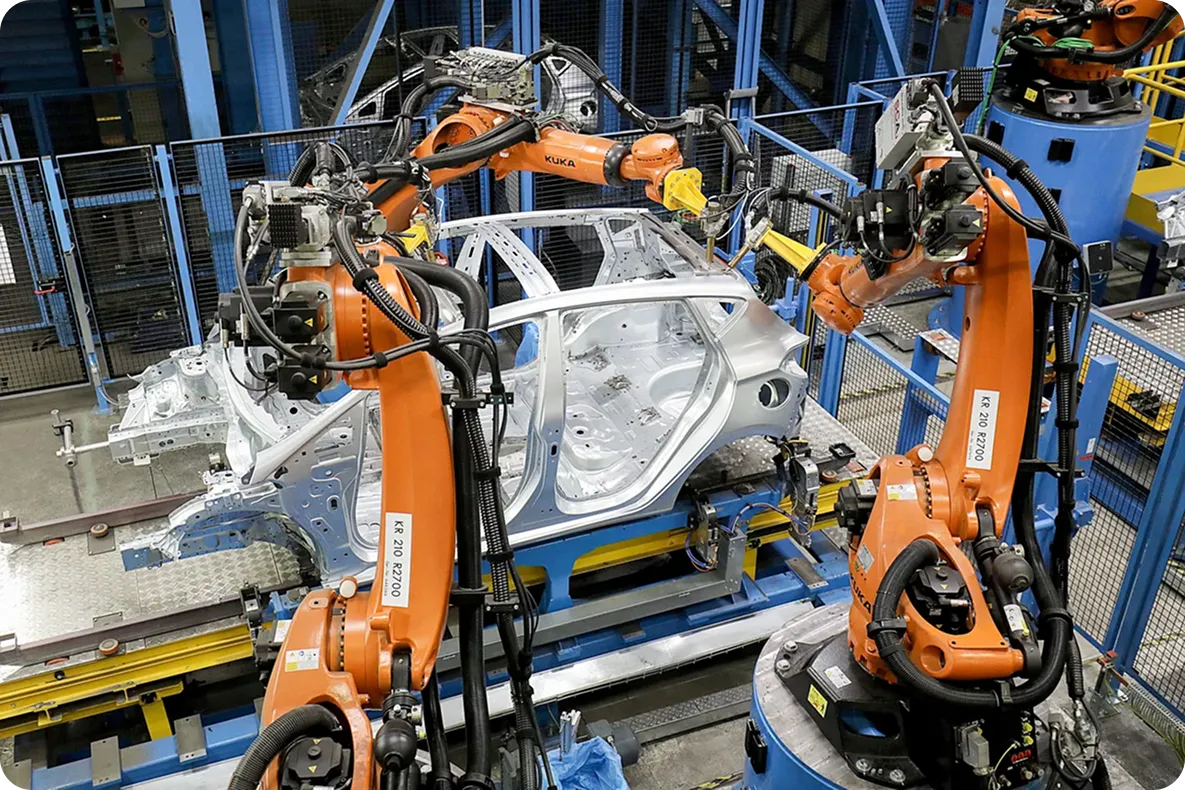

物体をピッキングして配置できるロボットは、製造業務の自動化とサプライチェーンの最適化において重要な役割を果たしています。それらの速度と精度により、アイテムの識別やソートなど、最小限の人的入力でタスクを実行できます。

YOLO11精密なインスタンス・セグメンテーションを使えば、ロボットアームを訓練して、ベルトコンベア上を移動する物体をdetect segment し、それらを正確にピックアップし、その種類とサイズに基づいて指定の場所に配置することができる。

例えば、一般的な自動車メーカーは、ビジョンベースのロボットを使用してさまざまな自動車部品を組み立て、組み立てラインの速度と精度を向上させています。YOLO11 ようなコンピュータビジョンモデルは、これらのロボットが人間の作業者と一緒に働くことを可能にし、ダイナミックな生産環境における自動化システムのシームレスな統合を保証します。この進歩は、生産時間の短縮、ミスの減少、製品の高品質化につながります。

YOLO11 、自律型ロボットシステムへのシームレスな統合に理想的な、いくつかの重要な利点があります。主な利点をいくつかご紹介しよう:

コンピュータビジョンモデルは、ロボットビジョンに強力なツールを提供しますが、それらを実際世界のロボットシステムに統合する際には、考慮すべきいくつかの制限があります。これらの制限には、以下が含まれます。

コンピュータビジョンシステムは、今日のロボットのツールであるだけでなく、ロボットが自律的に動作できる未来の構成要素でもあります。リアルタイムの検出能力と複数のタスクのサポートにより、次世代ロボット工学に最適です。

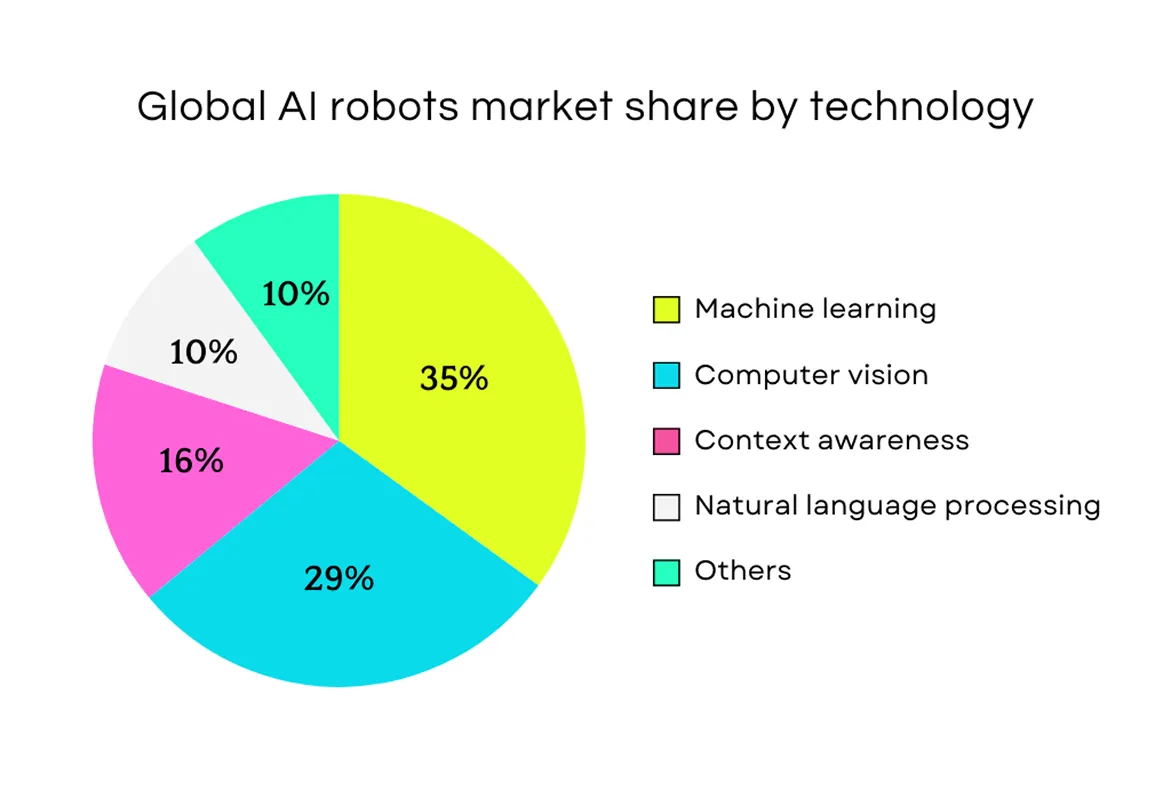

実際のところ、現在の市場動向は、コンピュータビジョンがロボット工学においてますます不可欠になっていることを示しています。業界レポートでは、コンピュータビジョンが世界のAIロボット市場で2番目に広く使用されている技術であることが強調されています。

リアルタイムの視覚データを処理する能力を持つYOLO11 、ロボットが周囲の環境をより正確にdetect、識別し、相互作用するのを助けることができる。これは、ロボットが人間と共同作業を行う製造業や、複雑な手術を支援するヘルスケアなどの分野で大きな違いをもたらす。

ロボット工学の進歩が続くにつれて、コンピュータビジョンをそのようなシステムに統合することは、ロボットがより効率的に幅広いタスクを処理できるようにするために不可欠になります。ロボット工学の未来は有望であり、AIとコンピュータビジョンがさらにスマートで適応性のあるマシンを推進しています。

AIについてさらに学ぶには、コミュニティにご参加いただき、GitHubリポジトリをご確認ください。ソリューションページでは、ヘルスケアにおけるAIや農業におけるコンピュータビジョンなど、AIのさまざまな応用例を紹介しています。独自のコンピュータビジョンソリューションを構築するには、ライセンスプランをご確認ください。

.webp)

.webp)