Por qué Ultralytics elimina NMS cómo eso cambia la implementación

Descubra cómo Ultralytics permite una inferencia verdadera de extremo a extremo NMS y por qué eliminar el posprocesamiento simplifica la exportación y la implementación en el borde.

Descubra cómo Ultralytics permite una inferencia verdadera de extremo a extremo NMS y por qué eliminar el posprocesamiento simplifica la exportación y la implementación en el borde.

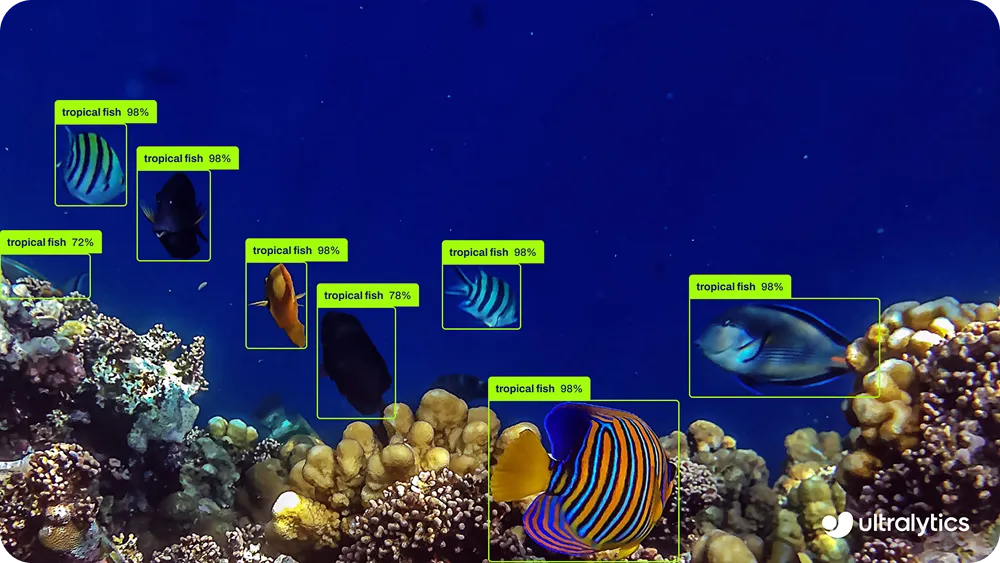

El 14 de enero lanzamos Ultralytics , la última generación de nuestros modelos de visión artificial. Con YOLO26, nuestro objetivo no era solo mejorar la precisión o la velocidad, sino replantearnos cómo se crean y se implementan los modelos de detección de objetos en los sistemas del mundo real.

A medida que la visión artificial pasa de la investigación a la producción, cada vez se espera más que los modelos se ejecuten en CPU, dispositivos periféricos, cámaras, robots y hardware integrado. En estos entornos, la fiabilidad, la baja latencia y la facilidad de implementación son tan importantes como el rendimiento.

YOLO26 se diseñó teniendo en cuenta esta realidad, utilizando una arquitectura optimizada de extremo a extremo que elimina la complejidad innecesaria del proceso de inferencia. Una de las innovaciones más importantes de YOLO26 es la eliminación de la supresión no máxima, comúnmente conocida como NMS.

Durante años, NMS sido una parte estándar de los sistemas de detección de objetos, utilizada como paso de posprocesamiento para limpiar las detecciones duplicadas. Aunque eficaz, también introdujo retos adicionales de cálculo y despliegue, especialmente en el hardware periférico.

Con YOLO26, adoptamos un enfoque diferente. Al replantearnos cómo se generan y entrenan las predicciones, hacemos posible una inferencia verdadera de extremo a extremo y NMS. El modelo produce detecciones finales directamente, sin depender de pasos de limpieza externos ni reglas creadas manualmente. Esto hace que YOLO26 sea más rápido, más fácil de exportar y más fiable para implementar en una amplia gama de plataformas de hardware.

En este artículo, analizaremos más detenidamente por qué la detección de objetos tradicional dependía del NMS, cómo se convirtió en un cuello de botella para la implementación y cómo YOLO26 elimina la necesidad de soluciones alternativas. ¡Empecemos!

Antes de profundizar en qué NMS y por qué lo eliminamos en YOLO26, demos un paso atrás y veamos cómo los modelos tradicionales de detección de objetos generan sus predicciones.

Los modelos tradicionales de detección de objetos suelen generar múltiples cuadros delimitadores superpuestos para un mismo objeto. Cada uno de estos cuadros tiene su propia puntuación de confianza, aunque todos se refieran al mismo objeto de la imagen.

Esto ocurre por varias razones. En primer lugar, el modelo realiza predicciones en muchas ubicaciones espaciales y a diferentes escalas al mismo tiempo. Esto ayuda al modelo detect de diferentes tamaños, pero también significa que las ubicaciones cercanas pueden identificar el mismo objeto de forma independiente.

En segundo lugar, muchos sistemas de detección de objetos utilizan enfoques basados en anclajes, que generan un gran número de cuadros candidatos alrededor de cada ubicación. Si bien esto mejora la posibilidad de encontrar objetos con precisión, también aumenta el número de predicciones superpuestas.

Por último, la detección basada en cuadrículas conduce naturalmente a la redundancia. Cuando un objeto se encuentra cerca del límite de varias celdas de la cuadrícula, varias celdas pueden predecir un recuadro para ese objeto, lo que da lugar a múltiples detecciones superpuestas.

Debido a esto, el resultado bruto del modelo suele contener varios recuadros para un solo objeto. Para que los resultados sean utilizables, es necesario filtrar estas predicciones redundantes de modo que solo quede una detección final.

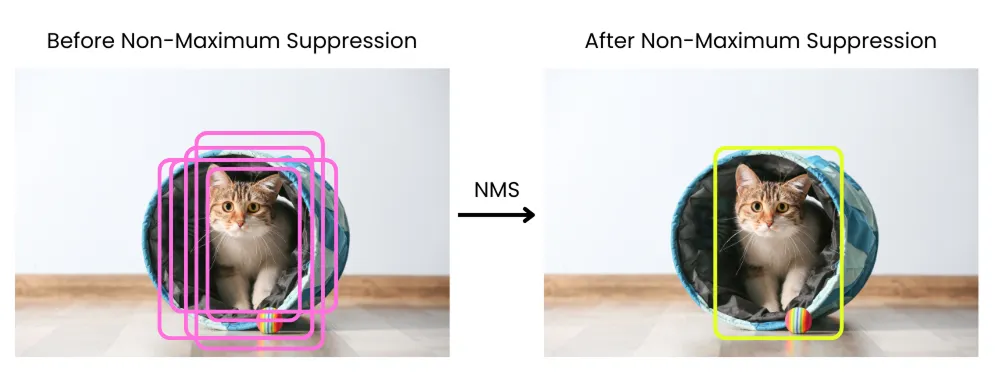

Cuando un modelo de detección de objetos produce varios recuadros delimitadores superpuestos para el mismo objeto, es necesario limpiar esos resultados antes de poder utilizarlos. Aquí es donde se aplica la supresión no máxima.

La supresión no máxima es un paso de posprocesamiento que se ejecuta después de que el modelo haya terminado de realizar sus predicciones. Su objetivo es reducir las detecciones duplicadas para que cada objeto esté representado por un único cuadro delimitador final.

El proceso funciona comparando los rectángulos delimitadores en función de sus puntuaciones de confianza y su grado de superposición. Las predicciones con una confianza muy baja se eliminan en primer lugar.

Las cajas restantes se clasifican por confianza y se selecciona la caja con la puntuación más alta como la mejor detección. Esa caja seleccionada se compara con las demás cajas.

Si otra caja se superpone demasiado con ella, esa caja se suprime y se elimina. La superposición se mide normalmente utilizando la intersección sobre la unión, una métrica que calcula la relación entre el área compartida por dos cajas y el área total cubierta por ambas. Este proceso se repite hasta que solo quedan las detecciones más fiables y sin superposición.

Si bien la supresión no máxima ayuda a filtrar las detecciones duplicadas, también plantea retos que se hacen más evidentes cuando los modelos pasan de la fase de investigación a la de implementación en el mundo real.

Uno de los mayores problemas es el rendimiento. NMS después de la inferencia y requiere comparar los cuadros delimitadores entre sí para decidir cuáles se conservan.

Este proceso es computacionalmente costoso y difícil de paralelizar de manera eficiente. En dispositivos periféricos y sistemas CPU, este trabajo adicional puede añadir una latencia notable, lo que dificulta el cumplimiento de los requisitos en tiempo real.

NMS aumenta la complejidad de la implementación. Dado que no forma parte del modelo en sí, debe implementarse por separado como código de posprocesamiento.

Los diferentes entornos de ejecución y plataformas gestionan NMS formas distintas, lo que a menudo implica mantener implementaciones personalizadas para cada entorno de destino. Lo que funciona en una configuración puede comportarse de forma ligeramente diferente en otra, lo que hace que la implementación sea más frágil y difícil de escalar.

La optimización del hardware es otro reto. NMS se adapta perfectamente a los aceleradores de IA especializados, que están diseñados para ejecutar operaciones de redes neuronales de manera eficiente. Como resultado, incluso cuando el modelo se ejecuta rápidamente en hardware optimizado, NMS convertirse en un cuello de botella que limita el rendimiento general.

Además de estos factores, NMS en parámetros seleccionados manualmente, como los umbrales de confianza y los umbrales de superposición. Estos ajustes pueden afectar significativamente a los resultados y, a menudo, es necesario adaptarlos a diferentes conjuntos de datos, aplicaciones o hardware. Esto hace que el comportamiento sea menos predecible en los sistemas de producción y añade una sobrecarga adicional de configuración.

Las limitaciones de la supresión no máxima nos llevaron a replantearnos cómo deberían comportarse los modelos de detección de objetos en el momento de la inferencia. En lugar de generar muchas predicciones superpuestas y limpiarlas después, nos planteamos una pregunta más fundamental.

¿Y si el modelo pudiera producir detecciones finales directamente? Esta pregunta es fundamental para la inferencia de detección de objetos de extremo a extremo. En un sistema de extremo a extremo, el modelo se entrena para gestionar todo el proceso de detección de principio a fin, sin depender de pasos de limpieza externos.

En lugar de producir muchas cajas candidatas y filtrarlas después de la inferencia, el modelo aprende a generar por sí mismo un pequeño conjunto de predicciones fiables y sin solapamientos. Las detecciones duplicadas se resuelven dentro de la red en lugar de eliminarse mediante un posprocesamiento.

Las arquitecturas de modelos más recientes demostraron que este enfoque era posible y práctico. Con la estrategia de entrenamiento adecuada, los modelos podían aprender a asociar cada objeto con una única predicción en lugar de con muchas predicciones contradictorias, lo que reducía la redundancia en su origen.

Para que esto funcione, la formación también tiene que cambiar. En lugar de permitir que muchas predicciones compitan por el mismo objeto, el modelo aprende a tomar una decisión clara, lo que da lugar a menos detecciones, pero más fiables.

El resultado general es un proceso de inferencia más sencillo. Dado que los duplicados ya se resuelven internamente, no es necesario aplicar la supresión no máxima en el momento de la inferencia. El resultado del modelo ya es el conjunto final de detecciones.

Este diseño integral también facilita la implementación. Sin pasos de posprocesamiento ni NMS específicas para cada plataforma, el modelo exportado es totalmente autónomo y se comporta de manera coherente en diferentes marcos de inferencia y objetivos de hardware.

Como explica nuestro ingeniero jefe de asociaciones, Francesco Mattioli, «el verdadero aprendizaje integral significa que el modelo debe gestionar todo, desde los píxeles hasta las predicciones, sin pasos de posprocesamiento manuales que rompan la diferenciabilidad y compliquen la implementación».

YOLO26 elimina la supresión no máxima cambiando la forma en que se aprenden y producen las detecciones, en lugar de depender del posprocesamiento para limpiarlas. En lugar de permitir que muchas predicciones compitan por el mismo objeto, YOLO26 está entrenado para aprender una relación clara uno a uno entre los objetos y los resultados.

Esto es posible en parte gracias a la detección basada en consultas aprendibles, que ayuda al modelo a centrarse en producir una única predicción fiable para cada objeto, en lugar de muchos candidatos superpuestos. Cada objeto se asocia a una predicción, lo que reduce de forma natural las detecciones duplicadas.

Este comportamiento se refuerza mediante estrategias de coincidencia coherentes durante el entrenamiento, lo que anima al modelo a tomar una decisión segura por objeto en lugar de generar predicciones superpuestas. En última instancia, el modelo produce menos predicciones, pero cada una de ellas representa una detección definitiva.

Otra innovación importante que permite la inferencia NMS en YOLO26 es la eliminación de la pérdida focal de distribución, o DFL. En YOLO anteriores, la DFL se utilizaba para mejorar la regresión del cuadro delimitador mediante la predicción de una distribución de posibles ubicaciones del cuadro en lugar de un único valor.

Si bien este enfoque mejoró la precisión de la localización, también añadió complejidad al proceso de detección. Esa complejidad se convirtió en una limitación a la hora de avanzar hacia una inferencia verdadera de extremo a extremo.

DFL introdujo cálculos adicionales y rangos de regresión fijos, lo que dificultó que el modelo aprendiera asignaciones de objetos limpias y uno a uno, y aumentó la dependencia de pasos de posprocesamiento como la supresión no máxima. Con YOLO26, eliminamos DFL y rediseñamos la regresión del cuadro delimitador para que fuera más simple y directa.

En lugar de basarse en resultados basados en la distribución, el modelo aprende a predecir coordenadas precisas de los recuadros de forma que se obtengan menos detecciones, pero más fiables. Este cambio ayuda a reducir las predicciones superpuestas en su origen y alinea la regresión de los recuadros delimitadores con el diseño integral y NMS de YOLO26.

El diseño NMS convierte a YOLO26 en un modelo verdaderamente integral. Esto tiene un impacto importante en la exportación de modelos.

Exportar significa convertir un modelo entrenado a un formato que se pueda ejecutar fuera del entorno de entrenamiento, como ONNX, TensorRT, CoreML u OpenVINO. En los procesos tradicionales, este proceso suele fallar porque la supresión no máxima no forma parte del modelo en sí.

Al eliminar NMS, YOLO26 evita este problema por completo. El modelo exportado ya incluye todo lo necesario para producir detecciones finales.

Esto hace que el modelo exportado sea totalmente autónomo y más portátil entre marcos de inferencia y objetivos de hardware. El mismo modelo se comporta de manera consistente, ya sea que se implemente en servidores, sistemas CPU, dispositivos integrados o aceleradores de borde. La implementación se vuelve más sencilla porque lo que se exporta es exactamente lo que se ejecuta.

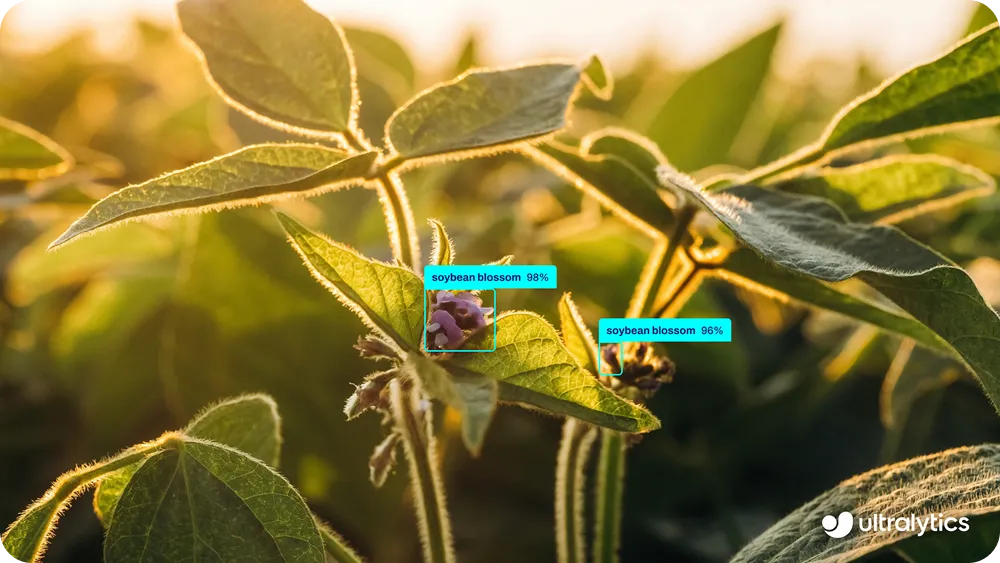

Esta simplicidad es especialmente importante para aplicaciones periféricas. Por ejemplo, YOLO26 se puede implementar fácilmente en dispositivos como drones para casos de uso tales como la supervisión de cultivos, la inspección de campos y el análisis de la salud de las plantas, donde los limitados presupuestos de computación y energía hacen que las complejas canalizaciones de posprocesamiento sean poco prácticas. Dado que el modelo genera directamente las detecciones finales, funciona de forma fiable en hardware ligero sin pasos de procesamiento adicionales.

En resumen, la inferencia NMS elimina las fricciones de la exportación y la implementación, y permite sistemas de visión más limpios y fiables. NMS una solución provisional. YOLO26 ya no necesita soluciones provisionales.

YOLO26 elimina la supresión no máxima (NMS) resolviendo el problema subyacente de las detecciones duplicadas, en lugar de limpiarlas a posteriori. Su diseño integral permite al modelo producir detecciones finales directamente, lo que simplifica la exportación y la implementación y las hace más coherentes en diferentes equipos. NMS una solución útil para los sistemas anteriores, pero YOLO26 ya no la necesita.

Únase a nuestra comunidad y consulte nuestro repositorio GitHub para obtener más información sobre la IA. Explore nuestras páginas de soluciones sobre IA en la agricultura y visión artificial en el comercio minorista. Descubra nuestras opciones de licencia y comience a utilizar Vision AI hoy mismo.