Despliegue de aplicaciones de visión artificial en dispositivos de IA perimetral

Descubra cómo Edge AI y las innovaciones de NVIDIA, como Jetson, Triton y TensorRT, están simplificando la implantación de aplicaciones de visión computerizada.

Descubra cómo Edge AI y las innovaciones de NVIDIA, como Jetson, Triton y TensorRT, están simplificando la implantación de aplicaciones de visión computerizada.

Gracias a los recientes avances en visión artificial e inteligencia artificial (IA), lo que antes era solo un campo de investigación ahora está impulsando aplicaciones impactantes en una variedad de industrias. Desde coches autónomos hasta imágenes médicas y seguridad, los sistemas de visión artificial están resolviendo problemas reales a escala.

Muchas de estas aplicaciones implican el análisis de imágenes y vídeo en tiempo real, y depender de la computación en la nube no siempre es práctico debido a la latencia, los costes y los problemas de privacidad. La IA en el Edge es una gran solución en estas situaciones. Al ejecutar modelos de IA visual directamente en dispositivos edge, las empresas pueden procesar los datos de forma más rápida, asequible y con mayor seguridad, lo que hace que la IA en tiempo real sea más accesible.

Durante YOLO Vision 2024 (YV24), el evento híbrido anual organizado por Ultralytics, uno de los temas centrales fue la democratización de Vision AI mediante una implantación más sencilla y eficiente. Guy Dahan, arquitecto sénior de soluciones de NVIDIA, habló sobre cómo las soluciones de hardware y software NVIDIA, incluidos los dispositivos de computación periférica, los servidores de inferencia, los marcos de optimización y los SDK de despliegue de IA, están ayudando a los desarrolladores a optimizar la IA periférica.

En este artículo, analizaremos los puntos clave de la ponencia de Guy Dahan en YV24 y cómo las últimas innovaciones de NVIDIAestán agilizando y haciendo más escalable la implantación de Vision AI.

Guy Dahan comenzó su intervención expresando su entusiasmo por unirse virtualmente al YV24 y su interés por el paquetePython Ultralytics ylos modelosYOLO Ultralytics , afirmando: "Llevo utilizando Ultralytics desde el día en que salió al mercado. Me gusta mucho Ultralytics ; ya antes utilizaba YOLOv5 , y soy un verdadero entusiasta de este paquete".

Luego, introdujo el concepto de Edge AI, explicando que implica ejecutar cálculos de IA directamente en dispositivos como cámaras, drones o máquinas industriales, en lugar de enviar datos a servidores en la nube distantes para su procesamiento.

En lugar de esperar a que las imágenes o los vídeos se carguen, se analicen y luego se envíen de vuelta con los resultados, Edge AI hace posible analizar los datos al instante en el propio dispositivo. Esto hace que los sistemas de Vision AI sean más rápidos, eficientes y menos dependientes de la conectividad a Internet. Edge AI es particularmente útil para aplicaciones de toma de decisiones en tiempo real, como coches autónomos, cámaras de seguridad y fábricas inteligentes.

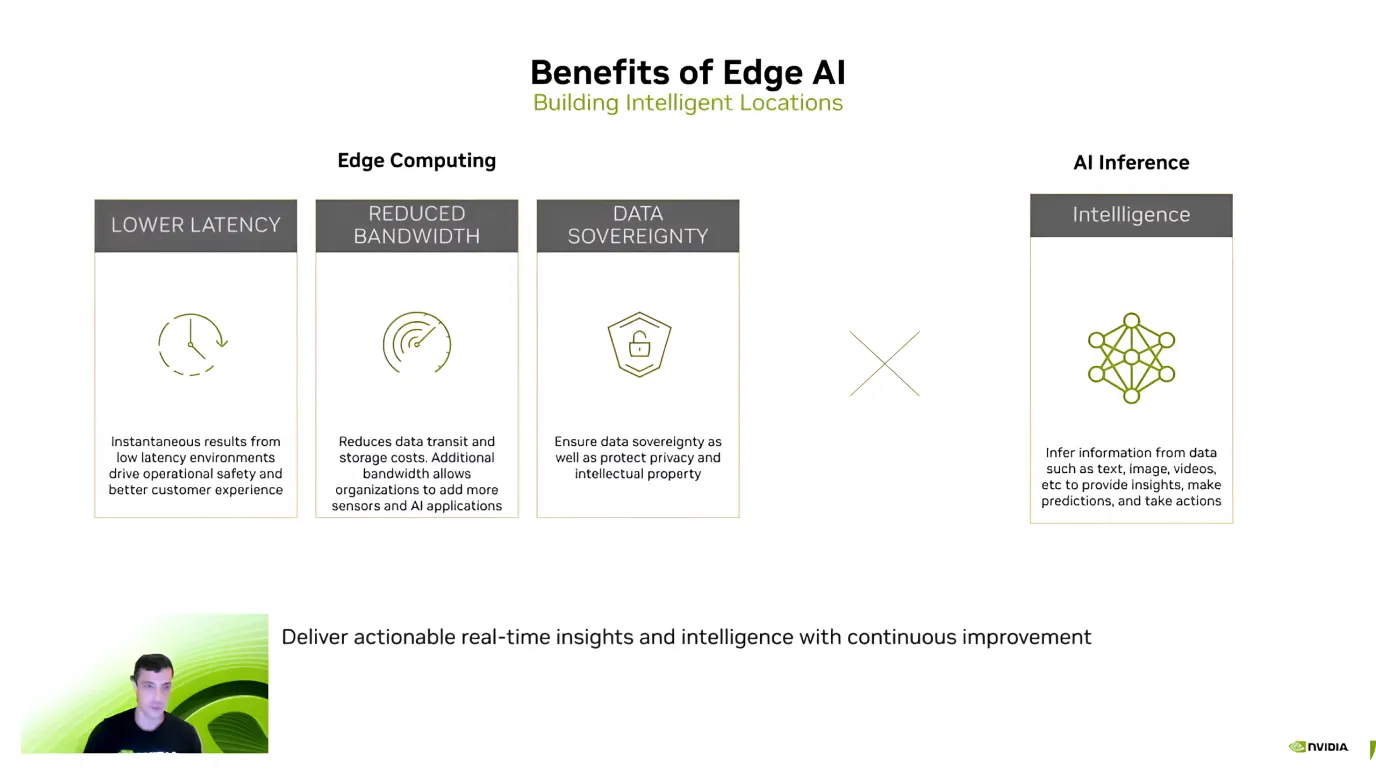

Después de presentar Edge AI, Guy Dahan destacó sus principales ventajas, centrándose en la eficiencia, el ahorro de costes y la seguridad de los datos. Explicó que una de las mayores ventajas es la baja latencia, ya que los modelos de IA procesan los datos directamente en el dispositivo, por lo que no es necesario enviar información a la nube y esperar una respuesta.

Edge AI también ayuda a reducir costes y a proteger los datos confidenciales. El envío de grandes cantidades de datos a la nube, especialmente flujos de vídeo, puede resultar caro. Sin embargo, procesarlos localmente reduce los costes de ancho de banda y almacenamiento.

Otra ventaja clave es la privacidad de los datos porque la información permanece en el dispositivo en lugar de ser transferida a un servidor externo. Esto es particularmente importante para las aplicaciones de atención médica, finanzas y seguridad, donde mantener los datos locales y seguros es una prioridad máxima.

Basándose en estas ventajas, Guy Dahan comentó la creciente adopción de Edge AI. Señaló que desde que NVIDIA introdujo Jetson en 2014, su uso se ha multiplicado por diez. En la actualidad, más de 1,2 millones de desarrolladores trabajan con dispositivos Jetson.

A continuación, Guy Dahan se centró en los dispositivosNVIDIA Jetson, una familia de dispositivos de inteligencia artificial diseñados para ofrecer un alto rendimiento con un bajo consumo de energía. Los dispositivos Jetson son ideales para aplicaciones de visión computerizada en sectores como la robótica, la agricultura, la sanidad y la automatización industrial. "Los Jetson son dispositivos Edge AI hechos específicamente a medida para la IA. Incluso podría añadir que originalmente se diseñaron sobre todo para visión por ordenador", añadió Guy Dahan.

Los dispositivos Jetson vienen en tres niveles, cada uno adecuado para diferentes necesidades:

Además, Guy Dahan habló del próximo Jetson AGX Thor, que se lanzará este año, y dijo que ofrecerá ocho veces más rendimiento de GPU (unidad de procesamiento gráfico), el doble de capacidad de memoria y un rendimiento mejorado de CPU (unidad central de procesamiento). Está diseñado específicamente para robótica humanoide y aplicaciones avanzadas de inteligencia artificial Edge.

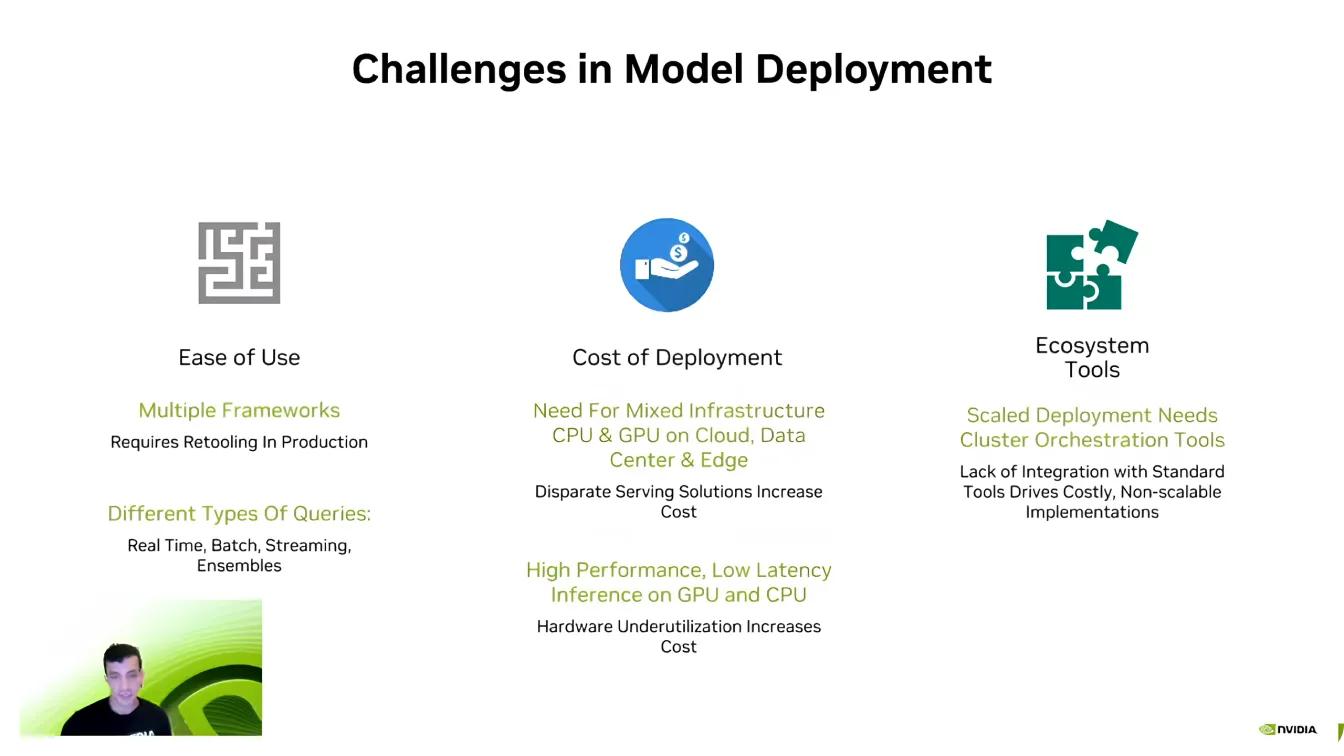

Guy Dahan pasó a hablar del lado del software de Edge AI y explicó que, incluso con un hardware potente, la implementación eficiente de modelos puede ser un reto.

Uno de los mayores obstáculos es la compatibilidad, ya que los desarrolladores de IA suelen trabajar con diferentes marcos de IA como PyTorch y TensorFlow. Pasar de un marco a otro puede resultar complicado, ya que los desarrolladores tienen que volver a crear entornos para asegurarse de que todo funciona correctamente.

La escalabilidad es otro desafío clave. Los modelos de IA requieren una potencia de cálculo significativa, y como dijo Dahan, "Nunca ha habido una empresa de IA que quiera menos capacidad de cálculo". La expansión de las aplicaciones de IA en múltiples dispositivos puede volverse rápidamente costosa, lo que hace que la optimización sea esencial.

Además, los pipelines de IA son complejos y a menudo implican diferentes tipos de datos, procesamiento en tiempo real e integración de sistemas. Los desarrolladores se esfuerzan mucho en asegurarse de que sus modelos interactúan a la perfección con los ecosistemas de software existentes. Superar estos retos es una parte crucial para que las implementaciones de la IA sean más eficientes y escalables.

A continuación, Guy Dahan centró su atención en el servidor de inferenciaTriton de NVIDIA. Señaló que muchas empresas y startups empiezan a desarrollar IA sin optimizar completamente sus modelos. Rediseñar todo un proceso de IA desde cero puede ser perturbador y llevar mucho tiempo, lo que dificulta una escalabilidad eficiente.

En lugar de requerir una revisión completa del sistema, Triton permite a los desarrolladores refinar y optimizar gradualmente sus flujos de trabajo de IA, integrando componentes más eficientes sin romper su configuración existente. Gracias a la compatibilidad con varios marcos de IA, como TensorFlow, PyTorch, ONNX y TensorRT, Triton permite una implantación perfecta en entornos de nube, centros de datos y dispositivos periféricos con ajustes mínimos.

Estas son algunas de las principales ventajas del servidor de inferencia Triton de NVIDIA:

Supongamos que buscas aún más aceleración; NVIDIA TensorRT es una opción interesante para optimizar tus modelos de IA. Guy Dahan explica que TensorRT es un optimizador de aprendizaje profundo de alto rendimiento creado para las GPU NVIDIA . TensorRT permite convertir modelos de TensorFlow, PyTorch, ONNX y MXNet en archivos GPU de alta eficiencia.

Lo que hace que TensorRT sea tan fiable son sus optimizaciones específicas para cada hardware. Un modelo optimizado para dispositivos Jetson no funcionará con la misma eficiencia en otras GPU porque TensorRT ajusta el rendimiento en función del hardware de destino. Un modelo de visión computerizada optimizado puede multiplicar por 36 la velocidad de inferencia en comparación con modelos no optimizados.

Guy Dahan también llamó la atención sobre la compatibilidad de Ultralytics con TensorRT y habló de cómo agiliza y hace más eficiente la implantación de modelos de IA. Los modelosYOLO Ultralytics pueden exportarse directamente al formato TensorRT , lo que permite a los desarrolladores optimizarlos para las GPU NVIDIA sin necesidad de realizar ningún cambio.

Para concluir, Guy Dahan presentó DeepStream 7.0, un marco de IA diseñado para procesar datos de vídeo, audio y sensores en tiempo real utilizando las GPU NVIDIA . Diseñado para aplicaciones de visión computerizada de alta velocidad, permite la detección, el seguimiento y el análisis de objetos en sistemas autónomos, seguridad, automatización industrial y ciudades inteligentes. Al ejecutar la IA directamente en los dispositivos periféricos, DeepStream elimina la dependencia de la nube, lo que reduce la latencia y mejora la eficiencia.

Específicamente, DeepStream puede gestionar el procesamiento de vídeo impulsado por IA de principio a fin. Admite flujos de trabajo integrales, desde la decodificación y el preprocesamiento de vídeo hasta la inferencia de IA y el postprocesamiento.

Recientemente, DeepStream ha introducido varias actualizaciones para mejorar la implementación de la IA, haciéndola más accesible y escalable. Las nuevas herramientas simplifican el desarrollo, mejoran el seguimiento multicámara y optimizan los pipelines de IA para un mejor rendimiento.

Los desarrolladores ahora tienen un soporte ampliado para entornos Windows, capacidades mejoradas de fusión de sensores para integrar datos de múltiples fuentes y acceso a aplicaciones de referencia preconstruidas para acelerar la implementación. Estas mejoras hacen de DeepStream una solución más flexible y eficiente para aplicaciones de IA en tiempo real, lo que ayuda a los desarrolladores a escalar el análisis de vídeo inteligente con facilidad.

Como se ilustró en la presentación principal de Guy Dahan en YV24, Edge AI está redefiniendo las aplicaciones de visión artificial. Con los avances en hardware y software, el procesamiento en tiempo real se está volviendo más rápido, más eficiente y rentable.

A medida que más industrias adoptan Edge AI, abordar desafíos como la fragmentación y la complejidad de la implementación será clave para desbloquear todo su potencial. Adoptar estas innovaciones impulsará aplicaciones de IA más inteligentes y receptivas, dando forma al futuro de la visión artificial.

¡Forme parte de nuestra creciente comunidad! Explore nuestro repositorio de GitHub para obtener más información sobre la IA, y consulte nuestras opciones de licencia para poner en marcha sus proyectos de Visión Artificial. ¿Tiene curiosidad por las innovaciones como la IA en la sanidad y la visión artificial en la fabricación? Visite nuestras páginas de soluciones para obtener más información.