¿Qué es la correspondencia de imágenes en Vision AI? Una breve introducción

Aprenda cómo funciona la correspondencia de imágenes en Vision AI y explore las tecnologías básicas que ayudan a las máquinas a detect, comparar y comprender datos visuales.

Aprenda cómo funciona la correspondencia de imágenes en Vision AI y explore las tecnologías básicas que ayudan a las máquinas a detect, comparar y comprender datos visuales.

Cuando se observan dos imágenes del mismo objeto, como un cuadro y una fotografía de un coche, es fácil darse cuenta de lo que tienen en común. Sin embargo, en el caso de las máquinas no es tan sencillo.

Para realizar estas comparaciones, las máquinas recurren a la visión por ordenador, una rama de la inteligencia artificial (IA) que les ayuda a interpretar y comprender la información visual. La visión por ordenador permite a los sistemas detect objetos, comprender escenas y extraer patrones de imágenes o vídeos.

En concreto, algunas tareas visuales van más allá del análisis de una sola imagen. Consisten en comparar imágenes para encontrar similitudes, detectar diferencias o track cambios a lo largo del tiempo.

La IA de visión abarca un amplio conjunto de técnicas, y una capacidad esencial, conocida como correspondencia de imágenes, se centra en identificar similitudes entre imágenes, incluso cuando la iluminación, los ángulos o los fondos varían. Esta técnica puede utilizarse en diversas aplicaciones, como la robótica, la realidad aumentada y la cartografía geográfica.

En este artículo exploraremos qué es la correspondencia de imágenes, sus técnicas básicas y algunas de sus aplicaciones en el mundo real. Empecemos.

La comparación de imágenes permite que un sistema informático comprenda si dos imágenes tienen un contenido similar. Los humanos pueden hacerlo de forma intuitiva fijándose en formas, colores y patrones.

Los ordenadores, en cambio, se basan en datos numéricos. Analizan las imágenes investigando cada píxel, que es la unidad más pequeña de una imagen digital.

Cada imagen se almacena como una cuadrícula de píxeles, y cada píxel suele contener valores de rojo, verde y azul (RGB). Estos valores pueden cambiar al girar una imagen, cambiar su tamaño, verla desde un ángulo distinto o capturarla en condiciones de iluminación diferentes. Debido a estas variaciones, comparar imágenes píxel a píxel suele ser poco fiable.

Para que las comparaciones sean más coherentes, la comparación de imágenes se centra en características locales o esquinas, bordes y regiones con textura que tienden a permanecer estables incluso cuando una imagen cambia ligeramente. Al detectar estas características, o puntos clave, en varias imágenes, un sistema puede compararlas con mucha más precisión.

Este proceso se utiliza ampliamente en casos de uso como la navegación, la localización, la realidad aumentada, la cartografía, la reconstrucción 3D y la búsqueda visual. Cuando los sistemas identifican los mismos puntos en diferentes imágenes o múltiples fotogramas, pueden track movimiento, comprender la estructura de la escena y tomar decisiones fiables en entornos dinámicos.

La correspondencia de imágenes implica varios pasos clave que ayudan a los sistemas a identificar y comparar regiones similares dentro de las imágenes. Cada paso mejora la precisión, la coherencia y la solidez en distintas condiciones.

A continuación se explica paso a paso cómo funciona la correspondencia de imágenes:

Antes de explorar las aplicaciones reales de la correspondencia de imágenes, veamos con más detalle las técnicas de correspondencia de imágenes utilizadas en los sistemas de visión por ordenador.

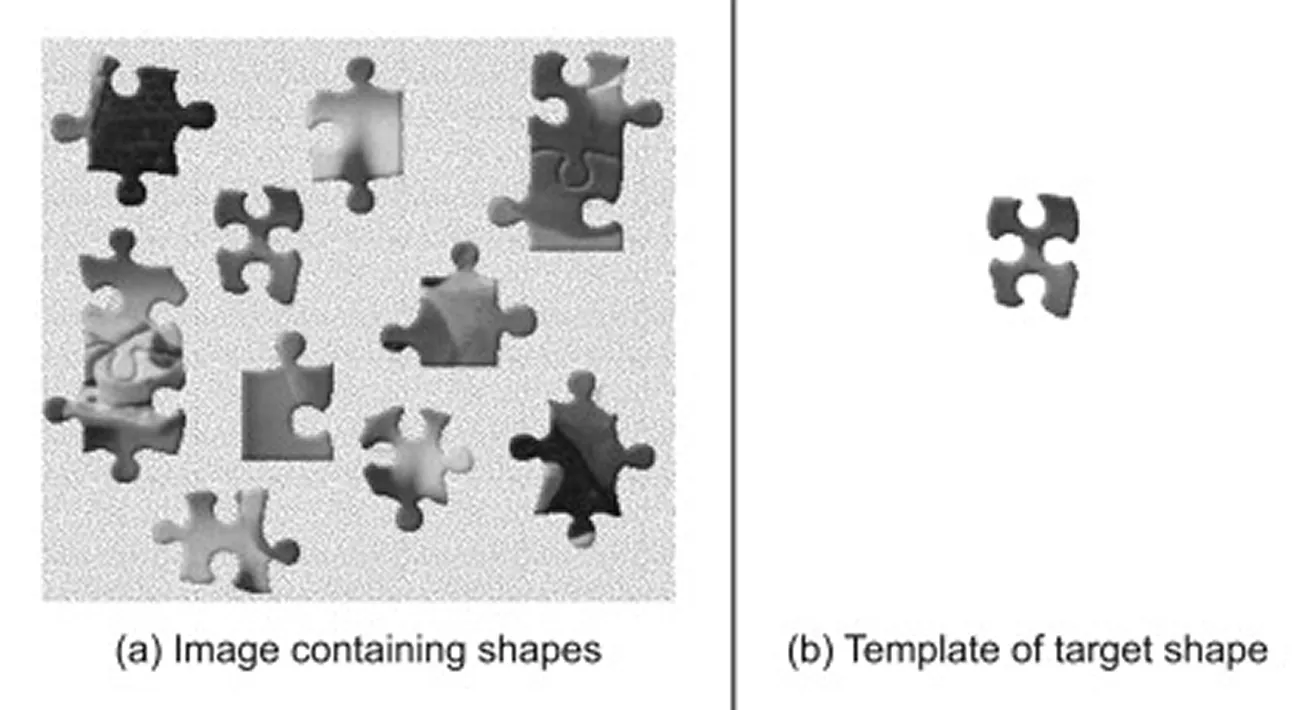

La comparación de plantillas es uno de los métodos más sencillos de comparación de imágenes. Suele considerarse una técnica de tratamiento de imágenes más que un método moderno de visión por ordenador, porque se basa en comparaciones directas de píxeles y no extrae características visuales más profundas.

Se utiliza para localizar una imagen de referencia más pequeña, o plantilla, dentro de una escena mayor. Funciona mediante un algoritmo que desliza una plantilla por la imagen principal y calcula una puntuación de similitud en cada posición para medir el grado de coincidencia entre las dos regiones. El área con la puntuación más alta se considera la mejor coincidencia, indicando dónde es más probable que aparezca el objeto en la escena.

Esta técnica funciona bien cuando la escala, la rotación y la iluminación del objeto se mantienen constantes, lo que la convierte en una buena opción para entornos controlados o comparaciones de referencia. Sin embargo, su rendimiento disminuye cuando el objeto tiene un aspecto diferente al de la plantilla, como cuando cambia de tamaño, está girado, parcialmente ocluido o aparece sobre un fondo ruidoso o complejo.

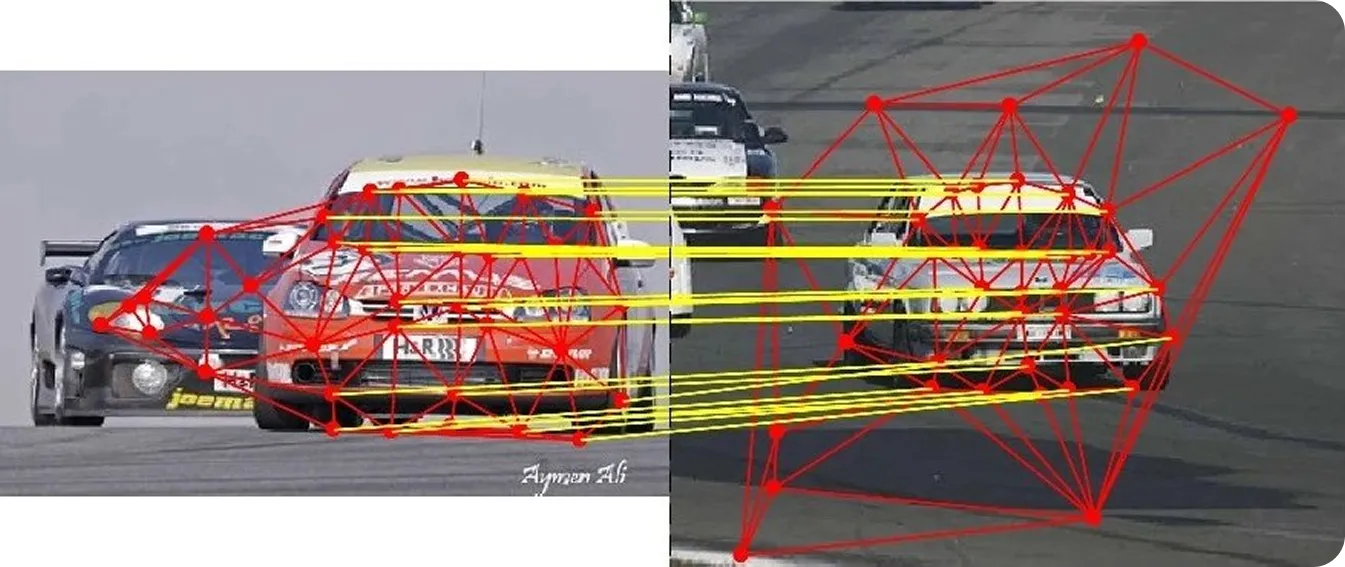

Antes de que se generalizara el aprendizaje profundo, la comparación de imágenes se basaba principalmente en algoritmos clásicos de visión por ordenador que detectaban puntos clave distintivos en una imagen. En lugar de comparar cada píxel, estos métodos analizan los gradientes de la imagen, o cambios en la intensidad, para resaltar esquinas, bordes y regiones con textura que destacan.

Cada punto clave detectado se representa mediante un resumen numérico compacto denominado descriptor. Al comparar dos imágenes, un emparejador evalúa estos descriptores para encontrar los pares más similares.

Una puntuación de similitud elevada suele indicar que en ambas imágenes aparece el mismo punto físico. Los comparadores también utilizan métricas de distancia específicas o reglas de puntuación para juzgar el grado de alineación de las características, lo que mejora la fiabilidad general.

Estos son algunos de los principales algoritmos clásicos de visión por ordenador utilizados para la comparación de imágenes:

A diferencia de los métodos clásicos que se basan en reglas específicas, el aprendizaje profundo aprende automáticamente características a partir de grandes conjuntos de datos, que son colecciones de datos visuales de las que los modelos de IA aprenden patrones. Estos modelos suelen ejecutarse en GPU (unidades de procesamiento gráfico), que proporcionan la gran potencia de cálculo necesaria para procesar grandes lotes de imágenes y entrenar redes neuronales complejas de forma eficiente.

De este modo, los modelos de IA pueden gestionar cambios del mundo real como la iluminación, los ángulos de cámara y las oclusiones. Algunos modelos también combinan todos los pasos en un único flujo de trabajo, lo que permite un rendimiento sólido en condiciones difíciles.

A continuación se presentan algunos enfoques basados en el aprendizaje profundo para la extracción y correspondencia de características de imágenes:

Ahora que entendemos mejor cómo funciona la correspondencia de imágenes, veamos algunas aplicaciones del mundo real en las que desempeña un papel importante.

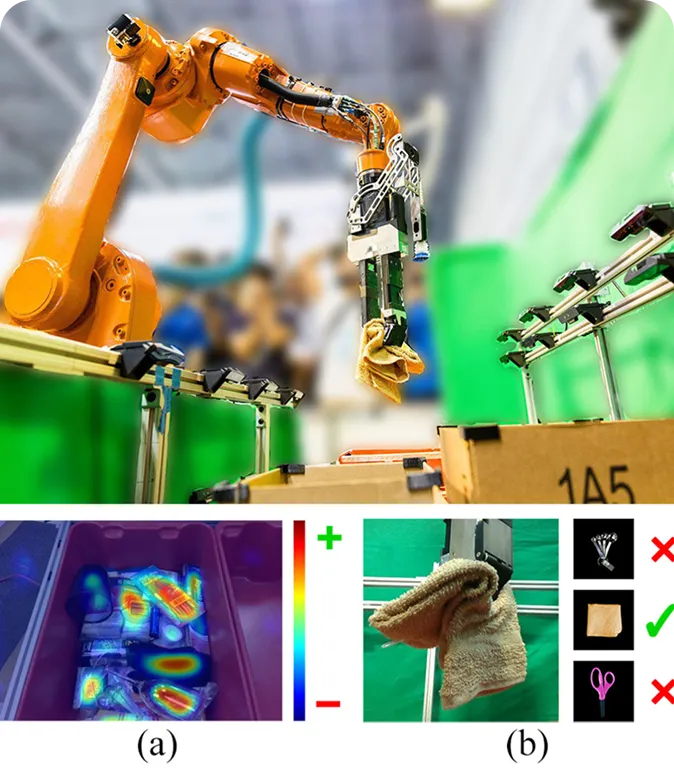

Los robots operan a menudo en entornos ajetreados y cambiantes, en los que necesitan comprender qué objetos están presentes y cómo están colocados. La correspondencia de imágenes puede ayudar a los robots a comprender los objetos que ven comparándolos con imágenes almacenadas o de referencia. Esto facilita a estos robots el reconocimiento de objetos, el track sus movimientos y la adaptación incluso cuando cambian la iluminación o los ángulos de la cámara.

Por ejemplo, en un almacén, un sistema robotizado de recogida y colocación puede utilizar la comparación de imágenes para identificar y manipular distintos artículos. El robot coge primero un objeto y luego compara su imagen con muestras de referencia para identificarlo.

Una vez encontrada la coincidencia, el robot sabe cómo ordenarlo o colocarlo correctamente. Este enfoque permite a los robots reconocer tanto objetos conocidos como nuevos sin necesidad de volver a entrenar todo el sistema. También les ayuda a tomar mejores decisiones en tiempo real, como organizar estanterías, ensamblar piezas o reordenar objetos.

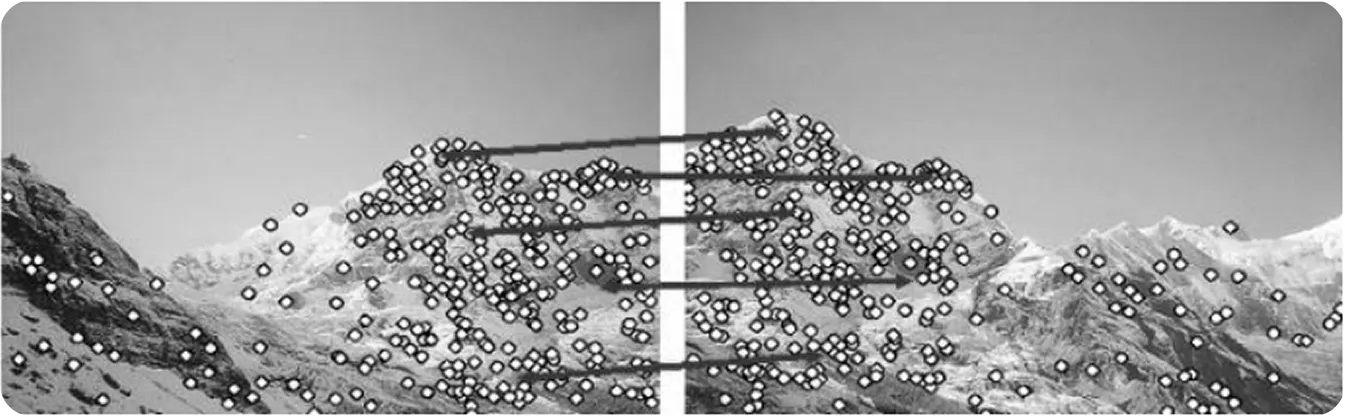

En ámbitos como la cartografía con drones, la realidad virtual y la inspección de edificios, los sistemas a menudo necesitan reconstruir un modelo 3D a partir de varias imágenes 2D. Para ello, se basan en la comparación de imágenes para identificar puntos clave comunes, como esquinas o regiones con textura, que aparecen en varias imágenes.

Estos puntos compartidos ayudan al sistema a comprender cómo se relacionan las imágenes entre sí en el espacio tridimensional. Esta idea está estrechamente relacionada con la Estructura a partir del Movimiento (SfM), una técnica que construye estructuras 3D identificando y emparejando puntos clave entre imágenes capturadas desde distintos puntos de vista.

Si la correspondencia no es exacta, el modelo 3D resultante puede aparecer distorsionado o incompleto. Por este motivo, los investigadores se han esforzado por mejorar la fiabilidad de la comparación de imágenes para la reconstrucción 3D, y los últimos avances han arrojado resultados prometedores.

Un ejemplo interesante es HashMatch, un algoritmo de comparación de imágenes más rápido y robusto. HashMatch convierte los detalles de la imagen en patrones compactos llamados códigos hash, lo que facilita la identificación de coincidencias correctas y la eliminación de valores atípicos, incluso cuando la iluminación o los puntos de vista varían.

Cuando se probó en conjuntos de datos a gran escala, HashMatch produjo modelos de reconstrucción 3D más limpios y realistas, con menos errores de alineación. Esto lo hace especialmente útil para aplicaciones como la cartografía con drones, los sistemas de realidad aumentada y la conservación del patrimonio cultural, donde la precisión es fundamental.

Cuando se trata de realidad aumentada (RA), mantener los objetos virtuales alineados con el mundo real suele ser un reto. Los entornos exteriores pueden cambiar constantemente en función de las condiciones ambientales, como la luz solar y el clima. Sutiles diferencias en el mundo real pueden hacer que los elementos virtuales parezcan inestables o ligeramente fuera de lugar.

Para resolver este problema, los sistemas de realidad aumentada utilizan la comparación de imágenes para interpretar su entorno. Comparando los fotogramas de la cámara en directo con las imágenes de referencia almacenadas, pueden comprender dónde se encuentra el usuario y cómo ha cambiado la escena.

Por ejemplo, en un estudio sobre entrenamiento militar de realidad aumentada al aire libre con gafas XR (Extended Reality), los investigadores utilizaron SIFT y otros métodos basados en características para emparejar detalles visuales entre imágenes reales y de referencia. Las coincidencias precisas mantenían los elementos virtuales correctamente alineados con el mundo real, incluso cuando el usuario se movía rápidamente o cambiaba la iluminación.

La correspondencia de imágenes es un componente esencial de la visión por ordenador, que permite a los sistemas comprender cómo se relacionan distintas imágenes entre sí o cómo cambia una escena a lo largo del tiempo. Desempeña un papel fundamental en robótica, realidad aumentada, reconstrucción 3D, navegación autónoma y muchas otras aplicaciones del mundo real en las que la precisión y la estabilidad son esenciales.

Con modelos de IA avanzados como SuperPoint y LoFTR, los sistemas actuales son mucho más robustos que los métodos anteriores. A medida que avancen las técnicas de aprendizaje automático, los módulos de visión especializados, las redes neuronales y los conjuntos de datos, es probable que la comparación de imágenes sea más rápida, precisa y adaptable.

Únase a nuestra creciente comunidad y explore nuestro repositorio GitHub para obtener recursos prácticos de IA. Para construir con Vision AI hoy mismo, explore nuestras opciones de licencia. Descubra cómo la IA en agricultura está transformando la agricultura y cómo Vision AI en sanidad está dando forma al futuro visitando nuestras páginas de soluciones.