Comprendre la précision moyennemAP dans la détection d'objets. Apprenez sa signification, son calcul et pourquoi la mAP est essentielle pour évaluer les performances d'un modèle.

Comprendre la précision moyennemAP dans la détection d'objets. Apprenez sa signification, son calcul et pourquoi la mAP est essentielle pour évaluer les performances d'un modèle.

L'adoption de l'IA croît rapidement et l'IA est intégrée à diverses innovations, des voitures autonomes aux systèmes de vente au détail capables d'identifier les produits sur une étagère. Ces technologies reposent sur la vision par ordinateur, une branche de l'intelligence artificielle (IA) qui permet aux machines d'analyser les données visuelles.

La précision moyennemAP est un paramètre d'évaluation clé utilisé pour mesurer la précision des systèmes et algorithmes de vision artificielle. La précision moyenne mAP indique dans quelle mesure les prédictions d'un modèle d'IA de vision correspondent aux résultats du monde réel.

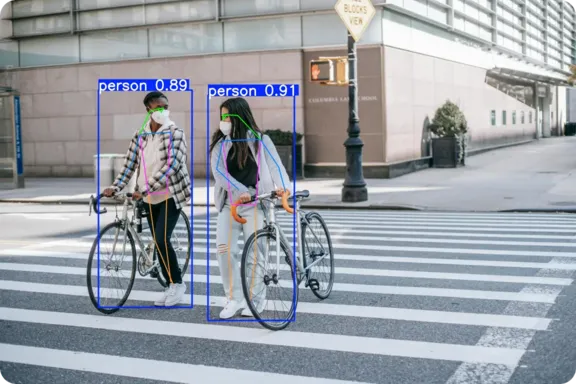

Une tâche courante de vision par ordinateur est la détection d'objets, où un modèle identifie plusieurs objets dans une image et dessine des boîtes de délimitation autour d'eux. mAP est la métrique standard utilisée pour évaluer la performance des modèles de détection d'objets et est largement utilisée pour comparer les modèles d'apprentissage profond tels que les modèles de détection d'objets et les modèles de détection d'objets. Ultralytics YOLO11.

Dans cet article, nous verrons comment la précision moyenne est calculée et pourquoi elle est essentielle pour quiconque entraîne ou évalue des modèles de détection d'objets. Commençons !

La précision moyenne est un score qui indique la précision d'un modèle d'apprentissage profond pour les tâches liées à la recherche d'informations visuelles, comme la détection et l'identification de différents objets dans une image. Prenons l'exemple d'un modèle de détection d'objets qui analyse une photo contenant un chien, un chat et une voiture. Un modèle fiable peut effectuer une détection d'objets en reconnaissant chaque objet et en dessinant des boîtes englobantes et des étiquettes autour de celui-ci, en indiquant où il se trouve et ce qu'il est.

mAP indique dans quelle mesure le modèle exécute cette tâche sur de nombreuses images et pour différents types d'objets. Il vérifie si le modèle identifie correctement chaque objet et son emplacement dans l'image. Le score va de 0 à 1, où 1 signifie que le modèle a parfaitement trouvé tous les objets, et où 0 signifie qu'il n'a detect aucun objet.

Avant d'explorer les concepts qui sous-tendent la précision moyenne moyenne en apprentissage automatique, essayons de mieux comprendre deux termes de base : la vérité terrain et les prédictions.

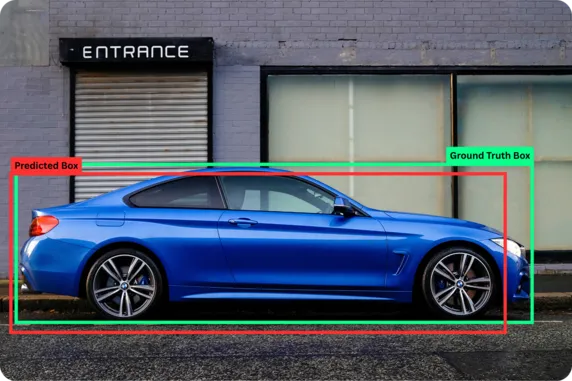

La vérité terrain désigne les données de référence exactes, où les objets et leurs emplacements dans l'image sont soigneusement étiquetés par des humains grâce à un processus appelé annotation. Pendant ce temps, les prédictions sont les résultats que les modèles d'IA donnent après avoir analysé une image. En comparant les prédictions du modèle d'IA à la vérité terrain, nous pouvons mesurer la précision des résultats obtenus par le modèle.

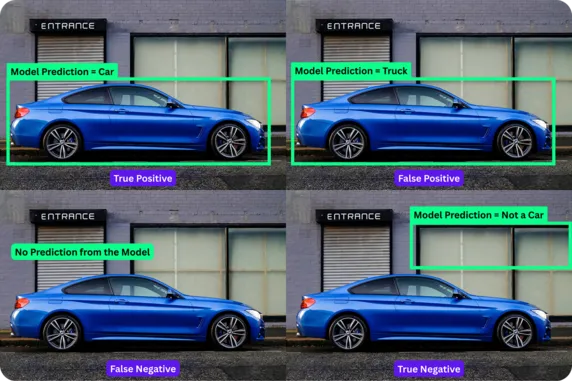

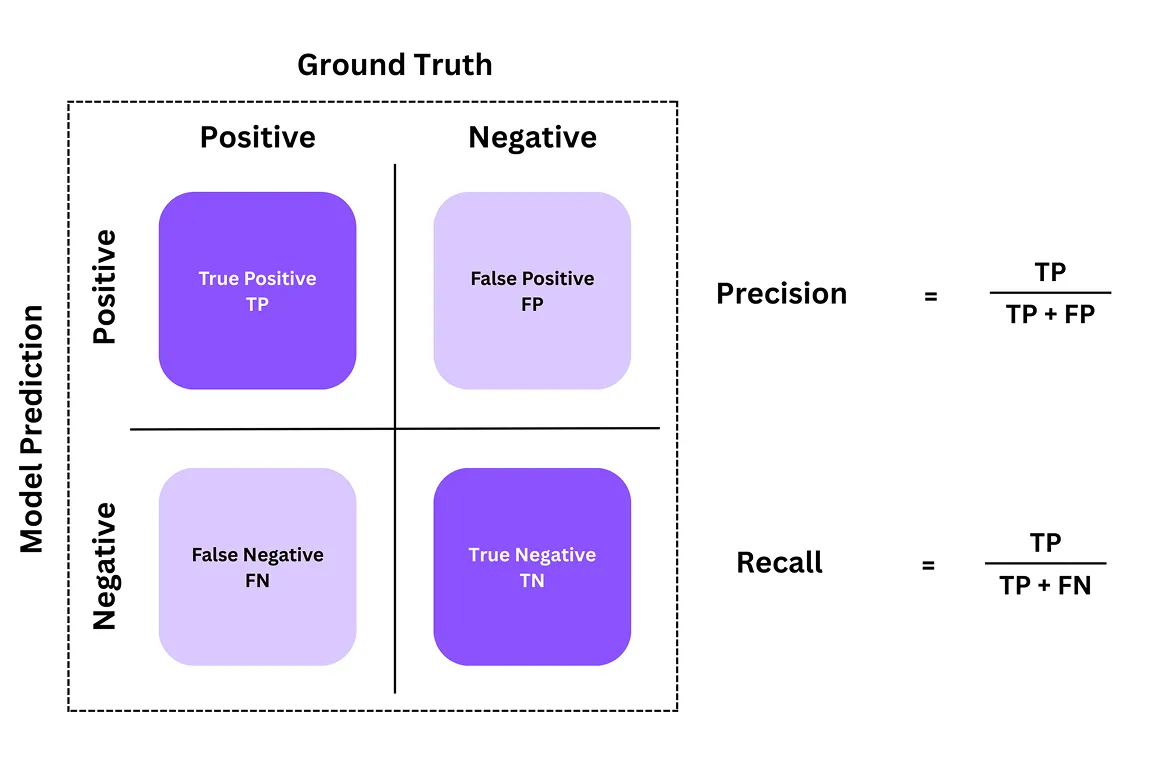

Une matrice de confusion est souvent utilisée pour comprendre la précision d'un modèle de détection d'objets. Il s'agit d'un tableau qui montre comment les prédictions du modèle correspondent aux réponses correctes réelles (vérité terrain). À partir de ce tableau, nous pouvons obtenir une ventilation de quatre composantes ou résultats clés : les vrais positifs, les faux positifs, les faux négatifs et les vrais négatifs.

Voici ce que ces composantes représentent dans la matrice de confusion :

Les vrais négatifs ne sont pas couramment utilisés dans la détection d'objets, car nous ignorons généralement les nombreuses régions vides d'une image. Cependant, ils sont essentiels dans d'autres tâches de vision artificielle, telles que la classification d'images, où le modèle attribue une étiquette à l'image. Par exemple, si la tâche consiste à detect si une image contient un chat ou non, et que le modèle identifie correctement "pas de chat" lorsque l'image n'en contient pas, il s'agit d'un vrai négatif.

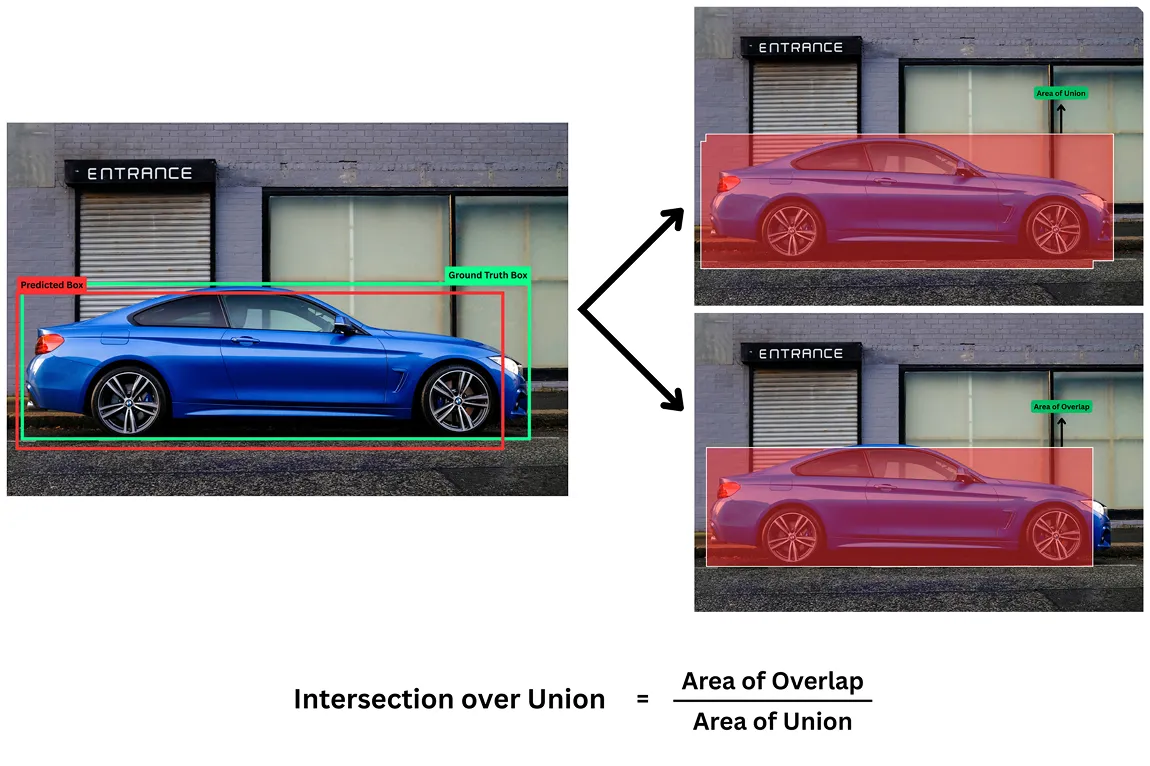

Une autre mesure essentielle dans l'évaluation des modèles de détection d'objets est l' intersection sur l'unionIoU). Pour ces modèles d'IA visionnaire, il ne suffit pas de détecter la présence d'un objet dans une image ; il faut aussi localiser l'endroit où il se trouve dans l'image pour dessiner des boîtes de délimitation.

L'indicateur d'IoU mesure le degré de correspondance entre la boîte prédite par le modèle et la boîte réelle et correcte (vérité de terrain). Le score est compris entre 0 et 1, où 1 signifie une correspondance parfaite et 0 signifie qu'il n'y a aucun chevauchement.

Par exemple, un IoU élevé (comme 0,80 ou 0,85) signifie que la boîte prédite est proche de la boîte de vérité au sol, ce qui indique une localisation précise. Un IoU inférieur (comme 0,30 ou 0,25) signifie que le modèle n'a pas localisé l'objet avec précision.

Pour déterminer si une détection est réussie, nous utilisons différents seuils. Un seuil commun de IoU est de 0,5, ce qui signifie qu'une boîte prédite doit chevaucher la boîte de vérité au sol d'au moins 50 % pour être considérée comme un vrai positif. Tout chevauchement inférieur à ce seuil est considéré comme un faux positif.

Jusqu'à présent, nous avons exploré quelques métriques d'évaluation de base pour comprendre les performances des modèles de détection d'objets. S'appuyant sur cela, deux des métriques les plus importantes sont la précision et le rappel. Ils nous donnent une image claire de la précision des détections du modèle. Examinons ce qu'ils sont.

Les valeurs de précision nous indiquent combien de prédictions du modèle étaient réellement correctes. Elles répondent à la question suivante : parmi tous les objets que le modèle prétendait detect, combien étaient réellement présents ?

Les valeurs de rappel, quant à elles, mesurent la capacité du modèle à trouver tous les objets réels présents dans l'image. Elles répondent à la question suivante : parmi tous les objets réels présents, combien le modèle a-t-il correctement detect?

Ensemble, la précision et le rappel nous donnent une image plus claire de la performance d'un modèle. Par exemple, si un modèle prédit 10 voitures dans une image et que 9 d'entre elles sont effectivement des voitures, il a une précision de 90 % (une prédiction positive).

Ces deux métriques d'évaluation impliquent souvent un compromis : un modèle peut atteindre une valeur de précision élevée en ne faisant que des prédictions dont il est pleinement certain, mais cela peut l'amener à manquer de nombreux objets, ce qui diminue le niveau de rappel. Parallèlement, il peut également atteindre un rappel très élevé en prédisant une boîte englobante presque partout, mais cela réduirait la précision.

Alors que la précision et le rappel nous aident à comprendre les performances d'un modèle sur des prédictions individuelles, la précision moyenneAP permet d'obtenir une vision plus large. Elle illustre l'évolution de la précision du modèle lorsqu'il tente de detect plus grand nombre d'objets et résume ses performances en un seul chiffre.

Pour calculer le score de précision moyenne, nous pouvons d'abord créer une métrique combinée de type graphique appelée courbe de précision-rappel (ou courbe PR) pour chaque type d'objet. Cette courbe montre ce qui se passe lorsque le modèle fait plus de prédictions.

Considérons un scénario dans lequel le modèle commence par détecter uniquement les objets les plus faciles ou les plus évidents. À ce stade, la précision est élevée car la plupart des prédictions sont correctes, mais le rappel est faible car de nombreux objets ne sont toujours pas détectés. Lorsque le modèle tente de detect davantage d'objets, y compris les plus difficiles ou les plus rares, il introduit généralement plus d'erreurs. La précision diminue alors, tandis que le rappel augmente.

La précision moyenne est l'aire sous la courbe (AUC de la courbe PR). Une aire plus grande signifie que le modèle parvient mieux à maintenir la précision de ses prédictions, même s'il détecte davantage d'objets. L'AP la AP est calculée séparément pour chaque étiquette de classe.

Par exemple, dans un modèle capable de detect voitures, des vélos et des piétons, nous pouvons calculer les valeurs AP individuellement pour chacune de ces trois catégories. Cela nous permet de savoir quels objets sont bien détectés par le modèle et quels objets doivent encore être améliorés.

Après avoir calculé la précision moyenne pour chaque classe d'objets, nous avons encore besoin d'un score unique qui reflète la performance globale du modèle pour toutes les classes. La formule de la précision moyenne permet d'y parvenir. Elle calcule la moyenne des scores de AP pour chaque catégorie.

Par exemple, supposons qu'un modèle de vision artificielle comme YOLO11 atteigne un AP de 0,827 pour les voitures, 0,679 pour les motos, 0,355 pour les camions, 0,863 pour les bus et 0,982 pour les bicyclettes. En utilisant la formule mAP , nous pouvons additionner ces chiffres et les diviser par le nombre total de classes comme suit :

mAP = (0,827 + 0,679 + 0,355 + 0,863 + 0,982) ÷ 5 = 0,7432 ≈ 0,743

Le score mAP de 0,743 offre une solution simple pour évaluer la performance du modèle dans toutes les classes d'objets. Une valeur proche de 1 signifie que le modèle est précis pour la plupart des catégories, tandis qu'une valeur inférieure suggère qu'il a des difficultés avec certaines d'entre elles.

Maintenant que nous comprenons mieux comment AP et mAP sont calculés et quelles sont leurs composantes, voici un aperçu de leur importance dans la vision par ordinateur :

Ensuite, examinons comment des mesures clés telles que mAP peuvent aider à élaborer des cas d'utilisation de la vision par ordinateur dans le monde réel.

En ce qui concerne les voitures autonomes, la détection des objets est essentielle pour identifier les piétons, les panneaux de signalisation, les cyclistes et les marquages de voie. Par exemple, si un enfant traverse soudainement la rue en courant, la voiture a quelques secondes pour detect l'objet (l'enfant), localiser l'endroit où il se trouve, track son mouvement et prendre les mesures nécessaires (freiner).

Des modèles comme YOLO11 sont conçus pour la détection d'objets en temps réel dans de tels scénarios à fort enjeu. Dans ces cas, la mAP devient une mesure de sécurité essentielle.

Un score mAP élevé garantit que le système détecte rapidement l'enfant, le localise avec précision et déclenche le freinage avec un délai minimal. Un mAP faible peut signifier des détections manquées ou des erreurs de classification dangereuses, comme le fait de confondre l'enfant avec un autre petit objet.

De même, dans le commerce de détail, les modèles de détection d'objets peuvent être utilisés pour automatiser des tâches telles que la surveillance des stocks et les processus de caisse. Lorsqu'un client scanne un produit à une caisse automatique, une erreur de détection peut entraîner de la frustration.

Un score mAP élevé permet de s'assurer que le modèle distingue correctement les produits similaires et dessine des boîtes de délimitation précises, même lorsque les articles sont étroitement emballés. Un score mAP faible peut entraîner des confusions. Par exemple, si le modèle confond une bouteille de jus d'orange avec une bouteille de jus de pomme visuellement similaire, il peut en résulter une facturation incorrecte et des rapports d'inventaire inexacts.

Les systèmes de vente au détail intégrés à des modèles tels que YOLO11 peuvent detect produits en temps réel, les comparer à l'inventaire et mettre à jour les systèmes de gestion instantanément. Dans les environnements de vente au détail où tout va très vite, le mAP joue un rôle crucial en assurant la précision et la fiabilité des opérations.

L'amélioration de la précision des diagnostics dans les soins de santé commence par une détection précise dans l'imagerie médicale. Des modèles comme YOLO11 peuvent aider les radiologues à repérer des tumeurs, des fractures ou d'autres anomalies à partir de ces scanners médicaux. Dans ce cas, la précision moyenne est une mesure essentielle pour évaluer la fiabilité clinique d'un modèle.

Un mAP élevé indique que le modèle atteint à la fois un rappel élevé (identifiant les problèmes les plus réels) et une précision élevée (évitant les fausses alertes), ce qui est crucial dans la prise de décision clinique. En outre, le seuil de l'IoU dans les soins de santé est souvent fixé à un niveau très élevé (0,85 ou 0,90) afin de garantir une détection extrêmement précise.

Cependant, un score mAP faible peut susciter des inquiétudes. Si un modèle ne détecte pas une tumeur, cela peut retarder le diagnostic ou conduire à un traitement incorrect.

Voici les principaux avantages de l'utilisation de la précision moyenne (mAP) pour évaluer les modèles de détection d'objets :

Bien que l'utilisation de la métrique mAP présente de nombreux avantages, il convient de tenir compte de certaines limites. Voici quelques facteurs à prendre en compte :

Nous avons vu que la précision moyenne n'est pas seulement un score technique, mais qu'elle reflète les performances potentielles d'un modèle dans le monde réel. Qu'il s'agisse d'un système de véhicule autonome ou d'une caisse de magasin, un score mAP élevé est un indicateur fiable de la performance et de l'aptitude pratique d'un modèle.

Bien que mAP soit une mesure essentielle et importante, il doit être considéré comme un élément d'une stratégie d'évaluation bien équilibrée. Pour les applications critiques telles que les soins de santé et la conduite autonome, il ne suffit pas de se fier uniquement à la mAP.

Des facteurs supplémentaires tels que la vitesse d'inférence (la rapidité avec laquelle le modèle fait des prédictions), la taille du modèle (qui a un impact sur le déploiement sur les appareils périphériques) et l'analyse qualitative des erreurs (comprendre les types d'erreurs que le modèle fait) doivent également être pris en compte pour garantir que le système est sûr, efficace et réellement adapté à l'usage auquel il est destiné.

Rejoignez notre communauté en pleine croissance et notre dépôt GitHub pour en savoir plus sur la vision par ordinateur. Explorez nos pages de solutions pour en savoir plus sur les applications de la vision par ordinateur dans l'agriculture et de l'IA dans la logistique. Consultez nos options de licence pour démarrer dès aujourd'hui avec votre propre modèle de vision par ordinateur !