Découvrez la segmentation conceptuelle promptable, en quoi elle diffère des méthodes traditionnelles et comment des modèles connexes tels que YOLOE-26 permettent des capacités de vocabulaire ouvert.

Découvrez la segmentation conceptuelle promptable, en quoi elle diffère des méthodes traditionnelles et comment des modèles connexes tels que YOLOE-26 permettent des capacités de vocabulaire ouvert.

La vision artificielle progresse rapidement et est largement utilisée pour analyser des images et des vidéos dans des environnements réels. Par exemple, des applications allant des systèmes de gestion du trafic à l'analyse commerciale sont intégrées à des modèles de vision par ordinateur.

Dans bon nombre de ces applications, les modèles de vision, tels que les modèles de détection d'objets, sont entraînés à reconnaître un ensemble prédéfini d'objets, notamment des véhicules, des personnes et des équipements. Pendant l'entraînement, ces modèles sont exposés à de nombreux exemples étiquetés afin qu'ils puissent apprendre à reconnaître chaque objet et à le distinguer des autres dans une scène.

Pour les tâches de segmentation, les modèles vont encore plus loin en produisant des contours précis au niveau des pixels autour de ces objets. Cela permet aux systèmes de comprendre exactement où chaque objet se trouve dans une image.

Cela fonctionne bien tant que le système n'a besoin de reconnaître que ce pour quoi il a été formé. Cependant, dans les environnements réels, c'est rarement le cas.

Les scènes visuelles sont généralement dynamiques. De nouveaux objets et concepts visuels apparaissent, les conditions changent et les utilisateurs souhaitent souvent segment qui ne faisaient pas partie de la configuration d'apprentissage initiale.

Ces limites sont particulièrement évidentes en matière de segmentation. À mesure que l'IA visuelle continue d'évoluer, il existe un besoin croissant de modèles de segmentation plus flexibles, capables de s'adapter à de nouveaux concepts sans nécessiter de réentraînement répété. C'est pourquoi la segmentation conceptuelle promptable (PCS) suscite de plus en plus d'intérêt.

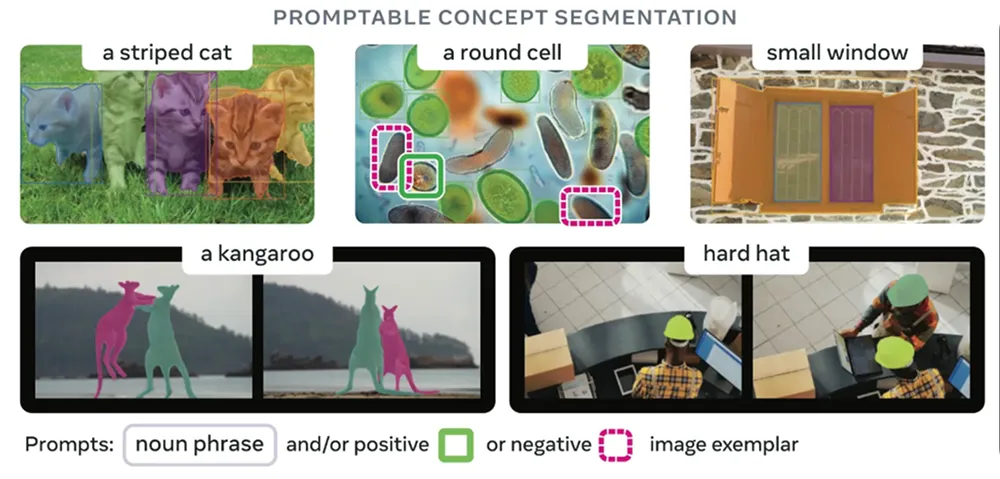

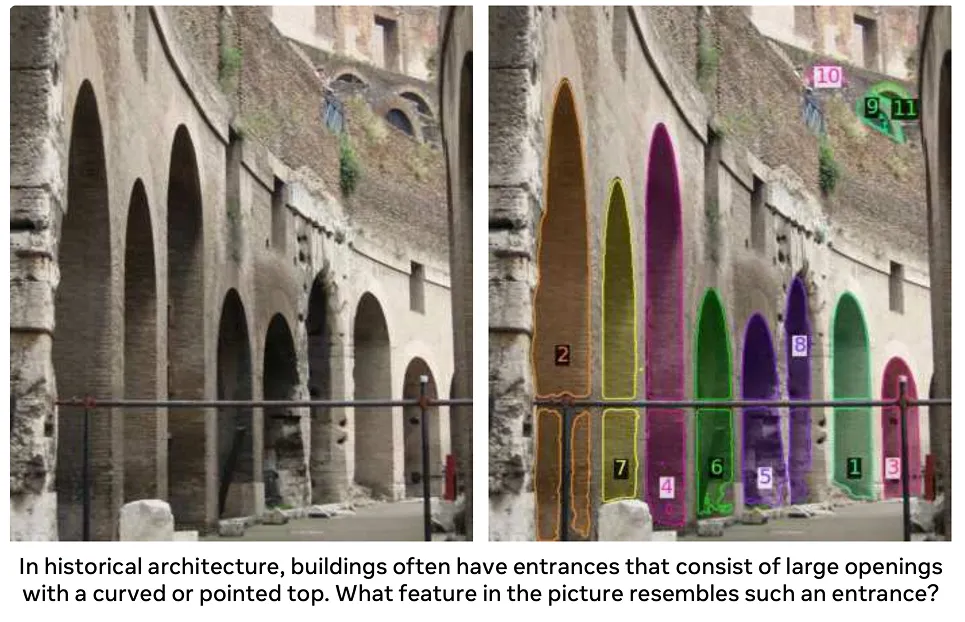

Au lieu de s'appuyer sur une liste fixe de catégories d'objets, les utilisateurs peuvent décrire ce qu'ils souhaitent segment texte, segment indications visuelles ou segment images d'exemple. Ces modèles peuvent ensuite identifier et segment les régions qui correspondent au concept décrit, même si ce concept n'a pas été explicitement inclus lors de l'entraînement.

Dans cet article, nous allons explorer le fonctionnement de la segmentation conceptuelle promptable, en quoi elle diffère des approches traditionnelles et où elle est utilisée aujourd'hui.

Dans la plupart des cas, les modèles de segmentation sont entraînés à reconnaître une courte liste de types d'objets. Cela fonctionne bien lorsqu'un système d'IA visuelle n'a besoin que de detect segment ensemble spécifique d'objets.

Dans les applications réelles, cependant, les scènes visuelles sont dynamiques. De nouveaux objets apparaissent, les exigences des tâches changent et les utilisateurs doivent souvent segment qui n'étaient pas inclus dans l'ensemble d'étiquettes d'origine. Pour faire face à ces situations, il faut généralement collecter de nouvelles données et annotations de haute qualité et réentraîner le modèle, ce qui augmente les coûts et ralentit le déploiement.

La segmentation conceptuelle instantanée résout ce problème en permettant aux utilisateurs d'indiquer au modèle ce qu'ils recherchent, plutôt que de choisir parmi une liste fixe d'étiquettes. Les utilisateurs décrivent l'objet ou l'idée qu'ils recherchent, et le modèle met en évidence toutes les zones correspondantes dans l'image. Il est ainsi beaucoup plus facile de relier l'intention de l'utilisateur aux pixels réels d'une image.

Les modèles qui prennent en charge la segmentation de concepts promptables sont flexibles, car ils peuvent accepter différents types d'entrées. En d'autres termes, il existe plusieurs façons d'indiquer au modèle ce qu'il doit rechercher, par exemple à l'aide de descriptions textuelles, d'indices visuels ou d'images d'exemple.

Voici un aperçu plus détaillé de chaque approche :

Avant d'aborder le fonctionnement de la segmentation conceptuelle promptable, comparons-la d'abord à diverses méthodes traditionnelles de segmentation d'objets.

Le PCS permet d'utiliser des modèles à vocabulaire ouvert et pilotés par des invites. Il peut fonctionner avec de nouvelles idées décrites à travers des invites, ce qui n'est pas le cas de la segmentation traditionnelle. Il existe plusieurs types d'approches de segmentation traditionnelle, chacune avec ses propres hypothèses et limites.

Voici un aperçu des principaux types de segmentation traditionnelle :

Toutes ces approches s'appuient sur une liste prédéfinie de catégories d'objets. Elles fonctionnent bien dans ce cadre, mais ne gèrent pas très bien les concepts qui s'en écartent. Lorsqu'un nouvel objet spécifique doit être segmenté, des données d'entraînement supplémentaires et un ajustement du modèle sont généralement nécessaires.

PCS vise à changer cela. Au lieu d'être enfermé dans des catégories prédéfinies, il vous permet de décrire ce que vous souhaitez segment une image au moment de l'inférence.

Ensuite, voyons comment les modèles de segmentation ont évolué vers la segmentation de concepts promptable.

Un modèle de base populaire qui a marqué un changement dans la segmentation était SAM, ou Segment Anything Model (modèle de segmentation de tout). Il a été introduit en 2023. Au lieu de s'appuyer sur des catégories d'objets prédéfinies, SAM aux utilisateurs de guider la segmentation à l'aide de repères visuels simples tels que des points ou des cadres de sélection.

Avec SAM, les utilisateurs n'avaient plus besoin de sélectionner une étiquette. Il leur suffisait d'indiquer où se trouvait un objet, et le modèle générait un masque pour celui-ci. Cela rendait la segmentation plus flexible, mais les utilisateurs devaient toujours indiquer au modèle où chercher.

SAM , sorti en 2024, s'est appuyé sur cette idée pour traiter des scènes plus complexes et étendre la segmentation par invite à la vidéo. Il a amélioré la robustesse dans différentes conditions d'éclairage, formes d'objets et mouvements, tout en continuant à s'appuyer principalement sur des invites visuelles pour guider la segmentation.

Le modèle SAM est la dernière étape de cette évolution. Lancé l'année dernière, il s'agit d'un modèle unifié qui combine la compréhension visuelle et le guidage linguistique, permettant ainsi un comportement cohérent dans les tâches de segmentation d'images et de vidéos.

Avec SAM , les utilisateurs ne sont pas limités à pointer ou dessiner des invites. Ils peuvent plutôt décrire ce qu'ils souhaitent segment texte, et le modèle recherche dans l'image ou les images vidéo les zones qui correspondent à cette description.

La segmentation est guidée par des concepts plutôt que par des catégories d'objets fixes, ce qui favorise l'utilisation d'un vocabulaire ouvert dans différentes situations et au fil du temps. En fait, SAM fonctionne sur un vaste espace conceptuel appris qui s'appuie sur une ontologie dérivée de sources telles que Wikidata et enrichie par des données d'entraînement à grande échelle.

Par rapport aux versions précédentes qui reposaient principalement sur des indications géométriques, SAM représente une avancée vers une segmentation plus flexible et axée sur les concepts. Cela le rend mieux adapté aux applications du monde réel où les objets ou les idées d'intérêt peuvent changer et ne peuvent pas toujours être définis à l'avance.

Alors, comment fonctionne la segmentation conceptuelle instantanée ? Elle s'appuie sur de grands modèles de vision et de langage visuel pré-entraînés, qui sont des modèles entraînés sur des collections massives d'images et, dans de nombreux cas, sur des textes associés. Cet entraînement leur permet d'apprendre des modèles visuels généraux et la signification sémantique.

La plupart des modèles PCS utilisent des architectures basées sur des transformateurs, qui traitent une image entière à la fois pour comprendre comment les différentes régions sont liées entre elles. Un transformateur visuel extrait les caractéristiques visuelles de l'image, tandis qu'un encodeur de texte convertit les mots en représentations numériques que le modèle peut traiter.

Au cours de l'entraînement, ces modèles peuvent apprendre à partir de différents types de supervision, notamment des masques au niveau des pixels qui définissent les limites exactes des objets, des cadres de sélection qui localisent approximativement les objets et des étiquettes au niveau de l'image qui décrivent ce qui apparaît dans une image. L'entraînement à l'aide de différents types de données étiquetées aide le modèle à saisir à la fois les détails fins et les concepts visuels plus larges.

Au moment de l'inférence, c'est-à-dire lorsque le modèle est effectivement utilisé pour faire des prédictions, PCS suit un processus guidé par des invites. L'utilisateur fournit des indications sous forme de descriptions textuelles, d'indices visuels tels que des points ou des encadrés, ou d'images d'exemple. Le modèle encode à la fois l'invite et l'image dans une représentation interne partagée ou des intégrations, et identifie les régions qui correspondent au concept décrit.

Un décodeur de masque convertit ensuite cette représentation partagée en masques de segmentation précis au niveau des pixels. Comme le modèle relie les caractéristiques visuelles à la signification sémantique, il peut segment concepts même s'ils n'ont pas été explicitement inclus pendant l'entraînement.

De plus, il est souvent possible d'affiner le résultat en ajustant l'invite ou en ajoutant des indications supplémentaires, ce qui aide le modèle à gérer des scènes complexes ou ambiguës. Ce processus itératif facilite l'optimisation pratique lors du déploiement.

Les modèles de segmentation de concepts promptables sont généralement évalués en fonction de leur capacité segment des concepts segment et de leur robustesse dans différentes scènes. Les benchmarks se concentrent souvent sur la qualité du masque, la généralisation et l'efficacité computationnelle, reflétant ainsi les exigences réelles de déploiement.

Voyons maintenant où la segmentation conceptuelle promptable est déjà utilisée et commence à avoir un impact réel.

L'imagerie médicale implique de nombreuses structures biologiques, maladies et types de scans, et de nouveaux cas apparaissent chaque jour. Les modèles de segmentation traditionnels ont du mal à suivre cette diversité.

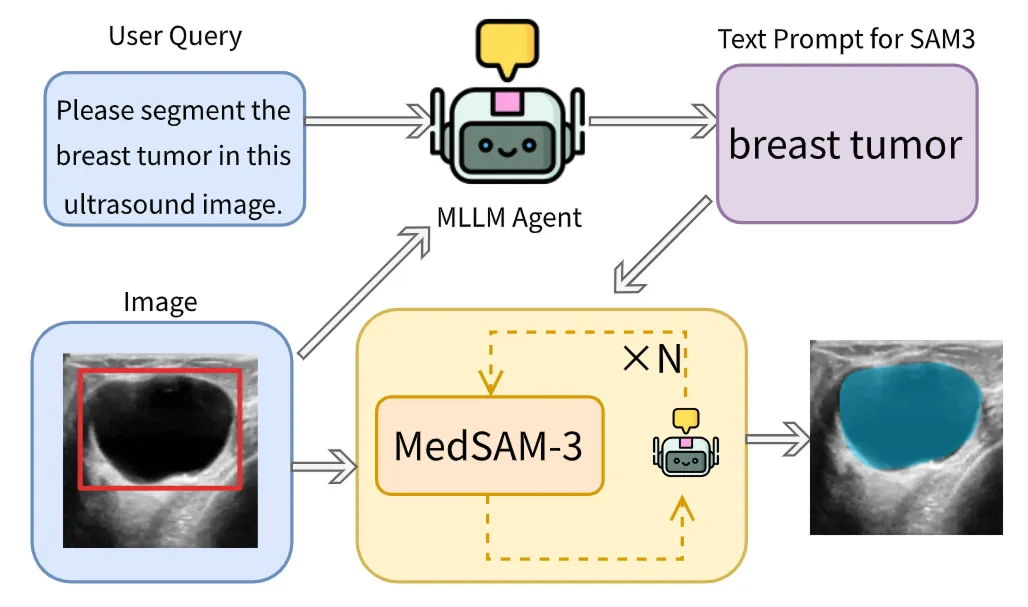

Le PCS s'intègre naturellement dans cet espace, car il permet aux cliniciens de décrire ce qu'ils veulent trouver au lieu de choisir parmi une liste courte et rigide. Grâce à des phrases textuelles ou des invites visuelles, le PCS peut être utilisé pour segment directement segment ou les zones d'intérêt, sans avoir à réentraîner le modèle pour chaque nouvelle tâche. Cela facilite la gestion des divers besoins cliniques, réduit le besoin de dessiner manuellement des masques et fonctionne avec de nombreux types d'imagerie.

Un excellent exemple est MedSAM-3, qui adapte l'architecture SAM pour les PCS à saisie textuelle dans l'imagerie médicale. Ce modèle peut être alimenté par des termes anatomiques et pathologiques explicites, tels que des noms d'organes comme le foie ou les reins et des concepts liés aux lésions comme les tumeurs ou les lésions. À partir d'une saisie, le modèle segmente directement la région correspondante dans l'image médicale.

MedSAM-3 intègre également des modèles linguistiques multimodaux de grande taille (MLLM ou LLM multimodaux), capables d'analyser à la fois du texte et des images. Ces modèles fonctionnent selon un principe d'agent en boucle, où les résultats sont affinés de manière itérative afin d'améliorer la précision dans les cas les plus complexes.

MedSAM-3 fonctionne efficacement avec les données issues de radiographies, d'IRM, de tomodensitométries, d'échographies et de vidéos, soulignant ainsi comment le PCS peut permettre des flux de travail d'imagerie médicale plus flexibles et plus efficaces dans des contextes cliniques réels.

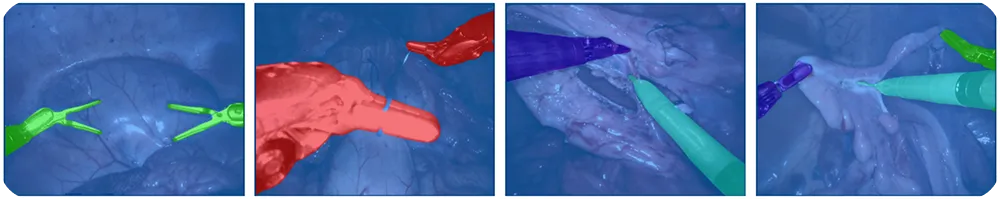

La chirurgie robotique s'appuie sur des systèmes de vision pour track et comprendre les scènes chirurgicales qui évoluent rapidement. Les instruments se déplacent rapidement, l'éclairage varie et de nouveaux outils peuvent apparaître à tout moment, ce qui rend difficile le maintien de systèmes d'étiquetage prédéfinis.

Grâce au PCS, les robots peuvent track , guider les caméras et suivre les étapes chirurgicales en temps réel. Cela réduit l'étiquetage manuel et facilite l'adaptation des systèmes à différentes procédures. Les chirurgiens ou les systèmes automatisés peuvent utiliser des invites textuelles telles que « pince », « scalpel » ou « outil caméra » pour indiquer ce qui doit être segmenté dans une image.

Un autre modèle de pointe intéressant lié à la segmentation de concepts promptables est notre Ultralytics . Notre modèle apporte une segmentation à vocabulaire ouvert et pilotée par des prompts à la familleYOLO Ultralytics YOLO .

YOLOE-26 est basé sur l'architecture Ultralytics et prend en charge la segmentation d'instances à vocabulaire ouvert. YOLOE-26 permet aux utilisateurs de guider la segmentation de plusieurs façons.

Il prend en charge les invites textuelles, où de courtes phrases visuelles peuvent spécifier l'objet cible, ainsi que les invites visuelles, qui fournissent des indications supplémentaires basées sur des repères visuels. De plus, YOLOE-26 comprend un mode sans invite pour l'inférence sans apprentissage, où le modèle détecte et segmente les objets à partir d'un vocabulaire intégré sans nécessiter d'invites de la part de l'utilisateur.

YOLOE-26 est idéal pour des applications telles que l'analyse vidéo, la perception robotique et les systèmes basés sur la périphérie, où les catégories d'objets peuvent changer, mais où une faible latence et un débit fiable restent essentiels. Il est également particulièrement utile pour l'étiquetage des données et la curation des ensembles de données, car il rationalise les flux de travail en automatisant certaines parties du processus d'annotation.

Voici quelques-uns des principaux avantages liés à l'utilisation de la segmentation conceptuelle promptable :

Bien que le PCS présente des avantages évidents, voici quelques limites à prendre en considération :

Lorsque vous explorez la segmentation promptable, vous vous demandez peut-être à quelles applications elle convient le mieux et dans quels cas un modèle de vision par ordinateur traditionnel tel que YOLO26 est plus adapté au problème que vous essayez de résoudre. La segmentation promptable fonctionne bien pour les objets généraux, mais elle n'est pas adaptée aux cas d'utilisation qui nécessitent des résultats très précis et cohérents.

La détection des défauts en est un bon exemple. Dans le secteur manufacturier, les défauts sont souvent minuscules et subtils, tels que de petites rayures, des bosses, des désalignements ou des irrégularités de surface. Ils peuvent également varier considérablement en fonction des matériaux, de l'éclairage et des conditions de production.

Ces problèmes sont difficiles à décrire à l'aide d'une simple invite et encore plus difficiles à detect pour un modèle polyvalent. Dans l'ensemble, les modèles basés sur des invites ont tendance à passer à côté de défauts ou à produire des résultats instables, tandis que les modèles spécialement entraînés sur des données de défauts sont beaucoup plus fiables pour les systèmes d'inspection réels.

La segmentation conceptuelle promptable facilite l'adaptation des systèmes de vision au monde réel, où de nouveaux objets et concepts apparaissent sans cesse. Au lieu d'être limités à des étiquettes fixes, les utilisateurs peuvent simplement décrire ce qu'ils souhaitent segment laisser le modèle faire le reste, ce qui permet de gagner du temps et de réduire le travail manuel. Bien qu'elle présente encore certaines limites, la PCS est déjà en train de changer la façon dont la segmentation est utilisée dans la pratique et devrait devenir un élément central des futurs systèmes de vision.

Pour en savoir plus sur l'IA, rendez-vous sur notre référentiel GitHub et rejoignez notre communauté. Consultez nos pages Solutions pour en savoir plus sur l'IA dans la robotique et la vision par ordinateur dans le secteur manufacturier. Découvrez nos options de licence pour commencer à utiliser Vision AI dès aujourd'hui !