Découvrez comment SAM 3, le nouveau modèle Segment Anything de Meta AI, facilite la detect, la segment et le track objets dans les images et les vidéos du monde réel.

Découvrez comment SAM 3, le nouveau modèle Segment Anything de Meta AI, facilite la detect, la segment et le track objets dans les images et les vidéos du monde réel.

Le 19 novembre 2025, Meta AI a publié Segment Anything Model 3, également connu sous le nom de SAM 3. Cette dernière version du modèle Segment Anything présente de nouvelles façons de detect, de segment et de track objets dans des images et des vidéos du monde réel à l'aide d'invites textuelles, d'invites visuelles et d'exemples d'images.

Le modèle SAM 3 s'appuie sur SAM et SAM 2 et apporte de nouvelles avancées et fonctionnalités telles que la segmentation des concepts, la détection du vocabulaire ouvert et le suivi vidéo en temps réel. Il peut comprendre des phrases nominales courtes, suivre des objets à travers les images et identifier des concepts fins ou rares que les modèles précédents ne pouvaient pas traiter de manière aussi cohérente.

Dans le cadre de la version SAM 3, Meta a également introduit SAM 3D. Cette suite de modèles de nouvelle génération reconstruit des objets, des scènes et des corps humains complets à partir d'une seule image et étend l'écosystème Segment Anything à la compréhension 3D. Ces ajouts ouvrent la voie à de nouvelles applications dans les domaines de la vision par ordinateur, de la robotique, de l'édition de médias et des flux de travail créatifs.

Dans cet article, nous allons explorer ce qu'est SAM 3, ce qui le différencie de SAM 2, comment le modèle fonctionne et ses applications dans le monde réel. C'est parti !

SAM 3 est un modèle de vision artificielle de pointe capable d'identifier, de séparer et de track objets dans des images et des vidéos sur la base d'instructions simples. Au lieu de s'appuyer sur une liste fixe d'étiquettes, SAM 3 comprend le langage naturel et les indices visuels, ce qui permet de dire facilement au modèle ce que l'on veut trouver.

Par exemple, avec SAM 3, vous pouvez taper une courte phrase comme "bus scolaire jaune" ou "un chat rayé", cliquer sur un objet ou mettre en évidence un exemple dans une image. Le modèle detect alors chaque objet correspondant et génère des masques de segmentation propres (un contour visuel qui indique exactement quels pixels appartiennent à un objet). SAM 3 peut également suivre ces objets à travers les images vidéo, en les gardant cohérents lorsqu'ils se déplacent.

Une autre partie intéressante de l'annonce de Meta AI est SAM 3D, qui étend le projet Segment Anything à la compréhension 3D. SAM 3D peut prendre une seule image en 2D et reconstruire la forme, la pose ou la structure d'un objet ou d'un corps humain en trois dimensions. En d'autres termes, le modèle peut estimer la façon dont un objet occupe l'espace, même lorsqu'un seul point de vue est disponible.

SAM 3D a été lancé sous la forme de deux modèles différents : SAM 3D Objects, qui reconstruit des objets de la vie quotidienne avec leur géométrie et leur texture, et SAM 3D Body, qui estime la forme et la pose du corps humain à partir d'une seule image. Les deux modèles utilisent les résultats de la segmentation de SAM 3 et génèrent ensuite une représentation 3D qui correspond à l'apparence et à la position de l'objet sur la photo d'origine.

Voici quelques-unes des principales mises à jour introduites par SAM 3 pour regrouper la détection, la segmentation et le suivi en un seul modèle unifié :

Supposons que vous regardiez une vidéo de safari avec de nombreux animaux différents et que vous souhaitiez detect et segment uniquement les éléphants. À quoi ressemblerait cette tâche dans les différentes versions de SAM?

Avec SAM, vous devez cliquer manuellement sur chaque éléphant dans chaque image pour générer un masque de segmentation. Il n'y a pas de suivi, donc chaque nouvelle image nécessite de nouveaux clics.

Avec SAM 2, vous pouvez cliquer une fois sur un éléphant, obtenir son masque et le modèle track ce même éléphant tout au long de la vidéo. Cependant, vous devrez toujours fournir des clics séparés si vous souhaitez segment plusieurs éléphants (objets spécifiques), car SAM 2 ne comprend pas les catégories telles que "éléphant" en soi.

Avec SAM 3, le flux de travail devient beaucoup plus simple. Vous pouvez taper "éléphant" ou dessiner un cadre autour d'un seul éléphant pour donner un exemple, et le modèle trouvera automatiquement tous les éléphants de la vidéo, les segment et les track manière cohérente d'une image à l'autre. Le modèle prend toujours en charge les invites de type "clic" et "boîte" utilisées dans les versions précédentes, mais il peut désormais répondre à des invites textuelles et à des images exemplaires, ce que SAM et SAM 2 ne pouvaient pas faire.

Examinons maintenant de plus près le fonctionnement du modèle SAM 3 et la manière dont il a été formé.

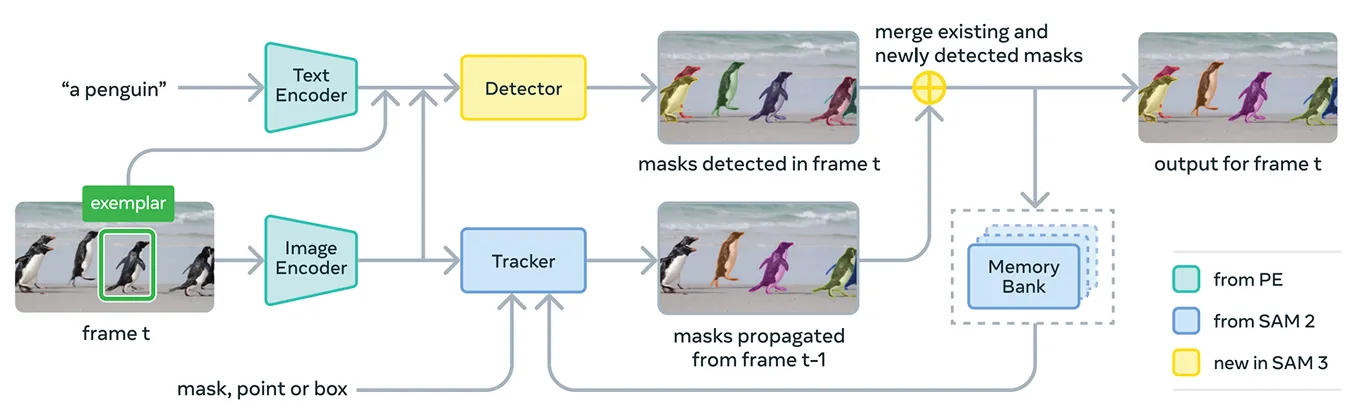

SAM 3 rassemble plusieurs composants pour prendre en charge les messages-guides conceptuels et les messages-guides visuels dans un seul système. À la base, le modèle utilise le Meta Perception Encoder, qui est l'encodeur image-texte unifié à source ouverte de Meta.

Cet encodeur peut traiter à la fois les images et les phrases nominales courtes. En d'autres termes, cela permet à SAM 3 de relier les caractéristiques linguistiques et visuelles plus efficacement que les versions précédentes du modèle Segment Anything.

En plus de cet encodeur, SAM 3 comprend un détecteur basé sur la famille DETR de modèles de transformateurs. Ce détecteur identifie les objets dans l'image et aide le système à déterminer quels objets correspondent à l'invite de l'utilisateur.

Plus précisément, pour la segmentation vidéo, SAM 3 utilise un composant de suivi qui s'appuie sur la banque de mémoire et l'encodeur de mémoire de SAM 2. Cela permet au modèle de conserver des informations sur les objets à travers les images afin de pouvoir les réidentifier et les track dans le temps.

Pour former SAM 3, Meta avait besoin de beaucoup plus de données annotées que ce qui existe actuellement sur Internet. Il est difficile de créer des masques de segmentation et des étiquettes textuelles de haute qualité à grande échelle, et il est lent et coûteux de décrire chaque instance d'un concept dans les images et les vidéos.

Pour résoudre ce problème, Meta a construit un nouveau moteur de données qui combine SAM 3 lui-même, des modèles d'IA supplémentaires et des annotateurs humains travaillant ensemble. Le flux de travail commence par un pipeline de systèmes d'IA, dont SAM 3 et un modèle de sous-titrage basé sur Llama.

Ces systèmes analysent de vastes collections d'images et de vidéos, génèrent des légendes, convertissent ces légendes en étiquettes textuelles et produisent des candidats au masque de segmentation précoce. Des annotateurs humains et artificiels examinent ensuite ces candidats.

Les annotateurs d'IA, formés pour égaler, voire dépasser, la précision humaine dans des tâches telles que le contrôle de la qualité des masques et la vérification de la couverture des concepts, filtrent les cas simples. Les humains n'interviennent que pour les exemples plus difficiles, pour lesquels le modèle peut encore éprouver des difficultés.

Cette approche permet à Meta d'améliorer considérablement la vitesse d'annotation. En laissant les annotateurs de l'IA s'occuper des cas faciles, le pipeline devient environ cinq fois plus rapide pour les invites négatives et 36 % plus rapide pour les invites positives dans les domaines à granularité fine.

Cette efficacité a permis d'étendre l'ensemble de données à plus de quatre millions de concepts uniques. La boucle constante des propositions de l'IA, des corrections humaines et des prédictions actualisées du modèle améliore également la qualité des étiquettes au fil du temps et aide SAM 3 à apprendre un ensemble beaucoup plus large de concepts visuels et textuels.

En ce qui concerne les performances, SAM 3 offre une nette amélioration par rapport aux modèles précédents. Sur le nouveau benchmark SA-Co de Meta, qui évalue la détection et la segmentation de concepts dans un vocabulaire ouvert, SAM 3 atteint environ le double des performances des systèmes précédents, tant pour les images que pour les vidéos.

Il égale ou dépasse également SAM 2 dans les tâches visuelles interactives telles que point-to-mask et mask-to-masklet. Meta fait état de gains supplémentaires sur des évaluations plus difficiles comme le LVIS zéro-shot (où les modèles doivent reconnaître des catégories rares sans exemples d'entraînement) et le comptage d'objets (mesurant si toutes les instances d'un objet sont détectées), mettant en évidence une plus grande généralisation à travers les domaines.

Outre ces améliorations en termes de précision, SAM 3 est efficace, traitant une image avec plus de 100 objets détectés en environ 30 millisecondes sur un GPU H200 et conservant des vitesses proches du temps réel lors du suivi de plusieurs objets dans une vidéo.

Maintenant que nous avons une meilleure compréhension de SAM 3, voyons comment il est utilisé dans des applications réelles, du raisonnement avancé guidé par le texte à la recherche scientifique et aux propres produits de Meta.

SAM 3 peut également être utilisé comme un outil au sein d'un modèle de langage multimodal plus large, que Meta appelle l'agent SAM 3. Au lieu de donner à SAM 3 une phrase courte comme "éléphant", l'agent peut décomposer une question plus compliquée en plus petites invites que SAM 3 comprend.

Par exemple, si l'utilisateur demande "Quel objet de l'image est utilisé pour contrôler et guider un cheval ?", l'agent essaie différentes expressions nominales, les envoie à SAM 3 et vérifie quels masques ont un sens. Il continue à affiner jusqu'à ce qu'il trouve le bon objet.

Même sans avoir été entraîné sur des ensembles de données de raisonnement spéciaux, l'agent SAM 3 obtient de bons résultats sur des bancs d'essai conçus pour des requêtes textuelles complexes, tels que ReasonSeg et OmniLabel. Cela montre que SAM 3 peut prendre en charge des systèmes qui ont besoin à la fois d'une compréhension du langage et d'une segmentation visuelle fine.

Il est intéressant de noter que SAM 3 est déjà utilisé dans des contextes de recherche où les étiquettes visuelles détaillées sont importantes. Meta a travaillé avec Conservation X Labs et Osa Conservation pour créer SA-FARI, un ensemble de données publiques de surveillance de la faune comprenant plus de 10 000 vidéos de pièges à caméra.

Chaque animal dans chaque image est étiqueté avec des cases et des masques de segmentation, ce qui prendrait énormément de temps à annoter à la main. De même, dans le domaine de la recherche océanographique, SAM 3 est utilisé avec FathomNet et MBARI pour créer des masques de segmentation d'instances pour l'imagerie sous-marine et soutenir de nouveaux critères d'évaluation.

Ces ensembles de données aident les scientifiques à analyser plus efficacement les séquences vidéo et à étudier les animaux et les habitats qu'il est généralement difficile de track à l'échelle. Les chercheurs peuvent également utiliser ces ressources pour construire leurs propres modèles d'identification des espèces, d'analyse du comportement et de surveillance écologique automatisée.

En plus de ses utilisations dans le domaine de la recherche, SAM 3 alimente également de nouvelles fonctionnalités et de nouveaux cas d'utilisation dans les produits de consommation de Meta. Voici un aperçu de quelques-unes des façons dont il est déjà intégré :

SAM 3 est une avancée passionnante pour la segmentation. Il introduit la segmentation des concepts, des invites textuelles à vocabulaire ouvert et un meilleur suivi. Avec des performances nettement plus élevées pour les images et les vidéos, et l'ajout de SAM 3D, la suite de modèles ouvre de nouvelles possibilités pour l'IA de vision, les outils créatifs, la recherche scientifique et les produits du monde réel.

Rejoignez notre communauté et explorez notre dépôt GitHub pour en savoir plus sur l'IA. Si vous souhaitez créer votre propre projet Vision AI, consultez nos options de licence. Pour en savoir plus sur des applications telles que l 'IA dans le domaine de la santé et l'IA de vision dans le domaine de la vente au détail, consultez nos pages consacrées aux solutions.