2025年の最先端物体検出モデルを探求する:主要アーキテクチャ、性能トレードオフ、実用的な導入要因を検証

2025年の最先端物体検出モデルを探求する:主要アーキテクチャ、性能トレードオフ、実用的な導入要因を検証

今年初め、AI および機械学習のパイオニアであるアンドルー・ング氏が、エージェント型物体検出の概念を発表しました。このアプローチでは、膨大な量のトレーニングデータを必要とせずに、推論エージェントdetect 。

画像や動画内の物体を、膨大なラベル付きデータセットを必要とせずに識別できることは、より賢く柔軟なコンピュータビジョンシステムへの一歩である。しかし、能動的なビジョンAIはまだ初期段階にある。

画像内の人物や道路標識の検出といった一般的なタスクは処理できるものの、より精密なコンピュータビジョンアプリケーションでは依然として従来の物体検出モデルに依存している。これらのモデルは、大規模で慎重にラベル付けされたデータセットを用いて訓練され、探すべき対象と物体の位置を正確に学習する。

従来の物体検出は、認識(物体が何であるかを特定する)と位置特定(画像内の正確な位置を決定する)の両方を提供するため不可欠である。この組み合わせにより、自律走行車から産業用自動化、医療診断に至るまで、機械が複雑な現実世界のタスクを確実に遂行できるようになる。

技術の進歩により、物体検出モデルは高速化・高精度化が進み、実環境での適用性が向上し続けています。本記事では、現在利用可能な優れた物体検出モデルをいくつかご紹介します。さっそく見ていきましょう!

画像分類などのコンピュータビジョンタスクは、画像に車や人物、その他の物体が含まれているかどうかを判別するために使用できます。しかし、それらは物体が画像内のどこに位置しているかを特定することはできません。

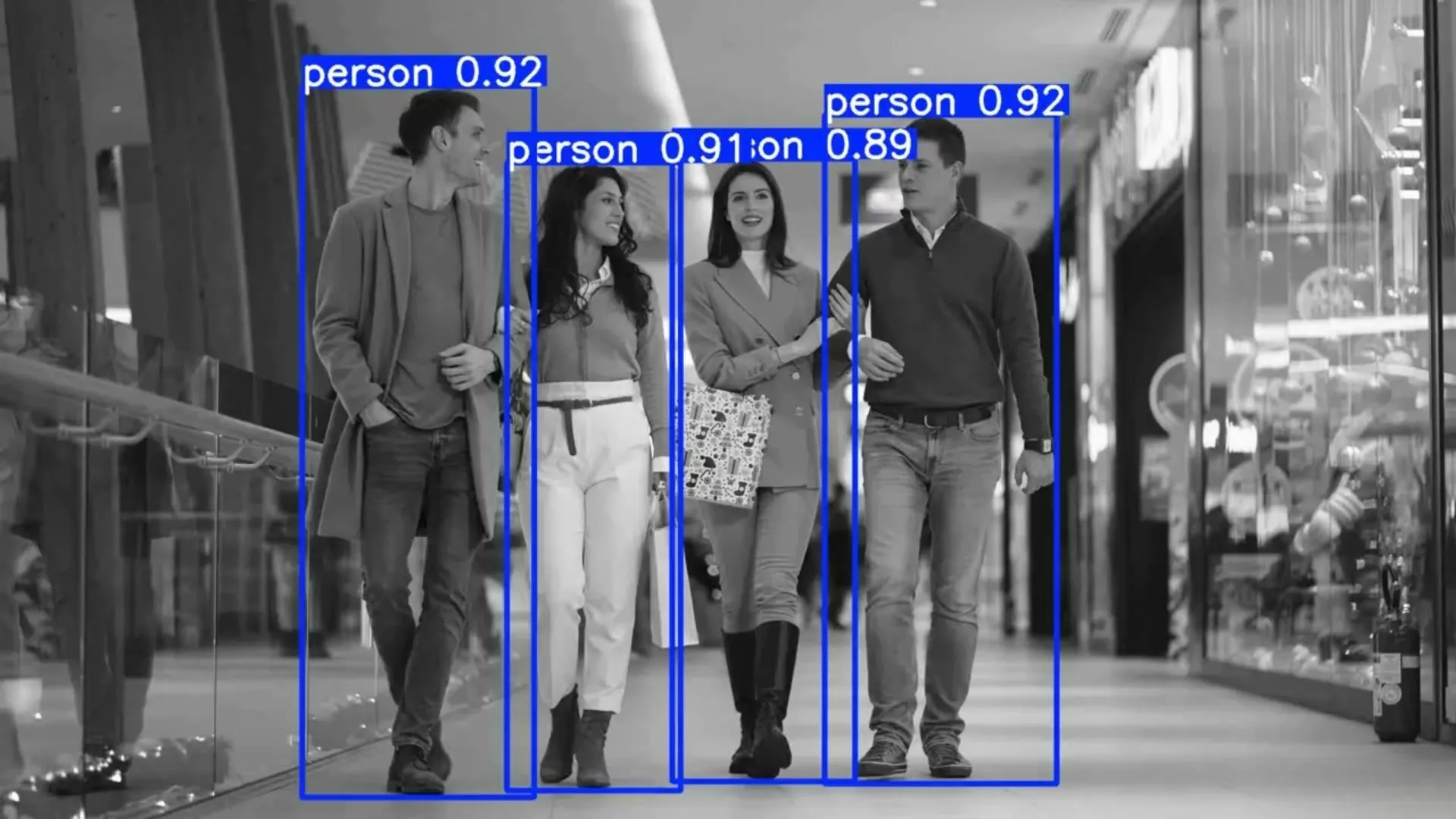

ここで物体検出が有用となる。物体検出モデルは存在する物体を識別し、その正確な位置を特定できる。この位置特定プロセスにより、機械はシーンをより正確に理解し、自動運転車の停止、ロボットアームの誘導、医療画像の領域強調など、適切な対応が可能となる。

深層学習の台頭は物体検出を変革した。手作業でコーディングされたルールに依存する代わりに、現代のモデルは注釈と視覚データから直接パターンを学習する。これらのデータセットは、物体の見た目、出現する場所、小さな物体・雑然としたシーン・変化する照明条件といった課題への対処法をモデルに教える。

実際、最先端の物体検出システムはdetect 物体を同時に正確にdetect 。この特性により、物体検出は自動運転、ロボティクス、医療、産業オートメーションなどの応用分野において重要な技術となっている。

物体検出モデルへの入力は画像であり、カメラ、動画フレーム、さらには医療用スキャンから得られる場合もある。入力画像はニューラルネットワーク(通常は畳み込みニューラルネットワーク:CNN)で処理され、このネットワークは視覚データ内のパターンを認識するよう訓練されている。

ネットワーク内部では、画像が段階的に解析される。検出された特徴に基づき、モデルはどの物体が存在し、どこに現れるかを予測する。

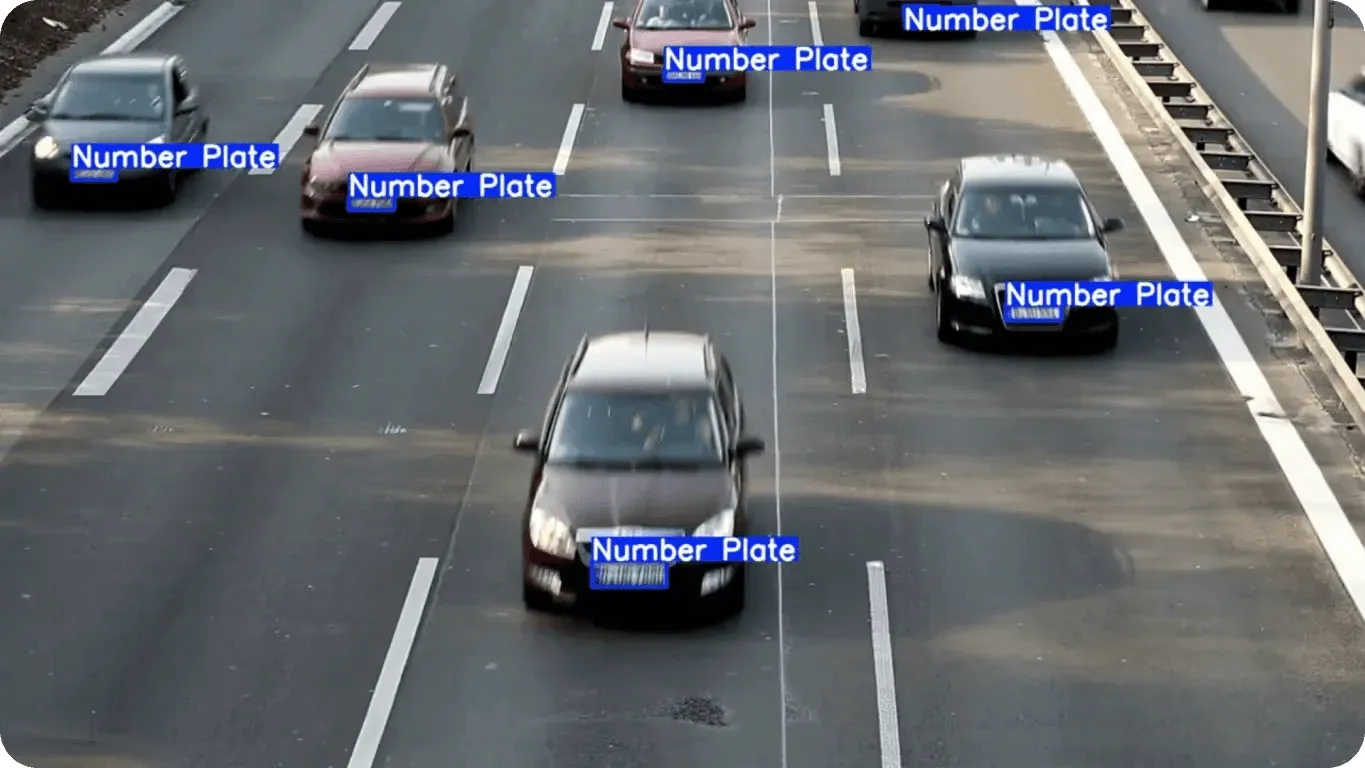

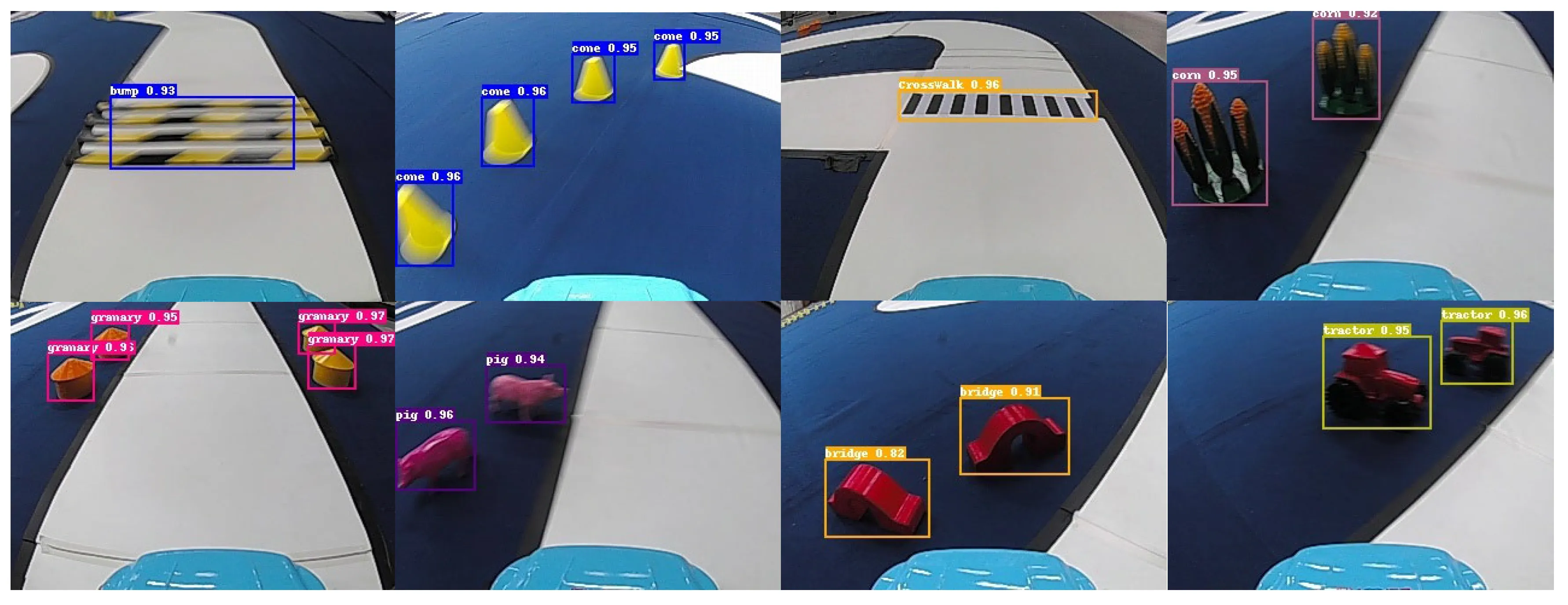

これらの予測は、検出された各オブジェクトの周囲に描かれた矩形であるバウンディングボックスを用いて表現されます。各バウンディングボックスに対して、モデルはクラスラベル(例:車、人、犬など)と、予測の確信度を示す信頼度スコア(確率と見なすことも可能)を割り当てます。

全体的なプロセスは特徴抽出に大きく依存している。モデルはエッジ、形状、テクスチャ、その他の識別特徴といった有用な視覚パターンを識別することを学習する。これらのパターンは特徴マップに符号化され、ネットワークが複数の詳細レベルで画像を理解するのに役立つ。

モデルアーキテクチャに応じて、物体検出器は物体を特定するために異なる戦略を用い、速度、精度、複雑さのバランスを取ります。

多くの物体検出モデル、特にFaster R-CNNのような二段階検出器は、画像内の特定領域である関心領域(ROI)に焦点を当てる。これらの領域に集中することで、モデルは全てのピクセルを均等に分析するのではなく、物体が含まれる可能性の高い領域を優先的に処理する。

一方、YOLO 単段階モデルは、二段階モデルのように特定のROIを選択しません。代わりに、画像をグリッドに分割し、アンカーボックスと呼ばれる事前定義されたボックスと特徴マップを用いて、画像全体にわたる物体を1回のパスで予測します。

近年、最先端の物体検出モデルではアンカーフリー手法が研究されている。従来の単一ステージモデルが事前定義されたアンカーボックスに依存するのとは異なり、アンカーフリーモデルは特徴マップから直接物体の位置とサイズを予測する。これによりアーキテクチャが簡素化され、計算オーバーヘッドが削減され、特に形状やサイズが異なる物体の検出において性能が向上する。

現在、多くの物体検出モデルが存在し、それぞれが特定の目標を念頭に設計されています。リアルタイム性能を最適化したモデルもあれば、最高精度を達成することに重点を置いたモデルもあります。コンピュータビジョンソリューションに適したモデルを選択する際は、特定のユースケースと性能要件によって決まることがよくあります。

次に、2025年の優れた物体検出モデルをいくつか見ていきましょう。

現在最も広く利用されている物体検出モデル群の一つが、Ultralytics YOLO 群である。YOLO(You Only Look Onceの略)YOLO、高速かつ信頼性が高く扱いやすい上に優れた検出性能を発揮するため、様々な業界で広く採用されている。

Ultralytics YOLO 以下が含まれます Ultralytics YOLOv5、 Ultralytics YOLOv8, Ultralytics YOLO11、そして近日Ultralytics 、様々な性能やユースケースの要件に対応する幅広い選択肢を提供します。軽量設計と速度最適化により、Ultralytics YOLO リアルタイム検出に最適であり、限られた演算能力とメモリを持つエッジデバイスへの展開が可能です。

基本的な物体検出を超えて、これらのモデルは極めて汎用性が高い。インスタンスセグメンテーション(ピクセルレベルで物体の輪郭を抽出する)や姿勢推定(人や物体のキーポイントを特定する)といったタスクにも対応する。この柔軟性により、Ultralytics YOLO 農業・物流から小売・製造まで、幅広い用途における最適な選択肢となっている。

YOLO 人気を博しているもう一つの主な理由は、Python 。このパッケージは、モデルのトレーニング、微調整、デプロイを簡単かつユーザーフレンドリーなインターフェースで提供します。開発者は事前学習済み重みから開始し、自身のデータセットに合わせてモデルをカスタマイズし、わずか数行のコードでデプロイすることが可能です。

RT-DETR(リアルタイム検出トランスフォーマー)およびより新しいRT-DETRv2は、リアルタイム利用向けに構築された物体検出モデルである。多くの従来モデルとは異なり、これらは画像を処理し、非最大抑制(NMS)を使用せずに直接最終的な検出結果を出力できる。

NMS モデルが同一の物体を複数回予測した場合に余分な重複ボックスを除去するNMS 。NMS 省略することで、検出プロセスはよりNMS 。

これらのモデルはCNNとトランスフォーマーを組み合わせています。CNNはエッジや形状といった視覚的詳細を検出する一方、トランスフォーマーは画像全体を一括して観察し、異なる部分同士の関係性を理解できるニューラルネットワークの一種です。この包括的な理解により、モデルは近接しているdetect 重なり合ったdetect 可能となります。

RT‑DETRv2は、マルチスケール検出機能(大小の物体検出の向上)や複雑なシーンへの対応強化など、元のモデルを改良しています。これらの変更により、モデルの高速性を維持しつつ精度が向上しています。

RF‑DETRは、トランスフォーマーアーキテクチャの精度と実世界アプリケーションに必要な速度を両立させるために設計された、リアルタイム対応のトランスフォーマーベースモデルです。RT‑DETRおよびRT‑DETRv2と同様に、トランスフォーマーを用いて画像全体を解析し、CNNを用いてエッジ、形状、テクスチャなどの微細な視覚特徴を抽出します。

このモデルは入力画像から直接物体を予測し、アンカーボックスや非最大抑制を省略するため、検出プロセスが簡素化され推論が高速に保たれます。RF-DETRはインスタンスセグメンテーションにも対応しており、バウンディングボックスの予測に加え、ピクセルレベルで物体の輪郭を描画することが可能です。

2019年末にリリースされたEfficientDetは、効率的なスケーリングと高性能を目的に設計された物体検出モデルである。EfficientDetの特徴は複合スケーリングにあり、これは入力解像度、ネットワークの深さ、ネットワークの幅を単独で調整するのではなく、同時にスケーリングする手法である。このアプローチにより、高性能タスク向けにスケールアップする場合でも、軽量なデプロイメント向けにスケールダウンする場合でも、モデルは安定した精度を維持できる。

EfficientDetのもう一つの重要な構成要素は、効率的な特徴ピラミッドネットワーク(FPN)です。これによりモデルは複数のスケールで画像を分析できます。このマルチスケール分析は、異なるサイズの物体を検出するために不可欠であり、EfficientDetが同一画像内の大小の物体を確実に識別することを可能にします。

2022年に公開されたPP-YOLOE+YOLO物体検出モデルであり、画像を一回だけ走査するだけで物体を検出・分類します。この手法により高速化が図られ、リアルタイムアプリケーションに適しつつも高い精度を維持しています。

PP-YOLOE+の主要な改良点の一つは、タスク整合学習である。これによりモデルの信頼度スコアが物体の位置精度を反映しやすくなる。これは特に、小さい物体や重なり合う物体の検出に有用である。

このモデルはまた、物体の位置予測とクラスラベル予測のタスクを分離するデカップリングされたヘッドアーキテクチャを採用している。これにより、物体を正確に分類しながら、より精密なバウンディングボックスを描画することが可能となる。

GroundingDINOは、視覚と言語を融合したトランスフォーマーベースの物体検出モデルです。固定されたカテゴリセットに依存する代わりに、ユーザーが自然言語テキストプロンプトを用いてdetect します。

画像の視覚的特徴とテキスト記述を照合することで、モデルは訓練データにその正確なラベルが含まれていなくても物体を特定できます。つまり、「ヘルメットをかぶった人物」や「建物の近くの赤い車」といった記述でモデルに指示を与えると、一致する物体の周囲に正確なバウンディングボックスを生成します。

また、GroundingDINOはゼロショット検出をサポートすることで、新たなユースケースごとにモデルを再学習または微調整する必要性を低減し、幅広いアプリケーションにおいて高い柔軟性を実現します。言語理解と視覚認識のこの組み合わせは、インタラクティブで適応性のあるAIシステムに新たな可能性を開きます。

様々な物体検出モデルを比較する際、どれが実際に最も優れた性能を発揮するのか判断する方法が気になるかもしれません。これは良い疑問です。なぜなら、モデルアーキテクチャやデータの質以外にも、多くの要因が性能に影響を与える可能性があるからです。

研究者は、モデルを一貫して評価し、結果を比較し、速度と精度のトレードオフを理解するために、共有ベンチマークと標準的な性能指標に依存することが多い。標準ベンチマークは特に重要である。なぜなら、多くの物体検出モデルはCOCO など、同じデータセット上で評価されるためである。

物体検出モデルを評価するために使用される一般的な指標を詳しく見てみましょう:

実世界アプリケーションにおける物体検出モデルの使用には、以下のような主な利点があります:

これらの利点があるにもかかわらず、物体検出モデルの性能に影響を与える可能性のある実用上の制約が存在します。考慮すべき重要な要素を以下に示します:

コンピュータビジョンプロジェクトに最適な物体検出モデルは、ユースケース、データ構成、性能要件、ハードウェア制約によって異なります。速度を最適化したモデルもあれば、精度を重視したモデルもあり、実際のアプリケーションの多くは両者のバランスを必要とします。オープンソースフレームワークとGitHub上の活発なコミュニティのおかげで、これらのモデルは評価・適応・実用化が容易になりつつあります。

詳細については、当社のGitHubリポジトリをご覧ください。コミュニティに参加し、ソリューションページで医療分野におけるAIや自動車産業におけるコンピュータビジョンなどの応用事例についてご確認ください。ライセンスオプションを確認し、今すぐVision AIの導入を開始しましょう。