Découvrez comment l'IA neuro-symbolique vise à combiner l'apprentissage et la logique pour construire des systèmes qui comprennent le contexte et fournissent des décisions plus transparentes et explicables.

Découvrez comment l'IA neuro-symbolique vise à combiner l'apprentissage et la logique pour construire des systèmes qui comprennent le contexte et fournissent des décisions plus transparentes et explicables.

Aujourd'hui, grâce à la croissance rapide de l'intelligence artificielle (IA) et à la disponibilité croissante de la puissance de calcul, des modèles d'IA avancés sont mis sur le marché plus rapidement que jamais. En fait, l'espace de l'IA est le moteur d'une innovation significative dans de nombreux secteurs.

Par exemple, dans le domaine des soins de santé, les systèmes d'IA sont utilisés pour faciliter des tâches telles que l'analyse d'images médicales en vue d'un diagnostic précoce. Cependant, comme toute technologie, l'IA a ses limites.

L'une des principales préoccupations est la transparence. Par exemple, un modèle de détection d'objets peut localiser avec précision une tumeur dans une IRM cérébrale, mais il peut être difficile de comprendre comment le modèle est parvenu à cette conclusion. Ce manque d'explication fait qu'il est plus difficile pour les médecins et les chercheurs de faire pleinement confiance aux résultats de l'IA ou de les valider.

C'est précisément la raison pour laquelle le domaine émergent de l'IA neuro-symbolique suscite un intérêt croissant. L'IA neuro-symbolique combine les forces de l'apprentissage profond en matière de reconnaissance des formes avec le raisonnement structuré et fondé sur des règles que l'on trouve dans l'IA symbolique. L'objectif est de créer des systèmes qui font des prédictions précises, mais qui peuvent aussi expliquer leur raisonnement d'une manière compréhensible pour les humains.

Dans cet article, nous allons explorer le fonctionnement de l'intelligence artificielle neuro-symbolique et la manière dont elle associe l'apprentissage et le raisonnement pour construire des systèmes plus transparents et plus conscients du contexte. Commençons par le commencement !

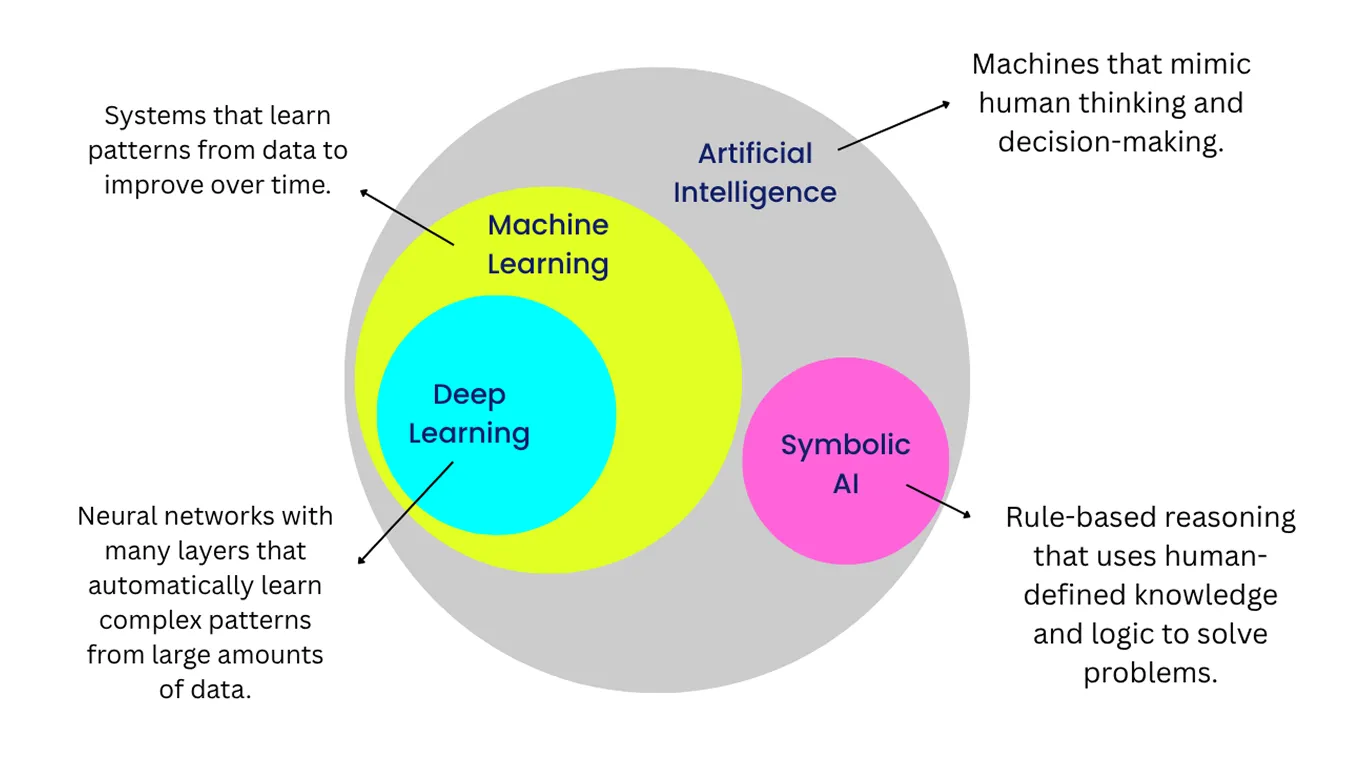

Avant de nous plonger dans l'IA neuro-symbolique, examinons de plus près les deux sous-domaines qu'elle regroupe : l'apprentissage profond et l'IA symbolique.

L'apprentissage profond se concentre sur la reconnaissance de modèles dans les données, tandis que l'IA symbolique utilise des règles, la logique ou le bon sens pour raisonner à travers les problèmes. Chacune de ces méthodes a ses points forts, mais aussi ses limites. En les combinant, l'IA neuro-symbolique crée des systèmes qui peuvent à la fois apprendre des données et expliquer leurs décisions plus clairement.

L'apprentissage en profondeur est une branche de l'apprentissage automatique qui utilise des réseaux neuronaux artificiels, vaguement inspirés de la manière dont le cerveau traite les informations. Ces réseaux apprennent en analysant de grandes quantités de données et en ajustant leurs connexions internes pour améliorer leurs performances.

Cela leur permet de reconnaître des modèles dans les images, les sons et les textes sans avoir besoin de règles élaborées à la main pour chaque situation. C'est pourquoi l'apprentissage profond est très efficace pour les tâches axées sur la perception, telles que la reconnaissance d'images, le traitement de la parole et la traduction linguistique.

Un bon exemple est un modèle de vision par ordinateur entraîné à segment objets dans des images. Avec suffisamment d'exemples étiquetés, il peut apprendre à séparer les routes, les véhicules et les piétons dans des séquences de trafic en temps réel.

Cependant, malgré leur précision, les modèles d'apprentissage profond peinent souvent à expliquer clairement comment ils sont parvenus à un résultat spécifique. Ce défi, communément appelé le problème de la boîte noire, fait qu'il est plus difficile pour les utilisateurs d'interpréter ou de vérifier les décisions du modèle, en particulier dans des domaines sensibles comme les soins de santé ou la finance. Ce problème est important car l'IA responsable exige de la transparence, de la confiance et la capacité de comprendre pourquoi un modèle a fait telle ou telle prédiction.

L'IA symbolique adopte une approche plus structurée de l'intelligence et de la prise de décision. Elle représente les connaissances à l'aide de symboles et applique des règles logiques pour travailler avec ces connaissances, de la même manière que nous utilisons le raisonnement et le langage pour résoudre des problèmes. Chaque étape du processus de raisonnement est définie, ce qui rend les décisions de l'IA symbolique transparentes et plus faciles à expliquer.

La connaissance symbolique fonctionne particulièrement bien dans les tâches qui suivent des règles claires et bien définies, telles que la planification, l'ordonnancement ou la gestion de connaissances structurées. Cependant, l'IA symbolique a du mal avec les données non structurées ou les situations qui n'entrent pas dans des catégories prédéfinies.

Les premiers programmes d'échecs constituent un exemple courant d'approches symboliques en action. Ils suivaient des règles élaborées à la main et des stratégies fixes plutôt que d'apprendre des parties précédentes ou de s'adapter à des adversaires différents. En conséquence, leur jeu avait tendance à être rigide et prévisible.

Dans les années 2010, avec la généralisation de l'apprentissage profond, les chercheurs ont commencé à chercher des moyens d'aller au-delà de la simple reconnaissance des formes et de comprendre les relations et le contexte. Cette évolution a permis aux modèles d'IA non seulement de detect objets dans une scène, comme un chat et un tapis, mais aussi d'interpréter la relation entre ces objets, par exemple en reconnaissant que le chat est assis sur le tapis.

Toutefois, ces progrès ont également mis en évidence une limitation fondamentale. Les modèles d'apprentissage profond peuvent très bien reconnaître des modèles, mais ils ont souvent du mal à expliquer leur raisonnement ou à gérer des situations peu familières. Ce regain d'attention pour le raisonnement a ramené les chercheurs vers un domaine qui existe depuis les années 1980 : l'IA neuro-symbolique.

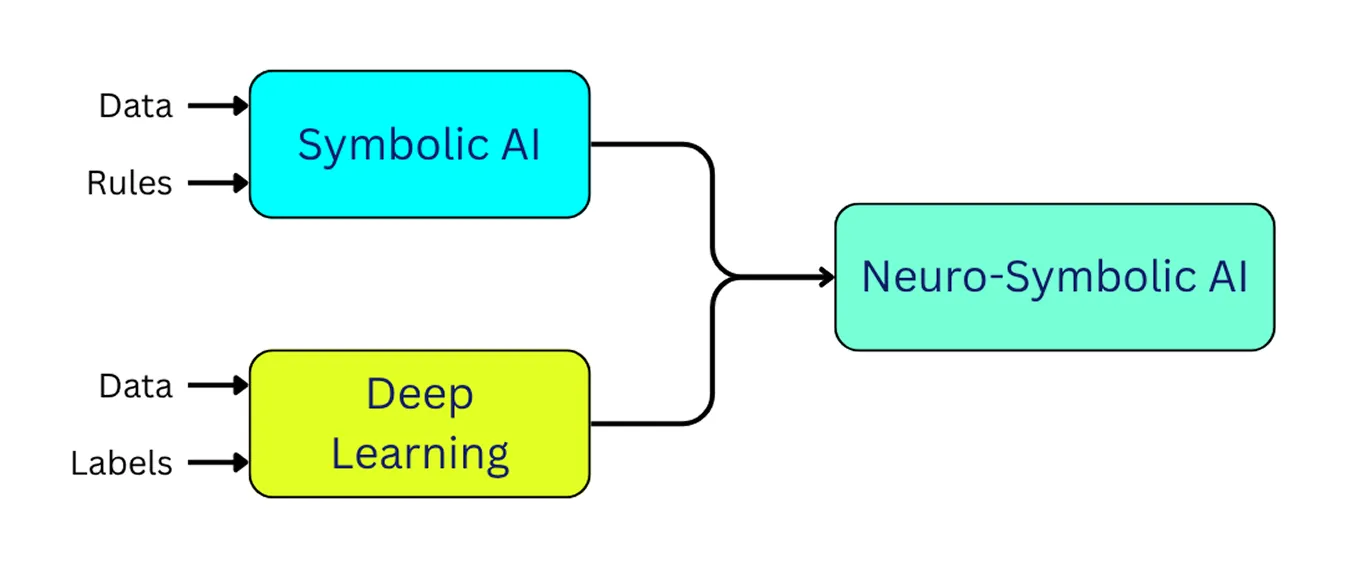

L'IA neuro-symbolique intègre l'apprentissage profond et l'IA symbolique. Elle permet aux modèles d'apprendre à partir d'exemples de la même manière que l'apprentissage profond, tout en appliquant la logique et le raisonnement comme le fait l'IA symbolique.

En d'autres termes, l'IA neuro-symbolique peut reconnaître les informations, comprendre le contexte et fournir des explications plus claires pour ses décisions. Cette approche nous rapproche du développement de systèmes d'IA qui se comportent de manière plus fiable et plus humaine.

Les architectures neuro-symboliques réunissent l'apprentissage et le raisonnement dans un cadre unique. Elles comprennent généralement trois parties principales : une couche de perception neuronale qui interprète les données brutes, une couche de raisonnement symbolique qui applique la logique et une couche d'intégration qui relie les deux. Nous allons maintenant examiner chaque couche de plus près.

Le composant de perception neuronale traite les données non structurées, telles que les images, les vidéos, le texte ou l'audio, et les convertit en représentations internes avec lesquelles le système peut travailler. Il utilise généralement des modèles d'apprentissage profond pour detect modèles et identifier des objets ou des caractéristiques dans les données d'entrée. À ce stade, le système reconnaît ce qui est présent dans les données, mais il ne raisonne pas encore sur le sens, les relations ou le contexte.

Voici quelques types courants de modèles d'apprentissage profond utilisés dans cette couche :

En fin de compte, ces modèles neuronaux extraient et représentent des caractéristiques significatives à partir de données brutes. Cette sortie devient alors l'entrée de la couche de raisonnement symbolique, qui interprète et raisonne sur ce que le système a détecté.

La couche de raisonnement symbolique prend les informations produites par la couche de perception neuronale et leur donne un sens en utilisant la logique. Au lieu de travailler à partir de simples modèles, elle s'appuie sur des éléments tels que des règles, des graphes de connaissances, des bases de connaissances et des ontologies (descriptions organisées de concepts et de la manière dont ils sont liés les uns aux autres). Ces éléments aident le système à comprendre comment les différents éléments s'intègrent et quelles sont les actions qui ont un sens dans une situation donnée.

Par exemple, dans une voiture auto-conduite, la couche de perception neuronale peut reconnaître un feu rouge dans le flux de la caméra. La couche de raisonnement symbolique peut alors appliquer une règle telle que : "Si le feu est rouge, le véhicule doit s'arrêter". Le raisonnement étant basé sur des règles claires, les décisions du système sont plus faciles à expliquer et à vérifier, ce qui est particulièrement important dans les situations où la sécurité et la responsabilité comptent.

La couche d'intégration relie la couche de perception neuronale et la couche de raisonnement symbolique, garantissant que l'apprentissage et le raisonnement fonctionnent ensemble. Dans un sens, elle convertit les sorties des modèles neuronaux (comme la détection d'un piéton) en représentations symboliques qui décrivent l'objet et ses attributs.

Dans l'autre sens, elle prend des règles symboliques (par exemple, "un véhicule doit s'arrêter si un piéton se trouve sur un passage pour piétons") et les traduit en signaux qui guident les modèles neuronaux. Il peut s'agir de mettre en évidence des zones pertinentes d'une image, d'influencer l'attention ou de façonner les voies de décision du modèle.

Cet échange bidirectionnel forme une boucle de rétroaction. Le côté neuronal gagne en structure et en interprétabilité grâce aux règles symboliques, tandis que le côté symbolique peut s'adapter plus efficacement en fonction des données du monde réel. Des techniques telles que les réseaux neuronaux logiques (LNN) permettent cette interaction en intégrant des contraintes logiques directement dans les architectures neuronales.

En reliant ainsi la perception et le raisonnement, l'IA neuro-symbolique peut produire des décisions à la fois précises et plus faciles à interpréter. De nombreux chercheurs considèrent cette approche comme une étape prometteuse vers une IA plus fiable et mieux adaptée à l'être humain, et potentiellement comme une base pour les progrès futurs vers l'intelligence générale artificielle (AGI).

Maintenant que nous comprenons mieux ce qu'est une IA neuro-symbolique et comment elle fonctionne, examinons quelques-uns de ses cas d'utilisation dans le monde réel.

Les véhicules autonomes doivent comprendre leur environnement pour fonctionner en toute sécurité. Ils utilisent des technologies telles que la vision par ordinateur pour detect piétons, les véhicules, les marquages de voies et les panneaux de signalisation.

Si les modèles d'apprentissage profond peuvent identifier ces objets avec précision, ils ne comprennent pas toujours ce que ces objets signifient dans leur contexte ou comment ils sont liés les uns aux autres dans une situation réelle. Par exemple, un modèle neuronal peut reconnaître un piéton sur un passage piéton, mais ne peut pas dire s'il est sur le point de traverser ou s'il attend simplement.

L'IA neuro-symbolique tente de combler cette lacune en permettant aux véhicules auto-conduits de combiner la reconnaissance visuelle et le raisonnement logique, afin qu'ils puissent interpréter des situations plutôt que de se contenter d'identifier des objets. Des recherches récentes en IA ont montré que les systèmes combinant la perception neuronale avec des règles symboliques peuvent améliorer la prédiction du comportement des piétons.

Dans ces systèmes, la composante neuronale analyse les indices visuels tels que la posture, le mouvement et la position du piéton. Le composant symbolique applique ensuite des règles logiques, en tenant compte de facteurs tels que la proximité d'un passage pour piétons ou l'indication du feu de signalisation en cours.

En combinant ces deux perspectives, le système neuro-symbolique peut faire plus que simplement detect un piéton. Il peut prédire de manière raisonnable si le piéton est susceptible de traverser et expliquer pourquoi il a pris cette décision. Cela permet aux véhicules autonomes d'adopter un comportement plus sûr et plus transparent.

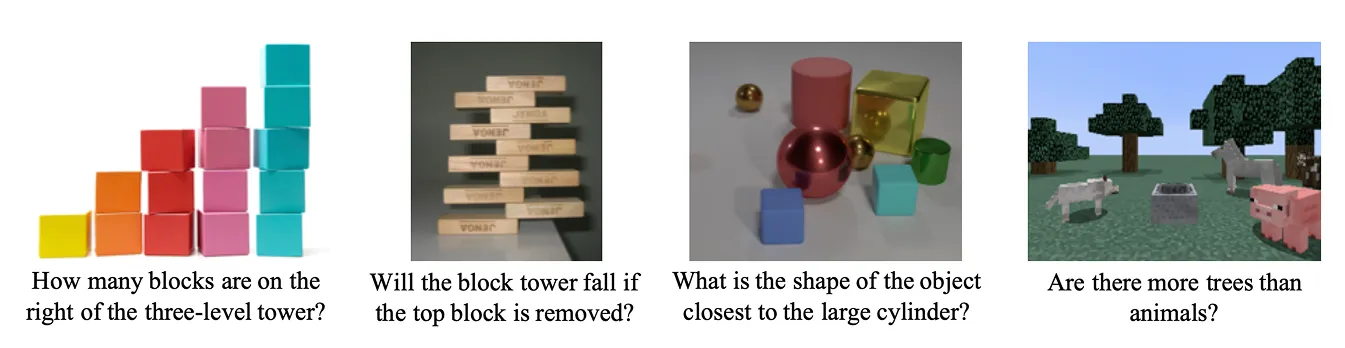

Une autre application importante de l'IA neuro-symbolique est la réponse aux questions visuelles (VQA). Les systèmes VQA sont conçus pour répondre à des questions sur des images.

Il associe de grands modèles de langage (LLM) et des modèles visuels pour effectuer un raisonnement multimodal, en combinant ce que le système voit avec ce qu'il comprend. Par exemple, si l'on montre une image à un système d'AQV et qu'on lui demande : "La tasse est-elle sur la table ?", il doit reconnaître les objets mais aussi comprendre la relation entre eux. Il doit déterminer si la tasse se trouve effectivement sur le dessus de la table dans la scène.

Une étude récente a démontré comment l'IA neuro-symbolique peut améliorer l'AQV en intégrant la perception neuronale au raisonnement symbolique. Dans le système proposé, le réseau neuronal analyse d'abord l'image pour reconnaître les objets et leurs attributs, tels que la couleur, la forme ou la taille.

Le composant de raisonnement symbolique applique ensuite des règles logiques pour interpréter la manière dont ces objets sont liés les uns aux autres et pour répondre à la question. Si la question "Combien de cylindres gris y a-t-il dans la scène ?" est posée, la partie neuronale identifie tous les cylindres et leurs couleurs, et la partie symbolique les filtre en fonction des critères et compte ceux qui sont corrects.

Ces recherches montrent comment l'AQV neuro-symbolique peut aller au-delà de la simple fourniture de réponses. Parce que le modèle peut montrer les étapes qu'il a suivies pour parvenir à une conclusion, il soutient l'IA explicable, dans laquelle les systèmes font des prédictions et justifient leur raisonnement d'une manière compréhensible.

Voici quelques-uns des principaux avantages de l'utilisation de l'IA neuro-symbolique :

Malgré son potentiel, l'IA neuro-symbolique est encore en évolution et présente certains défis pratiques. Voici quelques-unes de ses principales limites :

L'IA neuro-symbolique représente une étape importante vers la construction de systèmes d'IA capables non seulement de percevoir le monde, mais aussi de raisonner à son sujet et d'expliquer leurs décisions. Contrairement aux systèmes d'apprentissage profond traditionnels, qui s'appuient principalement sur des modèles appris à partir de données, l'IA neuro-symbolique combine l'apprentissage statistique avec une logique et des connaissances structurées. Plutôt que de remplacer l'apprentissage profond, elle le complète, ce qui nous rapproche un peu plus du développement d'une IA capable de comprendre et de raisonner d'une manière plus humaine.

Rejoignez notre communauté et explorez notre dépôt GitHub. Consultez nos pages de solutions pour découvrir diverses applications de l'IA dans l'agriculture et de la vision par ordinateur dans les soins de santé. Découvrez nos options de licence et commencez à construire votre projet Vision AI !