プロンプタブル概念セグメンテーションの仕組み、従来手法との相違点、およびYOLOE-26などの関連モデルがオープンボキャブラリ機能を実現する方法を解説します。

プロンプタブル概念セグメンテーションの仕組み、従来手法との相違点、およびYOLOE-26などの関連モデルがオープンボキャブラリ機能を実現する方法を解説します。

ビジョンAIは急速に進歩しており、実環境における画像や動画の分析に広く活用されている。例えば、交通管理システムから小売分析に至るまで、様々なアプリケーションがコンピュータビジョンモデルと統合されつつある。

これらのアプリケーションの多くでは、物体検出モデルなどのビジョンモデルが、車両、人物、設備など事前に定義された物体のセットを認識するよう訓練される。訓練中、これらのモデルには多くのラベル付き例が提示され、各物体の外観や、シーン内で他の物体と区別する方法を学習する。

セグメンテーションタスクでは、モデルはさらに一歩進んで、これらのオブジェクトの周囲に正確なピクセルレベルの輪郭を生成します。これにより、システムは画像内の各オブジェクトが正確にどこに位置しているかを理解できるようになります。

この手法は、システムが学習対象のみを認識する必要がある場合には有効である。しかし、現実の環境では、そのようなケースは稀である。

視覚シーンは通常、動的である。新たな物体や視覚的概念が出現し、状況が変化し、ユーザーはしばしば元の学習設定に含まれていなかったsegment と考える。

これらの制限は、セグメンテーションにおいて特に顕著である。ビジョンAIが進化を続ける中、繰り返し再学習することなく新たな概念に適応できる柔軟なセグメンテーションモデルの必要性が高まっている。そのため、プロンプタブル概念セグメンテーション(PCS)が注目を集めている。

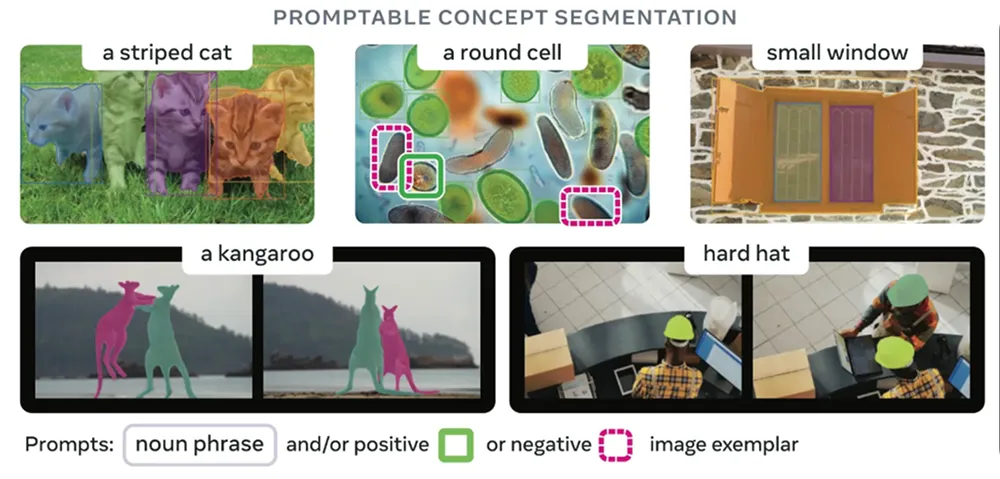

固定されたオブジェクトカテゴリのリストに依存する代わりに、ユーザーはテキスト、視覚的プロンプト、またはサンプル画像segment 対象を記述できます。これらのモデルは、訓練中に明示的に含まれていなかった概念であっても、記述された概念に一致するsegment 領域を識別しsegment 可能です。

本記事では、プロンプタブル概念セグメンテーションの仕組み、従来の手法との違い、そして現在の活用事例について探っていきます。

ほとんどの場合、セグメンテーションモデルは限られた種類の物体を認識するよう訓練される。これは、ビジョンAIシステムが特定の物体のsegment detect segment する必要がある場合に有効である。

しかし現実の応用では、視覚シーンは動的に変化する。新たな物体が現れ、タスク要件が変わり、ユーザーは当初のラベルセットに含まれていなかったsegment 必要が生じることが多い。こうした状況に対応するには、通常、新たな高品質データとアノテーションを収集しモデルを再学習させる必要があり、コスト増加と展開遅延を招く。

プロンプタブル概念セグメンテーションは、固定されたラベルリストから選択する代わりに、ユーザーがモデルに何を探すべきかを指示できるようにすることでこの問題を解決します。ユーザーは探している対象や概念を記述し、モデルは画像内の全ての一致する領域を強調表示します。これにより、ユーザーの意図を画像内の実際のピクセルに結びつけることが格段に容易になります。

プロンプト可能な概念セグメンテーションをサポートするモデルは、異なるタイプの入力を受け取れるため柔軟性が高い。つまり、モデルに何を探すべきかを伝える方法は複数存在し、テキスト記述や視覚的ヒント、あるいは例示画像を通じて指示できる。

各アプローチの詳細は以下の通りです:

プロンプタブル概念セグメンテーションの仕組みについて詳しく見る前に、まず従来の様々な物体セグメンテーション手法と比較してみましょう。

PCSはオープンボキャブラリかつプロンプト駆動型のモデルを実現します。プロンプトを通じて記述された新たなアイデアに対応可能ですが、従来のセグメンテーションでは不可能です。従来のセグメンテーション手法には複数の種類があり、それぞれ固有の前提と限界を有しています。

以下に、伝統的なセグメンテーションの主なタイプをいくつかご紹介します:

これらの手法はいずれも、あらかじめ定義されたオブジェクトカテゴリのリストに依存しています。その範囲内では良好に機能しますが、範囲外の概念にはあまり対応できません。新しい特定のオブジェクトをセグメント化する必要がある場合、通常は追加のトレーニングデータとモデルの微調整が必要となります。

PCSはその状況を変えようとしています。あらかじめ定義されたカテゴリに縛られる代わりに、推論時にsegment したい対象を記述できるようにします。

次に、セグメンテーションモデルがプロンプト対応型概念セグメンテーションへと進化した経緯を順を追って見ていきましょう。

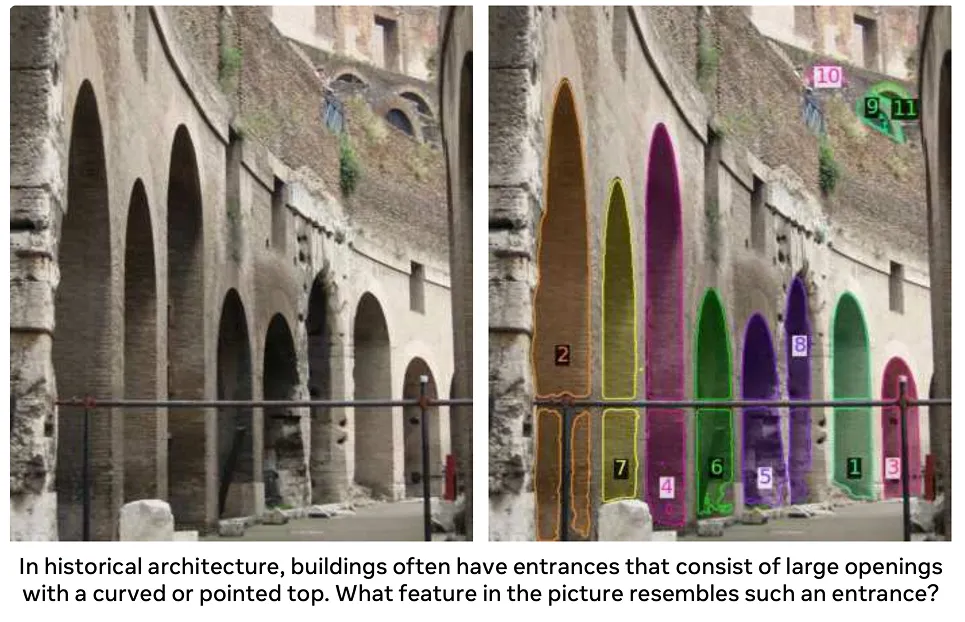

セグメンテーションの転換点となった人気のある基礎モデルは SAM、すなわちセグメント・エニシング・モデル(Segment Anything Model)である。これは2023年に導入された。SAM 事前定義された物体カテゴリに依存する代わりに、点や境界ボックスといった単純な視覚的指示を用いてユーザーがセグメンテーションを誘導することをSAM

SAM、ユーザーはラベルを選択する必要がなくなりました。単にオブジェクトの位置を示すだけで、モデルが自動的にマスクを生成します。これによりセグメンテーションはより柔軟になりましたが、ユーザーは依然としてモデルに「どこを見るべきか」を示す必要がありました。

2024年にリリースSAM 、この概念を発展させ、より複雑なシーンの処理とプロンプトによるセグメンテーションの動画への拡張を実現した。異なる照明条件、物体の形状、動きに対する頑健性を向上させつつ、セグメンテーションの誘導には依然として主に視覚的プロンプトに依存している。

SAM モデルはこの進化における最新のステップである。昨年リリースされたこの統合モデルは、視覚理解と言語ガイダンスを組み合わせることで、画像と動画のセグメンテーションタスク全体で一貫した動作を実現する。

SAM では、ユーザーはプロンプトを指し示したり描画したりする操作に限定されません。代わりに、segment したい対象をsegment 記述でき、モデルがその記述に一致する領域を画像や動画フレーム内から検索します。

セグメンテーションは固定された物体カテゴリではなく概念に基づいて行われ、異なる場面や時間軸を超えたオープンな語彙の使用をサポートする。実際、SAM ウィキデータなどの情報源から導出され、大規模な訓練データを通じて拡張されたオントロジーに基づく、学習された広大な概念空間上で動作する。

以前のバージョンが主に幾何学的プロンプトに依存していたのに対し、SAM より柔軟で概念主導のセグメンテーションに向けた一歩を踏み出しています。これにより、対象となる物体や概念が変化し、事前に定義できない場合もある現実世界のアプリケーションに適応しやすくなっています。

では、プロンプト対応型概念セグメンテーションはどのように機能するのでしょうか?これは大規模な事前学習済みビジョンモデルおよびビジョン言語モデルを基盤としています。これらのモデルは膨大な画像コレクション、そして多くの場合対応するテキストペアを用いて訓練されています。この訓練により、モデルは一般的な視覚パターンと意味的意味を学習します。

ほとんどのPCSモデルはトランスフォーマーベースのアーキテクチャを採用しており、画像全体を一度に処理して異なる領域間の関連性を理解する。視覚トランスフォーマーは画像から視覚特徴を抽出する一方、テキストエンコーダーは単語をモデルが処理可能な数値表現に変換する。

トレーニング中、これらのモデルは様々な種類の教師情報から学習できます。具体的には、物体の正確な境界を定義するピクセルレベルのマスク、物体のおおよその位置を示すバウンディングボックス、画像内に何が写っているかを記述する画像レベルのラベルなどです。異なる種類のラベル付きデータを用いたトレーニングにより、モデルは細かいディテールと広範な視覚的概念の両方を捉えることができます。

推論時、つまりモデルが実際に予測を行う際には、PCSはプロンプト駆動型プロセスに従います。ユーザーはテキスト記述、点や枠などの視覚的ヒント、または例示画像を通じて指示を提供します。モデルはプロンプトと画像の両方を共有内部表現(埋め込み)に変換し、記述された概念と一致する領域を特定します。

マスクデコーダーはこの共有表現を、正確なピクセルレベルのセグメンテーションマスクに変換する。このモデルは視覚的特徴と意味的意味を結びつけるため、訓練中に明示的に含まれていなくても、segment 概念をsegment できる。

また、プロンプトを調整したり追加のガイダンスを加えたりすることで出力を改善できる場合が多く、これによりモデルが複雑または曖昧な場面に対処できるようになります。この反復プロセスは、デプロイ時の実用的な最適化を支援します。

プロンプタブル概念セグメンテーションモデルは、通常、segment 概念をどれだけ正確segment 、および異なるシーン間でどれだけ頑健に動作するかで評価される。ベンチマークは、現実世界の導入要件を反映し、マスク品質、汎化性能、計算効率に焦点を当てる場合が多い。

次に、プロンプタブル概念セグメンテーションが既に活用され、実際の影響を与え始めている分野を見ていきましょう。

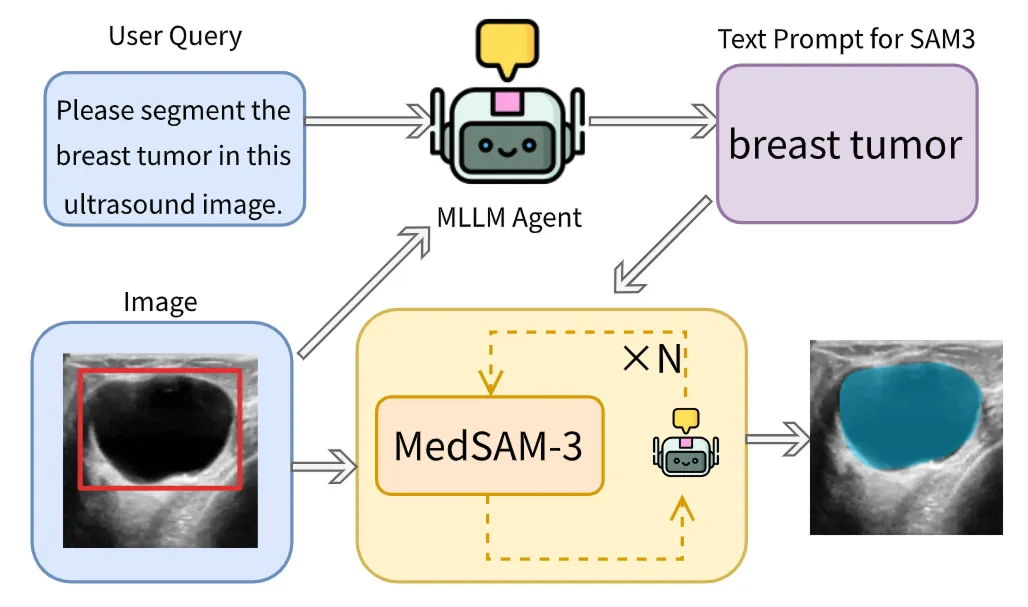

医療画像には多くの生物学的構造、疾患、スキャンタイプが含まれ、新たな症例が日々発生している。従来のセグメンテーションモデルはこの多様性に対応しきれずにいる。

PCSはこの領域に自然に適合します。なぜなら、臨床医が短い固定リストから選択するのではなく、探したいものを記述できるようにするためです。テキストフレーズや視覚的プロンプトを用いることで、PCSは新たなタスクごとにモデルを再訓練することなく、segment 関心領域を直接segment できます。これにより多様な臨床ニーズへの対応が容易になり、手動によるマスク描画の必要性が減少し、多くの画像タイプで機能します。

優れた例として、医療画像におけるSAM アーキテクチャを適応させたMedSAM-3が挙げられる。このモデルは、肝臓や腎臓といった臓器名、腫瘍や病変といった病変関連概念など、明示的な解剖学的・病理学的用語でプロンプト指定が可能である。プロンプトが与えられると、モデルは医療画像内の対応領域を直接セグメント化する。

MedSAM-3はマルチモーダル大規模言語モデル(MLLMまたはマルチモーダルLLM)も統合しており、テキストと画像の両方について推論が可能です。これらのモデルはエージェント・イン・ザ・ループ構成で動作し、より困難なケースにおける精度向上のため、結果を反復的に精緻化します。

MedSAM-3はX線、MRI、CT、超音波、動画データにおいて優れた性能を発揮し、PCSが実際の臨床現場でより柔軟かつ効率的な医療画像ワークフローを実現できることを示している。

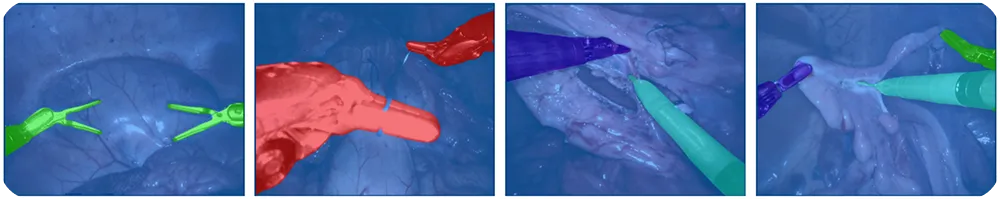

ロボット手術は、track 、急速に変化する手術現場を理解するために視覚システムに依存している。器具は素早く動き、照明は変化し、新たな器具がいつでも現れる可能性があるため、事前定義されたラベルシステムを維持することは困難である。

PCSにより、ロボットはtrack 、カメラの誘導、手術手順のリアルタイム追従が可能となる。これにより手動でのラベル付けが削減され、システムが様々な手術手順に適応しやすくなる。外科医や自動化システムは「グリッパー」「メス」「カメラツール」などのテキストプロンプトを用いて、画像内でセグメント化すべき対象を指示できる。

プロンプト対応可能な概念セグメンテーションに関連するもう一つの興味深い最先端モデルが、Ultralytics です。本モデルは、Ultralytics YOLO ファミリーにオープンボキャブラリかつプロンプト駆動型のセグメンテーション機能をもたらします。

YOLOE-Ultralytics アーキテクチャを基盤として構築され、オープンボキャブラリインスタンスセグメンテーションをサポートします。YOLOE-26では、ユーザーが複数の方法でセグメンテーションを誘導することが可能です。

テキストプロンプトをサポートしており、視覚的に根拠のある短いフレーズで対象物体を指定できます。また、画像の手がかりに基づく追加のガイダンスを提供するビジュアルプロンプトもサポートしています。さらに、YOLOE-26にはプロンプト不要モードが含まれており、ユーザープロンプトを必要とせずに、組み込みの語彙から物体を検出してセグメント化するゼロショット推論が可能です。

YOLOE-26は、物体のカテゴリが変化する可能性があっても低遅延と信頼性の高いスループットが不可欠な、ビデオ解析、ロボット知覚、エッジベースシステムなどの用途に最適です。また、データラベリングやデータセットキュレーションにも特に有用であり、アノテーションプロセスの一部を自動化することでワークフローを効率化します。

プロンプト対応型概念セグメンテーションを使用する主な利点は以下の通りです:

PCSには明らかな利点がある一方で、考慮すべき制限事項がいくつかあります:

プロンプト対応セグメンテーションを調査する中で、どのアプリケーションに最適なのか、また、解決しようとしている問題に対してYOLO26のような従来のコンピュータビジョンモデルの方が適しているのはどのような場合なのか疑問に思うかもしれません。プロンプト対応セグメンテーションは一般的な物体には効果的ですが、非常に精密で一貫した結果が求められるユースケースには適していません。

欠陥検出は良い例である。製造現場では、欠陥はしばしば微小で微妙なものであり、小さな傷、へこみ、位置ずれ、表面の不均一性などが挙げられる。また、材料、照明、生産条件によって大きく異なる場合もある。

これらの問題は単純なプロンプトでは説明が難しく、汎用モデルがdetect さらに困難である。全体として、プロンプトベースのモデルは欠陥を見逃したり不安定な結果を生成する傾向がある一方、欠陥データに特化して訓練されたモデルは実世界の検査システムにおいてはるかに信頼性が高い。

プロンプタブル概念セグメンテーションは、新たな物体や概念が絶えず出現する現実世界に視覚システムを適応させることを容易にする。固定されたラベルに縛られる代わりに、ユーザーはsegment 対象を単純に記述segment 残りはモデルが処理するため、時間を節約し手作業を削減できる。まだ限界はあるものの、PCSは既にセグメンテーションの実用的な活用方法を変革しつつあり、将来の視覚システムの核心部分となる可能性が高い。

AIについてさらに詳しく知るには、当社のGitHubリポジトリを訪問し、コミュニティに参加してください。ロボット工学におけるAIや製造業におけるコンピュータビジョンについて学ぶには、ソリューションページをご覧ください。ビジョンAIを今すぐ始めるためのライセンスオプションをご覧ください!